Парни я честно гуглил(правда с телефона) минут 40. Двоичный код это (условный пример 0101110010) Байт код (на примере JVM) компилятор берет код на java-> байт код->машинный код Вопрос двоичный код и байт код это одно и тоже . Если нет. то подробней пожалуйста

Отслеживать

задан 4 сен 2019 в 3:26

35 8 8 бронзовых знаков

Байт код — это промежуточный код между двоичным (машинным) и, к примеру, кодом на java. Двоичный код — это инструкции для конкретной ОС и архитектуры процессоров. Например, байт код у одной и той же программы будет одинаковый, но двоичный код получится разный для: windows и linux

4 сен 2019 в 4:15

Двоичный (шестнадцатеричный, восьмеричный) код — это текстовый вид (в виде набора символов) внутреннего представления данных. Байт-код — это набор инструкций для виртуальной машины (по сути, данные в виде набора байт). Байт-код может быть представлен в виде двоичного кода, но это не одно и то же.

4 сен 2019 в 5:06

2 ответа 2

Сортировка: Сброс на вариант по умолчанию

Двоичный код / Двоичная система счисления / Ascii Code| Основы Информатики #1

Небольшая историческая справка.

В самых первых компьютерах (1940-е годы) команды и данные хранились раздельно. Данные располагались в памяти, а команды задавались перемычками на лицевой панели. Из-за этого некоторые команды нельзя было реализовать в принципе. Например, нельзя было передать управление на команду, адрес которой хранится в памяти. Сейчас с помощью таких косвенных вызовов работают виртуальные методы в Java/C++/C#.

Группа инженеров предложила несколько архитектурных принципов, которые помогли сделать компьютеры проще и в то же время мощнее. Один из них гласит, что и программы и данные хранятся в оперативной памяти. Поскольку компьютер не хранит ничего кроме чисел, процессор «видит» программу именно как массив чисел.

Сейчас эти принципы называются архитектурой Фон Неймана по имени американского математика, который был участником группы, разработавшей первые компьютеры. Большая историческая несправедливость состоит в том, что Фон Нейман не руководил этой группой, и, скорее всего, не придумал ни одного из предложенных принципов. Но в опубликованной статье его фамилия стояла первой, и именно поэтому принципы получили такое название.

Числа хранятся в двоичном виде (ещё один принцип архитектуры Фон Неймана). Минимальной единицей хранения является байт. Я читал, что существовали компьютеры с 7-битными и 9-битными словами, но никогда их не видел. Насколько я знаю, уже в конце 60-х годов победил 8-битный байт.

Вот пример машинного кода и его представления на языке Ассемблера. Я нашёл его в Google. Слева указан порядковый номер (адрес) первого байта команды. Во второй колонке мы видим байты команды, они записаны в восьмеричной системе счисления. В третьей колонке мнемоники Ассемблера, которые упрощают восприятие программы человеком.

Некоторые команды занимают один байт, а некоторые два. В этом примере нет команд, которые занимают три, четыре и больше байт, но такие команды также встречаются.

Пишу программу в машинных кодах

004: 003 010 lbl adda #8 immediate value decimal 006: 103 010 addb #010 same thing in octal 010: 024 001 lda b memory reference 012: 235 220 stx (ptr) indirect reference 014: 306 204 ora data,x indexed 016: 337 220 lnega (ptr),x indirect/indexed 020: # jumps and calls 020: 344 004 jmp lbl unconditional jump 022: 043 030 jane lbl2-2 jump if a not equal 0 024: 257 221 jxgt (ptr+one) jump indirect if x gt 026: 364 041 call sub call to subroutine 030: 174 220 cbeq (ptr) call indirect if b eq 0 032: # set and skips 032: lbl2 032: 122 204 set1 fox,2 set bit 2 of data to 1 034: 272 205 skp0 data+1,7 skip if bit 7 is 0 036: # shifts and rotates 036: 001 shra 1+SHIFT shift a right 4 plcs 037: 361 rolb 2 rotate b left 2 places 040: 000 hlt halt 041: 000 sub db 0 return address 042: 200 nop no op 043: 023 222 lda #0222 045: 123 144 ldb #100 047: 360 sys system call (extension) 050: 023 222 sysp 0222,100 system call using parms 052: 123 144 054: 360 055: 354 041 jmp (sub) return

Именно это и есть двоичный код, который «понимает» процессор.

Теперь о байт-коде. Основной проблемой двоичного кода является его специфичность. Два разных устройства, например, ноутбук и мобильный телефон, имеют разные процессоры и разные наборы команд.

Если мы захотим написать для них программу, нам придётся писать две программы. Традиционно проблема переносимости решается с помощью языков высокого уровня и компиляторов. Хороший компилятор — это сложная программа, которую долго разрабатывать и трудно поддерживать. Если наш компилятор имеет создавать код для пяти разных процессоров, в нём пять разных оптимизаторов и пять генераторов кода.

Проблему переносимости и сложности можно решить с помощью промежуточной виртуальной машины. Она должна иметь архитектуру низкого уровня, чтобы её можно было просто реализовать. С другой стороны, она должна включать в себя возможности современных процессоров, чтобы не проседать в производительности.

Виртуальный процессор работает также, как и реальный: он видит массив чисел, и воспринимает их как команды для выполнения. Байт-код внешне совершенно идентичен двоичному коду. Вот пример байт-кода виртуальной машины Java:

000: 03 iconst_0 001: 3b istore_0 002: 84 00 01 iinc 0, 1 005: 1a iload_0 006: 05 iconst_2 007: 68 imul 010: 3b istore_0 011: a7 ff f9 goto -7

Единственная разница заключается в том, что двоичный код исполняет физический процессор, а байт-код — очень простая программа-интерпретатор. Впрочем, насколько я знаю, существуют физические процессоры, которые умеют выполнять байт-код Java-машины, так что разница между ними может быть и совсем условной.

Источник: ru.stackoverflow.com

Почему двоичное кодирование является универсальным? Методы программирования

Компьютер обрабатывает большое количество информации. Аудиофайлы, картинки, тексты – все это необходимо воспроизвести или вывести на экран. Почему двоичное кодирование является универсальным методом программирования информации любого технического оборудования?

Чем отличается кодирование от шифрования?

Зачастую люди отождествляют понятия «кодирование» и «шифрование», когда на самом деле они имеют разный смысл. Так, шифрованием называют процесс преобразования информации с целью ее сокрытия. Расшифровать зачастую может сам человек, который изменил текст, или специально обученные люди. Кодирование же применяется для обработки информации и упрощения работы с ней.

Обычно используется общая таблица кодировки, знакомая всем. Она же встроена в компьютер.

Принцип двоичного кодирования

Двоичное кодирование основывается на использовании всего лишь двух символов — 0 и 1 — для обработки информации, используемой различными устройствами. Эти знаки назвали двоичными цифрами, на английском – binary digit, или bit. Каждый из символов двоичного кода занимает память компьютера в 1 бит. Почему двоичное кодирование является универсальным методом обработки информации?

Дело в том, что компьютеру легче обрабатывать меньшее количество символов. От этого напрямую зависит и продуктивность работы ПК: чем меньше функциональных задач нужно выполнить устройству, тем выше скорость и качество работы.

Принцип двоичного кодирования встречается не только в программировании. С помощью чередования глухих и звонких ударов барабана жители Полинезии передавали информацию друг другу. Сходный принцип применяется и в азбуке Морзе, где для передачи сообщения используются длинные и короткие звуки. «Телеграфная азбука» используется и сегодня.

Где используется двоичное кодирование?

Двоичное кодирование информации в компьютере используется повсеместно. Каждый файл, будь то музыка или текст, должен быть запрограммирован, чтобы в последующем он мог быть легко обработан и прочитан. Система двоичного кодирования полезна для работы с символами и числами, аудиофайлами, графикой.

Двоичное кодирование чисел

Сейчас в компьютерах числа представлены в закодированном виде, непонятном для обычного человека. Использование арабских цифр так, как мы себе представляем, для техники нерационально. Причиной тому является необходимость присваивать каждому числу свою неповторимый символ, что сделать порой невозможно.

Существуют две системы счисления: позиционная и непозиционная. Непозиционная система основана на использовании латинских букв и знакома нам в виде греческих цифр. Такой способ записи достаточно сложен для понимания, поэтому от него отказались.

Позиционная система счисления используется и сегодня. Сюда входит двоичное, десятичное, восьмеричное и даже шестнадцатеричное кодирование информации.

Десятичной системой кодирования мы пользуемся в быту. Это привычные для нас арабские цифры, которые понятны каждому человеку. Двоичное кодирование чисел отличается использованием только нуля и единицы.

Целые числа переводятся в двоичную систему кодирования путем деления их на 2. Полученные частные также поэтапно делятся на 2, пока не получится в итоге 0 или 1. Например, число 12310 в двоичной системе может быть представлено в виде 11110112. А число 2010 будет выглядеть как 101002.

Индексы 10 и 2 обозначаются, соответственно, десятичную и двоичную систему кодирования чисел. Символ двоичного кодирования используется для упрощения работы со значениями, представленными в разных системах счисления.

Методы программирования десятичных чисел основаны на “плавающей запятой”. Для того чтобы правильно перевести значение из десятичной в двоичную систему кодирования, используют формулу N = M х qp. М – это мантисса (выражение числа без какого-либо порядка), p – это порядок значения N, а q – основание системы кодирование (в нашем случае 2).

Не все числа являются положительными. Для того чтобы различить положительные и отрицательные числа, компьютер оставляет место в 1 бит для кодирования знака. Здесь ноль представляет знак плюс, а единица – минус.

Использование такой системы счисления упрощает для компьютера работу с числами. Вот почему двоичное кодирование является универсальным при вычислительных процессах.

Двоичное кодирование текстовой информации

Каждый символ алфавита кодируется своим набором нулей и единиц. Текст состоит из разных символов: букв (прописных и строчных), арифметических знаков и других различных значений. Кодирование текстовой информации требует использования 8 последовательных двоичных значений от 00000000 до 11111111. Таким образом можно преобразовать 256 различных символов.

Для кодирования 1 символа требуется 8 бит памяти. Для упрощения подстчетов 8 бит приравниваются к 1 байту, поэтому общее место на диске для текстовой информации измеряется в байтах.

Большинство персональных компьютеров оснащены стандартной таблицей кодировки ASCII (American Standard Code for Information Interchange). Также используются другие таблицы, в которых система кодирования текстовой информации отличается. К примеру, первая известная кодировка символов называется КОИ-8 (код обмена информацией 8-битный), и работает она на компьютерах с ОС UNIX. Также широко встречается таблица кодов СР1251, которая была создана для операционной системы Windows.

Двоичное кодирование звуков

Еще одна причина, почему двоичное кодирование является универсальным методом программирования информации, — это его простота при работе с аудиофайлами. Любая музыка представляет собой звуковые волны разной амплитуды и частоты колебания. От этих параметров зависит громкость звука и его высота тона.

Чтобы запрограммировать звуковую волну, компьютер делит ее условно на несколько частей, или «выборок». Число таких выборок может быть большим, поэтому существует 65536 различных комбинаций нулей и единиц. Соответственно, современные компьютеры оснащены 16-битными звуковыми картами, что означает использование 16 двоичных цифр для кодирования одной выборки звуковой волны.

Чтобы воспроизвести аудиофайл, компьютер обрабатывает запрограммированные последовательности двоичного кода и соединяет их в одну непрерывную волну.

Кодирование графики

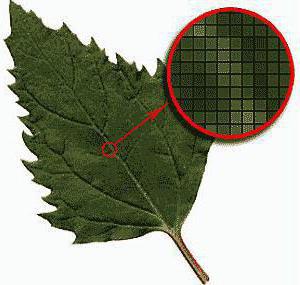

Графическая информация может быть представлена в виде рисунков, схем, картинок или слайдов в PowerPoint. Любая картинка состоит из мелких точек – пикселей, которые могут быть окрашены в разный цвет. Цвет каждого пикселя кодируется и сохраняется, и в итоге мы получаем полноценное изображение.

Если картинка черно-белая, код каждого пикселя может быть либо единицей, либо нулем. Если используется 4 цвета, то код каждого из них состоит из двух цифр: 00, 01, 10 или 11. По этому принципу различают качество обработки любого изображения. Увеличение или уменьшение яркости также влияет на количество используемых цветов. В лучшем случае компьютер различает около 16 777 216 оттенков.

Заключение

Существуют разные методы программирования информации, среди которых двоичное кодирование является наиболее эффективным. Всего лишь с помощью двух символов — 1 и 0 — компьютер легко прочитывает большинство файлов. При этом скорость обработки намного выше, нежели использовалась бы, например, десятичная система программирования. Простота этого метода делает его незаменимым для любой техники. Вот почему двоичное кодирование является универсальным среди своих аналогов.

Источник: fb.ru

Двоичный код — где и как применяется?

Сегодня я по-особому рад своей встрече с вами, дорогие мои читатели, ведь я чувствую себя учителем, который на самом первом уроке начинает знакомить класс с буквами и цифрами. А поскольку мы живем в мире цифровых технологий, то я расскажу вам, что такое двоичный код, являющийся их основой. Начнем с терминологии и выясним, что означит двоичный.

Для пояснения вернемся к привычному нам исчислению, которое называется «десятичным». То есть, мы используем 10 знаков-цифр, которые дают возможность удобно оперировать различными числами и вести соответствующую запись. Следуя этой логике, двоичная система предусматривает использование только двух знаков. В нашем случае, это всего лишь «0» (ноль) и «1» единица. И здесь я хочу вас предупредить, что гипотетически на их месте могли бы быть и другие условные обозначения, но именно такие значения, обозначающие отсутствие (0, пусто) и наличие сигнала (1 или «палочка»), помогут нам в дальнейшем уяснить структуру двоичного кода.

Зачем нужен двоичный код?

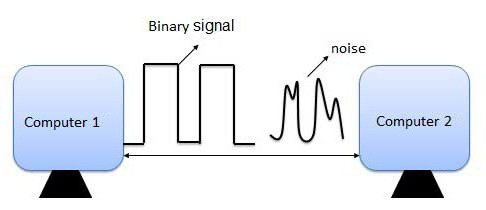

До появления ЭВМ использовались различные автоматические системы, принцип работы которых основан на получении сигнала. Срабатывает датчик, цепь замыкается и включается определенное устройство. Нет тока в сигнальной цепи – нет и срабатывания. Именно электронные устройства позволили добиться прогресса в обработке информации, представленной наличием или отсутствием напряжения в цепи.

Дальнейшее их усложнение привело к появлению первых процессоров, которые так же выполняли свою работу, обрабатывая уже сигнал, состоящий из импульсов, чередующихся определенным образом. Мы сейчас не будем вникать в программные подробности, но для нас важно следующее: электронные устройства оказались способными различать заданную последовательность поступающих сигналов. Конечно, можно и так описать условную комбинацию: «есть сигнал»; «нет сигнала»; «есть сигнал»; «есть сигнал». Даже можно упростить запись: «есть»; «нет»; «есть»; «есть».

Но намного проще обозначить наличие сигнала единицей «1», а его отсутствие – нулем «0». Тогда мы вместо всего этого сможем использовать простой и лаконичный двоичный код: 1011.

- Четырехбитным (как в примере на абзац выше 1011) позволяет записать 2^4 = 16 комбинаций-символов;

- Восьмибитным (например: 0101 0011; 0111 0001). Одно время он представлял наибольший интерес для программирования, поскольку охватывал 2^8 = 256 значений. Это давало возможность описать все десятичные цифры, латинский алфавит и специальные знаки;

- Шестнадцатибитным (1100 1001 0110 1010) и выше. Но записи с такой длинной – это уже для современных более сложных задач. Современные процессоры используют 32-х и 64-х битную архитектуру;

Скажу честно, единой официальной версии нет, то так сложилось, что именно комбинация из восьми знаков стала стандартной мерой хранящейся информации, именуемой «байт». Таковая могла применяться даже к одной букве, записанной 8-и битным двоичным кодом. Итак, дорогие мои друзья, запомните пожалуйста (если кто не знал):

Так принято. Хотя символ, записанный 2-х или 32-х битным значением так же номинально можно назвать байтом. Кстати, благодаря двоичному коду мы можем оценивать объемы файлов, измеряемые в байтах и скорость передачи информации и интернета (бит в секунду).

Бинарная кодировка в действии

Для стандартизации записи информации для компьютеров было разработано несколько кодировочных систем, одна из которых ASCII, базирующаяся на 8-и битной записи, получила широкое распространение. Значения в ней распределены особым образом:

- первый 31 символ – управляющие (с 00000000 по 00011111). Служат для служебных команд, вывода на принтер или экран, звуковых сигналов, форматирования текста;

- следующие с 32 по 127 (00100000 – 01111111) латинский алфавит и вспомогательные символы и знаки препинания;

- остальные, до 255-го (10000000 – 11111111) – альтернативная, часть таблицы для специальных задач и отображения национальных алфавитов;

Расшифровка значений в ней показано в таблице.

Если вы считаете, что «0» и «1» расположены в хаотичном порядке, то глубоко ошибаетесь. На примере любого числа я вам покажу закономерность и научу читать цифры, записанные двоичным кодом. Но для этого примем некоторые условности:

- Байт из 8 знаков будем читать справа налево;

- Если в обычных числах у нас используются разряды единиц, десятков, сотен, то здесь (читая в обратном порядке) для каждого бита представлены различные степени «двойки»: 256-124-64-32-16-8- 4-2-1;

- Теперь смотрим на двоичный код числа, например 00011011. Там, где в соответствующей позиции есть сигнал «1» – берем значения этого разряда и суммируем их привычным способом. Соответственно: 0+0+0+32+16+0+2+1 = 51. В правильности данного метода вы можете убедиться, взглянув на таблицу кодов.

Теперь, мои любознательные друзья, вы не только знаете что такое двоичный код, но и умеете преобразовать зашифрованную им информацию.

Язык, понятный современной технике

Конечно, алгоритм считывания двоичного кода процессорными устройствами намного сложнее. Но зато его помощью можно записать все что угодно:

- Текстовую информацию с параметрами форматирования;

- Числа и любые операции с ними;

- Графические и видео изображения;

- Звуки, в том числе и выходящие и за предел нашей слышимости;

Помимо этого, благодаря простоте «изложения» возможны различные способы записи бинарной информации:

- Дырочки на перфоленте и перфокарте, соответствующие «1», были одновременно и одним из языков программирования;

- Чередование ровной поверхности и выжженных впадин используется в CD и DVD дисках;

- Состоянием отдельных элементов группы транзисторов в USB накопителях;

- Изменением магнитного поля на HDD дисках;

Дополняет преимущества двоичного кодирования практически неограниченные возможности по передаче информации на любые расстояния. Именно такой способ связи используется с космическими кораблями и искусственными спутниками.

Так что, сегодня двоичная система счисления является языком, понятным большинству используемых нами электронных устройств. И что самое интересное, никакой другой альтернативы для него пока не предвидится.

Думаю, что изложенной мною информации для начала вам будет вполне достаточно. А дальше, если возникнет такая потребность, каждый сможет углубиться в самостоятельное изучение этой темы.

Я же буду прощаться и после небольшого перерыва подготовлю для вас новую статью моего блога, на какую-нибудь интересную тему.

Лучше, если вы сами ее мне подскажите 😉

Источник: profi-user.ru