Если вы также, как и я, не имеете доступа к DALLE 2 и уже израсходовали свои попытки с Midjourney, но все еще желаете создавать изображения, то вам стоит обратить внимание на новую нейросеть — Stable Diffusion, которая вызвала большой интерес. С помощью этой модели искусственного интеллекта вы сможете создавать визуальную реальность, которую ранее могли только представлять себе, причем абсолютно бесплатно. Она генерирует изображения на основе текста или входного изображения. Мы планируем интегрировать Stable Diffusion в наш Телеграм бот в ближайшее время, где сейчас успешно работает ChatGPT, чтобы вы удобно в одном месте могли пользоваться всеми благами нейронных сетей. Для доступа к боту вам нужно быть подписанным на наш Телеграм канал, там же вы и найдете ссылку на бота. А пока давайте приступим к обзору Stable Diffusion

5423 просмотров

Stable Diffusion

Что такое Stable Diffusion?

22 августа была выпущена в публичный доступ программа Stable Diffusion, созданная группой Stability.Ai и имеющая открытый исходный код. Она состоит из двух больших частей: обученной нейросети (доступна версия 1.4, скоро будет доступна 1.5, которая обещает еще более качественные лица/глаза/руки) и обвязки, которая вызывает эту нейросеть.

MidJourney — Как Пользоваться Бесплатно и Без Ограничений ?! | Нейросеть Stable Diffusion

Результаты ее работы напоминают DALL·E и Midjourney, однако по мнению меня и моих друзей, Midjourney создает более выразительные изображения в целом, а Stable Diffusion более точно следует запросу при настройках по умолчанию. Основное преимущество Stable Diffusion для пользователя заключается в том, что нет ограничений на генерируемые изображения (хотя в оригинальной версии есть NSFW-фильтр, который легко можно отключить), и все это бесплатно.

попросил создать диджея обезьяну на пляже =)

Существует множество способов работы с нейросетью, и сообщество, которое ею пользуется, растет очень быстро:

- Основной способ — через консоль, что подойдет тем, кто знает Python и может изменять код. Вы можете выбрать нужный вам вариант из исходников на GitHub (доступен здесь) или версию с меньшим использованием видеопамяти и дополнительными опциями (здесь). Затем следуйте инструкции по установке и настройке среды (для исходника здесь, для второго варианта — здесь). Преимущество — вы можете интегрировать новые методы генерации изображений и лучше понимать, как это все работает.

- Второй способ — через браузер, например, на сайте без регистрации и настроек (здесь) или на сайте с регистрацией и разными настройками. Плюс — это доступно с любого устройства, ничего не нужно устанавливать. Минусы — это медленно, и возможностей меньше, чем в консоли. Кроме того, в любой момент ваш любимый сайт может закрыться из-за наплыва пользователей или желания создателей.

- Третий способ — через графический интерфейс и установщик, который должен быть более привычным для пользователей Windows. Однако не факт, что в графическом интерфейсе будут все необходимые настройки. Преимущества — все наглядно, и вам не нужно знать ничего про Python, Anaconda, pip-install, командную строку и т. д.

НЕЙРОСЕТЬ STABLE DIFFUSION | КАК ПОЛЬЗОВАТЬСЯ | КАК УСТАНОВИТЬ

В ближайшее время мы интегрируем Stable Diffusion в наш Telegram bot, чтобы получить доступ в числе первых нужно быть подписанным на наш Телеграм канал. Подписывайтесь прямо сейчас!

Чем Stable Diffusion выделяется среди других нейронных сетей?

Для начала, SD (Stable Diffusion) представляет собой открытый исходный код, доступный по лицензии Creative ML OpenRail-M, что позволяет запускать его на локальном компьютере, вместо того чтобы обращаться к облачному API или сайту.

Для достижения качественных результатов разработчики рекомендуют использовать графический процессор NVIDIA серии 3xxx с минимальным объемом оперативной памяти в 6 ГБ.

За последние две недели появилось множество проектов, созданных с помощью Stable Diffusion, и люди достигли впечатляющих результатов, используя метод «img2img». Этот метод модернизировал игровое искусство, преобразовал сцены из «Аладдина» в 3D, превратил детские рисунки в красивые иллюстрации и многое другое.

Каким образом функционирует Stable Diffusion?

Большинство недавних ИИ использует скрытую диффузию, чтобы создавать изображения. Эта техника заключается в том, что модель обучается распознавать знакомые формы на фоне случайного шума и постепенно собирать эти элементы в соответствии с заданными словесными подсказками.

Stable Diffusion

Изначально, модель обучается на большом наборе данных изображений, который создают люди или группы, собирая изображения с метаданными. В случае Stable Diffusion, используется набор данных LAION-5B, содержащий 5 миллиардов изображений из интернета, включая сайты, такие как Pinterest, DeviantArt и Getty Images. Модель обучается на этом наборе данных, используя сотни графических процессоров, таких как Nvidia A100, за что было потрачено около 600 000 долларов на обучение.

В процессе обучения, модель связывает слова с изображениями, используя метод CLIP, разработанный OpenAI. С помощью скрытой диффузии, модель анализирует статистические ассоциации между цветными пикселями в изображениях, чтобы определить их отношения. Это позволяет модели создавать новые комбинации стилей на основе изученных данных.

Однако, модель не учитывает физические особенности людей на изображениях, поэтому при создании текстовых подсказок необходимо учитывать это самостоятельно. В будущем, модели, вероятно, будут улучшаться, чтобы фильтровать и корректировать изображения более эффективно.

В ближайшее время мы интегрируем Stable Diffusion в наш Telegram bot, чтобы получить доступ в числе первых нужно быть подписанным на наш Телеграм канал. Подписывайтесь прямо сейчас!

Какие проблемы у Stable Diffusion

Релиз программы Stable Diffusion вызвал беспокойство у людей, которые опасаются ее воздействия на культуру и экономику. В отличие от DALL-E 2, данные для обучения Stable Diffusion доступны для всех пользователей без ограничений. Программа включает автоматические фильтры NSFW и невидимый водяной знак для отслеживания, но эти ограничения можно легко обойти в открытом исходном коде, что позволяет создавать изображения, которые OpenAI в настоящее время блокирует, такие как порнография, пропаганда, изображения насилия, нарушающие авторские права, подделки и многое другое.

Лицензия программы запрещает многие из этих видов использования, однако, ее практическое реализование затруднено. Эмад Мостак утверждает, что преимущества перевешивают потенциальные недостатки, и включил политику этичного использования и инструменты для уменьшения вреда.

Кроме того, при обучении Stable Diffusion используются миллионы произведений искусства, которые были собраны без разрешения авторов, и программа генерирует очень похожие изображения. Это вызывает вопросы об авторстве и авторских правах. Р. Дж. Палмер выразил свою обеспокоенность как художник.

Также существует проблема культурных предубеждений, так как нейросети изучают социальные и культурные стереотипы, присутствующие в наборе данных. Например, в ранней стадии тестирования Stable Diffusion на сервере Discord тестировщики обнаружили, что почти каждый запрос на «красивую женщину» включал обнаженных женщин, что отражает стереотипы западного общества.

Попросил нарисовать красивую девушку

Что можно ожидать в будущем от Stable Diffusion?

Следуя тренду роста вычислительной мощности, вероятно, что в будущем доступ к нейросетям будет осуществляться через смартфоны. Кроме того, разработка новых методов позволит обучать модели на более доступном оборудовании, что приведет к взрывному росту творческих результатов, подпитываемых искусственным интеллектом. В ближайшее время можно ожидать создания фотореалистичных видео на основе текстовых подсказок, а в дальнейшем — расширение таких возможностей на области аудио, музыки, видеоигр и виртуальной реальности. Представьте себе, как продвинутые ИИ будут выполнять творческую тяжелую работу всего за несколько предложений, что откроет бесконечные возможности для создания различных развлечений в режиме реального времени по запросу.

Stable Diffusion использует сотни миллионов изображений для сжатия информации в файл размером 4,2 ГБ, и в будущем такая технология может быть использована для сжатия художественных фильмов в несколько мегабайт текста. Это может привести к возможности создания собственных художественных фильмов с помощью подобной технологии. Однако следует отметить, что эта технология может иметь опасные последствия, такие как пропаганда, дезинформация и искажение истории, а также уничтожение юридической ценности фото- или видеодоказательств. В конечном итоге, человечество адаптируется к изменениям, даже если это приведет к радикальным изменениям наших культурных рамок. Как сказал древнегреческий философ Гераклит, «единственная константа — это изменение».

В ближайшее время мы интегрируем Stable Diffusion в наш Telegram bot, чтобы получить доступ в числе первых нужно быть подписанным на наш Телеграм канал. Подписывайтесь прямо сейчас!

В конце концов, это представляет собой еще один инструмент для более быстрого и доступного выражения идей. Хотя результаты, получаемые с помощью SD, могут не использоваться в качестве окончательных ресурсов, они могут использоваться для создания текстур в прототипах игр или для создания логотипов для проектов с открытым исходным кодом.

Несмотря на то, что лицензия на модель запрещает ее использование во многих недобросовестных целях, открытый исходный код является двуединым мечом. В настоящее время невозможно предвидеть, какие последствия могут возникнуть в долгосрочной перспективе. Перспектива на 10-15 лет становится неясной, учитывая то, что трудно представить, какие возможности будут доступны с версией, работающей в реальном времени и в 10 раз лучше.

С чего начать свой путь — Stable Diffusion или Midjourney?

Если вы уже умеете генерировать запросы для Midjourney, то вы можете использовать свои навыки и для Stable Diffusion. Однако, следует помнить, что в Stable Diffusion отсутствуют команды, такие как «—wallpaper» и «—beta», и нет опции разделения сущностей через «::». Вместо этого можно использовать веса для этой цели, о чем будет рассказано позже.

Если же вы еще не знакомы с Midjourney, рекомендуется начать с него, так как на VC есть прекрасный гайд, который поможет вам понять, как создавать и уточнять запросы в режиме реального времени, и какие результаты выдает нейросеть при каждой модификации запроса.

Если вы не готовы тратить время на изучение еще одной нейросети, не стоит отчаиваться. На данный момент уже есть веб-сайты, где вы можете ознакомиться с результатами генерации запросов для Stable Diffusion (например, https://lexica.art/). Вы можете изучать запросы, созданные другими людьми, и использовать их как основу для своих собственных изображений, добавляя и удаляя части запроса и наблюдая за результатом. Также стоит обратить внимание на популярные работы в сообществе и посмотреть, как был составлен текст для их создания. Вы можете также использовать генераторы описаний, которые уже содержат известные элементы описаний, на которые реагирует ИИ.

Считается, что чем более подробно и разнообразно вы сформулируете свой запрос, тем лучше. Используйте разные синонимы для описания одного и того же. Хотите получить изображение с высокой детализацией? Пишите «шедевр, высокое качество, ультра-детализация, 4k» и т.д.

Укажите имя художника, который рисует в гипер-реалистичном стиле, используя запрос «от %Фамилия-Имя художника%, входящего в датасет LAION». Вы можете указать несколько похожих или совсем разных художников, чтобы получить более художественное изображение. Например, смешать стиль Моне и Ван Гога, Синьяка и Хокусая.

Однако учтите, что более чем 75 слов в запросе SD не принимает. Важно также расположение слов в запросе — чем ближе к началу, тем больший вес придаст нейросеть этому слову. Поэтому располагайте в начале те элементы, которые должны быть обязательно включены в изображение.

Не ожидайте сразу получить идеальный результат, вам, вероятно, придется попробовать много разных вариантов одного и того же запроса с разными настройками. Начинать необходимо с простых запросов, чтобы научиться генерировать более сложные. Не стоит сразу использовать k_lms и 50 шагов — когда вы генерируете множество запросов, важно, как много из них отрабатывает.

Если нужно, вы можете вручную указывать веса для каждого элемента запроса. Для этого после каждого элемента ставится «:xx», где xx — вес этого элемента при генерации. Сумма весов всех элементов должна равняться 100. Например, запрос для генерации изображения наполовину мини-дракона и наполовину хорька может выглядеть так: «мини-дракон:50, хорек:50».

Мои советы по Stable Diffusion

Попробуйте начать генерировать изображения уже сейчас и наслаждаться этим процессом, а также дарить другим людям возможность насладиться вашими творениями. Следите за сообществом на различных платформах, таких как GitHub или Reddit, чтобы узнавать о новых возможностях и удачных примерах использования. Также попробуйте использовать метод генерации по образцу, где вы используете набор изображений в качестве обучающей выборки и генерируете изображения в этом новом стиле.

Помимо этого, можно попробовать использовать различные улучшатели изображений, например RealESRGAN или GFPGAN, для увеличения разрешения или повышения качества лиц.

Желаю удачи! Не забывайте делиться не только своими интересными результатами, но и комбинациями запросов и настроек, которые приводят к удачным результатам.

В ближайшее время мы интегрируем Stable Diffusion в наш Telegram bot, чтобы получить доступ в числе первых нужно быть подписанным на наш Телеграм канал. Подписывайтесь прямо сейчас!

Источник: vc.ru

Stable Diffusion/Руководство для абсолютных новичков

Эта статья подразумевает околонулевую осведомленность о Stable Diffusion. Цель — познакомить с основами использования моделей текст-в-картинку и подсказать, что делать дальше.

Stable Diffusion это программа которая превращает текстовые описания в изображения. В этом руководстве мы нарисуем курицу, переходящую через дорогу.

Опробовать Stable Diffusion онлайн

1. Зайдите на одно из онлайн-приложений. Например, ссылка.

2. В строку «positive prompt» введите текстовое описание целевого изображения на английском, например, Chicken crossing the road .

3. Нажмите «Generate». Если на экране появляется сообщение вроде «app is busy, keep trying», нажмите кнопку еще несколько раз, пока она не сработает. Когда нейросеть начнет работать, загрузится и окончит, она должна выдать что-то подобное:

4. Возможно, вам повезет. Но в данном случае что-то пошло не так. Иногда нейросеть может генерировать несколько объектов, в данном случае петухов. Если собрать несколько петухов в одном месте, они могут начать беспредел: на 1 картинке они собираются драться, на третьей переходят дорогу вдоль. Чтобы это предотвратить, существует негативный промпт. Введите в него то, чего на изображении быть не должно, например, multiple birds .

5. Теперь мы видим, что нейросеть рисует кур с четырьмя ногами. Это неприемлемо. Также мы передумали и решили, что птица будет переходить дорогу в деревне, а не улицу в городе или шоссе. Мы заменем промпты соответствующе:

Chicken crossing a country road

multiple birds, four legs, road markings

Поздравляю, вы научились пользоваться промптами.

Следующие шаги

Если вам достаточно простых картинок, или нужно простое приложение заточенное под определенную цель, проверьте Список приложений и ботов

Однако, у большинства подобных приложений ограниченные возможности. Например, обычно нельзя увеличить время работы над одной картинкой, или установить другую модель, или обучить ее рисовать конкретного человека или объект. В частности, SD не умеет рисовать аниме. Если вам нужна более конкретная конфигурация, понадобится личная копия SD.

Установка Stable Diffusion для персонального использования

Сравнительная производительность на разных видеокартах

Рекомендуется запускать Stable Diffusion на компьютерах с видеокартой, имеющей не менее 6Gb памяти. Если у вас такого нет, обычно лучше запускать в облаке. Это значит, что у вас на компьютере будет интерфейс для генерации, а сама генерация будет происходить на другом, мощном компьютере. Хотя возможно запускать SD и на старых видеокартах и даже на процессоре, это намного медленнее. Кроме того, вам может понадобится память для запуска графического редактора для инпеинтинга

Нажмите на одну из опций внизу чтобы перейти к инструкции по установке на нужной платформе. После установки, зайдите на страницу Руководства.

Источник: ai-art-wiki.com

Запускаем Stable Diffusion у себя на компьютере

Stable Diffusion — нейросеть, которая рисует картинки по текстовому описанию. Мы уже рассказывали, как запустить Stable Diffusion простым способом на маке, теперь сделаем круче — установим всё вручную и запустим Stable Diffusion на компьютере с Windows. На Маке тоже заработает, кстати.

Вот коротко то, что будет дальше:

- Скачиваем веса и исходники.

- Ставим нужные библиотеки и программы.

- Разворачиваем рабочее окружение.

- Запускаем нейросеть и пишем по-английски, какая картинка нам нужна.

- Ждём.

- Смотрим на картинку.

На самом деле нет ничего сложного — просто выполняем команды по порядку и получаем результат. Единственное ограничение — нейросеть может плохо работать на компьютерах без поддержки CUDA и видеокарт Nvidia: иногда она падает с ошибкой или работает очень медленно.

Ещё нам понадобится примерно 15–20 гигабайт свободного места на диске. Удаляйте зарубежные фильмы и кровавые игры, мы будем делать всё своё.

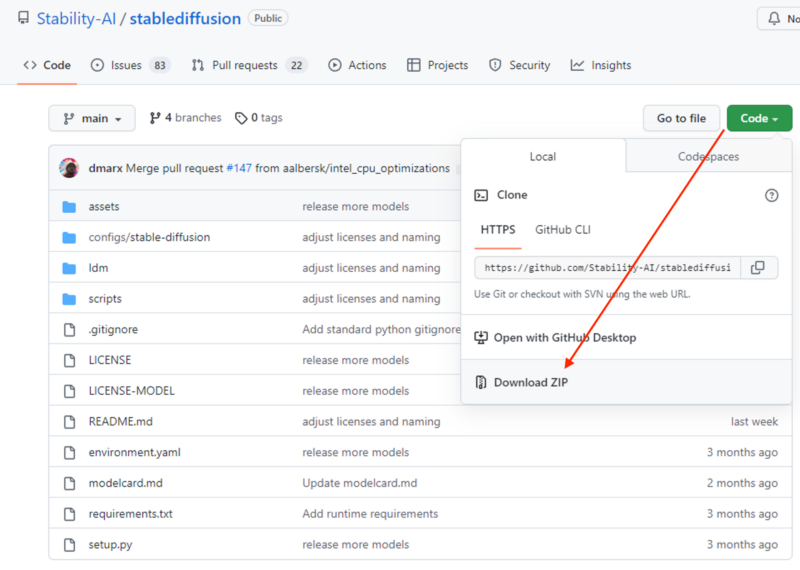

Скачиваем исходники

Идём на Гитхаб проекта и скачиваем весь исходный код Stable Diffusion. Для этого нажимаем Code → Download ZIP и сохраняем архив:

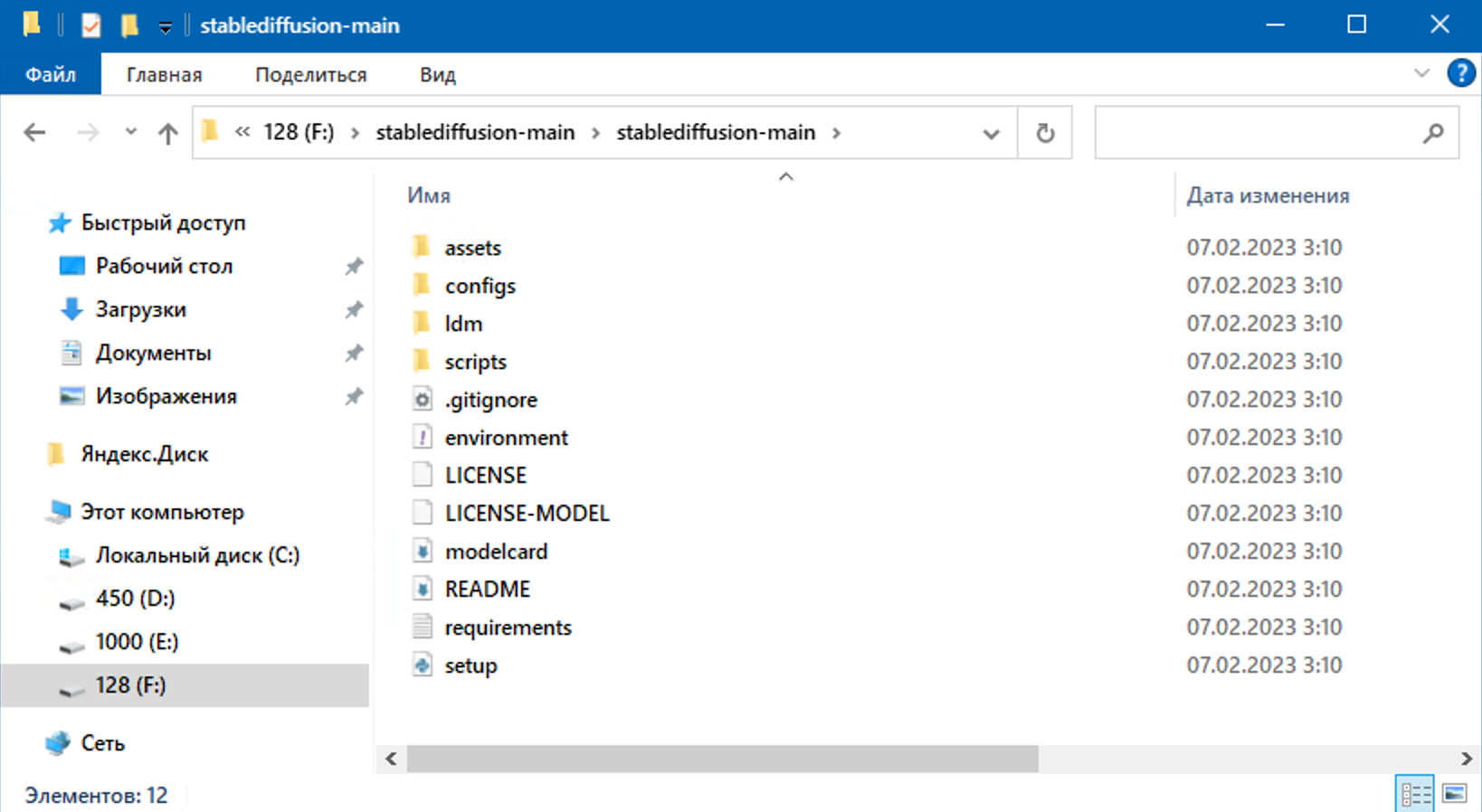

Как скачается — распаковываем в отдельную папку, у нас это F:stablediffusion-mainstablediffusion-main. Этот путь к скриптам нам скоро пригодится, поэтому запоминаем, куда распаковали:

Качаем модели и веса

Вся сила нейросетей — в их весах. От них зависит, какое решение будет принимать нейросеть на каждом этапе своей работы. Именно правильно подобранными весами отличается тренированная и обученная сеть от необученной.

Скачиваем один из этих файлов и кладём их в ту же папку, что и исходники Stable Diffusion:

v2-1_768-ema-pruned.ckpt ← если нужны картинки 768 на 768 пикселей (потребуется больше видеопамяти)

v2-1_512-ema-pruned.ckpt ← если хватит картинок с размером 512 на 512

Устанавливаем Conda

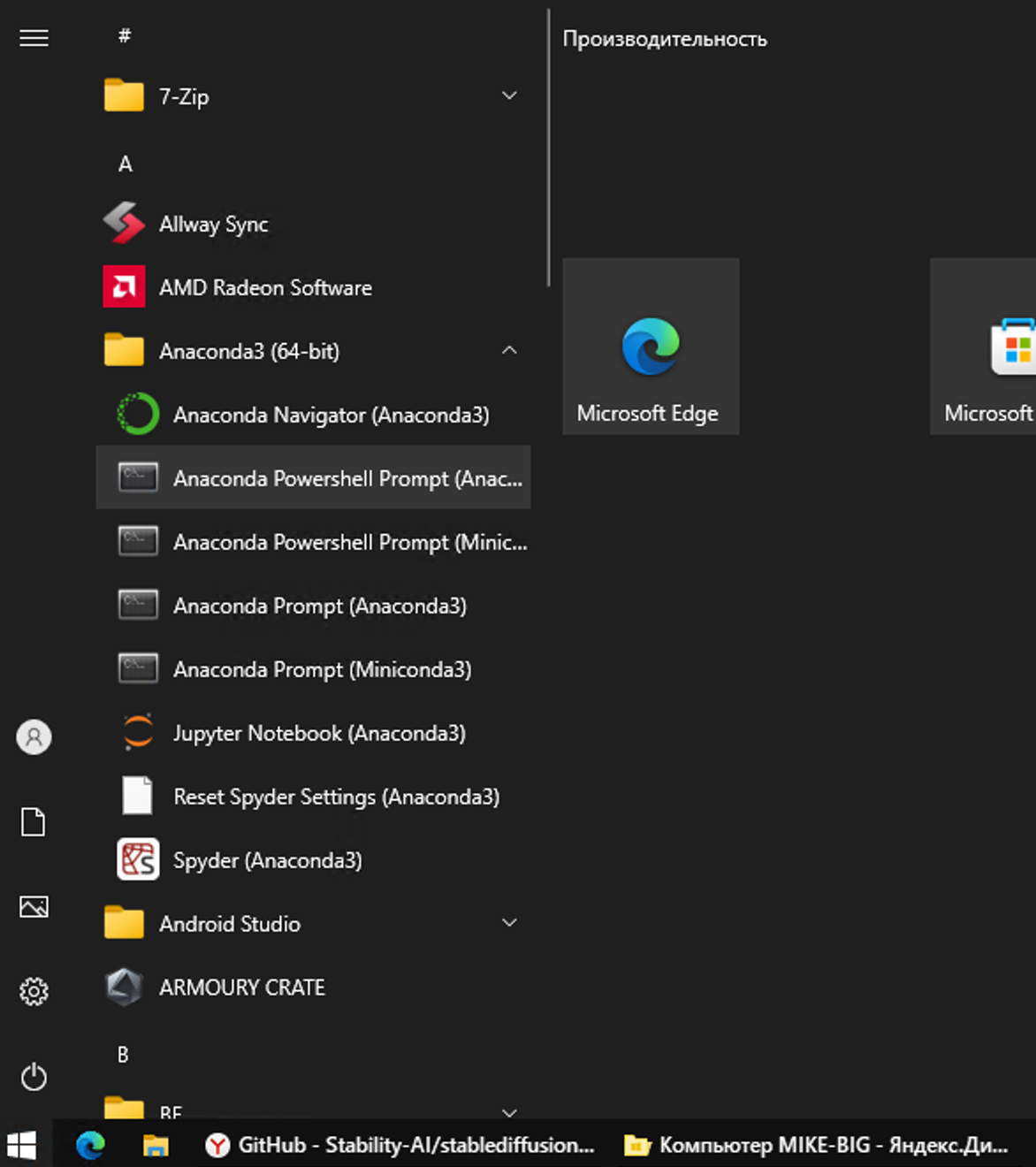

Conda — это менеджер пакетов, который часто используется для установки Python-библиотек. Он удобнее, чем pip, может сам проверять зависимости при установке и позволяет создавать виртуальные окружения (это нам пригодится). Качаем последнюю версию с официального сайта, устанавливаем и запускаем Anaconda Powershell Prompt:

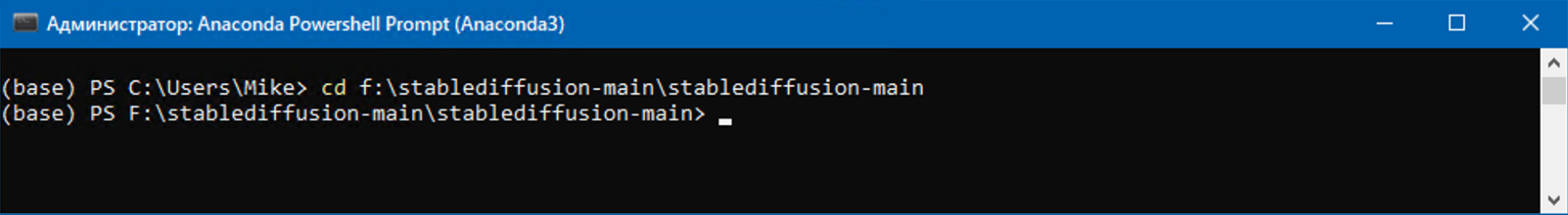

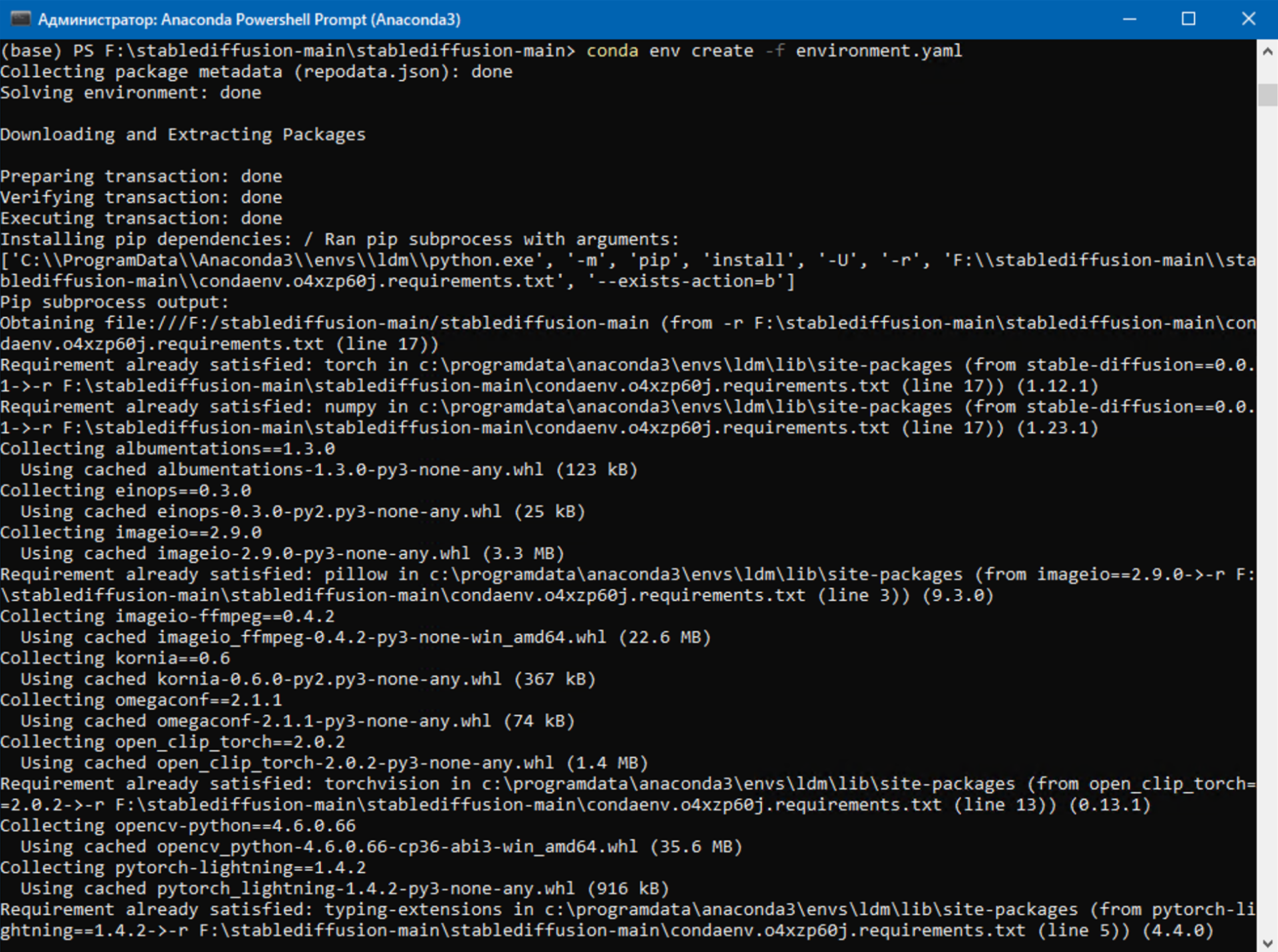

❗️ Перед нами появилось окно с командной строкой — дальше всё будем делать в нём.

Переходим в папку с исходниками, которую распаковали до этого

Создаём рабочее окружение и устанавливаем библиотеки

Виртуальное рабочее окружение — это такой способ работать с программами, чтобы настройки одних скриптов не мешали работе других. В исходниках, которые мы скачали на первом шаге, есть файл с настройками рабочего окружения как раз для нашего проекта. Создадим его:

conda env create -f environment.yaml

Во время установки рабочего окружения скрипт установит много дополнительных файлов и библиотек, это займёт некоторое время.

Теперь запускаем рабочее окружение:

conda activate ldm

Если в компьютере стоит видеокарта Nvidia с поддержкой CUDA, то выполняем такую команду:

conda install pytorch torchvision torchaudio pytorch-cuda=11.7 -c pytorch -c nvidia

Если нет — то такую:

conda install pytorch torchvision -c pytorch

Ставим библиотеку для невидимых водяных знаков — с их помощью другой алгоритм сможет отличить сгенерированную картинку от нарисованной человеком:

pip install transformers==4.19.2 diffusers invisible-watermark

Устанавливаем CUDA, если у нас есть видеокарта с поддержкой этой технологии

conda install cuda -c nvidia

Ставим библиотеку xformers, чтобы нейросеть работала быстрее:

pip install -U xformers

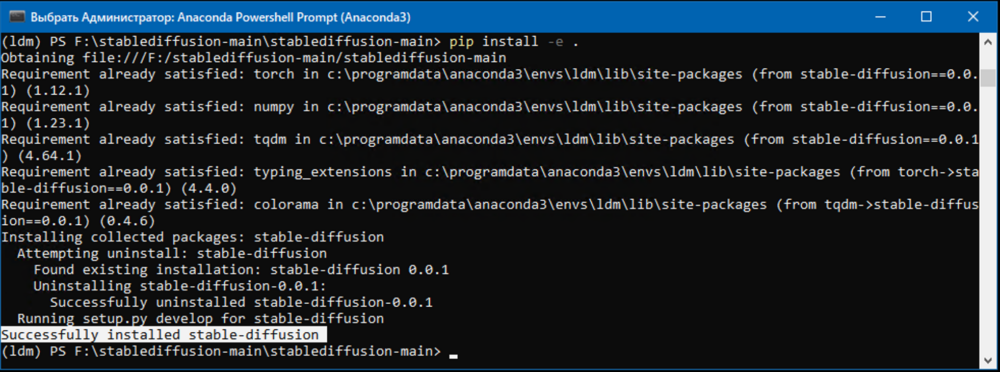

Теперь, когда все компоненты на месте, устанавливаем Stable Diffusion:

Точка означает, что команда возьмёт скрипт setup.py, который лежит в этой папке, и будет работать с ним:

Запускаем нейросеть

Чтобы нейросеть сгенерировала нам картинку, нужно написать запрос в командной строке. Допустим, мы хотим получить картинку программиста в стиле игры «Киберпанк 2077». Так как Stable Diffusion понимает только английский язык, наш запрос будет выглядеть так:

python scripts/txt2img.py —prompt «photo of a programmer at a desktop in the style of the game cyberpunk 2077» —ckpt v2-1_512-ema-pruned.ckpt —config configs/stable-diffusion/v2-inference-v.yaml —H 512 —W 512

Кроме текста запроса, здесь есть ещё несколько параметров:

- —ckpt v2-1_512-ema-pruned.ckpt — указываем, какой нужно использовать файл с весами;

- —config configs/stable-diffusion/v2-inference-v.yaml — откуда берём остальные настройки нейросети;

- —H 512 —W 512 — размер картинки в пикселях.

После запуска нейросеть подумает несколько минут, а потом картинка появится в папке outputstxt2img-samples:

Вот и всё! Теперь вы можете создавать свои картинки сколько угодно раз с любыми запросами. Если не знаете, как сформулировать запрос на английском, — используйте Яндекс Переводчик.

Любите данные? Посмотрите вот это

Возможно, у вас получится построить карьеру в мире дата-сайенса. Это новое направление, в котором очень нужны люди. Изучите эту сферу и начните карьеру в ИТ: старт — бесплатно, а после обучения — помощь с трудоустройством.

Получите ИТ-профессию

В «Яндекс Практикуме» можно стать разработчиком, тестировщиком, аналитиком и менеджером цифровых продуктов. Первая часть обучения всегда бесплатная, чтобы попробовать и найти то, что вам по душе. Дальше — программы трудоустройства.

Источник: thecode.media