Всем привет! Это руководство предназначено для того, чтобы помочь новичкам начать работу с Screaming Frog SEO Spider. В нем рассказывается о начальной настройке, о том, как начать сканирование, а также о просмотре отчетов и обнаруженных проблемах.

О Screaming Frog SEO Spider

Screaming Frog SEO Spider — это инструмент для сканирования веб-сайтов, разработанный для того, чтобы помочь SEO-специалистам и компаниям извлекать данные на сайте, проводить аудит SEO-проблем и анализировать результаты в режиме реального времени. Функции включают обнаружение дубликатов страниц, визуализацию сайта, планирование сканирования, аутентификацию на основе форм, создание XML-карты сайта и создание разного рода отчетов.

Инструмент позволяет специалистам по поисковой оптимизации сканировать небольшие или большие веб-сайты, отслеживать неработающие ссылки и ошибки сервера и экспортировать исходные URL-адреса разработчикам для исправления. Цифровые маркетологи могут анализировать заголовок страницы и метаописания, обнаруживать временные и постоянные перенаправления и обнаруживать заблокированные URL-адреса с помощью директив тегов. Это также позволяет пользователям очищать данные из HTML веб-страниц, используя путь CSS, XPath или регулярные выражения (regex).

Как начать работу в Netpeak Spider? Краткая инструкция для новичков

Screaming Frog SEO Spider интегрируется с различными сторонними платформами, такими как Google Analytics, Google Seach Console, PageSpeed и Link Metrics. Он доступен бесплатно и по годовой подписке и обеспечивает поддержку по телефону, электронной почте и в документации.

Screaming Frog работает как сканеры Google: он позволяет сканировать любой веб-сайт, включая сайты электронной коммерции. Но этот инструмент «SEO-паука» поднимает сканирование на ступеньку выше, предоставляя вам релевантные данные на сайте и создавая удобоваримую статистику и отчеты. С более простыми данными сайта от Screaming Frog вы можете легко увидеть, над какими областями вашего сайта нужно поработать.

Программное обеспечение Screaming Frog может помочь вам выполнить следующие задачи в области SEO:

- Поиск битых ссылок;

- Поиск временных и постоянных редиректов;

- Анализ метаданных;

- Поиск дублированного контента;

- Проверка robots.txt и других директив;

- Создание карты сайта XML;

- Анализ архитектуры сайта.

И, конечно же, вы можете сделать намного больше с Screaming Frog. Мы рассмотрим эти дополнительные функции в другом разделе.

Руководство по началу работы с SEO Spider

Установка

Для начала вам необходимо скачать и установить SEO Spider, который может сканировать до 500 URL-адресов за раз. Он доступен для Windows, MacOS и Ubuntu.

Затем дважды щелкните загруженный установочный файл SEO Spider и следуйте инструкциям программы установки.

Обучение Spider Project «ИСО» Продакшн ч. 1

Вы можете купить лицензию, которая снимает ограничение сканирования в 500 URL-адресов, открывает конфигурацию и предоставляет доступ к более продвинутым функциям. Посмотрите страницу с ценами, чтобы сравнить бесплатные и платные функции.

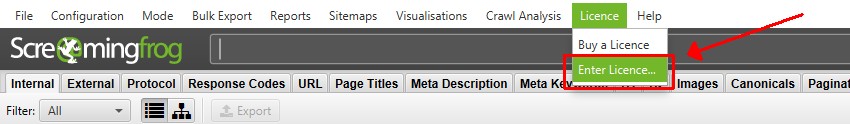

Активация лицензии

Если вы хотите использовать бесплатную версию, вы можете пропустить этот шаг. Однако если вы хотите просканировать более 500 URL-адресов, сохранить и повторно открыть сканирование и получить доступ к расширенным функциям, вы можете приобрести лицензию.

При покупке лицензии вам предоставляется имя пользователя и лицензионный ключ, которые необходимо ввести в приложении в разделе «Лицензия > Ввести лицензионный ключ».

При правильном вводе лицензия скажет, что она действительна, и покажет дату истечения срока действия. Затем вам потребуется перезапустить приложение, чтобы снять ограничение сканирования и разрешить доступ к конфигурации и платным функциям.

Если в лицензии указано, что она недействительна, ознакомьтесь с часто задаваемыми вопросами о распространенных проблемах с недействительной лицензией, чтобы устранить неполадки.

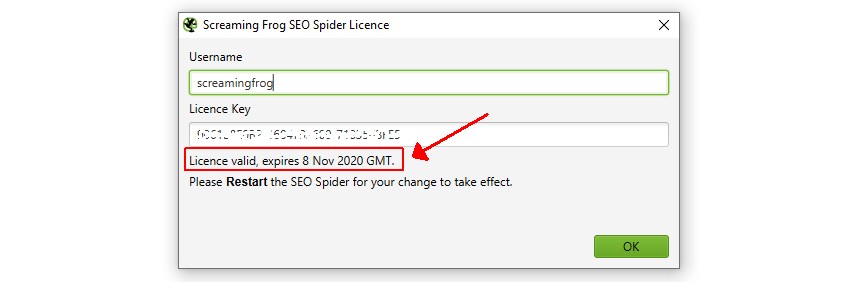

Настройка памяти и хранилища

Вы можете пропустить этот шаг, если используете бесплатную версию или просто хотите сразу приступить к сканированию. Однако, если вы используете платную версию, я рекомендую настроить ее с самого начала.

Если у вас есть SSD, то разработчики рекомендуют переключиться в режим хранения базы данных. Перейдите в «Конфигурация > Система > Режим хранения» и выберите «Режим хранения базы данных».

Режим хранения базы данных дает огромные преимущества, в том числе позволяет SEO Spider сканировать больше URL-адресов, автоматически сохранять данные сканирования и позволяет вам быстрее получать доступ к старым сканам.

Если у вас нет SSD, придерживайтесь режима хранения в оперативной памяти. Вы по-прежнему можете сохранять сканирование и сканировать множество URL-адресов, если у вас достаточно оперативной памяти.

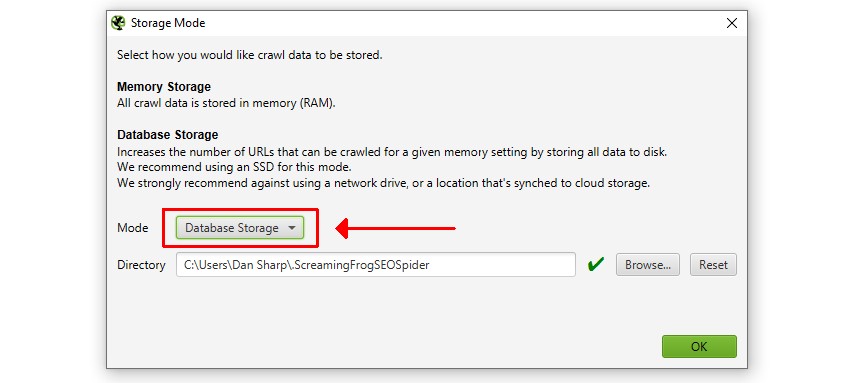

Запуск сканирования

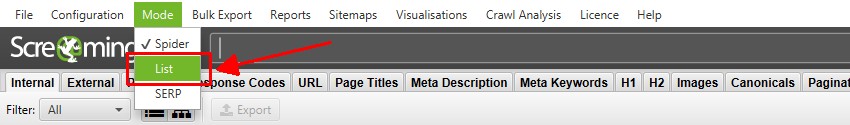

Существует два основных режима сканирования. Режим «Spider» по умолчанию, который сканирует веб-сайт, или «List», который позволяет загружать список URL-адресов для сканирования.

Вы можете начать обычное сканирование «Spider», вставив адрес домашней страницы в поле «Enter URL to spider» и нажав «Start».

Это просканирует и проверит введенный URL-адрес и все URL-адреса, которые он может обнаружить по гиперссылкам в HTML-страницах на том же поддомене.

Сканирование будет обновляться в режиме реального времени, а скорость и общее количество завершенных и оставшихся URL-адресов можно просмотреть в нижней части приложения.

Вы можете нажать «пауза» и «возобновить» сканирование в любое время. Вы также можете сохранить сканирование и возобновить его позже. Подробнее о сохранении чуть позже.

Если вы предпочитаете сканировать список URL-адресов, а не весь сайт, нажмите «Mode > List», чтобы загрузить или вставить список URL-адресов.

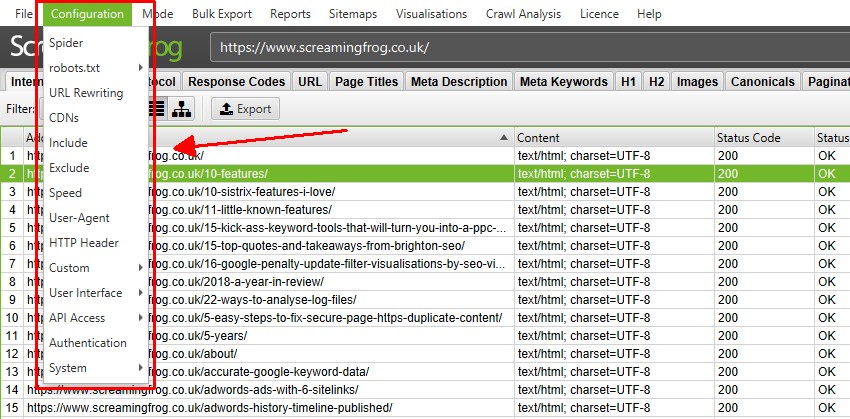

Настройка сканирования

Вам не нужно настраивать конфигурацию для сканирования веб-сайта, поскольку SEO Spider по умолчанию настроен на сканирование аналогично Google.

Однако существует множество способов настроить сканирование для получения нужных данных. Проверьте параметры в разделе «Configuration» в инструменте и обратитесь к нашему руководству пользователя для получения подробной информации о каждой настройке.

Некоторые из наиболее распространенных способов контроля того, что сканируется — это сканирование определенной подпапки, использование функций исключения (чтобы избежать сканирования URL-адресов по шаблону URL) или включения функций.

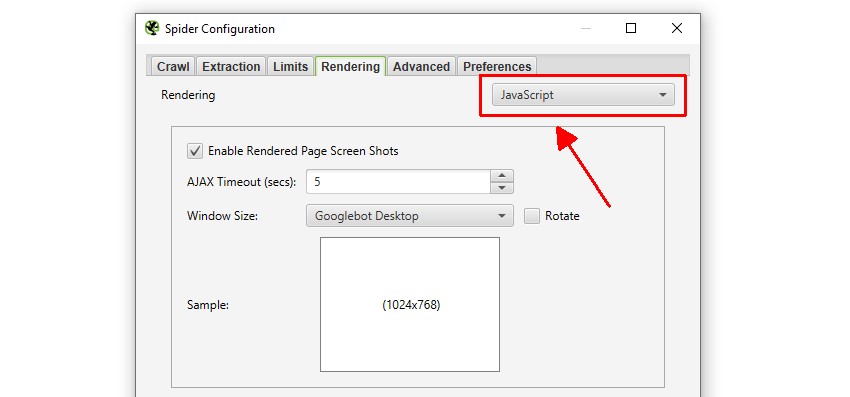

Если ваш веб-сайт использует JavaScript для заполнения контента, вы также можете переключиться в режим рендеринга JavaScript в разделе «Configuration > Spider > Rendering».

Это будет означать, что JavaScript выполняется, и SEO Spider будет сканировать контент и ссылки в отображаемом HTML.

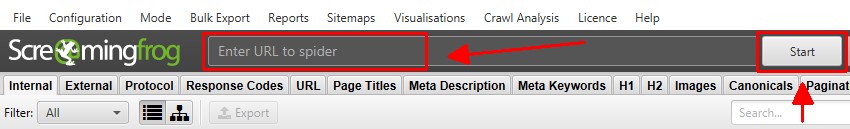

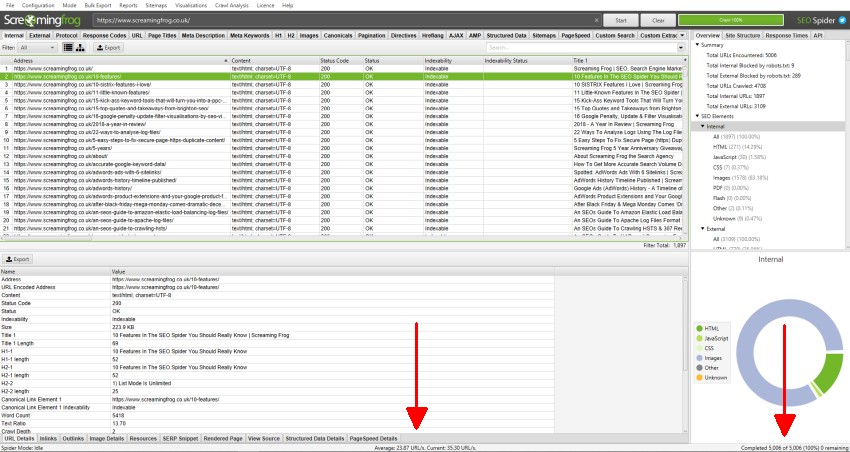

Просмотр данных сканирования

Данные сканирования заполняются в режиме реального времени в SEO Spider и отображаются на вкладках. Вкладка «Internal» содержит все данные, обнаруженные при сканировании просматриваемого веб-сайта. Вы можете прокручивать вверх, вниз и вправо, чтобы увидеть все данные в различных столбцах.

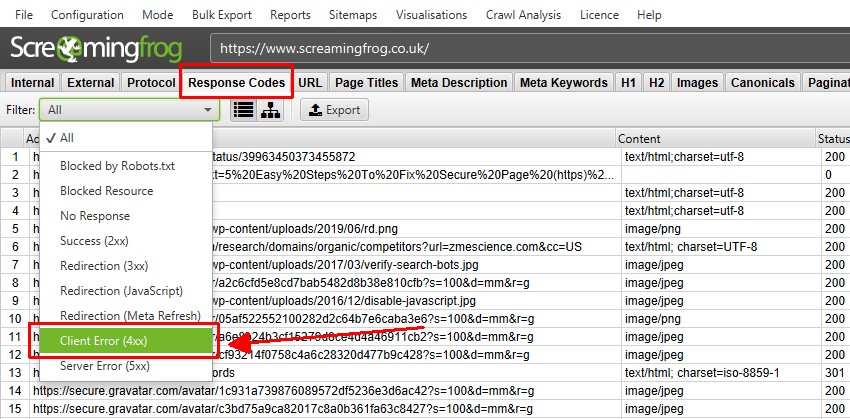

Вкладки сосредоточены на разных элементах, и на каждой из них есть фильтры, которые помогают уточнять данные по типу и потенциальным обнаруженным проблемам. Вкладка «Response Codes» и фильтр «Client Error (4xx)» покажут вам, например, все обнаруженные страницы 404.

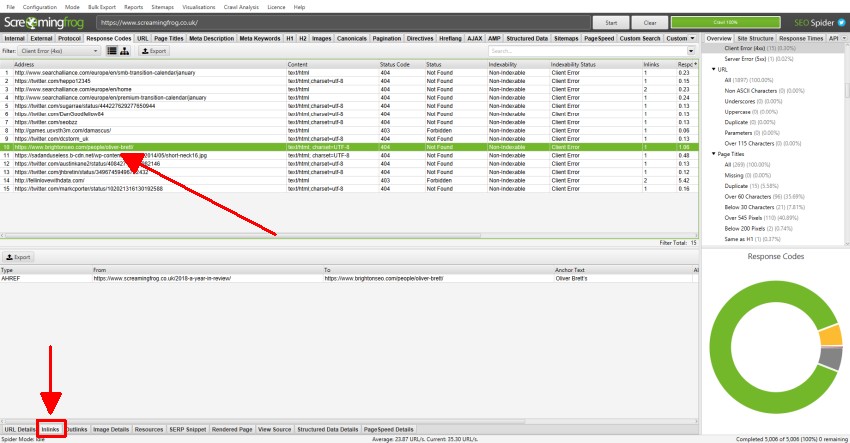

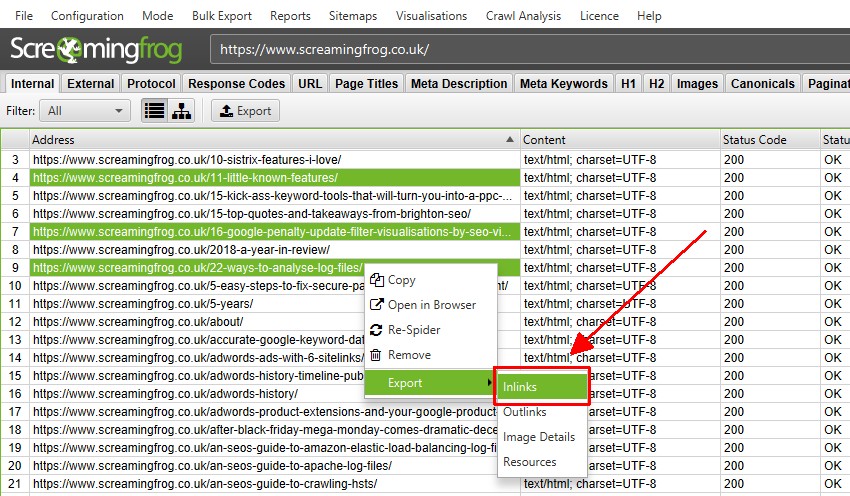

Вы можете нажать на URL-адреса в верхнем окне, а затем на вкладки внизу, чтобы заполнить нижнюю панель окна.

Эти вкладки предоставляют более подробную информацию об URL-адресе, например, их входящие ссылки (страницы, которые ссылаются на них), исходящие ссылки (страницы, на которые они ссылаются), изображения, ресурсы и многое другое.

В приведенном выше примере мы видим ссылки на неработающую ссылку, обнаруженную во время сканирования.

Обнаружение ошибок и проблем

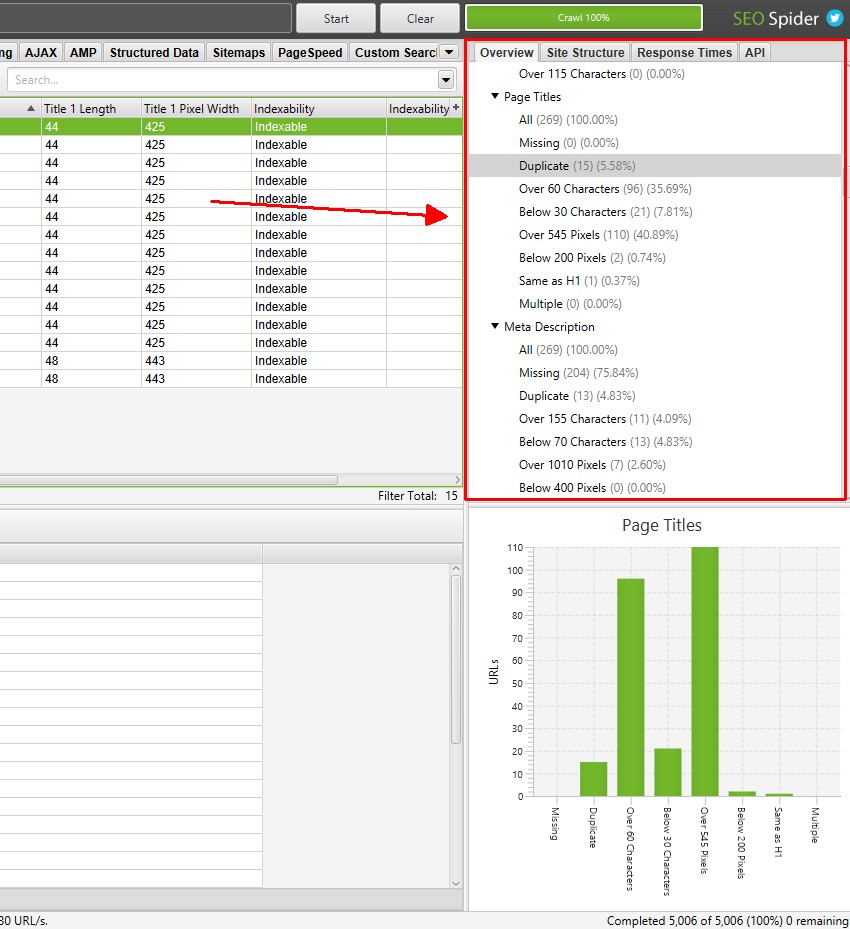

На вкладке «Overview» в правом окне отображается сводка данных сканирования, содержащихся на каждой вкладке и фильтре. Вы можете прокручивать каждый из этих разделов, чтобы определить потенциальные ошибки и обнаруженные проблемы, без необходимости нажимать на каждую вкладку и фильтровать.

Количество затронутых URL-адресов обновляется в режиме реального времени во время сканирования для большинства фильтров, и вы можете щелкнуть по ним, чтобы перейти непосредственно на соответствующую вкладку и фильтр.

SEO Spider не говорит вам, как делать SEO, он предоставляет вам данные для принятия более обоснованных решений. Тем не менее, «фильтры» дают подсказки по конкретным проблемам, которые следует решить или, по крайней мере, дополнительно рассмотреть в контексте вашего сайта.

Изучите эти подсказки, и если вы не уверены в значении вкладки или фильтра, просто обратитесь к нашему руководству пользователя. На каждой вкладке есть раздел (например, заголовки страниц , канонические значения и директивы ), в которых поясняется каждый столбец и фильтр.

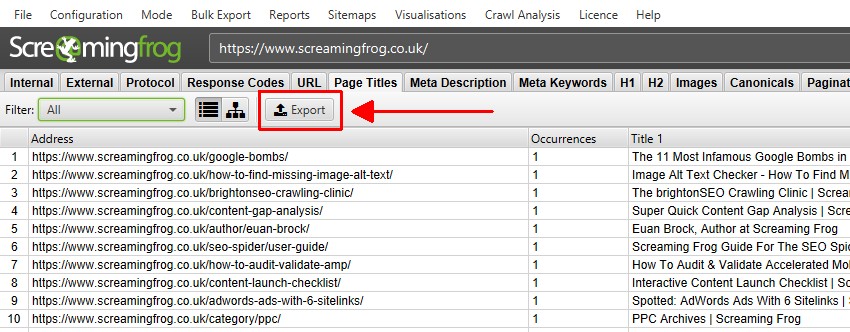

Экспорт данных

Вы можете экспортировать все данные в электронные таблицы из сканирования. Просто нажмите кнопку «Экспорт» в верхнем левом углу, чтобы экспортировать данные из вкладок и фильтров верхнего окна.

Чтобы экспортировать данные нижнего окна, щелкните правой кнопкой мыши по URL-адресам, с которых вы хотите экспортировать данные в верхнем окне, затем выберите один из вариантов.

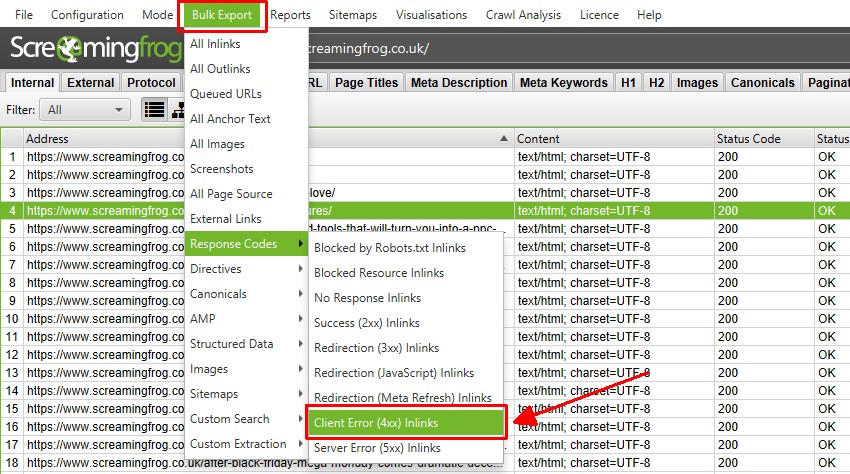

Также есть опция «Bulk Export», расположенная в меню верхнего уровня. Это позволяет вам экспортировать исходные ссылки, например, «входящие ссылки» на URL-адреса с определенными кодами состояния, такими как ответы 2XX, 3XX, 4XX или 5XX.

В приведенном выше примере выбор параметра «Client Error 4XX In Links» выше приведет к экспорту всех внутренних ссылок на все страницы с ошибками (страницы, которые ссылаются на страницы с ошибкой 404).

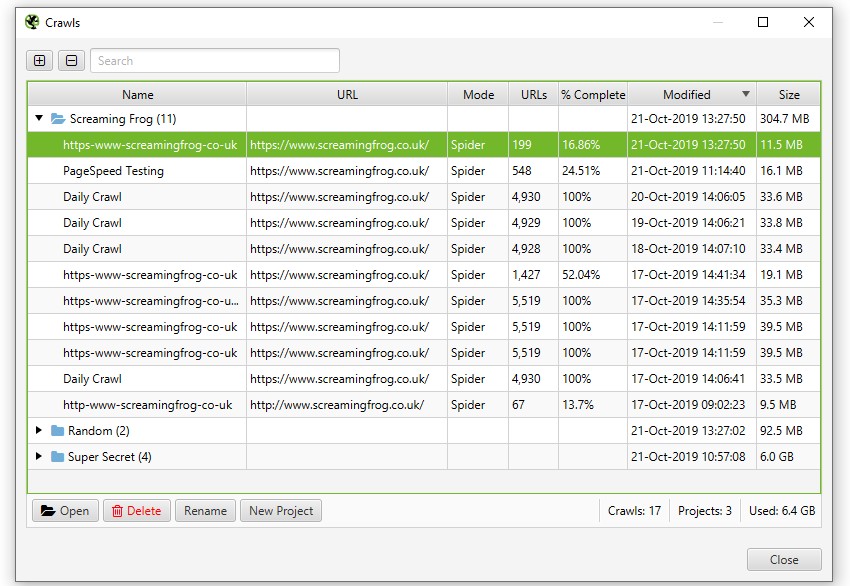

Сохранение и открытие обходов

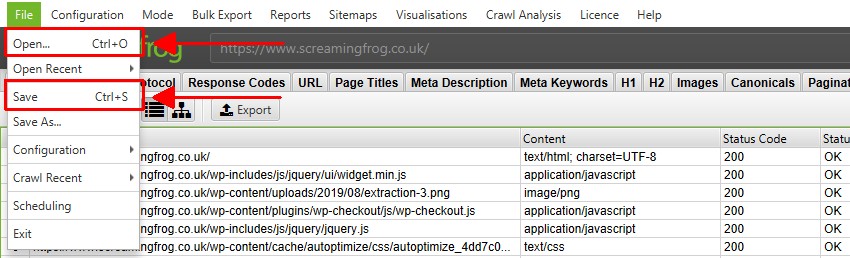

Вы можете сохранять и открывать обходы только с лицензией. В режиме хранения в памяти, по умолчанию вы можете сохранить сканирование в любое время (когда оно было приостановлено или завершено) и повторно открыть, выбрав «File > Save» или «File > Open».

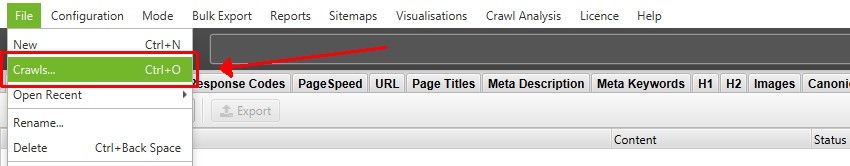

В режиме хранения базы данных, обходы автоматически «сохраняются» и фиксируются в базе данных во время обхода. Чтобы открыть сканирование, нажмите «File > Crawls» в главном меню.

В окне «Crawls» отображается обзор автоматически сохраненных обходов, где вы можете открывать, переименовывать, организовывать в папки проекта, дублировать, экспортировать или удалять их массово.

Популярные и расширенные функции

Как вы сами понимаете, в рамках одной статьи не возможно охватить все варианты использования и функции этого инструмента, поэтому рекомендую вам изучить доступные варианты и при необходимости обратиться к подробному руководству пользователя.

Тем не менее, прилагаю список некоторых наиболее распространенных применений SEO Spider со ссылками для дополнительного изучения.

- Найдите неработающие ссылки — мгновенно просканируйте веб-сайт и найдите неработающие ссылки (404) и ошибки сервера. Массовый экспорт ошибок и исходных URL для исправления или отправки разработчику.

- Аудит перенаправлений. Найдите временные и постоянные перенаправления, определите цепочки и петли перенаправлений или загрузите список URL-адресов для аудита при переносе сайта.

- Анализ заголовков и метаописаний страниц. Просмотрите заголовки и метаописания каждой страницы, чтобы обнаружить неоптимизированные, отсутствующие, повторяющиеся, длинные или короткие элементы.

- Просмотрите директивы и канонические правила. Просмотрите URL-адреса, заблокированные файлом robots.txt, директивами meta robots или X-Robots-Tag, такими как noindex или nofollow, и проверьте канонические правила.

- Найдите alt текст и атрибуты отсутствующего изображения. Найдите изображения, в которых отсутствует alt текст, и просмотрите alt текст каждого изображения при сканировании.

- Проверка на дублированный контент — проанализируйте веб-сайт на наличие точных дубликатов страниц и почти дублирующегося «похожего» контента.

- Сканирование веб-сайтов JavaScript. Отрисовывайте веб-страницы с помощью встроенного Chromium WRS для сканирования динамических веб-сайтов и фреймворков с большим количеством JavaScript, таких как Angular, React и Vue.js.

- Визуализируйте архитектуру сайта. Оцените структуру внутренних ссылок и URL-адресов с помощью интерактивных схем сканирования и каталогов, а также визуализаций сайта в виде древовидного графа.

- Создание файлов Sitemap в формате XML. Быстро создавайте файлы Sitemap в формате XML и файлы Sitemap в формате XML с расширенной настройкой URL-адресов, включая последние изменения, приоритет и частоту изменений.

- Аудит международной настройки (hreflang) — Найдите распространенные ошибки и проблемы с аннотациями hreflang в HTML, через HTTP-заголовок или в XML-картах сайта в масштабе.

- Анализируйте PageSpeed и Core Web Vitals — подключайтесь к PSI API для Core Web Vitals (полевые данные CrUX), метрикам Lighthouse, возможностям повышения скорости и диагностике в любом масштабе.

Также предлагаю список некоторых из наиболее популярных функций:

- Schedule Crawls — запланируйте сканирование для автоматического запуска в SEO Spider, как разовое или через выбранные промежутки времени.

- Сравните сканирование и промежуточное сканирование — отслеживайте ход решения проблем и возможностей SEO и смотрите, что изменилось между сканированиями. Сравните промежуточную среду с рабочей средой, используя расширенное сопоставление URL-адресов.

- Интеграция с GA, GSC и PSI. Подключайтесь к API Google Analytics , Search Console и PageSpeed Insights и извлекайте данные о пользователях и производительности для всех URL-адресов при сканировании для более глубокого понимания.

- Пользовательский поиск HTML — находите все, что хотите, в исходном коде веб-сайта. Будь то код Google Analytics, конкретный текст или код и т. д.

- Извлечение данных с помощью XPath. Собирайте любые данные из HTML-кода веб-страницы, используя путь CSS, XPath или регулярное выражение. Это могут быть социальные метатеги, дополнительные заголовки, цены, SKU и многое другое.

- Сканирование промежуточных сайтов и сайтов разработки . Войдите на промежуточный веб-сайт, используя базовую аутентификацию, дайджест или веб-формы.

- Управляйте через командную строку — программно запускайте сканирование через командную строку для интеграции с вашими собственными внутренними системами.

Приведенное выше руководство должно помочь проиллюстрировать простые шаги, необходимые для начала работы с SEO Spider.

Оригинал статьи взят с сайта SEO Jedi

Оцените статью

- Технический экспресс-аудит с помощью Screaming Frog SEO Spider

- Технический аудит сайта с помощью Screaming Frog SEO spider

- Netpeak Spider vs Screaming Frog: обзор сервисов для анализа сайта

Источник: screamingfrog.su

Анализатор сайтов — Netpeak Spider

Netpeak Spider — анализатор сайтов для выявления проблем оптимизации, быстрого поиска ошибок, системного seo анализа и парсинга сайтов. Предназначен для seo специалистов, вебмастеров и технически грамотных пользователей, способных анализировать, выявлять и устранять ошибки оптимизации сайта. Ведь полученные данные нужно уметь понимать и правильно использовать. Хотя такие ошибки, как битые ссылки, title, meta description, alt будут понятны всем без исключения.

Анализатор сайта — Netpeak Spider, решает любые задачи технической оптимизации сайта. Быстро выполнит полный технический seo-аудит любого сайта. Программа проведет глубокую seo-аналитику с применением сегментации, покажет полную структуру сайта, поможет улучшить перелинковку и поднять Pagerank.

Анализируя ваших конкурентов с Нетпик Спайдер, вы узнаете всю их подноготную и слабые места. С помощью анализатора сайтов вы получите заголовки, описание и ключи всех конкурентов в удобной таблице Excel. Программа достанет практически всю информацию, которая нужна для оценки ресурса.

От аналогичных программ (Screaming Frog SEO Spider, Sitebulb, WebSite Auditor) отличается высокой скоростью работы, меньшим потреблением памяти, функциональностью (работает с большими сайтами) и лучшими техническими отчетами (например: экспресс-аудит в PDF).

Основные возможности программы Netpeak Spider:

- Проверка ошибок оптимизации по 100+ параметрам

- Анализ сайта по 70+ SEO-параметров

- Сканирование больших сайтов с высокой скоростью

- Парсинг сайтов и извлечение данных

- Cегментация и фильтрация данных

- Расчёт внутреннего PageRank

- Проверка орфографии — 70 языков на которых можно проверить сайт

- Генератор Sitemap

- Валидатор XML Sitemap

- Анализ исходного кода и HTTP-заголовков

- Сканирование через виртуальный robots.txt

- Интеграция с Google Analytics и Search Console

- Интеграция с Яндекс.Метрикой

- Аудит качества оптимизации в PDF

- Экспорт данных в XLSX, CSV, Google Диск

- Работа с прокси

- Резервное копирование данных (автосохранение каждые 15 минут)

- Автоматическое обновление

- Онлайн поддержка

- Английский и русскоязычный интерфейс

- Работает на Windows и macOS

- Бесплатная и платная версии

Чтобы начать пользоваться программой, необходимо зарегистрироваться на сайте. После регистрации скачайте специальную программу Netpeak Launcher, запустите её и авторизируйтесь. В окне программы выберите Netpeak Spider, установите и запустите.

Для первого знакомства с программой вполне подойдут настройки программы по умолчанию. Но посмотреть на них, все же не помешает. Пройдитесь по всем пунктам и ознакомьтесь с ними.

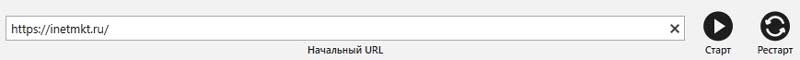

Если вас все устраивает, закройте окно с настройками и вставьте адрес сайта в поле «Начальный URL» и нажмите «Старт» на панели управления. Настройки по умолчанию подходят для общего анализа состояния сайта и решения стандартных seo-задач.

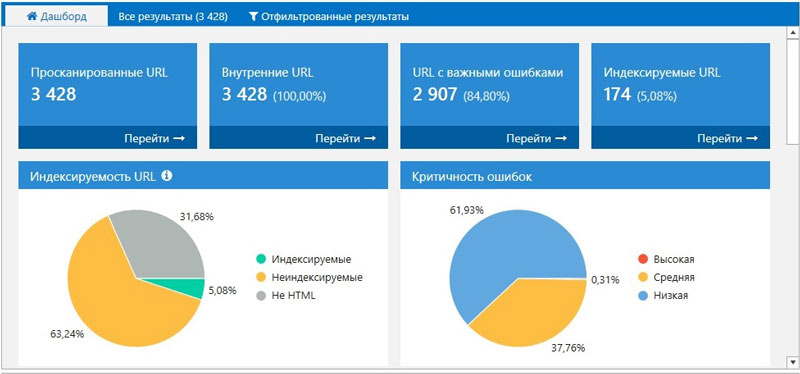

После окончания сканирования в левой части программы будет окно с результатами, а в правой части — отчеты в виде списка ошибок.

На вкладке «Дашборд» отображается данные о настройках и ходе сканирования, круговые и столбчатые диаграммы, вообще вся наглядная информация о состоянии сайта.

Главное предназначение программы, найти все ошибки, как критические, так и малозначимые и показать пути где их искать. По уровню значимости все ошибки выделены разным цветом. Анализатор сайтов разделяет данные об ошибках на три основные категории — ошибки с высокой критичностью, средней критичностью и низкой.

При клике на ошибку программа покажет список страниц, на которых она обнаружена, в информационной панели внизу увидите, что это за ошибка, чем она грозит и как её исправить. В том числе список адресов на полезные и информационные материалы.

Ошибки с высокой критичностью необходимо обязательно устранить, так как, именно они мешают продвижению сайта. В первую очередь это битые страницы, 4xx ошибки, редиректы, висячие узлы и дубликаты. Для этого есть два пути. Исправить все ошибки самостоятельно или отдать отчет ошибок на исправление специалисту.

Если решили самостоятельно устранить ошибки (например битые страницы и редиректы в wordpress) советую использовать плагины broken link cheker и better search replace. Первый проверит ссылки, а второй вычистит базу данных от неправильных адресов. Ну и конечно приложить руки. Именно таким образом я избавился от всех редиректов на этом сайте.

От других ошибок поможет избавиться плагин clearfy. Еще хочу обратить внимание на такую ошибку, как время ответа сервера. Эта ошибка напрямую зависит от хостинга вашего сайта. При продвижении в Google эта ошибка скажется отрицательно.

Мне например, пришлось поменять хостинг на другой (более быстрый) и страниц с большим временем ответа сервера в разы сократилось, что сразу заметил гугл (яндекс никак не отреагировал). В течении месяца выросли позиции по запросам в гугл.

В search console все сразу видно, что надо делать и реакцию на действия.

Инструменты Netpeak Spider

Отдельно хочется сказать об инструменте PageRank. Не каждый анализатор сайтов имеет в своем арсенале такую полезную функцию, как расчет внутреннего веса страниц. Да и программ определяющих PageRank на рынке seo услуг очень немного. Netpeak Spider позволяет узнать, как распределяется ссылочный вес по страницам, находить страницы (висячий узел) мешающие распределению PageRank.

Моделировать изменения PageRank страниц при внесении изменений на сайте. Просматривать вес входящих и исходящих ссылок на сайте. Очень нужный и полезный инструмент для продвижения сайта.

Анализатор сайтов — парсинг данных

Одним из главных инструментов программы, является парсинг данных. Подробнее об этом в этой статье. Инструмент парсинга в Netpeak Spider позволяет парсить любые HTML-данные, в том числе объёмы массивов данных (цены, товары, телефоны, емайлы, контакты, лайки, комментарии, обзоры, seo тексты, метрики и много других данных).

В программе реализовано четыре вида парсинга.

- По условию — Содержит. Простой вид парсинга. Определяет количество заданных элементов на странице.

- С помощью регулярного выражения RegExp. Требует базовых знаний регулярных выражений.

- На основе синтаксиса XPath. Некоторые примеры использования Xpath можно найти в этой статье.

- При помощи заданного CSS-селектора

Расписывать все функции работы, настройки и инструменты Netpeak Spider в статье не вижу особого смысла. Об этом на сайте программы есть подробная инструкция по настройке и практическом использовании Нетпик Спайдер. Перейти туда можно кликнув в программе на вкладку «Помощь — Перейти в центр поддержки».

Заключение

Анализатор сайтов Netpeak Spider многофункциональный инструмент высокого класса, умеющий не только анализировать и находить ошибки, но и извлекать любые данные с сайтов. Эффективный помощник SEO-специалистов и вебмастеров для автоматизации повседневных задач. Интеграция с Google Analytics, Search Console, Яндекс.Метрикой и огромная внутренняя база данных расширяют возможности Netpeak Spider до небывалых высот.

Программа выпускается как бесплатная версия и платная. В бесплатной версии нет сохранения проектов, копирования и отчетов. Если решитесь на покупку программы, пройдя по ссылке получите скидку 25%. Фактически вы покупаете сразу несколько программ (как минимум сканер, парсер, расчет веса) по цене одной.

ПС. Для полноты картины не хватает только визуализации, как например у конкурента Sitebulb.

Советую почитать:

- Бесплатный аудит сайтов программой Netpeak Spider

- Netpeak Spider. Бесплатный seo анализ сайта

- Screaming Frog SEO Spider — бесплатный seo аудит сайта

- Технический анализ сайта — программа SiteAnalyzer

- Бесплатный анализатор логов сервера

Источник: www.websteel.ru

Программа Netpeak Spider

Netpeak Spider – это программный продукт для проведения комплексного аудита сайта. При помощи программы можно проводить анализ Сео параметров сайта и получать основные технические показатели.

- Основные возможности

- Как начать работу с программой

- Интерфейс программы

- Настройки программы

- Тарифы

- Что мы получаем при работе с программой

Основные возможности

Netpeak Spider позволяет собирать данные для проведения анализа следующих Сео показателей:

- Проверка индексации страниц сайта.

- Коды ответа сервера.

- Время ответа сервера.

- Анализ заполнения тега Title.

- Анализ заполнения метатега Description.

- Анализ заполнения заголовка страницы сайта H1 и подзаголовков H2 – H6.

- Определение объема контента на страницах сайта.

- Контроль оптимизации графики на сайте.

- Заполнение тега rel=”canonical” и атрибутов пагинации

- Определение дубликатов контента, тегов Title, Description.

- Выявление «битых ссылок».

- Подсчет внутреннего Page Rank.

- Проверка и генерация «Карты сайта».

- Анализ структуры сайта.

- И еще ряд дополнительных возможностей.

Как начать работать с Нетпик Спайдер

Для начала работы необходимо зайти на сайт Netpeak Software и зарегистрироваться или активировать свой аккаунт. Это надо сделать для получения доступа к скачиванию программы.

Владельцы продукта предоставляют пользователям начальный период для ознакомления с работой инструмента сроком 14 дней. Далее уже придется оплачивать работу с продуктом.

После скачивания и установки программы на свой ПК, приступаем к работе.

Интерфейс программы

Основной экран программы состоит из таких частей:

- Верхнее меню.

- Тулбар.

- Боковой блок – настройки и отчеты.

- Основная рабочая область.

- Информационный блок – содержит расширенную информацию по строкам из основного блока.

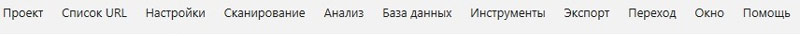

Верхнее меню

Верхнее меню состоит из 11 пунктов и позволяет работать со всеми возможностями программы.

- Пункт «Проект» позволяет управлять проектами: создавать новые, сохранять результаты, удалять ненужные, открывать и работать с ранее сохраненными проектами.

- Пункт «Список URL» дает возможность задавать список адресов, которые пользователю необходимо просканировать для анализа. Есть несколько вариантов для задания списка, набирать вручную, поместить из буфера обмена или файла, вставить из «Карты сайта».

Также эти списки можно сохранять, редактировать, удалять. - Пункт «Настройки» позволяет настроить процессы сканирования. На этом пункте подробнее остановимся немного позже.

- Пункт «Сканирование» служит для запуска, остановки и перезапуска краулера.

- Пункт «Анализ» дает доступ к информации по дубликатам, входящим ссылкам, цепочкам canonical, позволяет рассчитать внутренний Page Rank.

- Пункт «База данных» используется для быстрого доступа к данным по ссылкам: входящим, исходящим, внутренним и внешним. А также к данным по изображениям, списку ошибок, редиректов, канонических страниц, заголовков.

- Пункт «Инструменты» позволяет получить доступ к анализу исходного html-кода, рассчитать внутренний Page Rank, произвести валидацию «Карты сайта» Sitemap, генерировать Sitemap.

- Пункт «Экспорт» служит для выгрузки всех доступных отчетов в форматах xlsl или csv. Можно выгружать все отчеты, либо только те, которые необходимо.

- Пункт «Переход» упрощает навигацию по блокам программы.

- Пункт «Окно» дает возможность работать с несколькими окнами одновременно.

- Пункт «Помощь» служит для оказания помощи пользователям, дает возможность для связи с представителями компании, доступ к новостям на сайте, информацию об изменениях в различных версиях программы.

Тулбар

Тулбар предназначен для запуска сканирования сайтом. Он дублирует большинство возможносте пункта меню «Сканирование».

Позволяет запускать, останавливать и перезапускать процесс сканирования сайта.

Кроме этого можно получить быстрый доступ к инструментам и экспорту отчетов, выгрузить текущую таблицу или обновить ее, произвести поиск по результатам сканирования, настроить сегмент.

Боковой блок – настройки и отчеты.

Вкладка «Параметры»

В начале работы необходимо задать параметры сканирования данных. Эта вкладка расположена в боковом блоке.

Если Вы запускаете программу впервые, то оставьте параметры обхода сайта по умолчанию. В дальнейшем будете выбирать те настройки, которые Вас интересуют.

Вкладка «Отчеты»

Эта вкладка содержит отчеты по собранным показателям сайта. Состоит из 4 подпунктов:

- Ошибки. Можно смотреть отчеты, сгруппированные по типам ошибок и степени их критичности.

- Сводка. Содержит сводную информацию по результатам работы программы.

- Структура сайта. Формирует структуру сайта.

- Парсинг. Отображает результаты парсинга.

Основная рабочая область

Состоит из 3 вкладок:

- Дашборд

- Все результаты

- Отфильтрованные результаты

Вкладка «Дашборд»

Эта вкладка выполняет 2 функции:

1. Отображает процесс сканирования сайта. Это позволяет контролировать работу краулера и при необходимости вмешиваться и производить дополнительные настройки сканирования.

2. После завершения работы отображает сводные данные в виденаглядных и доступных графиков.

Справа расположены данные о найденных ошибках, они структурированы по степени тяжести, категориям и подкатегориям.

Далее оптимизаторам уже придется включать свою голову и разбираться, что делать со всей этой информацией. Какие ошибки исправлять в первую очередь, какие во вторую, а на какие можно и не реагировать.

Вкладка «Все результаты» содержит таблицу со всеми результатами работы программы по анализу сайта.

Вкладка «Отфильтрованные результаты» отображает данные по какой-то отдельной части сайта или конкретной проблеме.

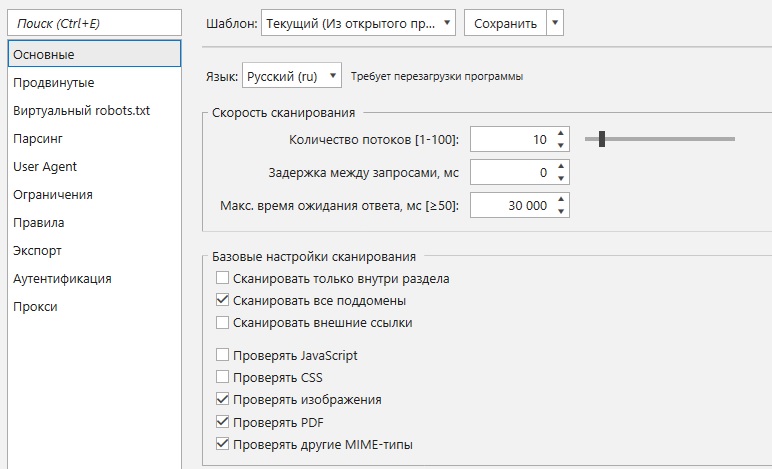

Настройка программы

Доступ к настройкам возможен через соответствующий пункт «Верхнего меню». Настройки распределены по 10 вкладкам, давайте кратко пройдемся по ним.

Для указания определенной возможности надо активировать соответствующий чек-бокс.

- Вкладка «Основные». Позволяет выбрать язык интерфейса программы, настроить скорость сканирования и задать базовые настройки сканирования.

- Вкладка «Продвинутые». Здесь настраиваем сканирование страниц, согласно директивам из различных источников: robots.txt, Cannonical, refresh, и других.

Также указываем сканировать или нет содержимое тегов link, условия остановки сканирования, обрабатывать ли cookies и страницы с четырехсотыми (4хх) кодами ответов. - Виртуальный robots. Позволяет тестировать файлы robots.txt для указанного сайта. Это полезно, если Вы не уверенны в том, как сработают директивы файла для вашего ресурса.

- Вкладка «Парсинг». Предназначена для настройки сбора информации на сайте по регулярным выражениям, css селекторам, атрибутам XPath.

- Вкладка User-Agent предназначена для указания типа сканирующего бота для работы программы.

- Вкладка «Ограничения» служит для задания ограничений при сканировании и настройки критериев для определения ошибок, максимальная длина тегов, количество ссылок и т.п.

- Вкладка «Правила» позволяет ввести дополнительные условия для сканирования.

- Вкладка «Экспорт» содержит настройки для выгрузки результатов. Формат файла XLSL или CSV, региональные настройки, настройки вывода ошибок, формирование названия файлов экспорта, выделение цветом ячейки при выгрузке.

- Вкладка «Аутентификация» дает возможность ограничить доступ к сайтам.

- Вкладка «Прокси» предназначена для настройки прокси сервера, если для этого есть необходимость.

В начале эксплуатации нет большой необходимости вникать в тонкости настройки программы. Используйте настройки по умолчанию. При дальнейшей работе постепенно освоите все возможности и настройки у Вас не будут вызывать затруднений.

Анализ больших сайтов

В обновленной версии программы значительно улучшились скоростные показатели обработки сайтов. Особенно это заметно при работе с большими сайтами. Наряду со значительным увеличением сканирования, появилась возможность приостановки этого процесса, и продолжения в любой удобный момент времени.

То есть обработку можно разбивать на несколько частей.

Также есть возможность повторного сканирования данных в отдельных таблицах и даже отдельных страниц.

Все это делает работу над исправлением ошибок более наглядной и комфортной.

Дополнительные возможности

Программа позволяет хранить всю историю работы с ней. Так, приступая работе с сайтом и проводя его аудит, сохраняем результаты первого сканирования. По мере работе над ошибками проводим промежуточные прогоны программы, и тоже их можно фиксировать.

И в конце работы проводим финальное сканирование. Это дает возможность сравнить итоговые показатели с начальными, и в целом оценить эффективность работ по внутренней оптимизации сайта. Эти данные можно использовать при работе над отчетами заказчику на продвижение сайта.

В одной публикации невозможно подробно описать весь функционал Netpeak Spider. Более детально можно узнать о тонкостях работы с программой лишь самому попробовав ее в деле.

Стоимость программы

Для работы с программой необходимо приобрести лицензию, стоимость которой равна 19 $ в месяц, если тариф Стандарт и 39 $ в месяц, если тариф PRO. При покупке лицензии на более долгий срок, ее стоимость снижается. Так годовая лицензия Стандарт обойдется в 182,40 $, то есть экономия 45,60 $. Если Вы приобретаете более 1 лицензии, то стоимость каждой также снижается.

Я являюсь партнером компании «Netpeak Software» и для читателей моего блока есть возможность приобрести лицензию на работу с программой с 25% скидкой. Для этого надо перейти по этой ссылке и при покупке следует указать промокод inetmktNS.

Netpeak Spider имеет бесплатную версию, в которой доступен практически весь функционал без ограничений по времени использования, количеству URL и с возможностью кастомизации настроек.

Что мы получаем при работе с Netpeak Spider?

Используя в своей работе инструменты программы Netpeak Spider, мы получаем возможность проведения качественного аудита сайта. Это дает нам контроль над всеми основными техническими и Сео параметрами сайта.

Выявление и исправление ошибок внутренней оптимизации сайта улучшает его Seo параметры. Оценка качества перелинковки позволяет правильно распределить внутренний вес внутри сайта и улучшить показатели Page Rank для важных страниц. И это только основные плюсы программы.

Эти мероприятия позволят нам повысить качество сайта, что будет положительно оценено, как посетителями, так и поисковыми системами.

Страницы сайта заслуженно займут места в ТОПе, что в конечном итоге приведет новых клиентов в Ваш бизнес и повысит доход и престиж Вашей компании.

![]()

Рубрика: Seo-оптимизация

Источник: inetmkt.ru