Есть много причин, по которым вам следует подумать о Скачать сайты от корки до корки. Не все веб-сайты выживают до конца своей жизни. Иногда, когда веб-сайты не приносят прибыли или когда разработчик теряет интерес к проекту, он (-ы) берет веб-сайт вместе со всем потрясающим контентом. Все еще есть части мира, где Интернет недоступен постоянно или где люди не имеют доступа к Интернету 24 часа в сутки 7. Автономный доступ к веб-сайтам может быть благом для этих людей.

В любом случае это хорошо сохранить места Задача получить ценные данные в Автономный режим Так что вы можете обращаться к нему, когда захотите. Это также возможность сэкономить время. Вам не потребуется подключение к Интернету, и вам никогда не придется беспокоиться о закрытии веб-сайта. Существует множество программ и веб-сервисов, которые позволяют загружать веб-сайты для просмотра в автономном режиме.

Давайте посмотрим на них ниже.

Как полностью скачать сайт с CSS, JavaScript и картинками

Скачать весь сайт

1. ХТТрек

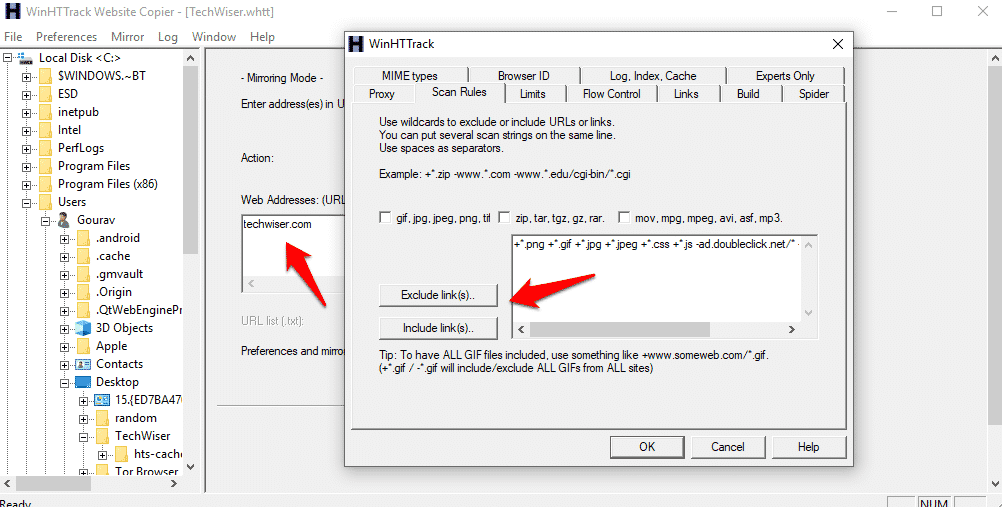

Вероятно, это один из старейших загрузчиков веб-сайтов. для Windows. Версия мобильного или веб-приложения недоступна в основном потому, что в те дни наиболее широко используемой платформой была Windows. Пользовательский интерфейс устарел, но функции мощные и по-прежнему работают как шарм. Этот загрузчик веб-сайтов с открытым исходным кодом под лицензией GPL как бесплатное программное обеспечение имеет легкую тему.

يمكنك Скачать все веб-страницы Включая файлы и изображения со всеми восстановленными и неповрежденными ссылками. Открыв отдельную страницу, вы можете перемещаться по всему веб-сайту в своем браузере, Не в сети , следуя структуре ссылок. Что мне нравится в HTTrack, так это то, что он позволяет мне загружать на жесткий диск только самую последнюю обновленную часть, поэтому мне не нужно загружать все заново. Он поставляется с правилами сканирования, которые позволяют включать или исключать типы файлов, веб-страницы и ссылки.

Положительные:

- مجاني

- Открытый источник

- Правила экзамена

минусы:

- Датированный пользовательский интерфейс

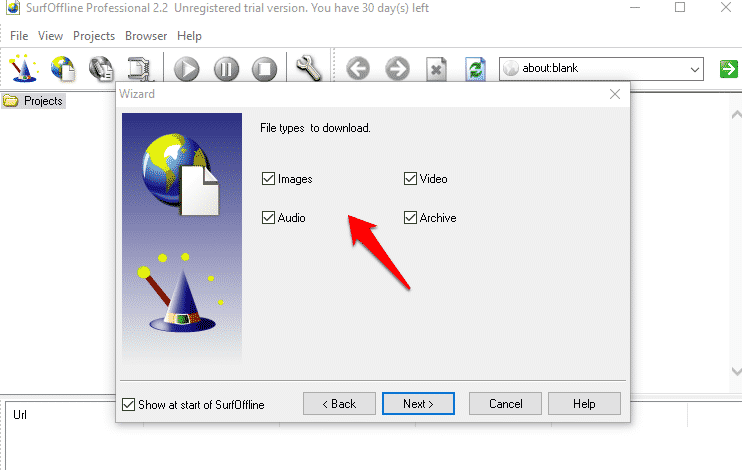

2. SurfOnline

SurfOnline — еще одна программа для Windows, которую вы можете использовать для загрузки веб-сайтов для автономного использования, но она не бесплатна. Вместо того, чтобы открывать веб-страницы в браузере, таком как Chrome, вы можете просматривать загруженные страницы прямо в SurfOnline. Как и в HTTrack, есть правила Чтобы скачать типы файлов Однако он очень ограничен. Вы можете выбрать только тип мультимедиа, но не тип файла.

Вы можете загружать до 100 файлов за раз, но общее количество не может превышать 400000 39.95 файлов на проект. С другой стороны, вы также можете загружать защищенные паролем файлы и веб-страницы. Цены на SurfOnline начинаются с 120 долларов и доходят до XNUMX долларов.

Положительные:

- Правила экзамена

- поддержка файлов chm

- Запись компакт-дисков

- Встроенный браузер

- Скачать страницы, защищенные паролем

минусы:

- Датированный пользовательский интерфейс

- Не бесплатно

- Правила экзамена ограничены

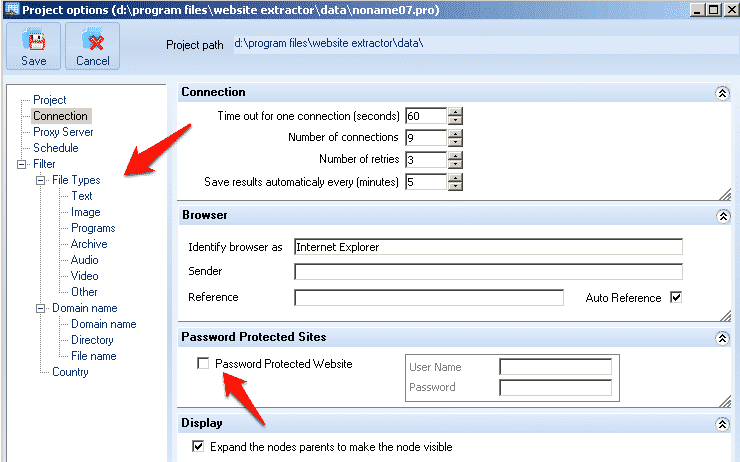

3. Веб-сайт eExtractor

Еще один загрузчик веб-сайтов с собственным браузером. Честно говоря, я бы придерживался Chrome или что-то вроде Firefox. В любом случае, Website eXtractor выглядит и работает очень похоже на то, как работают два предыдущих загрузчика веб-сайтов, которые мы обсуждали. Вы можете удалять или включать файлы на основе ссылок, имени, типа мультимедиа, а также типа файла. Также есть возможность загружать файлы или нет, в зависимости от каталога.

Одна из функций, которые мне нравятся, — это возможность поиска файлов на основе расширения файла, что может сэкономить вам много времени, если вы ищете определенный тип файла, например электронные книги. В описании говорится, что он поставляется с удобным создателем базы данных для переноса сайтов на новый сервер, но, по моему личному опыту, для этой задачи доступны гораздо лучшие инструменты.

Бесплатная версия ограничена загрузкой 10000 29.95 файлов, после чего она будет стоить вам XNUMX долларов.

Положительные:

- Встроенный браузер

- создатель базы данных

- Поиск по типу файла

- Правила экзамена

минусы:

- Не бесплатно

- Базовый пользовательский интерфейс

4. Уходите влево

Getleft имеет лучший и современный пользовательский интерфейс по сравнению с вышеупомянутыми загрузчиками веб-сайтов. В нем есть несколько полезных сочетаний клавиш, которые оценят обычные пользователи. Getleft — это программа Бесплатный и открытый исходный код А когда дело доходит до разработки, это совсем не так.

Нет поддержки безопасных сайтов (протокол HTTPS) Однако вы можете установить правила для загрузки типов файлов.

Положительные:

- Открытый источник

минусы:

- нет развития

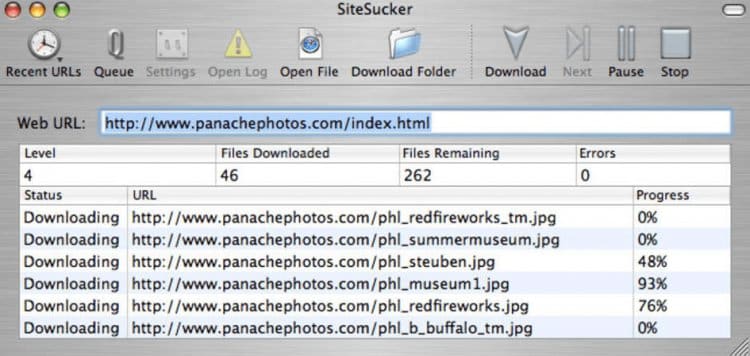

5. SiteSucker

SiteSucker — первая программа для загрузки сайтов для macOS. На это не приятно смотреть, но вы все равно используете загрузчик сайта не поэтому. Я не уверен, является ли это ограничительным характером экосистемы Apple или разработчик не думал о будущем, но SiteSucker не хватает ключевых функций, таких как правила поиска и сканирования.

Это означает, что нет возможности указать программе, что вы хотите скачать, а что нужно оставить в покое. Просто введите URL-адрес сайта и нажмите «Пуск», чтобы начать процесс загрузки. С другой стороны, есть возможность перевести загруженный материал на разные языки. SiteSucker обойдется вам в 4.99 доллара.

Положительные:

- Переводчик языков

минусы:

- Нет правил сканирования

- без поиска

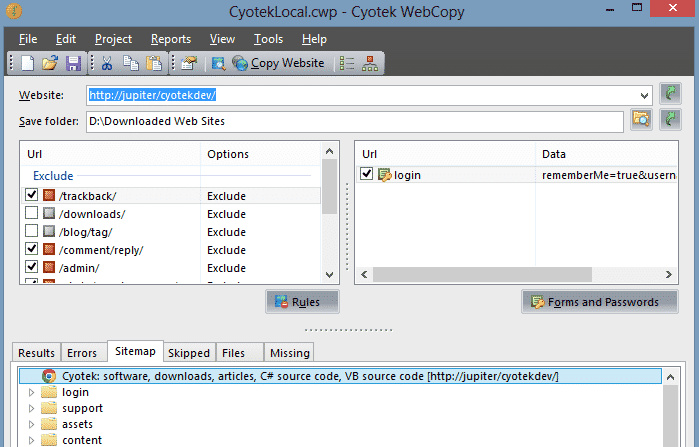

6. Циотек Вебкопи

Cyotek Webcopy — еще один загрузчик веб-сайтов, к которому можно получить доступ в Автономный режим. Вы можете указать, хотите ли вы загрузить все страницы веб-сайта или только его части. К сожалению, нет возможности загружать файлы по типу, например фотографии, видео и т. Д.

Cyotek Webcopy использует правила сканирования, чтобы решить, какую часть веб-сайта вы хотите сканировать и загружать, а какую — удалить. Например, теги, архивы и т. Д. Инструмент можно загрузить и использовать бесплатно, он поддерживается только за счет пожертвований. Нет рекламы.

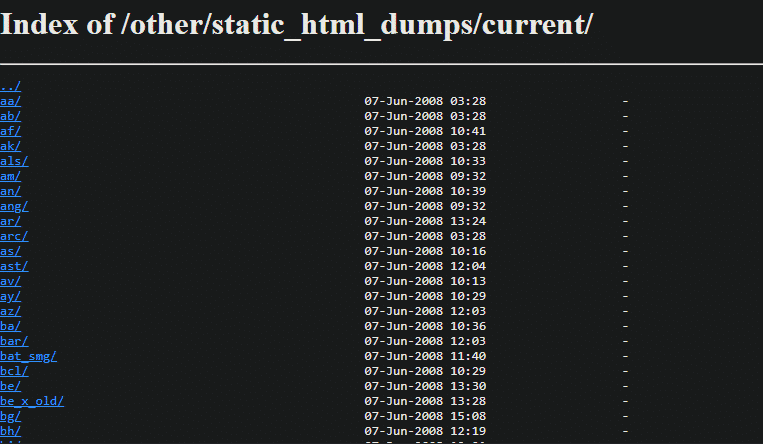

7. Свалки Википедии

Википедия Хороший источник информации И, если вы знаете свой путь и отслеживаете источник информации на странице, вы можете обойти некоторые из его ограничений. Нет необходимости использовать риппер или инструмент загрузки, чтобы получить Страницы Википедии на жестком диске. Сама Википедия предлагает дампы.

Эти дампы доступны в различных форматах, включая HTML, XML и DVD. В зависимости от ваших потребностей вы можете загрузить эти файлы или распаковать их и получить к ним доступ в автономном режиме. Обратите внимание, что Википедия запросила на лицо Укажите пользователям, что они не должны использовать поисковые роботы.

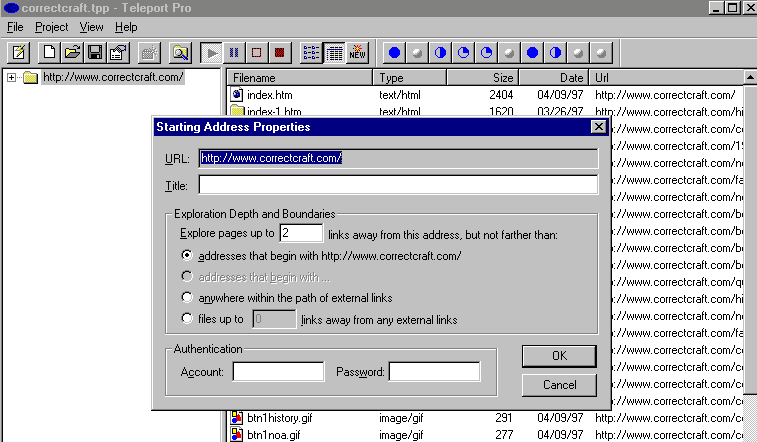

8. Телепорт Про

Большинство загрузчиков / загрузчиков / сканеров веб-сайтов хороши в том, что они делают, пока количество запросов не превысит определенное количество. Если вы хотите сканировать большой сайт и загружать сотни и тысячи страниц, вам понадобится более мощная и стабильная программа, такая как Teleport Pro.

Teleport Pro — это высокоскоростной сканер и загрузчик по цене 49.95 долларов США с поддержкой сайтов, защищенных паролем. Вы можете искать, фильтровать и загружать файлы на основе типа файла и ключевых слов, что может сэкономить время в реальном времени. Большинство поисковых роботов и загружаемых файлов не поддерживают JavaScript, используемый на многих сайтах. Teleport Pro легко справится с этим.

Положительные:

- Поддержка Javascript

- Работа с большими сайтами

- Расширенные правила сканирования

- Поддержка FTP

минусы:

9. Офлайн-страницы Pro

Это приложение для iOS для пользователей iPhone и iPad, которые скоро отправятся в районы, где подключение к Интернету будет роскошью (например, леса). Имея это в виду, вы можете загрузить и использовать Offline Pages Pro за 9.99 долларов США, а не на дорогостоящей стороне, для просмотра веб-страниц в автономном режиме.

Идея состоит в том, что вы можете просматривать свои любимые сайты даже в поездке. Приложение работает так, как рекламируется, но загрузка с крупных сайтов не ожидается. На мой взгляд, он лучше всего подходит для небольших сайтов или нескольких веб-страниц, которые вам нужны в автономном режиме.

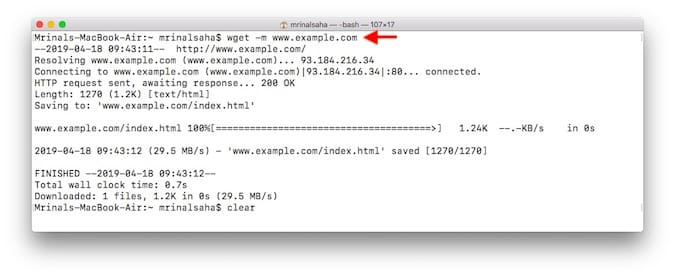

10. Взять

Wget (произносится как W get) — это утилита командной строки для загрузки веб-сайтов. Помните сцену взлома из социальной сети, где Цукерберг загружает изображения для своего веб-сайта Facemash? Да, используйте инструмент Wget. Он доступен для Mac, Windows и Linux.

В отличие от другого ПО. что делает Wget В отличие от других загрузчиков веб-сайтов в этом списке, он позволяет загружать не только веб-сайты, но и видео с YouTube или Файлы MP3 с веб-сайта или даже загрузите файлы за страницей входа. Однако, поскольку это инструмент командной строки, вам потребуется некоторый опыт работы с Терминалом, чтобы использовать его. Следует выполнить простой поиск в Google.

Например, не сойдет — wget www.example.com — Только домашняя страница сайта. Однако, если вам нужно точное зеркало веб-сайта и включить все внутренние ссылки и изображения, вы можете использовать следующую команду.

wget -m www.example.com

Положительные:

- Доступно для Windows, Mac и Linux

- Бесплатный и открытый исходный код

- Скачать почти все

минусы:

- Требуется небольшое знание командной строки

Вывод: скачать весь сайт

Это некоторые из Лучшие инструменты и приложения Чтобы скачать сайты для использования в автономном режиме. вы можете открыть эти сайты В Chrome, как и на обычных онлайн-сайтах, но без активного подключения к Интернету. Я бы порекомендовал HTTrack, если вы ищете бесплатный инструмент, и Teleport Pro, если можете выложить немного денег. Кроме того, последний больше подходит для активных пользователей, которые ежедневно ищут и работают с данными. Wget — еще один хороший вариант, если вы чувствуете себя комфортно с командной строкой.

Источник: www.dz-techs.com

Скачивание сайтов целиком лучшие программы

- 3

- 1

7 лет назад

Зачем все это ,если нет интернета ? Какой смысл ?

7 лет назад

Когда-то, очень давно, пользовался программой Teleport Pro — удобная, надежная программа. На мой взгляд, ничего другого и не надо.

7 лет назад

сергей, бывает, что конаретный сайт нужен для работы, а интернета или нет совсем или он очень медленный. Тогда можно скачать сайт целиком и работмть offline.

7 лет назад

Когда-то, очень давно, пользовался программой Teleport Pro — удобная, надежная программа. На мой взгляд, ничего другого и не надо.

7 лет назад

Зачем все это ,если нет интернета ? Какой смысл ?

7 лет назад

сергей, бывает, что конаретный сайт нужен для работы, а интернета или нет совсем или он очень медленный. Тогда можно скачать сайт целиком и работмть offline.

В огнелисе есть есть специальное расширение для создания оффлайн сайта.Бесплатное расширение scrapbook . Я пользовался и мне понравилось, а с WinHTTrack Website Copier у меня не работать получилось.

7 лет назад

Мтс интернет есть ВЕЗДЕ практически. Баловство всё это. И занимался подобной фигнёй лет 15 назад.

Источник: pomogaemkompu.temaretik.com

Как скачать сайт?

Вопрос который является заголовком этого материала поначалу вызывает у обычного современного пользователя полное недоумение. Зачем скачивать сайты, если они и так всегда под рукой? Однако, старые интернетчики и, как показывает жестокая действительность, знают, что это далеко не так.

Я не буду здесь указывать на причины, почему в одно мгновение некоторые, порой очень полезные сайты навсегда исчезают с просторов Интернет. Предлагаю всего лишь ознакомиться с сервисами и программами, которые можно использовать для сохранения сайтов и последующим их просмотром на своём компьютере.

Особенно полезно использовать такую возможность в случае скачивания огромного количества страниц или сайта целиком. Для меня таким случаем, стала потребность скачать с одного из образовательных сайтов все pdf документы. Рассмотрим программы и онлайн-сервисы для скачивания сайтов.

Программы для скачивания сайтов

Подобного рода оффлайн-программы позволят вам скачать указанный раздел или сайт целиком, что может понадобиться в разных случаях. Самое полезное в сохранении сайта на жестком диске, то, что он сохраняется вместе с внутренней системой ссылок.

Оффлайн-браузеры, создают копию всех доступных директорий сайта, что позволяет вам переходить по ссылкам так, как вы делаете на обычном сайте в интернет. В пределах скачанного сайта вы сможете пользоваться всеми разделами и меню.

Кроме того, программы способны распознавать скрипты, интерпретируя их, и тем самым давая возможность использовать их в скачанной копии сайта. При закачке сайта сохраняется полный список файлов вместе со ссылками на них, что дает вам, возможно, не только просматривать страницы, но также слушать музыку и даже смотреть видео.

HTTrack WebSite Copier

Одной из самых популярных программ подобного рода является HTTrack WebSite Copier. Её популярность объясняется простым и понятным интерфейсом, поддержкой русского языка, кроссплатформенностью и абсолютной бесплатностью!

Установка приложения выполняется на английском языке, после установки в настройках есть возможность выбора русского языка. Скачивание вебсайта производится с помощью мастера.

Teleport Pro

Одна из лучших платных программ для закачки сайтов целиком. Цена одной лицензии составляет 50 долларов. В неё нет поддержки русского языка, но интерфейс прост и его быстро можно освоить. Следует отметить что программа уже давно не обновлялась. Как впрочем, и многие другие программы подобного класса.

Позволяет выполнять на веб-странице поиск файлов определенного типа, размера, а также поиск по ключевым словам, формировать список всех страниц и файлов сайта.

Offline Explorer

Программа создана в компании Metaproducts, для работы в среде Windows. Стоимость самой простой лицензии Standard составляет порядка 60 долларов.

За эти деньги пользователь получает возможность скачивать не только html-страницы, но и потоковое аудио и видео.

Имеет современный интерфейс, в котором приятно работать, а также множество разнообразных настроек и функций, среди которых возможность одновременной обработки до 500 сайтов, загрузка запароленных сайтов, наличие собственного веб-сервера для комфортного просмотра скачанных ресурсов.

Важно! Одной из приятных особенностей программы является поддержка функции Drag–n–Drop, которая позволяет сохранять страницы путем их перетаскивания из браузера в программу.

Website Extractor

Программа для загрузки сайтов на жесткий диск.

WebCopier Pro

приложение, позволяющее скачивать из интернета сайты целиком (или частично — по желанию). Программа относится к классу т.н. «оффлайновых» браузеров.

WebTransporter

Программа, позволяющая скачивать сайты и просматривать их офлайн.

WebZIP

это программа, установив которую, вы сможете просматривать необходимые вам страницы Интернета без подключения к сети.

Visual Web Ripper

Программа, которая позволяет сохранять на вашем жестком диске структуру веб-сайтов, а также каталоги товаров и прочее.

Web Content Extractor

Программа анализирует веб-страницы и ищет на них заданную информацию.

SurfOffline

Разработчики предлагают 30-дневный испытательный срок чтобы протестировать все возможности программы.

Сохранение сайта происходит через мастер. Программа позволяет скачивать как весь сайт так и отдельные страницы.

Таблица сравнения программ по созданию оффлайн-копий сайтов.

| A1 Website Download | http://www.microsystools.com/products/website-download/ | 30-дневный испытательный срок | ограничен | + |

| BackStreet Browser | http://www.spadixbd.com/backstreet/index.htm | ограничены | + | |

| Cyotek WebCopy | http://www.cyotek.com/cyotek-webcopy | все | + | + |

| Darcy Ripper | http://darcyripper.com/ | все | + | |

| GetLeft | не существует | все | частично | |

| GNU Wget | http://www.gnu.org/software/wget/ | все | — | + |

| HTTrack | http://www.httrack.com/ | все | + | + |

| Local Website Archive | http://www.aignes.com/lwa.htm | ограничены | — | частично |

| Offline Downloader | http://www.offlinedownloader.com/ | 30-дневный испытательный срок | + | + |

| Offline Explorer | ограничены | + | + | |

| QuadSucker/Web | http://www.quadsucker.com/quadweb/ | все | + | + |

| SurfOffline | http://www.surfoffline.com/ | 30-дневный испытательный срок | + | + |

| Teleport Pro | http://www.tenmax.com/teleport/pro/home.htm | ограничены | + | + |

| Visual Web Ripper | http://visualwebripper.com/ | 15-дневный испытательный срок | — | + |

| Web Content Extractor | http://www.newprosoft.com/web-content-extractor.htm | ограничены | извлекает нужные данные | + |

| Web2Disk | http://www.web2disk.com/Default.aspx | ограничены | + | |

| WebTransporter | http://www.realsofts.com/ru | мало | + | |

| WebZIP | http://www.spidersoft.com/webzip/ | ограничены | + | + |

Продолжение таблицы сравнения программ по созданию оффлайн-копий сайтов.

| A1 Website Download | + | Windows, Mac OS X | от 39 уе | |||

| BackStreet Browser | Windows | 3.2 | 2011 | 19 уе | ||

| Cyotek WebCopy | очень много визуальных настроек и режимов | + | Windows | 1.1.1.4 | 2016 | бесплатен |

| Darcy Ripper | кроссплатформенный | бесплатен | ||||

| GetLeft | — | Windows (with Tcl/Tk), Linux, Mac OSX | 2.5 | бесплатен | ||

| GNU Wget | Linux | бесплатен | ||||

| HTTrack | кроссплатформенный | бесплатен | ||||

| Local Website Archive | — | Windows | 29,95 евро | |||

| Offline Downloader | Windows | 4.2 | 29,95 уе | |||

| Offline Explorer | все | + | Windows | от 60 уе | ||

| QuadSucker/Web | Windows | 3.5 | 2007 | бесплатен | ||

| SurfOffline | CSS, Flash, HTTPS, JS | + | Windows | 29,95 уе | ||

| Teleport Pro | HTML5, CSS3, and DHTML | + | Windows | 1.72 | 2015 | 49,95 уе |

| Visual Web Ripper | AJAX | + | Windows | 3.0.16 | 2016 | 349уе |

| Web Content Extractor | + | Windows | 8.3 | 2016 | 49 уе | |

| Web2Disk | Windows | 39,95 уе | ||||

| WebTransporter | http | + | Windows | недоступна | ||

| WebZIP | Windows | 7.1.2.1052 | 2008 | 39,95 уе |

Видеоролик о скачивании сайта с помощью WGet

Источник: inphormatika.ru