Сканируем большие сайты через Screaming Frog SEO Spider

Привет! Последнее время всё чаще начал сталкиваться со сканирование больших сайтов (от 1 млн страниц), а также встретился со множеством заблуждений от людей, которые этим никогда не занимались. Этот пост не про то, зачем вам парсить сайт, вы наверняка знаете, а про то, как не бояться этого делать и правильно всё настроить.

6538 просмотров

Главные заблуждения:

— Лягушка регулярно падает;

— Сканировать можно до 500 тысяч;

— Это крайне долго;

Более того, полезной и практической информации о сканировании больших сайтов именно этим софтом в интернете просто нет, есть инструкция от разработчиков, где демонстрируется работа с 8 млн страницами и на этом всё.

Своим опытом я делюсь у себя на канале, но поскольку в рамках сообщения в телеге сложно раскрыть отдельные нюансы, не перегружая его, решил оформить в виде поста-мануала здесь, поехали.

Задача — просканировать сайт с Х миллионами страниц и не попасть на передачу «Сдохни или умри». Конечно, можно оплатить тариф у JetOctopus, но проводя аналитику не только своих сайтов, но и конкурентов, разорение неминуемо.

Screaming Frog. Актуальный обзор Функций (Как сделать Аудит Сайта)

Конфигурация сервера

Чтобы парсинг не мешал основной работе я использую сервер, собранный из китайских запчастей. Моя конфигурация не самая удачная (много жрёт электричества, сильно греется), но с задачей краулинга справляется отлично — два 8 ядерных процессора E5-2689, 1080 (другой не было), 48 GB RAM (REG ECC), ну и Windows Server на борту, поскольку бесплатная на полгода и не перегружена всякой шелухой от майкрософта.

Нужен ли такой монстр? Разумеется нет, для объективности, установил в BIOS 2 ядра по 3.5 ггц и запустил те же самые настройки. Скорость парсинга не упала, но загрузка процессоров была 80-90%. Краулить реально без выполнения других задач.

Сканирование в 10 потоков двумя ядрами

Сканирование в 10 потоков 16 ядрами

Настройки программы

Теперь к основному, настройки программы. Первое и самое главное:

Configuration — Systeam — Storage Mode — Устанавливаем DataBase.

Теперь парсинг идёт не в оперативную память, а на диск. Диск крайне желательно должен быть SSD. Основной плюс в том, что все результаты просто дозаписываются в базу и если произойдет краш, ничего не потеряется (забегая наперёд, после переключения в этот режим падений ни разу не было).

DataBase режим

Вторым шагом зададим размер оперативной памяти (Configuration — Systeam — Memory Allocation). Разработчики рекомендуют от 4 гб для парсинга 2 млн страниц и 8 гб для 5 и более. У меня стоит 24, потому что могу. На самом деле, выставлять 16-32-48 гб памяти здесь нет необходимости, она нужна только для работы каждого из потоков.

Сканирование большого числа страниц = большой размер проекта. Отключаем лишнее. Залетаем в Configuration — Spider. Здесь оставляем парсинг только внутренних ссылок (если планируете искать битые внешние ссылки и прочее, разумеется включаем):

Критические ошибки SEO-оптимизации на сайте (Screaming Frog SEO Spider)

Оставляем только внутренние ссылки

Отключаем лишнее

Т.к. часто на сайтах изображения являются ссылками, софтина их продолжает собирать, несмотря на запрет, лезем в Configuration — Exclude и вставляем следующие исключения, они универсальный для любого парсинга:

Отлично, теперь изображения точно не будут собираться.

Напоследок, Configuration — Speed. Здесь всё крайне индивидуально и зависит от:

— Возможностей сервера с которого идёт парсинг;

— Возможностей сервера который парсим;

— От интернет канал;

Я ставлю от 7 до 10 потоков (10-30 урлов в секунду), этого хватает для комфортной работы всех сторон.

Куда без них. Опытным путем выяснил, что от уровня вложенности страниц сайта, при прочих равных, зависит скорость парсинга и размер базы данных, причем зависит серьезно, об этом ниже.

Всё это было бы бессмысленными теориями, если бы не было обкатано в бою.

Парсинг любого проекта я выполняю в два этапа:

— Первичный, понять очевидно проблемные разделы с мусорными страницами. Собирается 5-10% от будущего объема сайта и на основе данных структуры (Site Structure в сайдбаре) оцениваем что за разделы и для чего они нужны по количеству страниц в них;

— Вторичный, с отключенными проблемными разделами (через Exclude), чтобы найти более мелкие ошибки в рамках всего сайта.

Итак, на последнем проекте изначально было несколько проблемных разделов с 17-ю(!) уровнями вложенности. Размер проекта раздувался в космос, каждый следующий миллион страниц весил дополнительные 100 гб места на диске. Скорость через 1.5 млн страниц упала с 20-30 урлов в секунду до 2-3. Всего урлов в ожидании к тому моменту было 5 млн и это явно не предел.

Вторым этапом, исключив мусорные разделы, запустил парсинг повторно. В итоге, на сайте осталось 2 млн страниц и в 10 потоков (20-30 урлов в секунду, да там хороший сервер) он парсился ровно сутки. Удивился сам, но совпало с теоретическими расчётами: 2 000 000 / 20 (урлов в сек) / 3600 (часов) = 28 часов. При этом размер базы для всего проекта составил порядка 50 гб, что в 4 раза меньше прошлого парсинга для того же количества страниц.

Краулинг значительного объёма страниц реален и не так страшен, как о нём думают. Достаточно 4-х ядерной машины с 8-16 гб оперативной памяти и не сильно большого SSD. Сама лягушка такие объемы тянет и не падает.

При любом сканировании после первых 10-15%, оцените структуру сайта и посмотрите, какие разделы могут генерировать много лишних страниц. Исключите их из парсинга и перезапускайте сканирование уже до финала. Успехов!

Показать ещё

26 комментариев

Написать комментарий.

Тема полезная, но мало, душа больше требует.

Я всё это использую, но парсинг интернет-магазина среднего объёма всё равно занимает от суток. Ключ, конечно, в рендере HTML и во включенных правилах для UA, но никакие серверные ресурсы ускорить процессы мне не позволяют.

А парсить надо, и не по разу, с эмуляцией хотя бы основных поисковых ботов, иначе можно прохлопать пачку важных ошибок.

А сейчас вот с появлением рендера JS и вовсе боюсь экспериментировать. А надо.

Про исключение проблемных страниц и разделов не понял. Зачем? Если это именно те места, где боты ломают ноги и шеи — нужно как минимум понять, в чём там трабл.

Развернуть ветку

Очень помогает команда ? в Exclude, которая отсекает страницы с параметрами.

Также помогает просканировать 10%, выявить то, что можно добавить в Exclude, а потом выключить парсер и перенастроить с отсечением выявленного мусора+пагинацию тоже выключить исключением (если настройка и ? не помогли, может генерироваться иначе).

+ перечисленное в статье.

Сутки — вполне неплохое достижение.

Развернуть ветку

Тема полезная, но мало, душа больше требует.

Каждый случай индивидуален, поэтому общие рекомендации, которые подойдут для любого проекта

Я всё это использую, но парсинг интернет-магазина среднего объёма всё равно занимает от суток.

Сколько страниц на сайте? Какая цель регулярного парсинга?

Про исключение проблемных страниц и разделов не понял. Зачем?

Тут речь вот про что, начиная парсинг нового проекта еще не знаешь его структуры, велика вероятность наличия проблемных разделов. Под проблемными я понимаю страницы, которые не должны быть в индексе и в структуре, но они там есть по разным причинам. К проблемным легко можно отнести ссылки с параметрами, распространенная ситуация с календарем записей, где краулер до бесконечности может перебирать даты и так далее. Понятно, что тратить ресурсы на перебор такого типа страниц нет смысла, понятна маска урла и как это исправить, поэтому при повторном парсинге, такие разделы исключаю и уже ищу действительно неочевидный мусор.

Источник: vc.ru

Анализ сайта с помощью Screaming Frog SEO Spider

Анализ сайта является монотонной задачей, если выполнять ее вручную. Но с помощью таких инструментов, как Screaming Frog SEO Spider, можно значительно облегчить эту работу.

Что такое Screaming Frog SEO Spider?

Screaming Frog сканирует URL-адреса, ссылки, изображения и выявляет недостатки, которые не позволяют сайту продвигаться вперед. Этот инструмент может быть установлен на компьютере, и он полностью бесплатный. Но чтобы воспользоваться дополнительными функциями, придется приобрести лицензию.

Рассмотрим наиболее важные функции Screaming Frog, которые помогают провести полный анализ сайта.

1) Исправление битых ссылок

При редизайне сайта разработчики часто удаляют связанные страницы или забывают обновить URL-адрес при его изменении. Это приводит к возникновению битых ссылок. Они отображаются как «ошибка 404» и приводят к уменьшению объема трафика, поступающего на сайт.

SEO Frog Spider помогает мгновенно находить битые ссылки, что упрощает работу и позволяет уменьшить количество «ошибок 404», возникающих на сайте.

2) Поиск некачественных title и description

Уникальные метаданные важны для SEO. Ключевые слова должны быть правильно употреблены в теге title и мета-описании. Хороший заголовок должен иметь длину не более 60 символов, а ключевое слово должно использоваться в его начале. Для мета-описания рекомендуется длина 160 символов.

SEO Frog Spider работает так же, как профессионалы поисковой оптимизации. Инструмент исправляет тайтлы и описания, которые слишком длинны и неприемлемы для поисковой системы. Он отдельно отображает результаты по заголовкам: URL-адрес, вхождения, длина и содержимое. Затем вы сможете устранить выявленные ошибки и внести необходимые исправления.

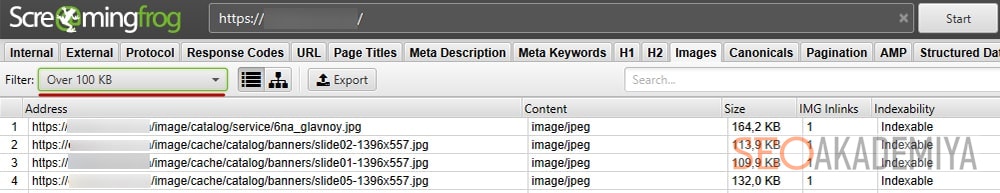

3) Изображения с высоким разрешением

Поисковые системы не индексируют изображения, которые имеют слишком большой размер, высокое разрешение или долго грузятся. Размер изображения не должен превышать 100 КБ. Не забудьте добавить ключевое слово в альтернативный текст. Он должен подробно описывать изображение, чтобы, если оно не может быть загружено, посетитель сайта мог воспользоваться этим текстом.

SEO Frog Spider находит на сайте изображения, которые не подходят, и их нужно сжимать. Также можно изучить исчерпывающий отчет об изображениях, размещенных на сайте. Если вы используете на ресурсе «неоригинальные изображения», инструмент предложит создать свои собственные картинки, чтобы повысить качество контента.

4) Создание файлов XML-Sitemap

Важно, чтобы на каждом сайте была XML карта, и поисковая система могла быстро получать доступ к веб-страницам. Sitemap помогает поисковику просканировать весь контент, размещенный на ресурсе.

Используя SEO Frog Spider, можно быстро и просто создавать файлы XML-Sitemap. Добавление изображений в карту сайта необязательно. После того, как вы создали XML-файл, можно будет вручную изменить частоту обхода некоторых страниц.

5) Определение плохой структуры URL-адресов

Правильно прописанный URL-адрес поможет улучшить индексацию сайта. Но существуют сайты, которые используют некачественные URL-адреса. В результате поисковая система не индексирует их.

На вкладке «URL-адреса» вы сможете проанализировать все URL сайта. Screaming Frog SEO Spider проверяет длину всех URL-адресов, находит слишком длинные и повторяющиеся.

6) Аудит редиректов

Screaming Frog SEO Spider является полезным инструментом для аудита редиректов при переносе сайта на новый домен или изменении структуры URL-адресов. В этих случаях рекомендуется проверять URL, чтобы определить, правильно ли они перенаправлены. С этим могут быть связаны многие проблемы поисковой оптимизации.

SEO Frog Spider решает проблему неправильных редиректов.

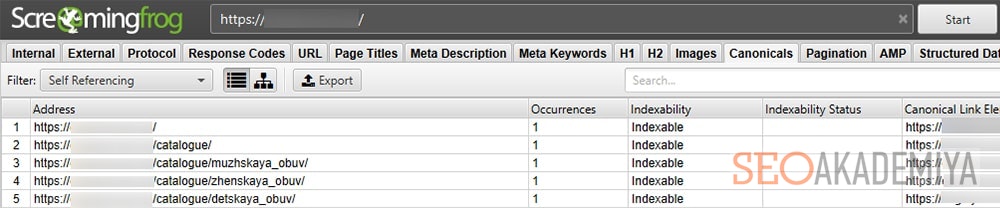

7) Обзор директив

С помощью SEO Frog Spider вы сможете получить информацию, связанную с тегом Meta robots , rel = next / prev и каноническими ссылками. А также файлом robots.txt , который используется на сайте.

Кроме этого вы сможете просмотреть URL-адреса, заблокированные вrobots.txt . Эта функция также полезна для поиска страниц, которые не должны индексироваться.

8) Интеграция с Google Analytics

Особенность SEO Frog заключается в том, что он может использовать API Google Analytics. То есть, напрямую извлекать из аналитического сервиса показатели по посещениям и сессиям, отказов и конверсии.

Сначала нужно выбрать учетную запись Google Search Console, из которой хотите извлечь данные и определить диапазон дат. После этого вы сможете увидеть страницы сайта с низким трафиком или те, на которых трафик вообще отсутствует.Если вы проводите рекламную кампанию в Google AdWords, вы также сможете получать данные по количеству показов, а также кликами затратам.

И это еще не все, вот функции, которые делают SEO Frog Spider незаменимым инструментом:

1) Экспорт данных: SEO Frog Spider предлагает функцию экспорта для преобразования всех данных в формат Excel. Если вы хотите экспортировать данные в соответствии с фильтром, инструмент может перенести только их.

Также доступна опция «Групповые отчеты». Например, если нужно экспортировать все «Входящие ссылки» и «Исходящие ссылки», вы сможете сделать это, выбрав указанный столбец.

2) Визуализация данных: Это дополнительная функция Screaming Frog SEO Spider, которая предоставляется в платной версии. С ее помощью можно получить все необходимые данные в понятной форме. Это поможет сделать отчет визуально привлекательным.

3) Сканирование крупных сайтов: когда дело доходит до больших сайтов, увеличивается объем памяти, необходимой для сохранения и обработки данных. Screaming Frog SEO Spider использует гибридный движок, который позволяет осуществлять широкомасштабное сканирование. Чтобы сохранять данные сканирования на диск, необходимо настроить SEO Spider.Это позволит ему сканировать сайт беспрецедентно быстро.

Также Screaming Frog SEO Spider предлагает два типа хранилища:

- Хранилище памяти. Если на вашем компьютере объем оперативной памяти меньше, чем объем жесткого диска, лучше оставить режим «Хранилище памяти».

- Хранилище базы данных. Рекомендуется пользователям, на компьютере которых установлен SSD-накопитель, поскольку это позволяет сканироваться URL-адресов.

Заключение

Screaming Frog SEO Spider — отличный инструмент для оптимизации сайта, повышения его производительности и выявления недостатков. Очень важно оптимизировать интернет-ресурс под поисковые системы.А вручную выявлять и исправлять возникающие проблемы неудобно.

Screaming Frog SEO Spider позволяет бесплатно сканировать до 500 URL- адресов (в версии «lite»). Но бесплатная версия не предоставляет доступ к выборочному извлечению источников, аналитике Google, визуализации данных иинтеграции с Google Search Console. Для использования расширенных функций требуется платная лицензия, которая стоит 149 фунтов стерлингов в год.

Источник: www.internet-technologies.ru

Screaming Frog SEO Spider

Screaming Frog SEO Spider — мощный инструмент для анализа сайтов, предоставляющий обширный функционал для SEO-оптимизаторов. Позволит подробно проанализировать и просканировать URL адрес, после чего отображает обилие полезной информации для технического аудита.

Возможности Screaming Frog SEO Spider

- Мощный сканер веб-сайтов, блогов и т.д;

- Отображение данных по мета тегам;

- Встроенный анализатор скриптов CSS;

- Расширяемость за счёт установки плагинов;

- Тонкая настройка парсинга для вебмастеров;

- Работа с библиотеками JavaScript Underscore;

- Удобная визуализация анализируемого контента;

- Поддерживает экспорт данных в форматы CSV, TXT, HTML, Word;

- Выгрузка содержимого нужных тегов по регулярному выражению;

- Интегрировано средство аудита входящего и исходящего трафика;

- Генерация отчётов о показателях ранжирования и индексации сайта;

- Позволяет учитывать cookies (аналогично поисковому роботу GoogleBot);

- Можно узнать тип, кодировку и уровень вложенности определённой веб-страницы;

- Помощь в выполнении перелинковки для увеличения позиций по продвигаемым запросам.

Преимущества

- Поддержка прокси;

- Поиск дублирующих тайтлов;

- Выставление лимита таймаутов;

- Невысокое потребление RAM и CPU;

- Защита аккаунта логином и паролем;

- Визуализация ссылочного текста;

- Полное соответствие стандартам языка разметки;

- Утилита более функциональна на фоне многих конкурентов;

- Выведение рекомендаций с директивами во всплывающем окне;

- Совместимость с операционными системами Виндовс, разрядностью x86, x64;

- Можно настроить столбцы с отображаемыми сведениями при помощи фильтров и опции сортировки;

- Дополнительные чекбоксы с типами валидации микроразметки (Schema.org, Google Validation, Case-Sensitive);

- Обнаруживает причину возникновения и помогает исключить критические ошибки (Error 404, «Нет ответа от сервера» и пр).

Недостатки

- Низкая скорость парсинга без покупки дополнительных прокси;

- Англоязычная локализация пользовательского интерфейса;

- Бесплатная версия может сканировать не более пяти сотен ссылок по умолчанию (дальше нужен кейген либо регистрация).

Advego Plagiatus

Словоеб

Screaming Frog SEO Spider скачать бесплатно

Последняя версия:

15.2 от 20.5 2021

Разработчик: Screaming Frog Ltd

Операционные системы:

Windows 7, 8, 10 Интерфейс: Русский Размер файла: 401 Mb

Скачать Screaming Frog SEO Spider

Screaming_Frog_SEO_Spide_Setup.exe

Полное описание

Скриминг Фрог работает по принципу так называемого «паука», выполняет проверку веб-ресурса и сбор информации о его содержимом. После этого, оптимизатор сможет анализировать полученные данные, проводить быстрый аудит сайта, проверять страницы на предмет критических ошибок и так далее.

Рассмотрим перечень основных опций, встроенных в софт.

- Ищет битые страницы и редиректы;

- Работает через командную строку;

- Возможность извлекать данные при помощи XPath;

- Поддерживает Proxy;

- Умеет парсить все поддомены и внутренние ссылки по расписанию;

- Выгрузка всех картинок, удаление ненужных папок;

- Можно отфильтровать каждый столбец и колонку в таблице;

- Показывает недостающие ключевые слова, необходимые для оптимизации;

- Отображение анкоров, а также документов, на которых присутствуют урлы к этим страницам;

- Позволяет найти конкретные странички с дублирующими заголовками и метатегами Description;

- Может находить изображения с отсутствующими и длинными атрибутами alt и title тега img;

- Выводит сведения по meta тэгам, которые управляют поисковыми ботами (краулерами);

- Возможность указывать размеры заголовков в символах и пикселях;

- Генерирует карту сайта в файл sitemap xml с множеством дополнительных настроек;

- Анализирует скорость и время загрузки web-страниц;

- Проверка массового перенаправления, сканер URL-адресов для переадресации;

- Настройка максимального размера страницы для обхода (в килобайтах);

- Наличие вкладки In Links, в ней можно посмотреть список страниц, которые ссылаются на указанный URL;

- Работа с конфигурациями Robots.txt (итоговый вариант будет считаться каноничным для парсера).

Представленные выше функции, являются лишь небольшой частью интегрированного инструментария. Примечательно, что программное обеспечение SF API Access поддерживает интеграцию с разными статистическими сервисами, включая Google Analytics или Majestic, благодаря чему вы сможете увидеть и просмотреть еще больше всевозможных данных и параметров.

Источник: softcatalog.io

Screaming Frog SEO Spider — обзор программы

В статье речь пойдёт об уже не новой и неплохо зарекомендовавшей себя программе, позволяющей проводить качественный многосторонний аудит сайта. Несмотря на популярность на западе, далеко не все seo-специалисты и тем более владельцы сайтов знают, как пользоваться Screaming Frog SEO Spider и на какие вопросы она даёт ответы. Мы решили заполнить этот пробел и опубликовать небольшую инструкцию к SEO Frog Screaming и рассказать, как с ней работать.

Содержание:

- Общая информация о программе Screaming Frog

- Начало работы в Screaming Frog SEO Spider: инструкция по заполнению данных

- Базовые функции Screaming Frog SEO Spider

- Internal

- External

- Protocol

- Response Codes

- URL

- Page Titles, Meta Description

- H1 и H2

- Images

- Canonical

- Дополнительные популярные возможности Screaming Frog

- Выводы

Общая информация о программе Screaming Frog

Сервис для аудита сайта Скриминг Фрог расскажет практически всё о ресурсе, плюс к этому, помогает в работе, например, может сгенерировать файл Sitemap. Программа была создана британским программистом, на протяжении нескольких лет занимавшимся SEO-оптимизацией сайтов. Возможно, именно благодаря большому опыту SEO-специалиста, удалось создать такой целостный и полезный продукт.

Screaming Frog устанавливается на компьютер и анализирует ресурсы, используя собственный сервер пользователя. В зависимости от ваших предпочтений можно выбрать ограниченную бесплатную версию, которая позволяет проанализировать до 500 страниц сайта, или полноценную платную версию.

Помимо ограничения количества сканируемых страниц сайта, бесплатная версия Скриминг Фрог отличается набором доступных функций. Её можно использовать в качестве теста программы, но для полноценного аудита сайта лучше все же приобрести годовую лицензию. Учитывая, что от большинства сервисов для анализа, которыми приходилось пользоваться ранее и которые не обладают таким широким функционалом, можно отказаться, в итоге вы ещё сэкономите.

Программа имеет только англоязычную версию, но здесь всё очень просто и понятно, поэтому разобраться с инструментами сервиса будет несложно.

Начало работы в Screaming Frog SEO Spider: инструкция по заполнению данных

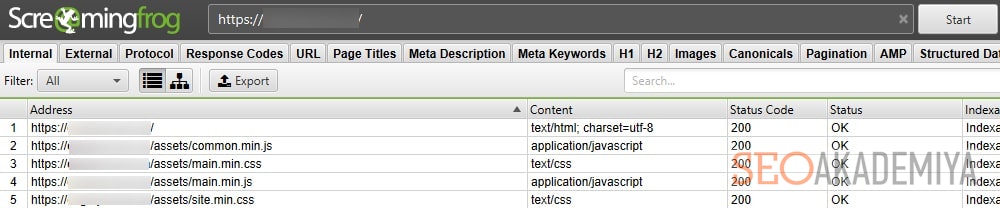

Собственно, здесь всё просто. Чтобы добавить сайт для запуска сбора данных, необходимо ввести адрес сайта в специально отведённое для этого поле и нажать на кнопку Start. Программа автоматически подгрузит всю информацию и разложить её по полочкам, то есть по вкладкам, для удобного изучения.

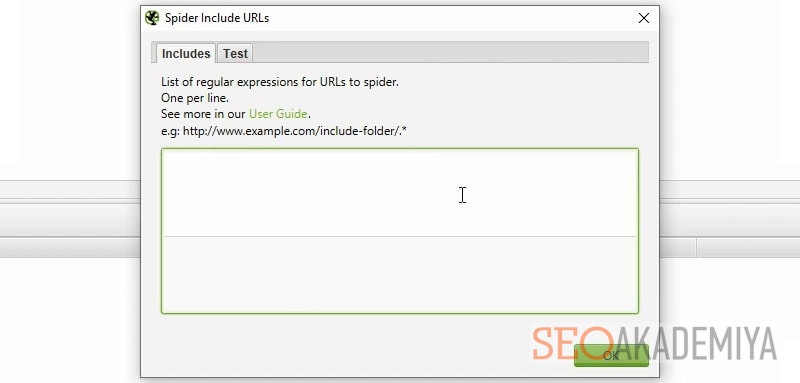

Если требуется просканировать отдельные папки/страницы сайта, то в меню программы Screaming Frog необходимо перейти на вкладку Configurations > Include и перечислить их.

И наоборот, если нужно исключить определённые разделы при формировании данных для анализа ресурса, переходим в раздел Configurations > Exclude. Здесь Вы можете указать конкретные URL, исключить папки, страницы и файлы, которые содержат определенные слова или символы.

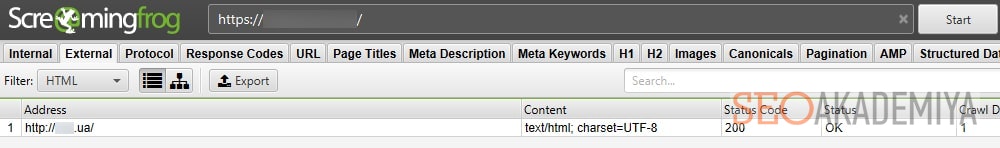

Рассмотрим еще несколько базовых настроек парсинга в программе Screaming Frog SEO Spider:

- Если вы хотите ускорить процесс парсинга сайта или просто нет необходимости анализировать определённые типы файлов, в разделе Configurations > Spider > Crawl можете исключить их.

- Аналогично, если нужно проанализировать только определенные параметры страниц, например, Title, Description и H1, то во вкладке Extraction можно включить их, а ненужное — исключить.

- Во вкладке Limit в настройке Limit Crawl Depth можно указать ограничения по глубине парсинга в зависимости от уровня вложенности страниц.

- Чтобы парсер программы Screaming Frog анализировал информацию также, как и роботы поисковых систем, во вкладке Advanced установите галочки напротив полей Respect Noindex и Respect NoFollow. К тому же это сократит время анализа ресурса.

- Во вкладке Preferences вы можете указать желаемые параметры для Title, Description и других сканируемых элементов.

- Если сайт пока закрыт от индексации, чтобы краулер программы Скриминг Фрог мог провести анализ, необходимо во вкладке Configurations > Robots.txt > Settings выбрать опцию «Ignore robots.txt».

Теперь давайте познакомимся с основным функционалом Screaming Frog и узнаем, как можно пользоваться представленной сервисом информацией.

Базовые функции Screaming Frog SEO Spider

Главные инструменты анализа сайта разложены по разделам сервиса, представленными отдельными вкладками. По ним и пройдёмся.

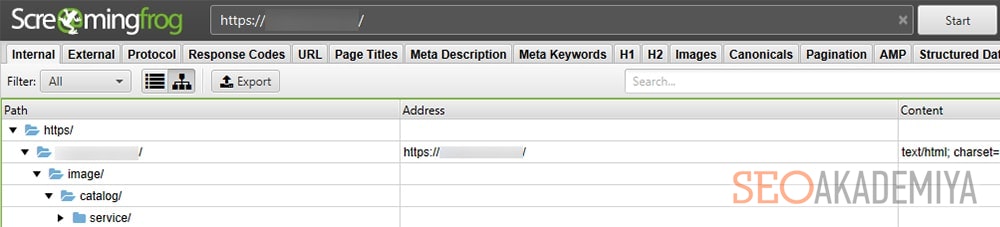

Вкладка Internal

Здесь представлена информация о внутренних ссылках ресурса. В зависимости от настроек данные по страницам можно отсортировать по алфавиту или в порядке очерёдности в соответствии с вложенностью страниц, начиная от главной страницы сайта.

Чтобы изучить подробную информацию о каждой странице, необходимо кликнуть по её адресу в результатах анализа. Здесь будут представлены данные о весе страницы, коде ответа сервера, количеству слов, графических объектах, заголовках, мета-тегах, сниппете, ссылках – внутренних и внешних, а также другая информация, которая поможет оценить, все ли данные на месте и не нужно ли их скорректировать.

Вкладка External

Знакомит с информацией о внешних ссылках. Данные этой вкладки позволяют проанализировать ссылки, которые направляют с собственного ресурса на сторонний сайт. Здесь же есть информация о кодировках, типах ссылок, месте расположения страницы, содержащих внешние ссылки и прочие данные.

Если у основного домена есть поддомены и они не учтены в настройках, то ссылки на них Screaming Frog будет воспринимать как внешние. Чтобы такого не произошло, рекомендуем в меню Configuration заранее отметить пункт Crawl All Subdomains. В этом случае система будет учитывать поддоменты как часть основного ресурса.

Вкладка Protocol

Здесь вы сможете увидеть отдельно страницы с протоколом http и https. Если сайт находится на https, а анализ программы Screaming Frog показал страницы с http, проверьте их код ответа сервера (Status Code должен быть 301) и отсутствие ссылок на них во вкладке Inlinks.

Получить бесплатную консультацию от SEO-эксперта по вашему сайту

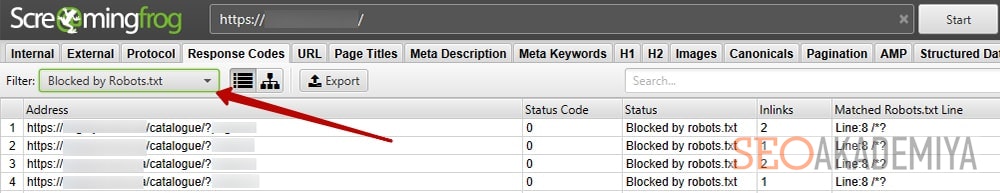

Вкладка Response Codes

Вкладка, посвящённая кодам ответа сервера. Вверху страницы можно установить фильтр, в зависимости от класса состояния ответа сервера и других параметров. Например, можно проверить:

- какие страницы заблокированы в файле robots.txt — Blocked by robots.txt;

- по каким нет никакого ответа — No response;

- какие автоматически перенаправляют на другие страницы — Redirection (3xx);

- какие отдают ошибки на стороне клиента — Client Error (4XX);

- и на стороне сервера — Server Error (5XX).

Проведя анализ предоставленной информации, можно найти ошибки в кодах и исправить их или удалить те ссылки, которые приводят на несуществующие страницы.

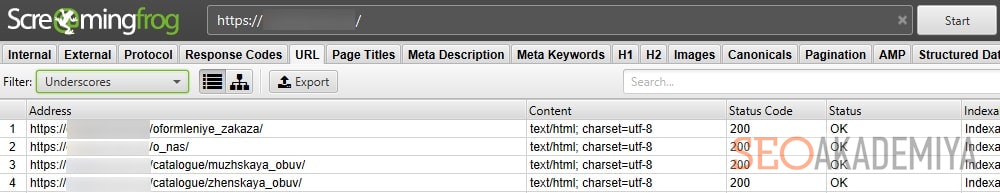

Вкладка URL

Если необходимо узнать о страницах, с которыми что-то не так, идём в эту вкладку и смотрим, какие страницы Screaming Frog подозревает в наличии ошибок. Проверка указанных страниц может здорово упростить жизнь оптимизатора. Список проблемных страниц могут пополнить те, у которых:

- некорректный URL;

- динамический адрес;

- есть дубликат и т. д.

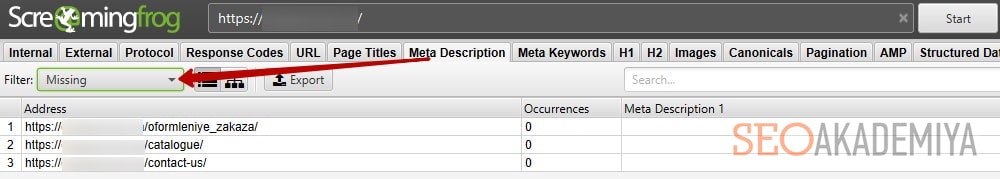

Вкладки Page Titles, Meta Description

Посвящены мета-тегам сайта, здесь собрана информация о Title и Description страниц, в написании которых допущены ошибки. Наиболее важной является информация о мета-тегах:

- совпадающих с заголовками H1;

- неуникальных (дублирующихся на разных страницах);

- слишком коротких или чрезмерно длинных;

- их отсутствии и т. д.

Всё это ошибки, которые требуют корректировки.

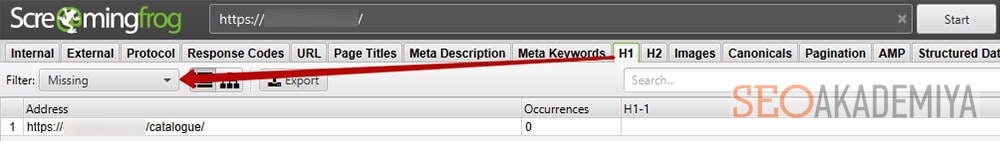

Вкладки H1 и H2

Демонстрируют все данные, связанные с заголовками на каждой странице сайта. Как и в случае с мета-тегами, здесь можно увидеть допущенные нарушения в написании этих элементов сайта и своевременно внести необходимые изменения.

Вкладка Images

В этом разделе анализа программы Screaming Frog SEO Spider представлены данные обо всех используемых на ресурсе изображениях. Очень полезная информация для оптимизации сайта, благодаря которой можно обнаружить неоправданно «тяжёлые» объекты, снизить «вес» ресурса и ускорить его загрузку.

Вкладка Canonical

Здесь прописаны канонические ссылки (тег rel=»canonical»), которые устраняют проблемы при размещении одного и того же контента на разных страницах. Их анализ позволит найти ошибки, такие как: несколько атрибутов rel=canonical на одной странице, канонической указана закрытая от индексации страница и т.д.

Дополнительные популярные возможности Screaming Frog

Наиболее часто используемая функция Screaming Frog, которая позволяет получить данные, предоставленные сервисом, в удобной и привычной форме — выгрузка в отдельный Excel-файл. Для этого необходимо нажать на кнопку Export, которая имеется на каждом экране сервиса.

Очень удобно и просто создавать файл Sitemap.xml, необходимый для повышения эффективности процесса сканирования сайта ботами поисковых систем. В Screaming Frog существует раздел Sitemap, в котором можно создать данный файл.

Выводы

Тестируя Screaming Frog SEO Spider, наши специалисты отметили, что это очень удобный, понятный и полезный инструмент для аудита и оптимизации сайта, который точно стоит внимания SEO-специалистов и владельцев любых сайтов. Большое количество важной информации, представленной в удобном для восприятия формате, и простой интерфейс делают программу отличным решением для оптимизаторов, как опытных, так и начинающих. Рекомендуем попробовать скачать тестовую версию на пробу и протестировать основные возможности сервиса.

А какие инструменты вы используете для аудита сайта?

Источник: seo-akademiya.com