Одно из заблуждений, бытующее среди пользователей Интернет, гласит, что в Интернет найдется все. Это не так по двум причинам. Во-первых, в Интернет может найтись лишь то, что туда кем-то было помещено. Во-вторых, для того чтобы найти в Интернет то, что там наверняка есть, нужно обладать определенными навыками поиска.

Но даже будь пользователь самым крупным специалистом по поиску в Интернет, все его способности будут бессильны, если владелец ресурса с нужной вам информацией не позаботился о том, чтобы она стала доступной для поиска. Так тоже бывает, и от такого головотяпства уже ничто не поможет.

Давайте посмотрим, что и как можно искать в Интернет, чем при этом пользоваться и каких ошибок следует избегать во время поиска.

Поисковые системы — это Интернет-порталы, которые предназначены для того, чтобы предоставить их посетителю возможность найти сайты, на которых встречаются заданные слова или Целые фразы. Поисковые системы хороши в тех случаях, когда пользователь точно знает, что вам нужно, когда пользователь может быть уверены, что если на какой-либо странице присутствуют те или иные слова или Фразы, то это как раз то, что он ищет.

В мобильном Майнкрафте обновили управление!

Как мы уже говорили, порталы — это целый набор серверов, которые обеспечивают работу единой системы какого-либо Интернет-сервиса. В данном случае нас интересует служба поиска сайтов по заданным словам. Это значит, что поисковая машина должна знать, где и на каком сайте встречаются те или иные слова.

Согласитесь, если бы поиск по сайтам начинался в момент, когда мы щелкаем на кнопке Найти, то мы бы не дождались ее завершения и через несколько дней. Сейчас Интернет насчитывает более одного терабайта информации. Это примерно 2×10* 8 страниц машинописного текста. Если просматривать эти страницы по 10 в секунду, то на это уйдет чуть меньше года! Как же получается, что поисковые системы предоставляют нам результат за несколько секунд?

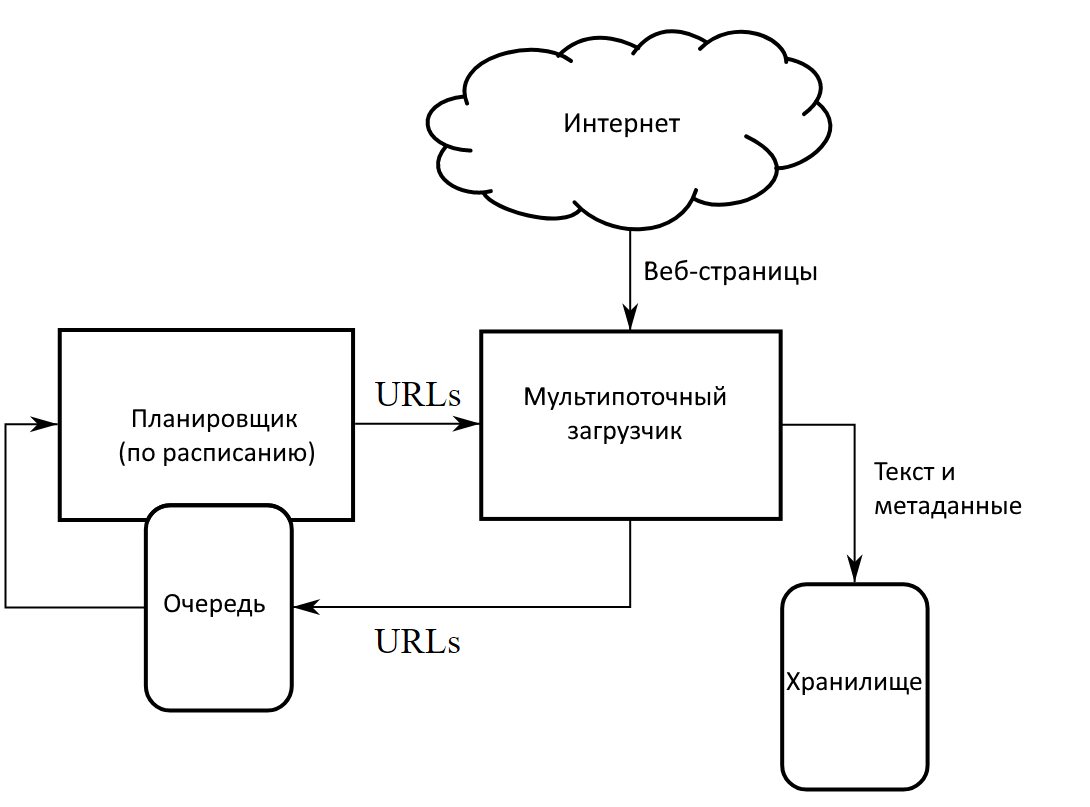

Для этого существуют специальные поисковые роботы, или, как их еще называют, пауки. Они представляют собой серверы, на которых запущена программа сканирования сайтов. После того как владелец сайта зарегистрирует свой ресурс на поисковом сервере, робот запишет этот адрес в очередь, через несколько дней зайдет на этот сайт и проиндексирует его.

Все слова, найденные на страницах сайта, будут занесены в специальную базу данных и отсортированы соответствующим образом, чтобы их поиск по этой базе отнимал как можно меньше времени. И когда пользователь в строке поискового запроса набирает нужное слово, поиск на самом деле ведется не по всей сети Интернет, а лишь по базе данных поискового сервера. Периодически «паук» повторно обходит известные ему страницы, чтобы обновить сведения о них. Таким образом, результаты поиска будут достаточно актуальны, но в пределах времени, необходимого роботу для повторной проверки ресурса.

Далее, чтобы предоставить вам информацию, поисковая машина должна ее как-то классифицировать и упорядочить. Вот здесь и начинаются «секретные» технологии. Дело в том, что поисковые серверы пытаются предугадать, насколько тот или иной сайт соответствует введенному пользователем запросу. Это соответствие называется релевантность.

КАК Я СОЗДАЛ ОПАСНЕЙШИЙ ВИРУС И ЗАРАБОТАЛ НА ЭТОМ!

У каждой поисковой системы собственные методы оценки релевантности. А держатся они в строжайшем секрете не только для обеспечения своего авторского права, но и для того, чтобы Web-мастера, создающие сайты, не смогли четко вычислять факторы, влияющие на то, чтобы сайты доказывались среди первых в списке найденных результатов. Тогда они будут искусственно фабриковать эти факторы, и страница не будет реально отвечать введенному слову или фразе.

Источник: studopedia.su

Поисковый робот: общие принципы работы и методы управления

Робот для поиска, он же поисковый краулер (от crawler, «ползать») – это бот, который используется Google, Яндекс и другими поисковыми системами для обнаружения новых страниц в сети. Основной принцип работы заключается в так называемом индексировании страниц. Краулер поисковой системы постоянно сканирует все попадающиеся страницы, находит на них ссылки и переходит по этим ссылкам. Вся собранная информация заносится им в специальную базу данных, индекс. В дальнейшем индекс используется для различия уже встречавшихся и новых страниц, а также для проверки обновления их содержимого.

Отметим, что краулер может называться множеством синонимов. В русскоязычном сегменте сети популярны термины «поисковый робот», «поисковый бот», «поисковый паук». В англоязычном интернете используются «webrobot», «webspider» и «ant».

Как видит поисковый робот

С точки зрения краулера любой сайт выглядит совсем не так, как с точки зрения пользователя. Визуальный контент игнорируется, интерес представляет техническая информация.

Следующие параметры являются при анализе приоритетными:

- текущий веб-сервер;

- IP-адрес;

- наличие постоянного http-соединения (keep-alive);

- текущая дата в GMT-формате;

- URL сайта и/или страницы;

- ответ http-заголовка страницы;

- код перенаправления;

- тип и объем контента;

- правила cookie, действующие на сайте;

- внешние и внутренние ссылки страницы.

Важные алгоритмы Google

Как работают поисковые роботы

Рассмотрим принципы работы краулеров на примере образцов Google и Яндекса. Обобщенная цепочка действий выглядит так:

- переход по URL на страницу;

- сканирование контента;

- сохранение содержимого на сервере (обычно с конвертацией данных в удобный для поисковика формат);

- переход по новому URL и повторение действий.

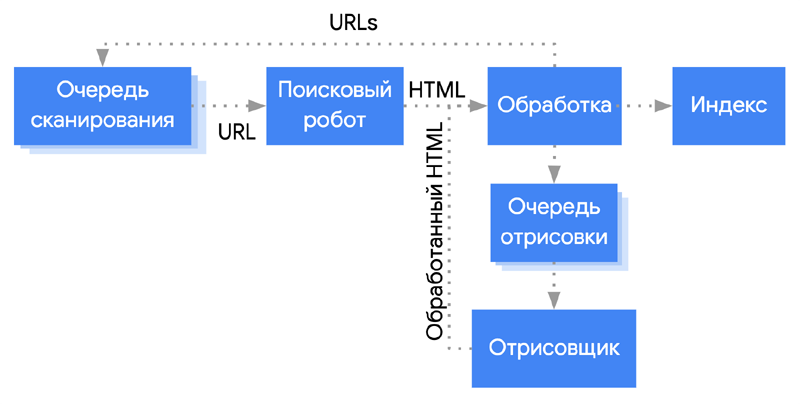

Детали регламентируются конкретной поисковой системой и паттернами правил для определенного типа ботов. Например, порядок сканирования может разливаться по максимальному количеству переходов внутри одного сайта, количеству посещений, разрешению или запрету зацикливания и т.д. Поведение типичного краулера Google, например, выглядит следующим образом:

Информация по просканированным страницам попадает от краулеров в базы данных не сразу. Яндекс обновляет индекс в срок от нескольких дней до двух недель, Google – несколько раз в сутки.

Типы поисковых роботов

Для оптимизации процесса при сканировании разного контента поисковики используют разные типы краулеров.

Например, Google разделяет ботов для обработки общего качества страницы, качества рекламы, сканирования изображений, сканирования видео, а также для новостного контента и мобильных страниц. Все эти типы ботов обладают отдельным user agent и для любого из них можно создать директивное обращение в стандарте исключения (об этом немного ниже).

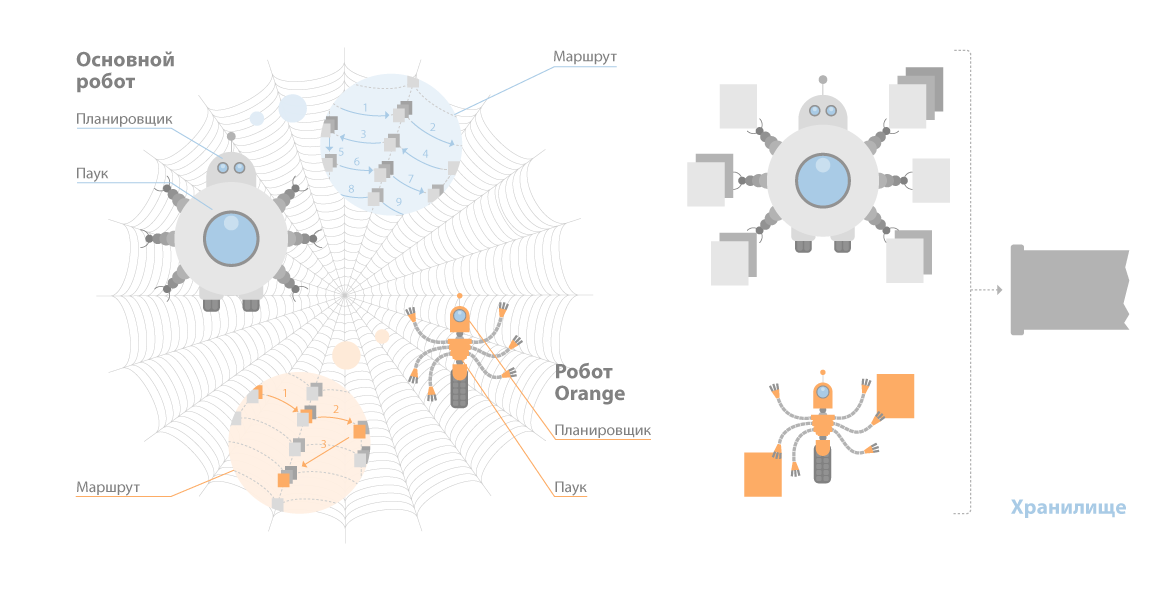

Что касается Яндекса, то основных краулеров у него всего два: стандартный и быстрый Orange. Последовательность операций стандартного бота:

- планировщик выстраивает очередность сканирования данных;

- робот получает от планировщика маршрут;

- робот обходит документы по этому маршруту;

- если от сайта есть корректный ответ, идет скачивание данных;

- идентифицируется ряд параметров документа, включая язык;

- сведения отправляются в кэш Яндекса.

Почему сайт не индексируется целиком

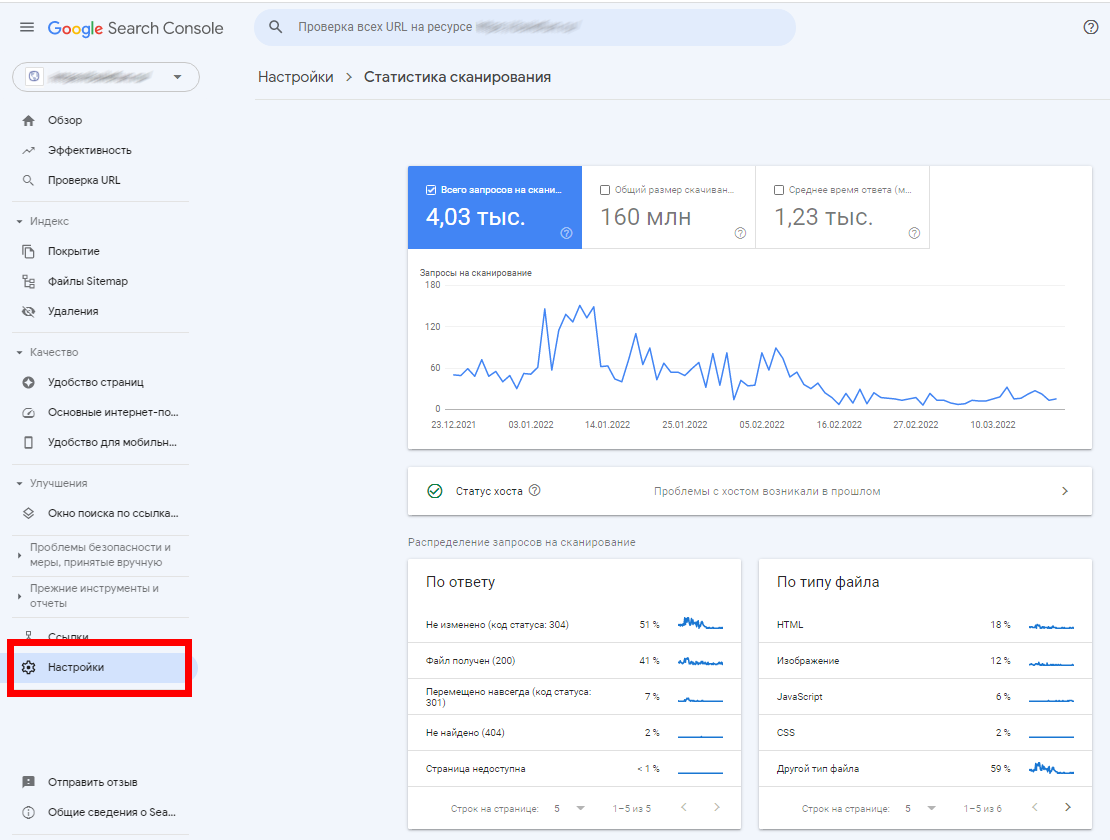

Владельцы сайтов могут заметить, что когда ресурс введен в пользование, он индексируется не только не сразу, но еще и не целиком – когда до нового сайта добираются поисковые боты, они могут индексировать сначала только несколько страниц. Это связано с тем, что каждый конкретный краулер имеет лимит по количеству обращений к конкретному сайту (так называемый краулинговый бюджет). Этот лимит может быть суточным или месячным, но суть не меняется. При помощи Google Search Console можно увидеть общее количество запросов сканирования сайта; для этого нужно перейти на вкладку «Статистика сканирования».

Кроме того, надо помнить и про дополнительные факторы: бот вполне может повторно сканировать одну и ту же страницу (что тоже снижает его лимит по количеству обращений), а также может иметь ограничение сканирования – например, по уровню глубины доступа или по размеру текстового контента. По этим причинам сайт, особенно крупный и имеющий сложную структуру, для полного индексирования требует нескольких подходов сканирования.

Краулеры в виде пользователей

Роботы поисковых систем всегда играют по правилам: они никогда не делают вид, что являются пользовательским клиентом. Однако для отдельных сервисов полностью соблюдать все ограничения для ботов может быть фатально: с учетом затрат на бюджеты обращений и интервалы между обращениями, сканирование может быть очень медленным, особенно для сервисов, которым нужно обрабатывать огромные массивы данных. В таких случаях разработчики конкретных сервисов создают личных ботов, которые представляются пользовательским клиентом, браузером. Они точно так же индексируют страницы, но отображаются в статистике ресурса как пользователи.

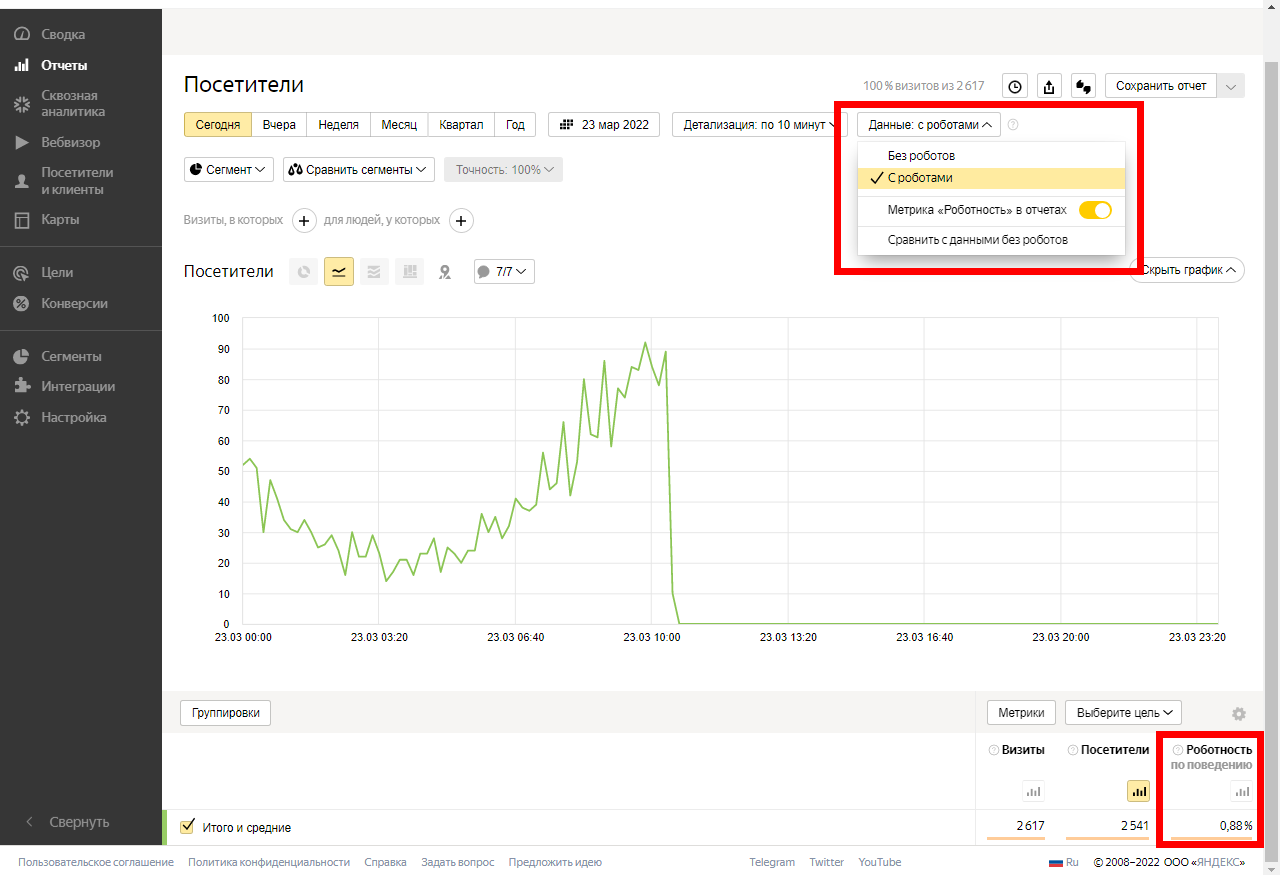

Чтобы боты, в том числе притворяющиеся пользователями, не искажали статистику посещений, придуманы алгоритмы по их отсеву. Например, Яндекс.Метрика может ограничить отображение данных по пользователям, которые соответствуют параметру «роботность по поведению» — если по поведенческим факторам это краулер, значит, его в общую статистику можно не включать. Для отсева надо открыть любой отчет, выбрать строку «данные с роботами» и использовать наиболее подходящий фильтр.

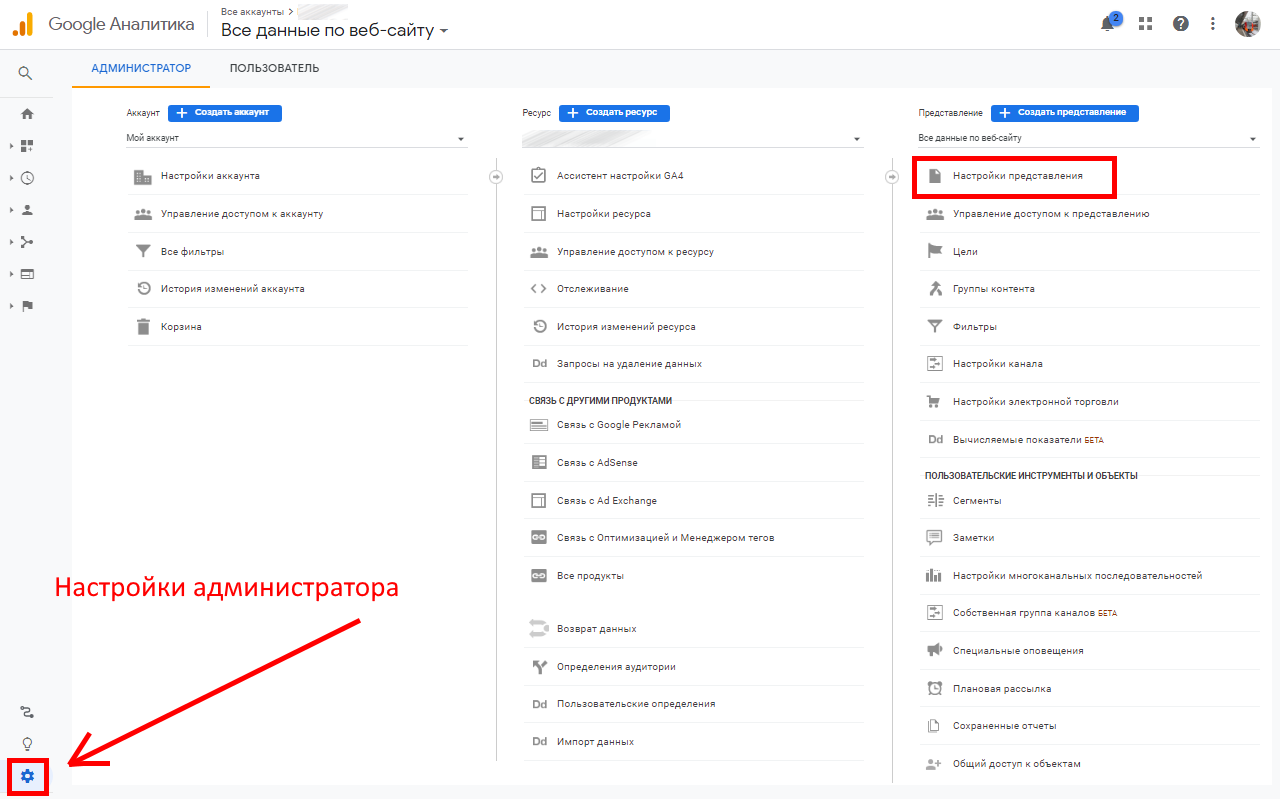

Фильтрация есть и в Google Analytics. В настройках администратора и параметрах представления можно отметить чекбокс «исключить обращение роботов и пауков», и их активность не будет отмечаться в отчетах GA.

Полезные и вредные

Проблемы краулеров для владельца сайта не только в медленной индексации или искажении статистики посещений. Возможно и возникновение других неприятностей.

Например, роботы генерируют объем трафика. Казалось бы, для передачи информации в индекс нужен ничтожный объем данных, однако надо помнить – краулеры используются не только в Яндексе и Google. Во-первых, они применяются многими другими поисковиками, которые не пользуются популярностью и малоизвестны, но тем не менее существуют.

Во-вторых, краулеры создаются для различных аналитических сервисов, SEO-инструментов, статистических сайтов –можно вспомнить хотя бы известнейший Amazon. При ограниченных ресурсах сервера множество поисковых ботов могут стать полноценной проблемой. Есть и откровенно вредные боты, которые добывают данные для дальнейшего использования – например, для слива электронных адресов в базы данных и последующих рекламных рассылок.

Для борьбы с вредной стороной поисковых ботов используют различные средства. Например, многие CMS имеют различные плагины и расширения, ограничивающие воздействие краулеров на сайт. В WordPress, к примеру, популярностью пользуется Blackhole for Bad Bots. Он добавляет триггерную скрытую ссылку в колонтитул страниц и запрещает краулерам переходить по ней (с помощью команды в robots.txt). Если краулер игнорирует правило – значит, это вредоносный робот и он попадет в ловушку.

Запрет на сканирование

Основной инструмент для ограничения сканирования вашего сайта – это директивы в robots.txt. В этот файл можно прописывать временные интервалы, которые бот должен соблюдать при обращении к странице, и конкретные разделы, которые нельзя сканировать. Это позволяет снизить нагрузку на сервер.

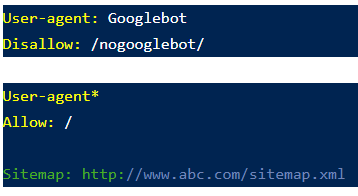

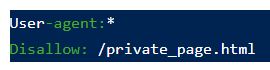

Директивы могут настраиваться по-разному. Например, директива со скриншота ниже расшифровывается так:

- карта сайта опубликована на странице http://www.abc.com/sitemap.xml;

- для краулеров Google запрещен обход ссылок, начинающихся с http://abc.com/nogooglebot/;

- краулеры других систем и сервисов могут сканировать сайт без ограничений.

По умолчанию любой сайт доступен всем ботам, если только в robots.txt не указано обратное. Однако надо помнить, что эти указания носят рекомендательный характер. То, что делает поисковый робот, контролируется исключительно его собственными директивами. При этом соблюдение рекомендаций из robots.txt считается хорошим тоном, а если они не соблюдаются – этот бот, скорее всего, создан с неблаговидными целями.

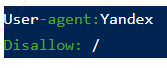

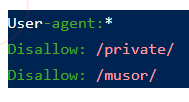

В заключение дадим несколько простых директив, пользующихся наибольшей популярностью.

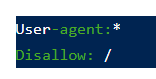

- Директива для запрета на индексацию сайта для всех ботов

- Директива для запрета индексирования конкретной страницы

- Директива для запрета на индексацию страницы конкретному боту, с указанием user agent

- Директива для ограничения индексирования каталога со всем содержимым

Еще раз подчеркнем, что директивы в robots.txt это рекомендации, а не полноценные команды. Для полной блокировки страниц или всего сайта от поисковиков проще всего поставить пароль или прописать соответствующую команду в http-заголовок.

Источник: arcticlab.ru

Что такое веб-краулер?

Веб-краулеры (поисковые роботы) – важная часть инфраструктуры Интернета. В этой статье мы рассмотрим:

- Определение веб-краулера

- Как работают поисковые роботы?

- Примеры веб-краулеров

- Почему веб-краулеры важны для SEO

- Проблемы, с которыми сталкиваются поисковые роботы

Определение веб-краулера

Веб-краулер — это программный робот, который сканирует Интернет и загружает найденные данные. Большинство краулеров работают под управлением поисковых систем, таких как Google, Bing, Baidu и DuckDuckGo. Поисковые системы применяют свои алгоритмы поиска к собранным данным, чтобы сформировать индекс своей поисковой системы. Индексы позволяют им предоставлять релевантные ссылки пользователям на основе их поисковых запросов.

Существуют поисковые роботы, которые служат не только поисковым системам, но и другим интересам, например The Way Back Machine из Интернет-архива, который предоставляет снимки сайтов в определенный момент времени в прошлом.

Как работают поисковые роботы?

Поисковые роботы, такие как Googlebot, начинают каждый день со списка сайтов, которые они хотят просканировать. Это называется краулинговым бюджетом. Он отражает потребность в индексировании страниц. На краулинговый бюджет влияют два основных фактора: популярность и устаревание.

URL-адреса, которые более популярны в Интернете, обычно сканируются чаще, чтобы они оставались свежими в индексе. Поисковые роботы также пытаются предотвратить устаревание URL-адресов в индексе.

Когда краулер подключается к сайту, он начинает с загрузки и чтения файла robots.txt. Файл robots.txt является частью протокола исключения роботов (REP), группы веб-стандартов, которые регулируют, как роботы сканируют Интернет, получают доступ и индексируют контент, а также предоставляют этот контент пользователям.

Владельцы сайтов могут определить, какие пользовательские агенты могут и не могут получать доступ к сайту. В robots.txt также можно определить директиву задержки сканирования, чтобы ограничить скорость запросов, которые сканер делает на сайте. В Robots.txt также перечисляются связанные с сайтом карты сайта, так что краулер может найти каждую страницу и время ее последнего обновления. Если страница не изменилась с момента последнего посещения краулером, он ее пропустит.

Когда поисковый робот, наконец, достигает страницы для сканирования, он отображает ее в браузере, загружая весь HTML, сторонний код, JavaScript и CSS. Эта информация хранится в базе данных поисковой системы, а затем используется для индексации и ранжирования страницы. Он также загружает все ссылки на странице. Ссылки, которых еще нет в индексе поисковой системы, добавляются в список для последующего сканирования.

Соблюдение директив в файле robots.txt является добровольным. Большинство основных поисковых систем следуют директивам robots.txt, но некоторые этого не делают. Злоумышленники, такие как спамеры и ботнеты, игнорируют директивы robots.txt. Даже некоторые законные поисковые роботы, такие как Архив Интернета, игнорируют файл robots.txt.

Примеры веб-краулеров

Поисковые системы имеют несколько типов поисковых роботов. Например, у Google есть 17 типов ботов:

- APIs-Google

- AdSense

- AdsBot Mobile Web Android

- AdsBot Mobile Web

- Googlebot Image

- Googlebot News

- Googlebot Video

- Googlebot Desktop

- Googlebot Smartphone

- Mobile Apps Android

- Mobile AdSense

- Feedfetcher

- Google Read Aloud

- Duplex on the web

- Google Favicon

- Web Light

- Google StoreBot

Почему веб-краулеры важны для SEO

Цель SEO заключается в том, чтобы ваш контент можно было легко найти, когда пользователь выполняет поиск по определенному поисковому запросу. Google не может знать, куда ранжировать ваш контент, если он не проиндексирован.

Поисковые роботы также могут помочь и в других областях. Сайты эл. коммерции часто сканируют сайты конкурентов для анализа выбора продукции и ценообразования. Этот тип сбора данных обычно известен как «веб-скрапинг вместо сканирования». Веб-скрапинг фокусируется на определенных элементах данных HTML.

Веб-скраперы очень целенаправленны, тогда как веб-краулеры расставляют широкую сеть и собирают весь контент. На стороне пользователя также есть инструменты SERP API, которые помогают сканировать и собирать данные поисковой выдачи.

Проблемы, с которыми сталкиваются поисковые роботы

Есть ряд проблем, с которыми могут столкнуться поисковые роботы.

| Проблема | Описание |

| Ограничения robots.txt | Если поисковый робот соблюдает ограничения robots.txt, он не сможет получить доступ к определенным страницам или отправить запросы, превышающие произвольное ограничение. |

| Баны IP | Поскольку некоторые поисковые роботы не соблюдают ограничения robots.txt, они могут использовать ряд других инструментов для ограничения сканирования. Сайты могут блокировать IP-адреса, которые считаются вредоносными, например, бесплатные прокси данных, используемые мошенниками, или определенные IP ЦОД. |

| Ограничения геолокации | Некоторые сайты требуют, чтобы посетитель находился в определенной локации для доступа к содержимому сайта. Хорошим примером является попытка доступа к контенту Netflix USA за пределами США. Большинство гео-ограничений можно преодолеть с помощью резидентных прокси-сетей. |

| CAPTCHA | Некоторые веб-сайты, обнаружив большое количество активности из подозрительных источников, выставляют CAPTCHA, чтобы проверить, настоящий ли человек стоит за запросом. CAPTCHA могут нарушить деятельность веб-краулеров. Многие решения для веб-скрапинга имеют инструменты и технологии для преодоления подобных блокировок. Эти инструменты часто используют решение для разблокировки CAPTCHA. |

Подведем итоги

Поисковые роботы являются важной частью инфраструктуры Интернета. Они позволяют поисковым системам собирать данные, необходимые для создания поисковых индексов и предоставления результатов поиска по запросам пользователей. Многие компании обращаются к краулерам, чтобы помочь им в своих исследованиях. Зачастую они сосредоточены только на одном или двух сайтах, таких как Amazon, Adidas или Airbnb. В таких случаях для их нужд лучше подходят такие инструменты, как веб-парсеры IDE от Bright Data.

Источник: ru-brightdata.com