Решение нелинейных уравнений на языке программирования Pascal

Практически перед каждым программистом рано или поздно встает задача определения корней уравнения. На сегодняшний день существует достаточно много алгоритмов решения данной задачи. Из этой статьи вы узнаете о наиболее известных алгоритмах численного решения уравнений. Практически все они могут быть разделены на два этапа: отделения и уточнения корней.

Первую часть легко выполнить графическим методом. Для выполнения второго этапа решения уравнения можно воспользоваться одним из многих методов уточнения корней уравнения.

Наиболее простым в реализации является метод бисекции, или как его еще называют, метод половинного деления. Это итерационный метод, суть которого заключается в том, что на каждой итерации интервал сокращается вдвое до тех пор, пока не будет найдено решение с заданной точностью.

Численные методы решения нелинейных уравнений

где f(x) — заданная алгебраическая или трансцендентная функция.

Решение нелинейного уравнения методом хорд (секущих) (программа)

Решить уравнение — значит найти все его корни, то есть те значения x , которые обращают уравнение в тождество.

Если уравнение достаточно сложно, то задача точного определения корней является в некоторых случаях нерешаемой. Поэтому ставится задача найти такое приближенное значение корня xПP , которое отличается от точного значения корня x* на величину, по модулю не превышающую указанной точности (малой положительной величины) ε , то есть

Величину ε также называют допустимой ошибкой , которую можно задать по своему усмотрению.

Этапы приближенного решения нелинейных уравнений

Приближенное решение уравнения состоит из двух этапов:

- Отделение корней, то есть нахождение интервалов из области определения функции f(x) , в каждом из которых содержится только один корень уравнения f(x)=0 .

- Уточнение корней до заданной точности.

Отделение корней

Отделение корней можно проводить графически и аналитически.

Для того чтобы графически отделить корни уравнения, необходимо построить график функции f(x) . Абсциссы точек его пересечения с осью Ox являются действительными корнями уравнения.

Для примера рассмотрим задачу решения уравнения

где угол x задан в градусах. Указанное уравнение можно переписать в виде

Для графического отсечения корней достаточно построить график функции

Из рисунка видно, что корень уравнения лежит в промежутке x∈(6;8) .

Аналитическое отделение корней

Аналитическое отделение корней основано на следующих теоремах.

Теорема 1 . Если непрерывная функция f(x) принимает на концах отрезка [a; b] значения разных знаков, т.е.

Решение нелинейного уравнения методом простых итераций (программа)

то на этом отрезке содержится по крайней мере один корень уравнения.

Теорема 2 . Если непрерывная на отрезке [a; b] функция f(x) принимает на концах отрезка значения разных знаков, а производная f'(x) сохраняет знак внутри указанного отрезка, то внутри отрезка существует единственный корень уравнения f(x) = 0 .

Уточнение корней

Для уточнения корней может использоваться один из следующих методов:

- Метод последовательных приближений (метод итераций)

- Метод Ньютона (метод касательных)

- Метод секущих (метод хорд)

- Метод половинного деления (метод дихотомии)

Метод последовательных приближений (метод итераций)

Метод итерации — численный метод решения математических задач, используемый для приближённого решения алгебраических уравнений и систем. Суть метода заключается в нахождении по приближённому значению величины следующего приближения (являющегося более точным). Метод позволяет получить решение с заданной точностью в виде предела последовательности итераций. Характер сходимости и сам факт сходимости метода зависит от выбора начального приближения решения.

Функциональное уравнение может быть записано в виде

Функцию f(x) называют сжимающим отображением .

Последовательность чисел x0, x1 ,…, xn называется итерационной , если для любого номера n>0 элемент xn выражается через элемент xn-1 по рекуррентной формуле

а в качестве x0 взято любое число из области задания функции f(x) .

Реализация на C++ для рассмотренного выше примера

Уравнение может быть записано в форме

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

Результат выполнения

Метод Ньютона (метод касательных)

Если известно начальное приближение x0 корня уравнения f(x)=0, то последовательные приближения находят по формуле

Графическая интерпретация метода касательных имеет вид

Реализация на C++

Для заданного уравнения

производная будет иметь вид

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

#define _USE_MATH_DEFINES

#include

#include

using namespace std;

double find( double x, double eps)

double f, df; int iter = 0;

cout do f = sin(M_PI*x / 180) — 1 / x;

df = M_PI / 180 * cos(M_PI*x / 180) + 1 / (x*x);

x = x — f / df;

iter++;

> while (fabs(f) > eps iter <20000);

cout return x;

>

int main()

cout cin.get(); return 0;

>

Результат выполнения

Метод секущих (метод хорд)

Если x0 , x1 — приближенные значения корня уравнения f(x) = 0 и выполняется условие

то последующие приближения находят по формуле

Методом хорд называют также метод, при котором один из концов отрезка закреплен, т.е. вычисление приближения корня уравнения f(x) = 0 производят по формулам:

Геометрическая интерпретация метода хорд:

Реализация на C++

В отличие от двух рассмотренных выше методов, метод хорд предполагает наличие двух начальных приближений, представляющих собой концы отрезка, внутри которого располагается искомый корень.

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

#define _USE_MATH_DEFINES

#include

#include

using namespace std;

double find( double x0, double x1, double eps)

double rez = x1, f0, f;

int iter = 0;

cout do f = sin(M_PI*rez / 180) — 1 / rez;

f0 = sin(M_PI*x0 / 180) — 1 / x0;

rez = rez — f / (f — f0)*(rez — x0);

iter++;

> while (fabs(f) > eps iter <20000);

cout return rez;

>

int main()

cout cin.get(); return 0;

>

Результат выполнения

Метод половинного деления (метод дихотомии)

Если x0 , x1 — приближенные значения корня уравнения f(x) = 0 и выполняется условие

то последующие приближения находятся по формуле

и вычисляется f(xi) . Если f(xi)=0 , то корень найден. В противном случае из отрезков выбирается тот, на концах которого f(x) принимает значения разных знаков, и проделывается аналогичная операция. Процесс продолжается до получения требуемой точности.

Геометрическая интерпретация метода дихотомии

Реализация на C++

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

#define _USE_MATH_DEFINES

#include

#include

using namespace std;

double func( double x)

return (sin(M_PI*x / 180) — 1 / x);

>

double find( double x0, double x1, double eps)

double left = x0, right = x1, x, fl, fr, f;

int iter = 0;

cout do x = (left + right) / 2;

f = func(x);

if (f > 0) right = x;

else left = x;

iter++;

> while (fabs(f) > eps iter <20000);

cout return x;

>

int main()

cout cin.get(); return 0;

>

Результат выполнения

Для численного поиска решения также можно использовать генетические алгоритмы.

Комментариев к записи: 8

Источник: prog-cpp.ru

Численные методы решения систем нелинейных уравнений

Многие прикладные задачи приводят к необходимости нахождения общего решения системы нелинейных уравнений. Общего аналитического решения системы нелинейных уравнений не найдено. Существуют лишь численные методы.

Следует отметить интересный факт о том, что любая система уравнений над действительными числами может быть представлена одним равносильным уравнением, если взять все уравнения в форме , возвести их в квадрат и сложить.

Для численного решения применяются итерационные методы последовательных приближений (простой итерации) и метод Ньютона в различных модификациях. Итерационные процессы естественным образом обобщаются на случай системы нелинейных уравнений вида:

(1)

Обозначим через  вектор неизвестных и определим вектор-функцию

вектор неизвестных и определим вектор-функцию  Тогда система (1) записывается в виде уравнения:

Тогда система (1) записывается в виде уравнения:

(2)

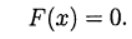

Теперь вернёмся к всеми любимому Python и отметим его первенство среди языков программирования, которые хотят изучать [1].

Этот факт является дополнительным стимулом рассмотрения числительных методов именно на Python. Однако, среди любителей Python бытует мнение, что специальные библиотечные функции, такие как scipy.optimize.root, spsolve_trianular, newton_krylov, являются самым лучшим выбором для решения задач численными методами.

С этим трудно не согласится хотя бы потому, что в том числе и разнообразие модулей подняло Python на вершину популярности. Однако, существуют случаи, когда даже при поверхностном рассмотрении использование прямых известных методов без применения специальных функций библиотеки SciPy тоже дают неплохие результаты. Иными словами, новое- это хорошо забытое старое.

Так, в публикации [2], на основании проведенных вычислительных экспериментов, доказано, что библиотечная функция newton_krylov, предназначенная для решения больших систем нелинейных уравнений, имеет в два раза меньшее быстродействие, чем алгоритм TSLS+WD

(two-step least squares), реализованный средствами библиотеки NumPy.

Целью настоящей публикации является сравнение по числу итераций, быстродействию, а главное, по результату решения модельной задачи в виде системы из ста нелинейных алгебраических уравнений при помощи библиотечной функции scipy.optimize.root и методом Ньютона, реализованного средствами библиотеки NumPy.

Возможности решателя scipy.optimize.root для численного решения систем алгебраических нелинейных уравнений

Библиотечная функция scipy.optimize.root выбрана в качестве базы сравнения, потому что имеет обширную библиотеку методов, пригодных для сравнительного анализа.

scipy.optimize.root(fun, x0, args=(), method=’hybr’, jac=None, tol=None,callback=None, ptions=None)

fun — Векторная функция для поиска корня.

x0 –Начальные условия поиска корней

method:

hybr -используется модификация Пауэлл гибридный метод;

lm – решает системы нелинейных уравнений методом наименьших квадратов.

Как следует из документации [3] методы broyden1, broyden2, anderson, linearmixing, diagbroyden, excitingmixing, krylov являются точными методами Ньютона. Остальные параметры являются «не обязательными» и с ними можно ознакомится в документации.

Методы решения систем нелинейных уравнений

Приведенный далее материал действительно можно прочитать в литературе, например в [4], но я уважаю своего читателя и для его удобства приведу вывод метода по возможности в сокращенном виде. Те, кто не любит формулы, этот раздел пропускают.

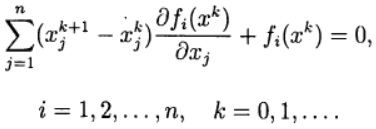

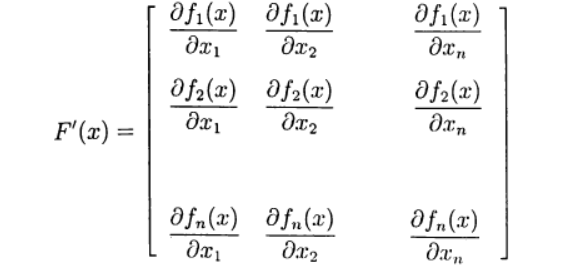

В методе Ньютона новое приближение для решения системы уравнений (2) определяется из решения системы линейных уравнений:

(3)

Определим матрицу Якоби:

(4)

Запишем(3) в виде:

(5)

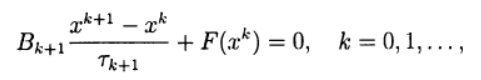

Многие одношаговые методы для приближенного решения (2) по аналогии с двухслойными итерационными методами для решения систем линейных алгебраических уравнений можно записать в виде:

(6)

где  — итерационные параметры, a

— итерационные параметры, a  — квадратная матрица n х n, имеющая обратную.

— квадратная матрица n х n, имеющая обратную.

При использовании записи (6) метод Ньютона (5) соответствует выбору:

Система линейных уравнений (5) для нахождения нового приближения может решаться итерационно. В этом случае мы имеем двухступенчатый итерационный процесс с внешними и внутренними итерациями. Например, внешний итерационный процесс может осуществляться по методу Ньютона, а внутренние итерации — на основе итерационного метода Зейделя

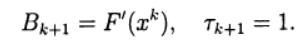

При решении систем нелинейных уравнений можно использовать прямые аналоги стандартных итерационных методов, которые применяются для решения систем линейных уравнений. Нелинейный метод Зейделя применительно к решению (2) дает:

(7)

В этом случае каждую компоненту нового приближения из решения нелинейного уравнения, можно получить на основе метода простой итерации и метода Ньютона в различных модификациях. Тем самым снова приходим к двухступенчатому итерационному методу, в котором внешние итерации проводятся в соответствии с методом Зейделя, а внутренние — с методом Ньютона.

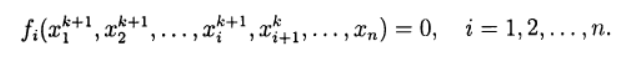

Основные вычислительные сложности применения метода Ньютона для приближенного решения систем нелинейных уравнений связаны с необходимостью решения линейной системы уравнений с матрицей Якоби на каждой итерации, причем от итерации к итерации эта матрица меняется. В модифицированном методе Ньютона матрица Якоби обращается только один раз:

(8)

Выбор модельной функции

Такой выбор не является простой задачей, поскольку при увеличении числа уравнений в системе в соответствии с ростом числа переменных результат решения не должен меняться, поскольку в противном случае невозможно отследить правильность решения системы уравнений при сравнении двух методов. Привожу следующее решение для модельной функции:

n=100 def f(x): f = zeros([n]) for i in arange(0,n-1,1): f[i] = (3 + 2*x[i])*x[i] — x[i-1] — 2*x[i+1] — 2 f [0] = (3 + 2*x[0] )*x[0] — 2*x[1] — 3 f[n-1] = (3 + 2*x[n-1] )*x[n-1] — x[n-2] — 4 return f

Функция f создаёт систему из n нелинейных уравнений, решение которой не зависит от числа уравнений и для каждой из n переменных равно единице.

Программа для тестирования на модельной функции c результатами решения системы алгебраических нелинейных уравнений с помощью библиотечной функции optimize.root для разных методов отыскания корней

from numpy import* from scipy import optimize import time ti = time.clock() n=100 def f(x): f = zeros([n]) for i in arange(0,n-1,1): f[i] = (3 + 2*x[i])*x[i] — x[i-1] — 2*x[i+1] — 2 f [0] = (3 + 2*x[0] )*x[0] — 2*x[1] — 3 f[n-1] = (3 + 2*x[n-1] )*x[n-1] — x[n-2] — 4 return f x0 =zeros([n]) sol = optimize.root(f,x0, method=’krylov’) print(‘Solution:n’, sol.x) print(‘Krylov method iteration = ‘,sol.nit) print(‘Optimize root time’, round(time.clock()-ti,3), ‘seconds’)

Только один из методов, приведенных в документации [3] прошёл тестирование по результату решения модельной функции, это метод ‘krylov’.

Решение для n=100:

Solution:

[1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1.]

Krylov method iteration = 4219

Optimize root time 7.239 seconds:

Решение для n=200

Solution:

[1.00000018 0.99999972 0.99999985 1.00000001 0.99999992 1.00000049

0.99999998 0.99999992 0.99999991 1.00000001 1.00000013 1.00000002

0.9999997 0.99999987 1.00000005 0.99999978 1.0000002 1.00000012

1.00000023 1.00000017 0.99999979 1.00000012 1.00000026 0.99999987

1.00000014 0.99999979 0.99999988 1.00000046 1.00000064 1.00000007

1.00000049 1.00000005 1.00000032 1.00000031 1.00000028 0.99999992

1.0000003 1.0000001 0.99999971 1.00000023 1.00000039 1.0000003

1.00000013 0.9999999 0.99999993 0.99999996 1.00000008 1.00000016

1.00000034 1.00000004 0.99999993 0.99999987 0.99999969 0.99999985

0.99999981 1.00000051 1.0000004 1.00000035 0.9999998 1.00000065

1.00000061 1.0000006 1.0000006 1.0000006 1.0000006 1.0000006

1.0000006 1.0000006 1.0000006 1.0000006 1.0000006 1.0000006

1.0000006 1.0000006 1.0000006 1.0000006 1.0000006 1.0000006

1.0000006 1.0000006 1.0000006 1.0000006 1.0000006 1.0000006

1.0000006 1.0000006 1.0000006 1.0000006 1.0000006 1.0000006

1.0000006 1.0000006 1.0000006 1.0000006 1.0000006 1.0000006

1.0000006 1.0000006 1.0000006 1.0000006 1.0000006 1.0000006

1.0000006 1.0000006 1.0000006 1.0000006 1.0000006 1.0000006

1.0000006 1.0000006 1.0000006 1.0000006 1.0000006 1.0000006

1.0000006 1.0000006 1.0000006 1.0000006 1.0000006 1.0000006

1.0000006 1.0000006 1.0000006 1.0000006 1.00000059 1.00000056

1.00000047 1.00000016 1.00000018 0.99999988 1.00000061 1.00000002

1.00000033 1.00000034 1.0000004 1.00000046 1.00000009 1.00000024

1.00000017 1.00000014 1.00000054 1.00000006 0.99999964 0.99999968

1.00000005 1.00000049 1.0000005 1.00000028 1.00000029 1.00000027

1.00000027 0.9999998 1.00000005 0.99999974 0.99999978 0.99999988

1.00000015 1.00000007 1.00000005 0.99999973 1.00000006 0.99999995

1.00000021 1.00000031 1.00000058 1.00000023 1.00000023 1.00000044

0.99999985 0.99999948 0.99999977 0.99999991 0.99999974 0.99999978

0.99999983 1.0000002 1.00000016 1.00000008 1.00000013 1.00000007

0.99999989 0.99999959 1.00000029 1.0000003 0.99999972 1.00000003

0.99999967 0.99999977 1.00000017 1.00000005 1.00000029 1.00000034

0.99999997 0.99999989 0.99999945 0.99999985 0.99999994 0.99999972

1.00000029 1.00000016]

Krylov method iteration = 9178

Optimize root time 23.397 seconds

Вывод: С увеличением числа уравнений вдвое заметно появление ошибок в решении. При дальнейшем увеличении n решение становится не приемлемым, что возможно из-за автоматической адаптации к шагу, эта же причина резкого падения быстродействия. Но это только моё предположение.

Программа для тестирования на модельной функции c результатами решения системы алгебраических нелинейных уравнений с помощью программы написанной на Python 3 с учётом соотношений (1)-(8) для отыскания корней по модифицированному методу Ньютона

Программа отыскания корней по модифицированному методу Ньютона

from numpy import* import time ti = time.clock() def jacobian(f, x): h = 1.0e-4 n = len(x) Jac = zeros([n,n]) f0 = f(x) for i in arange(0,n,1): tt = x[i] x[i] = tt + h f1= f(x) x[i] = tt Jac [:,i] = (f1 — f0)/h return Jac, f0 def newton(f, x, tol=1.0e-9): iterMax = 50 for i in range(iterMax): Jac, fO = jacobian(f, x) if sqrt(dot(fO, fO) / len(x)) < tol: return x, i dx = linalg.solve(Jac, fO) x = x — dx print («Too many iterations for the Newton method») n=100 def f(x): f = zeros([n]) for i in arange(0,n-1,1): f[i] = (3 + 2*x[i])*x[i] — x[i-1] — 2*x[i+1] — 2 f [0] = (3 + 2*x[0] )*x[0] — 2*x[1] — 3 f[n-1] = (3 + 2*x[n-1] )*x[n-1] — x[n-2] — 4 return f x0 =zeros([n]) x, iter = newton(f, x0) print (‘Solution:n’, x) print (‘Newton iteration = ‘, iter) print(‘Newton method time’, round(time.clock()-ti,3), ‘seconds’)

Решение для n=100:

Solution:

[1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1.]

Newton iteration = 13

Newton method time 0.496 seconds

Решение для n=200:

Solution:

[1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1.]

Newton iteration = 14

Newton method time 1.869 seconds

Чтобы убедиться в том, что программа действительно решает систему, перепишем модельную функцию для ухода от корня со значением 1 в виде:

n=10 def f(x): f = zeros([n]) for i in arange(0,n-1,1): f[i] = (3 + 2*x[i])*x[i]*sin([i]) — x[i-1] — 2*x[i+1] — 2+e**-x[i] f [0] = (3 + 2*x[0] )*x[0] — 2*x[1] — 3 f[n-1] = (3 + 2*x[n-1] )*x[n-1] — x[n-2] — 4 return f

Получим:

Solution:

[ 0.96472166 0.87777036 0.48175823 -0.26190496 -0.63693762 0.49232062

-1.31649896 0.6865098 0.89609091 0.98509235]

Newton iteration = 16

Newton method time 0.046 seconds

Вывод: Программа работает и при изменении модельной функции.

Теперь вернёмся к начальной модельной функции и проверим более широкий диапазон для n, например в 2 и 500.

n=2

Solution:

[1. 1.]

Newton iteration = 6

Newton method time 0.048 seconds

n=500

Solution:

[1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.]

Newton iteration = 15

Newton method time 11.754 seconds

Выводы:

Программа, написанная на Python по модифицированному методу Ньютона, при решении систем нелинейных уравнений из приведенной модельной функции обладает большей устойчивостью решения, чем при решении с помощью библиотечной функции optimize.root(f,x0, method=’krylov’) для метода Крылова. Относительно быстродействия окончательного вывода сделать нельзя из-за разного подхода к управлению шагом.

- Рейтинг языков программирования 2018.

- Бондарь И.В, Фалейчик Б.В. Безматричные итерационные процессы со среднеквадратичным подавлением ошибки для больших систем нелинейных уравнений.

- scipy.optimize.root.

- Вабищевич П.Н. Численные методы: Вычислительный практикум. — М.: Книжный дом «ЛИБРОКОМ», 2010. — 320 с.

- Численные методы

- scipy.optimize.root

- Метод Ньютона – Крылова

- нелинейные уравнения

- python

Источник: habr.com