Сбор и структуризация данных – достаточно сложный процесс, требующий временных затрат. Однако можно отказаться от выполнения работы вручную, сделав выбор в пользу парсинга. Инструмент позволяет автоматизировать процесс сбора данных и является законным. Об особенностях парсинга, скриптах и онлайн-инструментах, ограничениях и результатах мы расскажем прямо сейчас.

Что такое парсинг?

Парсинг – синтаксический анализ, понятие пришло из сферы лингвистики и информатики. Во время парсинга выполняется анализ, извлечение, контролируемый сбор и структуризация информации с сайтов, каталогов, агрегаторов и других ресурсов. Парсер способен проанализировать тысячи сайтов в сжатые сроки, что не под силу ни одному человеку, ни большой команде специалистов.

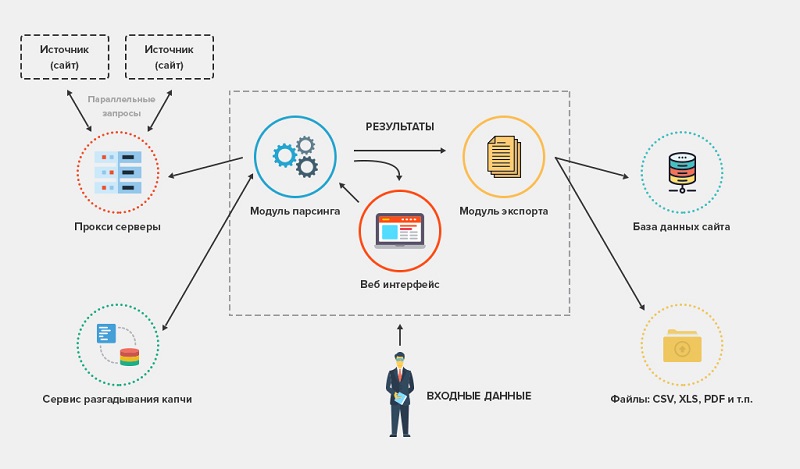

Программа анализирует исходный код страницы, выявляет совпадения, заданные пользователем, а потом собирает их. После сбора данные сохраняются в удобном формате – это может быть текстовый документ, XML, другой. Рассмотрим процесс поэтапно:

Умение парсить на Python — изменит твою жизнь

- пользователь выбирает подходящий софт, задает настройки;

- программа получает доступ к исходному коду веб-страницы;

- происходит анализ и извлечение необходимых данных;

- осуществляются преобразование и сохранение результатов.

Срок выполнения минимальный, объемы данных – огромные, ведь в течение 1 минуты могут быть просканированы тысячи сайтов. Для работы с парсингом не нужны навыки программирования, однако опыт необходимо иметь, чтобы получить четкую финишную картину. Схожие инструменты используют поисковые системы «Яндекс» и Google, которые на базе собранных данных осуществляют индексацию, ранжирование, пессимизацию и прочие действия.

Как можно использовать парсинг для развития интернет-магазина?

Сбор данных необходим повсеместно, особенно если речь идет о сайтах конкурентов, поставщиков и других ресурсах, на которых размещена информация, важная для бизнеса. С помощью парсинга выполняется:

- анализ ассортимента, как своего, так и конкурентов;

- анализ отзывов, а также характеристик товаров, размещенных на сторонних сайтах;

- анализ цен, которые собрать вручную даже с десяти сайтов очень сложно;

- общий контроль обновлений, что актуально для интернет-магазина, работающего в динамической нише. Речь идет о предпринимателях, которые реализуют товары, характеризующиеся частыми ценовыми колебаниями. Применение инструментов парсинга поможет отслеживать текущую ситуацию и оперативно вносить изменения, предупреждая убытки или отток клиентов;

- оптимизация цен, товаров и выполнение других действий на своем сайте. Парсинг просто незаменим для крупных интернет-магазинов, которые являются мультибрендовыми и имеют большой каталог;

- сбор данных и подготовка базы людей, которые могут быть полезными для бизнеса. Речь идет о тех, кто принимает решения, может выступить в качестве инвестора или партнера;

- рекрутинг. С помощью парсинга можно искать сотрудников по конкретным параметрам с помощью анализа HR-сайтов;

- сбор данных конкурентов, находящихся в открытом доступе.

Парсинг в Python за 10 минут!

Парсинг имеет достаточно широкие возможности, является важным инструментом автоматизации процессов. Он помогает отказаться от штата аналитиков, программистов и менеджеров, которые будут собирать данные вручную. Инструмент исключает ошибки и искажение текущей ситуации, ведь он ищет семантические связи, что не может выполнить обычный человек.

Парсинг – это законно?

Стоит помнить о том, что парсинг – абсолютно законный и безопасный инструмент, не оставляющий следов. Во время правильного парсинга не нарушаются авторские права, не происходит взлом, DDOS-атака или сбор конфиденциальной информации (коммерческая тайна), противоречащие актуальному законодательству. Однако некоторые сайты защищены от парсинга, поэтому доступ к информации получить удается не всегда. Во время использования рассматриваемого софта нельзя нарушать следующие ограничения:

- запрещено извлечение данных, попадающих под понятие «коммерческая тайна»;

- запрещено извлечение данных, охраняемых авторским правом;

- работа парсера не должна мешать функционированию сайта;

- запрещено нарушать правила использования ресурса.

Для предупреждения вышеперечисленных проблем нужно применять проверенные парсеры, а также ответственно подходить к процессу настройки. Собирать можно лишь те данные, которые находятся в открытом доступе и не защищены законодательством. Нарушение запретов может стать причиной претензий со стороны владельцев сайтов.

Плюсы и минусы парсинга

Парсинг – универсальный инструмент, его можно использовать для сбора информации с разнообразных ресурсов. К плюсам стоит отнести:

- быстрый сбор информации, во время которого исключены ошибки и неточности;

- сокращение времени на сбор данных с 2-3 недель до нескольких часов;

- низкую нагрузку на анализируемый сайт, поэтому не происходит DDOS-атака;

- данные, подающиеся в понятном и логичном виде, поэтому они сразу могут использоваться для работы;

- большой выбор продуктов, которые помогают выполнять парсинг без ограничений;

- возможность создания собственного скрипта;

- проведение парсинга по алгоритму с установкой временных интервалов;

- программы и другой софт, отличающиеся гибкими настройками;

- существенную экономию, ведь парсеры имеют невысокую цену, а многие распространяются бесплатно. Применение такого софта стоит намного дешевле, чем наем стороннего персонала.

К минусам можно отнести то, что некоторые сайты могут быть защищены от парсинга. Для защиты используется разграничение прав доступа, капча, установка времени обновления страниц в файле sitemap.xml или временная задержка между запросами. Хороший софт способен обходить эти ограничения, что необходимо учитывать при выборе программы или разработке скрипта.

Для настройки софта потребуются опыт и знания, поэтому привлечь специалиста придется, но это будет один человек, а не целый штат. Еще один минус заключается в том, что во время выполнения работы нельзя нарушать ограничения, в противном случае могут возникнуть проблемы с законом.

Как можно выполнять парсинг сайтов?

Для парсинга используется профессиональный софт, который может быть платным или распространяться на бесплатной основе. Еще одно решение – написание собственного скрипта с помощью любого языка программирования (чаще всего используется Python), для чего можно привлечь программиста. Написать скрипт сможет не только высококлассный специалист, но и студент или фрилансер – это недорого и эффективно. Программы и скрипты являются среднебюджетным решением, поэтому они доступны и для малого, и для крупного бизнеса.

Написание собственного парсера – выбор крупных интернет-магазинов, которым необходим точный и регулярный сбор информации. Готовые программы проверены опытом и временем, в них нет ошибок, что облегчает процесс парсинга. Не нужно будет тратить время на тестирование и отладку софта. Еще одно решение – заказ парсинга в профильном агентстве, однако такая услуга стоит достаточно дорого, а для ее реализации используется не уникальный софт, а тот, который есть в открытом доступе.

При выборе способа парсинга стоит ориентироваться на свой бюджет, цели, а также прогнозируемую частоту сбора информации. На первых порах можно поэкспериментировать с готовыми бесплатными или платными инструментами, чтобы понять принцип функционирования и определить приоритетный для бизнеса канал сбора, систематизации информации.

Какие программы и скрипты стоит использовать для парсинга?

Нижеприведенные инструменты помогут вам выполнить парсинг любого масштаба. Многие являются англоязычными, однако интуитивно понятный интерфейс и внутренние подсказки помогут выполнить настройки правильно:

- Import.io. Популярный онлайн-инструмент для сбора данных, отличающийся простым управлением. Позволяет создавать собственный API, применяемый для импорта данных. Доступен широкий выбор расширений и приложений, внутренний обучающий блог. Предусмотрены платные и бесплатные версии.

- Webhose.io. В основе продукта лежит уникальная технология работы с данными, он позволяет парсить тысячи сайтов с одним API. Поддерживает более 200 языков, доступна бесплатная 10-дневная версия, которая позволяет протестировать все возможности софта.

- Scrapinghub. Продукт позволяет парсить сайты, которые защищены от роботов. Быстро обрабатывает огромные массивы данных, характеризуется лояльной ценовой политикой.

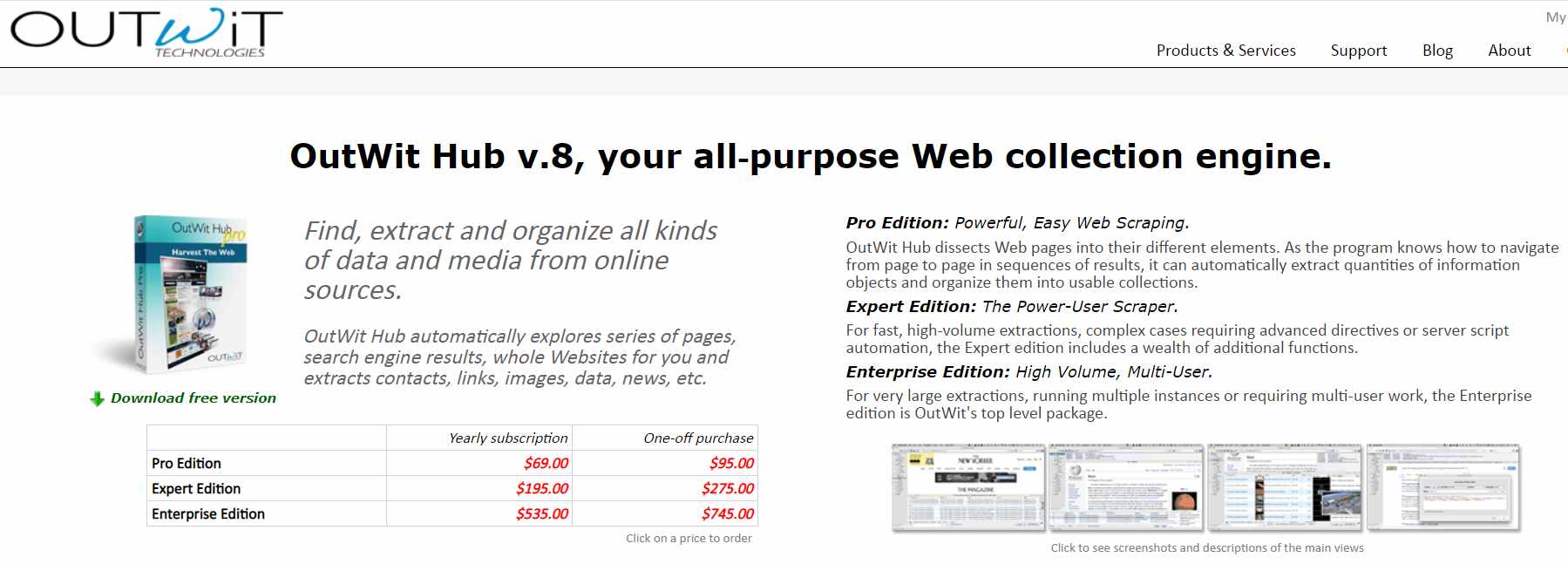

Для парсинга можно использовать другие продукты, предварительно изучив их функционал и отзывы, которые оставили реальные пользователи. Хорошую репутацию имеют VisualScraper, Scraper, OutWit Hub. Если необходимо уникальное решение, то стоит заказать создание скрипта программисту, однако в большинстве случаев возможностей вышеперечисленных инструментов достаточно для выполнения качественного парсинга.

Как часто необходимо выполнять парсинг?

Парсинг – общее понятие, ведь он может использоваться для сбора разных видов данных. Поэтому частоту проведения определяют особенности бизнеса, конкурентная среда, а также задачи, которые необходимо решить. Если интернет-магазин работает в нише, характеризующейся сезонными колебаниями и скачками цен, то парсинг придется выполнять максимально часто, чтобы быть в курсе всех возможных изменений. Чаще всего программы и софт позволяют выставлять временные интервалы для выполнения парсинга, что оптимизирует и упрощает процессы.

Какой результат можно получить?

Автоматизация сбора данных – настоящая палочка-выручалочка для владельцев интернет-магазинов и вебмастеров. С ее помощью можно парсить не только сайты конкурентов, но и социальные сети, платформы для размещения отзывов, агрегаторы, каталоги и другие, но не менее важные ресурсы. В ходе парсинга можно собирать любые виды данных – от контактов до цен. На базе собранной информации выполняются:

- корректировка цен;

- корректировка контент-плана;

- разные виды рассылок;

- внедрение конкурентных предложений;

- пересмотр политики сотрудничества с поставщиками;

- внедрение новых предложений;

- расширение или сокращение ассортимента;

- расширение или сокращение численности персонала;

- поиск новых сотрудников по итогам анализа данных;

- создание стратегии работы с клиентами;

- корректировка каталога с учетом новых данных.

Данные, собранные во время парсинга, могут использоваться для любых видов развития бизнеса. Они являются актуальными, поэтому могут быть взяты за основу при принятии стратегических решений.

В заключение

Парсинг – универсальный и высокоточный инструмент, который помогает собирать информацию и развивать бизнес в разных направлениях. С его помощью можно заглянуть в сердце сайтов конкурентов, собрать сведения о ценах и характеристиках продукта, выявить лучших поставщиков и решить другие глобальные задачи. При выполнении этой работы необходимо следить за правильностью настроек и соблюдением ограничений. Если опыта выполнения парсинга нет, то рекомендуется либо привлечь профильного специалиста, либо пройти краткий обучающий курс, который реализуют многие сервисы, специализирующиеся на парсинге.

Источник: www.insales.com

Что такое парсинг?

Что такое парсинг сайтов: польза и вред

Открыто говорить о том, что «парсят» конкурентов, люди обычно стесняются. При том, что далеко не каждый имеет четкое представление о том, что такое парсинг, в обществе он считается занятием несколько стыдным, и публично порицается. И однако, парсингом занимаются все.

А если и не все поголовно, то все крупные акулы рынка точно.

В веб-программировании процесс обработки и представления данных зовется красивым словом – парсинг. Что это такое простыми словами? По сути – автоматизированный сбор разрозненной информации с сайтов, ее сортировка и выдача в форме структуры (например, таблицы). Сбор данных с сайтов ведет специальная программа – парсер.

Что такое парсер и как он работает

Парсер представляет собой программу, скрипт, реализованный на одном из языков программирования (скажем, Python). Скрипт этот «тянет» данные с сайтов по нужным нам условиям.

Алгоритм работы парсера такой:

- Получаем исходный код страницы (правый щелчок по интересующему элементу нам в помощь), и оправляем в парсер на обработку.

- Проходясь по html-коду, как по обычному тексту, парсер отыскивает в нем определенные соответствия.

- Программа сравнивает, сопоставляет и отбирает массивы данных, которые нам интересны.

Как итог, парсер сохраняет результат в удобном пользователю формате. Это может быть файл SQL, XML, банальный TXT, но чаще – XLS (таблица Excel).

Проще говоря, парсер бродит по указанным ему ссылкам, собирая оттуда интересную нам информацию в файл.

Зачем парсят сайты

Мишенью парсинга может стать практически любой открытый ресурс в сети. В основном это доски объявлений, справочники, интернет-магазины, блоги, форумы и отзовики.

Парсинг сайтов интересен прежде всего маркетологам. Первоочередная цель парсинга – мониторинг цен у конкурентов, анализ их ассортимента, отслеживание акций на товары. «Кто, что, почём и в каких объемах продает?» – вот главные вопросы, на которые призван дать ответ парсинг. Вот пример парсера служащего этим целям.

Кроме этого, парсинг может быть использован для получения контента. Что дает возможность создавать и обновлять сайты, схожие по структуре, оформлению, содержанию. Например, наполнить каталог онлайн-аптеки на базе уже существующих в сети ресурсов.

Многие отождествляют парсинг такого рода с воровством контента, однако предлагающие услуги парсинга компании открещиваются от таких обвинений, уверяя, что закон они не преступают. Логика их проста. Ведь что такое парсинг данных? – Не более чем сбор того, что любой может видеть на сайте и вручную к себе скопировать. Просто программа парсер сделает это несравнимо быстрее. А как распорядится полученной инфой заказчик – это будет уже на его совести.

Пожалуй, самое безобидное применение парсинга – так называемый «самопарсинг». Довольно оригинальный способ проверить собственный ресурс на предмет ошибок в коде, битых ссылок, соответствия выложенного на сайте ассортимента реальному положению дел на складе, и т.п.

И наконец, к горечи простых людей, парсинг сайтов объявлений (тех же Сian или Avito) – практика распространенная. Сбор данных пользователей здесь идет не совсем с невинными целями. Просканировав доску объявлений, парсер выдаст готовенькую таблицу с контактами пользователей, а далее – все прелести в духе «правовых оттенков серого»: перепродажа баз туроператорам, риэлторам, а то и промышляющим телефонным спамом конторам и прочим надоедливым слепням на теле обывателя.

Вред парсинга для сайта-«донора»

Регулярно «шарящая» по твоему сайту программа создает конкретную нагрузку на серверы, мешая владельцу ресурса вести бизнес. А значит, что такое парсинг сайта для его владельца? – Паразитная нагрузка, не приносящая прибыли. Да и репутация ресурса, с которого «спарсили» данные пользователей, может оказаться подмоченной.

Владельцы крупных интернет-порталов отчаянно пытаются защитить свои ресурсы от парсинга. Однако любые попытки бороться с парсингом все больше напоминают борьбу с ветряными мельницами. Препятствий для парсинга по существу нет, это лишь вопрос времени и ценности информации.

Правда можно порекомендовать один недорогой сервис по защите сайта от ботов и спама. Насколько это будет эффективно, трудно сказать.

Выгодно ли заниматься парсингом

Существуют готовые программы для парсинга (например, Screaming Frog SEO Spider или Netpeak Spider), но и они требуют вдумчивого подхода, настройку, да и не всякая задача им по плечу. Большому бизнесу удобнее заказать парсинг у тех, кто на нем «собаку съел», и конторы, парсящие сайты за деньги, множатся, как грибы после дождя. Представитель одной делится статистикой компании:

- Цена за парсинг сайта – от 5000 до 9000 руб. в месяц

- Средний объем заказов – 8-15 сайтов на одного заказчика

- В день парсится порядка 300 сайтов

Вопрос, выгодно ли заниматься парсингом, похоже отпадает совсем.

Законен ли парсинг в принципе?

В законодательстве нашей страны нет статьи, прямо запрещающей парсинг. Есть запреты на взлом сайтов, DDOS-атаки, воровство защищенного авторским правом контента, но парсинг под эти статьи не попадает. А как известно, что не запрещено, то разрешено;)

Некоторые склонны видеть в парсинге DDOS-атаку. Однако профи парсинга настаивают, что всё не так. Аргументируют тем, что при парсинге они, наоборот, стараются создавать нагрузку на целевой сайт по минимуму, дабы бизнесу не навредить. Напрашивается сравнение со здоровым паразитизмом, когда паразит не станет слишком вредить «хозяину», чтобы не остаться без кормильца.

Интересно, что всем известные поисковики тоже «грешат» парсингом: ведь индексируют они сайты, регулярно наведываясь на веб-страницы и там собирая информацию. Парадокс в том, что по ясным причинам все желают, чтобы Гугл с Яндексом их сайты индексировали, однако никто не желает, чтобы их сайты парсили.

Вывод

Если вы – динамично развивающийся бизнес, продаете популярные товары, либо оперируете в высокомобильной среде (например, предлагаете услуги для отдельных категорий авторов объявлений или организуете найм персонала), то встретитесь с парсингом непременно. В качестве мишени, или в качестве заказчика.

Советую почитать:

- Что такое парсер и парсинг?

- Парсер поисковой выдачи — SELKA

- Что такое синонимизатор?

- Что такое FTP (File Transfer Protocol)?

- Что такое хостинг сайта? Как и какой выбрать

Источник: www.websteel.ru

Парсинг — что это значит и как парсить сайты?

Привет, ребят. Опережая события, хочу предупредить, что для того, чтобы парсить сайты необходимо владеть хотя бы php. У меня есть интересная статья о том, как стать php программистом. И все же, что такое парсинг?

Начнем с определения. В этой статье речь пойдет о парсинге сайтов. Попробую объяснить как можно проще и доходчивее.

Парсинг, что это значит: слово понятное дело пришло от английского parse -по факту это означает разбор содержимого страницы на отдельные составляющие. Этот процесс происходит автоматически благодаря специальным программам (парсеров).

В пример парсера можно привести поисковые системы. Их роботы буквально считывают информацию с сайтов, хранят данные об их содержимом в своих базах и когда вы вбиваете поисковой запрос они выдают самые подходящие и актуальные сайты.

Кстати говоря, если вы планируете сделать мощное приложение, которое могло бы работать удаленно, то вам может понадобиться аренда dedicated сервера. Это отличный способ получить достаточно мощные ресурсы и нужное количество памяти.

Парсинг? Зачем он нужен?

Парсинг? Зачем он нужен?

Представьте себе, что вы создали сайт, не одностраничный продающий сайт, а крупный портал с множеством страниц. У Вас есть красивый дизайн, панель управления и возможно даже разделы, которые вы хотите видеть, но где взять информацию для наполнения сайта?

В интернете — где ж еще. Однако не все так просто.

Приведу в пример лишь 2 проблемы при наполнении сайта контентом:

- Серьезный объём информации. Если Вы хотите обойти конкурентов, хотите чтобы Ваш ресурс был популярен и успешен, Вам просто необходимо публиковать огромное количество информации на своем ресурсе. Сегодняшняя тенденция показывает, что контента нужно больше чем возможно заполнить вручную .

- Постоянные обновления. Информацию которая все время меняется и которой как мы уже сказали большие объемы, невозможно обновлять вовремя и обслуживать. Некоторые типы информации меняются ежеминутно и обновлять её руками невозможно и не имеет смысла.

И тут нам приходит на помощь старый добрый парсинг! Та-дааааам!

Это самое оптимальное решение, чтобы автоматизировать процесс изменения и сбора контента.

Чем парсинг круче работы человека:

- быстро изучит тысячи сайтов;

- аккуратно отделит нужную информацию от программного кода;

- безошибочно выберет самые сливки и выкинет ненужное;

- эффективно сохранит конечный результат в нужном виде.

Как парсить сайты?

Тут я буду краток, скажу лишь, что для этого можно использовать практически любой язык программированию, который мы используем при разработке сайтов. Это и php, и C++, и python и т.д.

Поскольку наиболее распространенным среди веб-разработчиков является php, я собираюсь написать подробную инструкцию, как можно можно парсить сайты при помощи php или специальных сервисов.

Что такое парсер сайта

Парсер — это скрипт, который вытягивает нужную информацию со сторонних ресурсов.

Парсером может быть как онлайн сервис, так и программное обеспечение, которое устанавливается на компьютер.

Например, я пользовался такой программой, когда нужно было быстро наполнить интернет магазин в 10 000 товаров. Вручную я бы занимался этим целый год наверное. А так справился за неделю.

При установке такого ПО скорость работы во многом зависит от производительности вашего компа. Чем мощнее, тем быстрее происходит процесс обработки данных.

В другом случае, я воспользовался онлайн сервисом, который автоматически брал новости с одного сайта(когда они появлялись) и вставлял их на сайт клиента. Хотя на SEO продвижение такой подход влияет отрицательно. Но, как говорится, желание клиента закон.

Заказать парсинг для сайта/интернет-магазина

Если вам срочно понадобилось настроить парсинг статей на сайт или спарсить товары в магазин, можете оставить заявку и мои программисты за отдельную плату помогут решить эту задачу

А что Вы думаете об автоматизации сбора информации?

Действительно ли без этого не обойтись или лучше наполнять сайт настоящим эксклюзивным контентом?

Напишите Ваше мнение в комментариях.

Понравилась статья? Рекомендую подписаться на мою рассылку, чтобы не пропустить самые важные новости

Источник: royal-site.ru