Парсинг данных для интернет-магазинов: что такое, как работает, зачем нужен, обзор популярных сервисов

Кто владеет информацией, владеет всем миром. Сегодня это известное выражение Натана Ротшильда стало еще актуальнее, чем в бытность известного миллиардера. Расскажем об одном из популярных инструментов сбора информации из интернет-источников — парсинге. Итак, парсинг данных для интернет-магазинов: что, как, зачем.

Что такое парсинг информации

Так называют процесс автоматического сбора данных из сети. Для этих целей создано немало специальных сервисов — от простеньких до продвинутых. Они умеют анализировать буквально все: сайты магазинов конкурентов, социальные сети, сайты бесплатных объявлений, где есть нужная информация. Время парсинга зависит от объема данных и поставленной задачи. Важное условие: программы-парсеры умеют собирать базы только из открытых источников.

Что происходит с собранной информацией после ее автоматического сбора? Теперь ее можно использовать в любых целях: наполнять сайт товарами, собирать базы для электронных рассылок и делать многое другое.

Парсинг в Python за 10 минут!

Какую информацию можно парсить

Вообще любую, которую можно использовать в своих целях и когда речь идет о большом объеме однотипных данных. Обычно парсят товары с сайтов магазинов конкурентов, чтобы потом наполнить собственный каталог в автоматическом режиме. Но на самом деле сфера применения программ-парсеров куда шире. Расскажем об основных направлениях.

Парсить можно:

- товары из каталогов. Это одно из основных векторов для работы. Представьте: ассортимент даже небольшого интернет-магазина может состоять из тысяч и десятков тысяч позиций. Заливать их на сайт вручную долго и муторно. Придется пользоваться услугами копирайтеров чтобы писать описание товара, где-то брать картинки и изображения и прочее прочее. Сервисы делают это в автоматическом режиме: собранные данные можно сразу импортировать в собственный каталог;

- цены и динамику цен. Можно до бесконечности мониторить сайты конкурентов вручную, чтобы определиться с ценовой политикой и установить адекватные расценки. А можно прибегнуть к использованию программ-парсеров и сделать это быстро и безболезненно;

- профили пользователей, зарегистрированных в социальных сетях. Речь идет о таких данных, как пол, возраст, интересы, географическое местоположение и многое другое — все, что указывают люди на своих персональных страницах. В последующем эти данные можно использовать при проведении узконаправленных рекламных кампаний: контекстной рекламы в “Яндекс. Директ” и Google Adwords, настройках таргетинга во “ВКонтакте”, “Одноклассниках” и так далее;

- информацию о соискателях на сайтах объявлений и поиске работы и различных HR-порталах. Если вы активно набираете сотрудников в больших количествах (например, менеджеров по продажам). Те, кто сталкивался с формированием штата знают: собирать такую информацию вручную долго и трудозатратно. Нужно изучить множество профилей, изучить резюме и сделать многое другое. При помощи автоматических программ такая информация будет собрана автоматически. Большинство сервисов имеют встроенные фильтры, позволяющие выставить нужные критерии и требования к соискателям. На выходе — полный пул кандидатов, с которыми можно работать: звонить, писать и связываться по другим каналам;

- контактные данные. Сразу оговоримся: такая информация попадает под действие закона и защите персональных данных. Поэтому так просто взять и спарсить телефоны и email-адреса, а потом транслировать на них рассылки и оповещения, попросту нельзя. Но технически это выполнимо. Обычно в виде доноров подобной информации выступают всевозможные сайты бесплатных объявлений: “Авито”, “Циан”, “Авто.ру”, CarPrice и другие;

- объемы продаж. Некоторые крупные маркетплейсы, агрегаторы и ритейлеры показывают такие данные в открытом доступе. Вы все это видели: прямо на сайте в карточке товара есть примерно такие данные: сколько единиц осталось на складе, сколько продано за сегодня и тому подобное. Подход используют такие гиганты, как “Wildberries”, “Ламода” и “Леруа Мерлен”. Зачем интернет-магазину эта информация? Да затем, что из нее можно выудить много полезного: объемы продаж конкретных позиций, их популярность на рынке, а также примерный спрос. После этого появится понимание, в какую сторону движется рынок и чем он сейчас дышит. А еще есть возможность прогнозировать спрос на определенные товары в перспективе, например, через месяц или два;

- любую другую однотипную информацию в больших объемах.

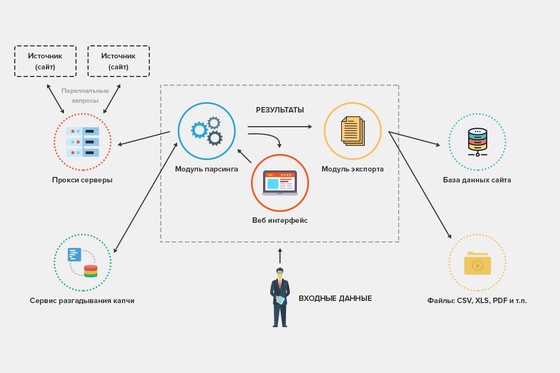

Как это работает

Для того, чтобы спарсить требуемую информацию, нужно проделать следующее:

- Определиться с тем, что собираем. Критерии поиска надо сформулировать как можно подробнее. Программы-парсеры имеют в настройках множество фильтров, которые лучше применять на полную катушку. Так данные будут более релевантными запросам и подробными. Если речь идет о сборе профилей пользователей, распишите не только пол, возраст и геолокации, но и участие в тематических сообществах, круг интересов, образование и прочие данные.

- Выбрать подходящую программу. Здесь все зависит от бюджета на проект и ваших запросов. Есть простенькие сервисы с бесплатными пробными версиями, а есть дорогостоящие профессиональные инструменты. Если парсинг требуется раз от разу и особых требований к сбору данных нет, можно начать с бесплатной площадки или использовать пробную версию крутого продукта. Второе предпочтительнее — так вы получите серьезный функционал на безвозмездной основе. В случае, когда запросы к сбору данных велики, придется оплатить подписку на один из профессиональных сервисов.

- Собственно, запустить парсинг и собрать данные. Для этого в специальном окне программы-парсера указываем адрес страницы-донора. Ну или страниц, если нужно спарсить данные из нескольких источников. Проводим настройки, выставляем фильтры и запускаем парсинг. После этого можно использовать информацию по прямому назначению. Обычно собранные данные сводятся в наглядную таблицу, но здесь все зависит от особенностей работы конкретного сервиса. Все это можно импортировать в другие места, например, в каталог сайта интернет-магазина.

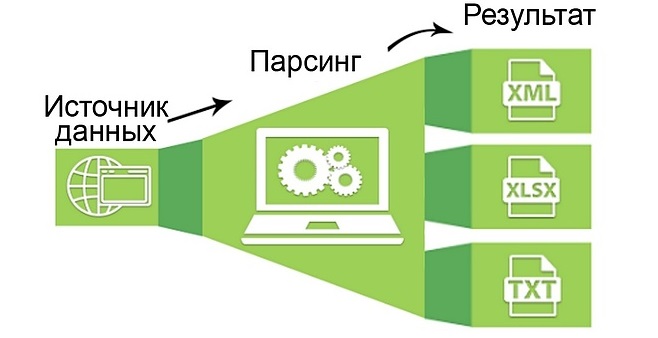

Общая схема работы метода

Как выбрать подходящий сервис для сбора информации

Приводим пошаговый алгоритм выбора программы-парсера. Работа будет состоять из нескольких этапов:

- Определитесь с целями и задачами. Дело в том, что большинство программ имеют узкую направленность и универсальных инструментов мало. То есть, такого софта, который анализирует соцсети, собирает контакты с “Авито” и попутно парсит каталоги товаров почти нет. Так что если нужно собирать данные из нескольких разных областей, придется воспользоваться парой-тройкой различных площадок. А так — если нужно собрать профили под портрет целевой аудитории — надо использовать программу-парсер социальных сетей.

- Определитесь с бюджетом. Сколько денег вы готовы потратить на сбор данных? Этот критерий может оказаться ключевым при выборе программы-парсера. Как мы уже говорили, существуют бесплатные сервисы и продвинутые дорогостоящие продукты. От бюджета на проект и будет зависеть выбор сервиса.

- Обратите внимание на функционал площадки. Он должен удовлетворять списку требований к сбору данных. Если чего-то не хватает, все предприятие может пролететь впустую, когда пропущен один из ключевых параметров поиска.

- Почитайте отзывы о сервисе в интернете. Только ищите настоящие, а не фейковые, написанные самими о себе. О том, как распознать такие комментарии, мы писали ранее.

- Обратите внимание на работу службы технической поддержки. Она должна функционировать в режиме 24/7/365, то есть круглосуточно, без выходных и праздничных дней. По закону подлости все сбои в работе, требующие оперативного вмешательства со стороны поставщика услуги, происходят именно ночью в выходной. Круглосуточное техническое сопровождение будет в этой ситуации очень кстати.

- Изучите сайт поставщика услуги на предмет кейсов и тех, кто уже воспользовался сервисом. Если среди клиентов вы обнаружите гигантов интернет-торговли или просто крупные компании, это очень хорошо. Обычно найти такую информацию не составляет труда: сервисы очень гордятся сотрудничеством с компаниями федерального масштаба и охотно вываливают такую информацию на главную страницу сайта. Увидели там “Тинькофф-банк” или Mail.ru Group — все в порядке, сервису доверяют.

Обзор сервисов для сбора информации

Приготовили для вас мини-подборку популярных площадок-парсеров. Среди них вы найдете сервисы для анализа ЦА, товаров и цен конкурентов. Поехали.

Targethunter

Номер один нашего списка. Почему? Именно по той причине, что площадке доверяют многие крупные компании, например, “Билайн” и “Додо пицца”. Кроме того, это один из официальных партнеров социальной сети “ВКонтакте”, а это говорит о многом. Сервис предназначен для анализа целевой аудитории в соцсетях и послужит незаменимым инструментом в работе любого SMM-специалиста.

“Таргетхантер” это:

- более 150 различных инструментов для поиска и анализа целевой аудитории;

- автоматическая загрузка собранных данных в рекламный кабинет;

- удобное управление сообществами с помощью специальных опций;

- бонусная программа. Вы получаете награду за активности, а потом деньги можно потратить на оплату сервиса и другие цели;

- круглосуточная техподдержка без выходных и праздников. По заверениям представителей площадки, среднее время ответа специалиста не превышает одной минуты.

Сервис работает на трех тарифных планах:

- бесплатный free-тариф. Здесь есть 35 инструментов для парсинга, круглосуточная техподдержка и доступ к сообществу с полезной информацией, а также доступ к закрытым чатам с экспертами по SMM;

- тариф “Стандартный”, стоимостью от 18 рублей в день при оплате за год. Это уже 130 парсинговых инструментов и более высокая скорость сбора данных;

- тариф “Автоматизация”. Цена — от 34 рублей в день. Самая высокая скорость парсинга, а также дополнительные опции: отслеживание активностей сообществах, дополнительный поток для автоматических задач и другие.

Import.io

Пожалуй, один из самых продвинутых сервисов для сбора информации о товарах в интернет-магазинах. С его помощью можно создать каталог легко и безболезненно, не прибегая к услугам программистов и других специалистов. Система анализирует карточки товаров интернет-магазинов-доноров и формирует пакет со следующими данными:

- цена;

- название;

- категория;

- материал;

- год выпуска и так далее.

Софт иностранного производства, поэтому вы столкнетесь с серьезным минусом: интерфейс доступен исключительно на английском языке. Import.io работает на двух тарифных планах — платном и бесплатном. Для большинства интернет-магазинов достаточно будет бесплатной версии продукта.

Scrapinghub

Один из немногих универсальных инструментов, позволяющих парсить информацию любого вида и формата. Программа преобразует однотипные данные с сайтов и организованный контент. Есть бесплатный тариф, дающий доступ к работе одного поискового робота. Бесплатно спарсить можно 1 гигабайт информации, далее за каждый месяц придется платить 4 доллара.

Премиум-тариф запускает сбор посредством работы четырех ботов одновременно. Это будет стоить уже 9 долларов в месяц.

Минус Scrapinghub тот же — отсутствие русскоязычной версии. Правда, из-за простого и понятного интерфейса это не проблема. Техподдержка в лучших традициях: круглосуточно, без выходных и праздников.

На самом деле программ для сбора данных гораздо больше, на любой вкус и выбирайте, парсите и будьте на голову выше конкурентов. Удачи!

Источник: www.insales.ru

Парсер – что это такое простыми словами, как его настроить и пользоваться программой для парсинга сайтов

Получи нашу книгу «Контент-маркетинг в социальных сетях: Как засесть в голову подписчиков и влюбить их в свой бренд».

Подпишись на рассылку и получи книгу в подарок!

Есть приложения, которые позволяют автоматизировать множественные процессы интернет-маркетинга. Они необходимы многим бизнесменам, которые либо хотят использовать сбор информации с конкурирующих веб-источников, либо защитить себя от подобного «воровства» контента. В любом случае, работая с интернет-ресурсом важно знать о парсинге сайта – что это такое (мы расскажем простыми словами) и как настроить и пользоваться парсером данных.

Содержание скрыть

- Parsing

- Законно ли использовать парсинг семантического ядра с сайтов конкурентов

- Сквозная аналитика

- Как парсить данные

- Как спарсить цену

- Как парсить характеристики товаров

- Как спарсить отзывы (с рендерингом)

- Как парсить структуру сайта

Parsing

Данный механизм действует по заданной программе и сопоставляет определенный набор слов, с тем, что нашлось в интернете. Как поступать с полученной информацией, написано в командной строке, называемой «регулярное выражение». Она состоит из символов и задает правило поиска.

Фактически понятие переводится с английского языка как семантический анализ или разбор. Но термин, применяемый в технологиях создания и наполнения вебсайта, имеет более широкое значение.

Это процедура, действие, предполагающее многостороннее исследование страницы, документа, целого раздела на предмет нахождения лексических, грамматических единиц или иных элементов (не только текста, но и видео-, аудио-контента) с последующей систематизацией. Искомые сведения находятся и преобразуются, они подготавливаются для дальнейшей работы с ними. Еще можно сказать, что это быстрая оценка и скорая обработка интернет-ресурса, данных с него. Вручную подобный процесс занял бы много времени, но автоматизация его значительно упрощает.

Больше видео на нашем канале — изучайте интернет-маркетинг с SEMANTICA

Таким образом, парсер – это программа для парсинга ключевых слов сайтов. Она настраивается, в нее вводятся параметры поиска и прочие указания, чтобы получить семантическое ядро или анализ карточек товаров для интернет-магазина.

Второе название для процедуры – скраппинг, или скрейпинг от англоязычного «scraping». В ходе этого буквального «соскабливания» программное обеспечение заходит на вебсайт под видом обыкновенного пользователя и, используя скрипты, производит сбор данных.

Исходником может быть ваш собственный веб-ресурс (для аналитики и принятия последующих решений), сайт конкурента, страничка из социальных сетей и пр. Полученным результатом можно будет пользоваться в дальнейшем по усмотрению владельца. Приведем понятный пример. По такому принципу работают поисковые системы, когда они анализируют страницы на релевантность, наличие ключевых слов из запроса и соответствие тематике, а затем на основе полученных сведений автоматически формируется выдача.

Законно ли использовать парсинг семантического ядра с сайтов конкурентов

Посмотрим на это с такой стороны. Если ресурс является открытым для пользователей, то вся представленная информация может собираться вручную. А если это доступно, то и применение специального софта для автоматизации процесса не является противозаконной. Опять же при условии, что доступ разрешен всем.

- Взламывать ресурс и извлекать внутренние, конфиденциальные сведения, например, о пользователях интернет-магазина, совершенных ими покупках, персональных данных, записях в личных кабинетах и пр.

- Намеренные перезагрузки системы, то есть атаки DDOS. В ходе них на сервер оказывается чрезмерное искусственное давление, вычислительная система не может оперативно обрабатывать все полученные запросы и отказывается работать.

- Воровство уникального контента. На любую информацию может распространяться авторское право, в том числе, на изображения, фотографии и текст, если их подлинность была нотариально заверена.

Таким образом, никто вас не накажет за сам факт автоматизированного сбора данных с открытых источников. Но проблемы у многих пользователей парсеров начинаются в тот момент, когда нужно распоряжаться полученной информацией.

Сквозная аналитика

Это услуга, которая признана дать отчет о результативности интернет-рекламы. То есть с помощью сервиса собираются данные с рекламных площадок, связывает их со сведениями об обращениях и продажах. Анализируя это, можно понять, насколько эффективно было использование того или иного метода продвижения. Таким образом возможно выявить, какие каналы являются затратными, но не приносят достаточно выгодного результата, это помогает оптимизировать бюджет.

Такую услугу постоянной аналитики предлагает компания SEMANTICA в комбинации с комплексным продвижением сайтов. Клиенты этого агентства могут наблюдать за тем, какой результат он получает от того или иного действия, проекта. Все сведения предоставляются в виде отчетов, диаграмм.

Для чего нужен парсинг

Первое с чем сталкивается начинающий руководитель – вокруг много информации, слишком большое ее количество затрудняет возможность оперировать большинством ее массы вручную.

Именно здесь необходимы парсеры.

- Сделать анализ средних цен на рынке. Это очень большая работа, если проводить ее самостоятельно. Ведь в одном сегменте может быть представлена масса позиций и многочисленные конкуренты. Нужно не только узнать усредненные параметры, но и самые низкие границы, чтобы проводить акции, скидки, быть конкурентоспособным.

- Следить за изменениями, которые происходят в сфере. Это может быть включение новых товаров, смена цен.

- Периодически осуществлять генеральную «уборку» в собственном интернет-магазине. Особенно это необходимо для крупных ресурсов с обширным каталогом, где могут затеряться страницы с ошибками, дубли, незаполненные разделы и прочие недоработки.

- Наполнение карточками товаров. Можно просто копировать описания на аналогичные позиции у конкурентов, но это может вызвать неодобрение со стороны поисковых систем. Повысить уникальность помогает синонимайзер. Или еще одна возможность – с помощью парсера позаимствовать информацию с иноязычного ресурса, а затем провести ее через переводчик. Получится коряво, потом можно вручную исправлять. При этом быстро наполняется большой объем карточек.

- Формирование баз клиентов. Данные берутся из относительно открытых ресурсов, архивов и резюме. Насколько этично пользоваться таким контентом – решать только вам.

Достоинства применения программ для парсинга каталога товаров с сайта для интернет-магазина

Сравним автоматический режим сбора с ручным, преимущества:

- скорость, возможность работать в любой период времени, даже круглосуточно, только бы было поставлено достаточно целей;

- заданные параметры могут быть настолько тонкими и разнообразными, насколько это требуется;

- не происходит ошибок из-за человеческого фактора – невнимательность, усталость вычислительной системе не известны;

- проверка может запускаться автоматически, например, если настроить еженедельную аналитику, полностью без вмешательства человека;

- можно выбрать удобный формат отчетности и менять его в один клик при необходимости – диаграммы, списки и пр.;

- нагрузка на анализируемую страницу распределяется равномерно, чтобы вас не уличили в противозаконной атаке DDOS.

Ограничения: почему бывает сложно парсить

Многие задумываются о том, как защитить сайт от парсинга, потому что не хотят терять уникальность контента. Поэтому используют различные программы, которые запрещают доступ к ресурсу ботам.

Запреты могут накладываться на работу по следующим аспектам:

- По user-agent. Клиентское приложение отправляет запросы, чтобы получить информацию о пользователе. Многие вебсайты блокируют парсеры, но это можно избежать, если настроить все как YandexBot или Googlebot.

- По robots.txt. Здесь еще проще. Прописываем в настройках, что нужно игнорировать этот протокол.

- По IP. Подозрительно, что с одного адреса с удивительной регулярностью поступают одинаковые запросы, действия. Решить это можно, используя VPN.

- По капче. Ряд ресурсов при подозрении на автоматизацию процесса предлагают ее пройти. Обучение системы отгадывать и распознавать картинку – это дорогая и длительная процедура.

Как работает парсинг и какой контент можно парсить своими руками или автоматически

Вам удастся получить любую информацию (текстовую или медийную), которая находится в открытом доступе, например:

- Названия товаров, карточек и категорий, в которые они обобщены.

- Характеристики. Особенно важно для бытовой техники, смартфонов.

- Стоимость, наличие скидки.

- Изменение товарного ряда, добавление новых позиций.

- Описание услуг или продаваемых предметов.

- Изображения. Но с ними следует работать аккуратнее, они могут быть авторскими, а значит, их использование уже будет незаконным.

Мы очень не рекомендуем перезаливать полученный текст на свою страничку в надежде, что он пройдет через фильтры поисковых систем. Скорее всего, они сразу вас забанят при попытке продвинуть такой неуникальный ресурс.

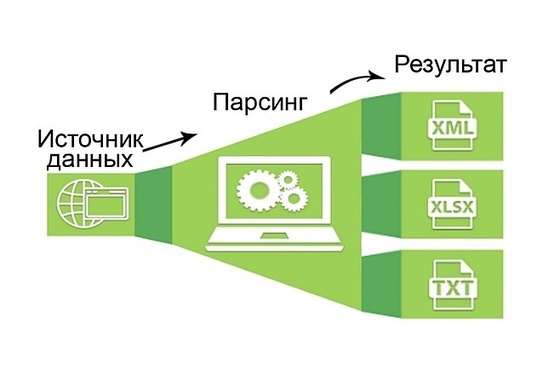

Алгоритм работы парсера

Тонкости процесса зависят от задачи, которая забивается в программы, но в остальном действия имеют следующую последовательность, схему:

- В приложение вбиваются параметры для поиска.

- По ним он осуществляет отбор вебсайтов.

- По завершении полученные сведения систематизируются в единую базу. Глубина также указывается.

- Формируется отчетность в наиболее удобном для вас варианте.

Способы применения

Парсинг для начинающих начинается с анализа конкурирующих фирм, чтобы сформировать собственную ценовую политику и план продвижения, стратегию интернет-маркетинга. А уже уверенные пользователи одновременно используют парсеры и для изучения конкурентов, и для аудита своего ресурса, для сравнения полученных сведений. Такая работа в тесной связке помогает поддерживать конкурентоспособность на высоком уровне.

Как парсить данные

Можно пойти двумя путями – купить программу, которых представлено большое множество, или создать приложение собственными силами фактически на любом из языков программирования.

Второе особенно актуально, когда нужно выставить только несколько параметров. Посмотрим теперь на особенности парсинга некоторых данных для «чайников».

Как спарсить цену

Определение ценовой политики – это самая ходовая задача для приложений. Для этого необходимо посмотреть код анализируемого товара и ввести его в программу. Она автоматически подтянет другие позиции, отвечающие запросу. Сэкономить время и повысить эффективность можно, если ограничить круг страничек. Например, так он не будет искать по разделу с информационными статьями.

Добавлять стоит категории и сами карточки продукции. Прописываются ссылки на них в карте XML.

Как парсить характеристики товаров

Для этого понадобится вручную определить код у каждого продукта, который вам требуется. Затем можно подвязать полученные сведения с автозаполнением полей в вашем интернет-магазине. Особенно актуально подтягивать описание, когда вы занимаетесь реализацией техники, автомобилей, смартфонов. Часто характерные особенности берутся на сайтах производителей. Они не могут отличаться уникальностью, поэтому поисковики за это не ругаются.

Как спарсить отзывы (с рендерингом)

Процедура аналогичная – копирование кода, а затем его ввод в приложение для парсинга. Но несколько отличаются последующие действия. Обычно комментарии открываются в тот момент, когда пользователь прокручивает страницу вниз, чтобы ознакомиться с ними. И тогда нужно снова залезть в настройки и изменить поле «Рендеринг» на JavaScript. В таком случае программа будет себя вести точно как юзер, прокручивая вниз контент до отзывов.

Как парсить структуру сайта

Это важное занятие, которым также часто занимаются новички. Основная задача – узнать, из каких разделов, подразделов и категорий состоит веб-ресурс, чтобы сделать аналогичные. Структурирование определяется, благодаря изучению breadcrumbs, или хлебных крошек в буквальном переводе. На самом деле термин подразумевает навигационную цепочку, которая выстраивается от начального элемента (корневого файла) до итогового.

Что нужно для этого сделать:

- навести курсор на одну из строчек навигации;

- скопировать код по аналогии с тем, как мы это делали с ценами;

- отправить его в приложение.

Данный алгоритм следует повторить и с другими элементами структуры.

Теперь вы знаете, как сделать парсинг сайта интернет-магазина самостоятельно. Но не всегда удается правильно распорядиться полученной информацией, а также быстро обойти все существующие ограничения на поиск. В таком случае мы рекомендуем обратиться к компании по продвижению вебсайтов. Специалисты агентства SEMANTICA производят анализ конкурентов на начальном этапе работы с проектом, а заказчик получает готовый результат в удобном формате.

Источник: semantica.in

Парсинг

Расскажем, что такое парсинг, что значит парсить данные, как правильно это делать и насколько законной является данная процедура. А также расскажем, какую информацию можно парсить на сайтах и какие есть виды парсинга.

Что такое парсинг

В переводе с английского слово парсинг означает структурирование.

Парсинг — это автоматизированный сбор и структурирование информации с сайтов при помощи программы или сервиса. Эта программа называется парсер и её задачей является сбор информации в соответствии с заданными параметрами.

Например, при помощи парсинга сайтов можно создать описание карточек товаров онлайн-магазина. Сотрудники не тратят время на их заполнение вручную, так как все данные собирает программа.

Что значит «парсить сайт»

Парсинг сайта — это процесс сбора данных с сайтов. Вот как можно использовать такой тип парсинга:

- анализ собственного сайта — найти ошибки и внести изменения;

- анализ сайтов конкурентов — найти идеи для обновления собственного сайта, посмотреть описания товаров;

- анализ технической стороны сайта — поиск неработающих ссылок, повторяющихся страниц, оценка правильности работы robots.txt и других элементов;

- анализ сайта с точки зрения развития собственного бизнеса — анализ продуктов конкурентов, сбор информации по ценам, заголовкам, описаниям, оценка структуры сайтов.

Для чего нужен парсинг данных сайта

Большой объём данных непросто систематизировать вручную. Парсинг данных помогает:

- заполнить карточки товаров на новом сайте — на заполнение вручную уйдёт много времени;

- привести сайт в порядок — парсинг поможет найти страницы с ошибками, карточки товаров с неправильным описанием, повторы, ошибки в информации об оставшихся товарах на складе;

- оценить среднюю стоимость продукта, собрать информацию по другим компаниям на рынке;

- регулярно следить за изменениями — например, повышением цен или нововведениями у прямых конкурентов;

- собрать тексты с зарубежных сайтов и перевести их автоматически.

Плюсы парсинга

По сравнению со сбором данных, который бы делался вручную, с парсерами компании могут:

- собирать данные безошибочно;

- учитывать при поиске все заданные параметры;

- быстро собирать данные, 24 часа в сутки, регулярно — каждый месяц;

- собирать информацию в нужном формате: XLSX, XML, CSV, JSON;

- не нагружать сайт, чтобы не провоцировать эффект похожий на DDOS-атаку;

- выгружать данные на сайт.

Законно ли использовать парсинг

Иногда парсинг вызывает негативное отношение. Но в действительности парсинг не нарушает законодательных норм и юридическая ответственность за него не установлена.

Онлайн-обзор платформы Roistat

В прямом эфире расскажем, как сделать маркетинг эффективным

Вот что запрещает законодательство:

- собирать данные из личных кабинетов пользователей;

- DDOS-атаки (Distributed Denial of Service attack) — совокупность действий, которые могут вывести сайт из рабочего состояния;

- копирование контента: изображений, текстов.

Парсинг не нарушает закон, когда программы собирают данные из открытого доступа. Такую информацию можно собрать и вручную. Парсеры лишь ускоряют процесс и исключают неточности.

Незаконным может быть то, как владелец распоряжается собранной информацией — например, если бизнес полностью копирует статьи конкурентов.

Какой тип данных можно парсить с сайтов

Собирать разрешено информацию, которая находится в открытом доступе:

- характеристики товаров;

- названия продуктов;

- тексты для рерайта, например, для описания товаров;

- информацию о промоакциях и скидках;

- цены.

Как парсер собирает данные

Схематично алгоритм парсинга сайта можно представить так:

- по заданным параметрам программа ищет информацию на определённых сайтах или по всему интернету;

- данные собираются и систематизируются в зависимости от заданных настроек;

- создается отчёт в заданном формате. Как правило, парсеры поддерживают разные форматы и работают в том числе с PDF, RAR, TXT.

Виды парсинга

В зависимости от того, какие данные собираются, можно выделить несколько видов парсинга:

- Парсинг товаров — сбор данных о товарах из каталогов интернет-магазинов. Нужен, чтобы проанализировать ценовую политику конкурентов или заполнить описание собственных товаров.

- Парсинг цен — сбор данных о ценах конкурентов. На основе этой информации можно выстроить собственную ценовую политику и подобрать оптимальные цены для товаров.

- Парсинг в программировании — проводится с целью выявить проблем в производительности сайта или приложения, с кодом, найти другие недостатки в работе сайта.

- Парсинг слов — помогает проанализировать семантическое ядро сайта, разделить собранные ключевые слова на группы. Это помогает создавать рекламные объявления на Яндекс.Директ и Google Ads.

- Парсинг аудитории — поиск и сбор информации о пользователях соцсетей. Помогает найти целевую аудиторию, которой интересен продукт бизнеса. Для таргетинга рекламы можно указывать конкретные характеристики: пол, возраст, хобби, географическое положение, социальный статус аудитории. Компания предложит релевантный продукт аудитории и сократит затраты на рекламу.

- Парсинг выдачи — помогает определить сайты-лидеры поисковой выдачи и собрать важные для SEO данные о них: количество обратных ссылок, число индексируемых страниц по ключевой фразе и другое. Это поможет найти хорошие рекламные площадки и сайты для размещения ссылок.

Источник: roistat.com

Что такое парсинг?

Владельцы сайтов и интернет-магазинов очень часто пользуются парсингом для развития своего бизнеса. В то же время мало кто признается в этом, и, кроме того, почему-то это считается в широких кругах не самым честным способом получения информации. Что такое парсинг, как это работает и почему это законно, разберемся далее.

Что называется парсингом?

Парсинг – это сбор и систематизация информации по необходимым критериям в автоматическом режиме. Слово произошло от английского глагола «to parse», который в переводе означает «анализировать, обрабатывать, разбирать». Как мы видим, ничего, что было бы противозаконно или аморально, в этом нет. Для парсинга используются программы и алгоритмы, позволяющие проводить сбор и систематизацию необходимой информации автоматически, что разительно ускоряет процесс.

Зачем это нужно?

Анализ и сбор информации о трендах на рынке и конкурентах необходим для развития бизнеса. и, если в небольших объемах такой сбор данных можно провести вручную, то, когда речь идет об огромных массивах данных, к примеру, об анализе ассортимента и ценообразования в нескольких онлайн-магазинах конкурентах, сделать это без применения определенного автоматического алгоритма очень сложно.

Для примера, провести ручной анализ пяти правил ценообразования магазинов-конкурентов и внести необходимые данные в таблицу для последующего анализа, действительно, не составит труда. Говоря же о пятидесяти магазинах, проще приобрести программу и провести тот же анализ автоматически.

Законно ли это?

Несмотря на то, что многие считают парсинг незаконным, он ничем не противоречит законодательству. Более того, крупные компании не скрывают, что прибегают к нему в своем развитии. Но в то же время есть некоторые вещи, косвенно связанные с парсингом, которые законными не являются.

- Взлом сайта: получение личных данных его пользователей.

- DDOS-атаки: в результате парсинга данных сайт может испытывать чрезмерную нагрузку.

- Заимствование контента, защищенного авторским правом: авторских статей, фотографий с водяными знаками, стихотворений тоже запрещено.

Таким образом, парсинг законен в том случае, если вы собираете ровно ту же информацию, которую могли бы собрать вручную, но с использованием автоматически программ. В то же время, вы вполне можете попасть под стражу за то, как вы распоряжаетесь полученной информацией.

Для каких целей можно использовать парсинг?

Парсинг можно применять для сбора данных в различных ситуациях. Разберем некоторые з них.

- Анализ цен на рынке. Если вы открыли свой интернет-магазин, для анализа ценовой политики конкурентов и формирования собственной политики ценообразования, особенно если позиция для исследования много, проще и быстрее использовать парсеры, чем делать это вручную.

- Отслеживание ценовых скачков. Регулярное проведение парсинга позволяет выявить скачки цен и подстроиться под рынок, чтобы не потерять покупателей.

- Приведение сайта в порядок. Благодаря парсингу можно найти дублированные карточки товара на сайте, выровнять цены, исправить данные по остатку товара на сайте в соответствии с фактическими остатками.

- Наполнение товарных карточек на сайте магазина. Это тоже можно сделать с помощью программы-парсера, особенно если сайт только что создан и требуется заполнить много карточек товара. При этом чаще всего программа использует для наполнения товарных карточек иностранные сайты и автоматически переводит необходимую информацию для того, чтобы избежать плагиата. Можно использовать и тексты русских сайтов, отредактированные синонимайзером, но в этом случае вы можете попасть под санкции поисковых систем.

- Поиск потенциальных клиентов. Такой парсинг выглядит не очень этично, но, тем не менее, используется. Для этого можно создать личный кабинет на сайте по поиску работы с доступом к открытым и архивным вакансиям и резюме.

Плюсы парсинга

- Данные можно собирать в любое время: программам не нужен отдых и перерывы.

- Можно настроить сбор данных по множеству параметров под любой, даже самый сложный запрос.

- При автоматическом сборе данных ошибки из-за невнимательности или усталости невозможны.

- Проверку и сбор новых данных можно выполнять автоматически в указанное время или с необходимым временным промежутком.

- Данные можно собрать в любом необходимом формате.

- Можно дозировать нагрузку на сайт-источник, чтобы избежать его перегрузки.

Ограничения для программ-парсеров

- По user-agent. Программа должна сообщить сайту данные о себе, что послужит причиной для ограничения ее деятельности на данном ресурсе. Решается это с помощью смены данных о программе в настройках на YandexBot или Googlebot.

- По robots.txt. это ограничение не позволяет поисковым роботам Гугл или Яндекс индексировать страницу. Для того, чтобы обойти это ограничение, необходимо в настройках задать игнорирование robots.txt.

- По IP-адресу. Если на сайт поступает слишком много одинаковых запросов с одного IP-адреса, сайт может ограничить программе доступ. Для решения проблемы необходимо использовать VPN.

- По капче. Этот способ ограничения парсинга обойти программе слишком сложно и дорого. При поступлении множества одинаковых запросов на сайт необходимо ввести капчу и подтвердить, что действия совершаются человеком.

Какую конкретно информацию можно получить с помощью парсинга?

Благодаря такому методу сбора информации вы можете получить практически любые данные в текстовом и фото-формате, однако фотографии часто защищены авторским правом, поэтому их брать опасно. Кроме того, не стоит использовать парсеры для сбора личных данных пользователей различных сайтов из их личных кабинетов. В основном, программы-парсеры фокусируются на сборе текстовой информации:

- Категории и названия товаров;

- Характеристики товаров;

- Цены на продукцию;

- Информация о новых товарах, акциях и скидках;

- Описания товаров и другие тексты для последующего рерайта.

Как работает программа-парсер?

Несмотря на то, что программ для парсинга существует довольно много, общий алгоритм их работы довольно прост, а принцип их работы схож с ручным поиском и сбором данных.

В первую очередь, после настройки программы, парсер ищет на указанных сайтах или в интернете необходимые пользователю данные. Далее данные собираются и систематизируются в соответствии с критериями, выбранными пользователем. И после сбора и систематизации информации она предоставляется пользователю в предпочтительном для него формате. Большинство парсеров могут предоставлять информацию во всех часто используемых и поддерживаемых форматах.

Способы применения программ-парсеров

Обычно парсеры используются для анализа сайта пользователя или сайтов конкурентов. Это необходимо для улучшения собственного сайта и анализа трендов и цен на рынке, чтобы составить достойную конкуренцию другим бизнесменам, а в идеале стать более привлекательным для клиента, нежели конкуренты. Чаще всего оба анализа проводятся одновременно, чтобы иметь более полное представление и о различиях и сходстве результатов анализа.

Как воспользоваться парсингом?

Существует два варианта того, как парсить необходимые для вас данные. Вы можете выбрать подходящую для вас программу из тех, что существуют на рынке. Если же те парсеры, что уже созданы, вам не подходят, вы можете самостоятельно написать необходимую программу, используя почти любой из существующих языков программирования.

Создать парсер также можно с помощью ресурса ZennoPoster, который позволяет конструировать необходимую программу в соответствии с вашими запросами. Работать такие программы будут точно так же, как уже существующие платные или бесплатные парсеры.

Классификация программ-парсеров

Существуют несколько видов парсеров, которые можно классифицировать по различным критериям.

- Способ доступа к ресурсам парсинга. Программа может устанавливаться на компьютер, а может работать из облачного хранилища.

- Используемые технологии. Программы могут быть созданы с помощью одного из языков программирования. Также можно использовать специальные браузерные расширения, формулы Excel или Google.

- Назначение программы.

Классификация программ-парсеров по их функциям:

- Парсер для заполнения карточек товаров. Такие программы позволяют найти необходимые описания товаров, цены, характеристики, чтобы автоматически заполнить карточки товаров в интернет-магазине и не тратить на это время сотрудников.

- Парсер для публикации статей. Такие программы с определенной частотой сканируют указанные ресурсы и размещают найденные на них статьи и другие данные на другом сайте. Это в определенной степени граничит с воровством авторского контента, однако противозаконным не является, если данные взяты в общем доступе.

- Парсеры для сбора личных данных. Пользование такими программами может быть незаконна, если речь идет о данных, указанных пользователями в их личных кабинетах, однако чаще всего такие программы используются для сбора данных в общем доступе, например, данных о пользователях соцсетей, чтобы сформировать понимание целевой аудитории того или иногда бренда, товара или услуги и настроить, к примеру, таргетинговую рекламу.

- Парсер для лент новостей. Такие программы в автоматическом режиме отслеживают, к примеру, прогноз погоды, курс валют и другие динамически меняющиеся данные и публикуют и на различных сайтах.

- Парсеры для сбора семантического ядра. Такие программы анализируют частотность различных запросов по различным темам и формируют семантическое ядро. В дальнейшем по полученной с помощью таких парсеров информации можно создавать авторские статьи, которые будут индексироваться поисковыми системами и привлекать пользователей.

- Парсеры – аудиторы. Такие программы проверяют заголовки и подзаголовки сайтов, а также содержащуюся на них информацию, на соответствие требованиям поисковых систем, что напрямую влияет на то, насколько хорошо индексируются сайты поисковыми системами и насколько они актуальны и заметны для пользователей.

Выводы

Парсинг – одно из средств улучшения качества наполнения сайта через сбор и анализ доступной информации. С помощью него владельцы сайтов и СЕО-специалисты могут определить целевую аудиторию для рекламы и продвижения своих продуктов. Несмотря на распространенное мнение о том, что парсинг и программы для него не соответствуют закону или морали, на деле многие компании пользуются таким способом получения необходимой для их развития информации. Можно сказать, что на сегодняшний день парсинг – это всего лишь способ получения и систематизации информации в доступной форме, и его законность определяется лишь тем, какую информацию вы собираете и как вы сами ее используете.

Источник: quokka.media