Что такое парсинг: как правильно парсить цены, фото и товары с сайта

Парсинг — это автоматизированный способ сбора и систематизации данных из различных интернет-источников. Для получения информации нужен специализированный сервис — парсер.

Парсер — это автоматизированная система, для которой вся информация в сети представлена в виде кода или текста. Он собирает информацию практически из любых источников в 3 шага: сканирует ресурс → находит заданные параметры → составляет отчет.

Парсер ищет данные на обычных сайтах, интернет-магазинах, социальных сетях и каталогах.

Разберем, как спарсить данные с любого сайта без навыков программирования.

Зачем нужен парсинг?

Маркетолог ежедневно работает с большим объемом данных. Он анализирует работу сайта, отслеживает конкурентов, интересы аудитории и другие данные. Этот процесс можно делать вручную или автоматизировать с помощью специальных утилит — парсеров.

Когда проводят парсинг?

При проведении маркетингового исследования

Парсинг: что это такое и зачем он нужен | SEMANTICA

Специалисты мониторят и сравнивают цены конкурентов. Когда ассортимент большой, ручная проверка занимает несколько дней. С парсером ту же процедуру реализуют за пару часов

При настройке сайта

С помощью парсера web-мастер анализирует структуру интернет-магазина через карту ресурса

При мониторинге цен

Когда нужно отследить изменения цены у конкурентов и сделать ответное предложение покупателям, настраивают парсинг цен. Можно отслеживать динамику и предлагать скидки в ответ на действия других компаний — парсер существенно экономит время.

Или отслеживать динамику цен у поставщиков. Это особенно важно интернет-магазинам и бизнесам, действующим по модели дропшиппинг

При поиске товарных позиций

Если с сайта компании-поставщика нужно перенести описание и характеристики товаров, автоматизируйте процесс.

Собирайте информацию по требуемым параметрам и копируйте в свой каталог

При поисковой оптимизации сайта

При аудите сайта-конкурента специалисты копируют метатеги и ключевые слова.

Специалисты также парсят позиции конкурентов в поисковой выдаче, выделяют title, description и заголовки.

Парсер собирает сведения, сводит их в таблицу и помогает повышать эффективность продвижения в поисковых системах

При аудите ссылочной массы

Когда сайт выдает ошибку, web-мастер оптимизирует работу с помощью парсера.

Программа ищет неработающие страницы и линки, а специалист исправляет ошибки

При анализе контента на сторонних сайтах и в соцсетях

При разработке стратегии продвижения маркетолог учитывает опыт конкурентов.

Для этого он отслеживает описание и характеристики товаров, изображения, статьи и другую информацию, которая стимулирует покупателей.

Парсер автоматически сводит информацию по нескольким компаниям в один отчет

При сборе контактов и адресов компаний

Парсер удобен, если надо собрать сведения по организациям из одной отрасли. За несколько минут он сводит статистику по фирмам в один документ

Парсинг в Python за 10 минут!

При отслеживании объемов продаж

На некоторых сайтах публикуют данные по складским остаткам и маркетинговым исследованиям. Парсер собирает и систематизирует статистику

Если ваша цель систематизировать общедоступные данные для улучшения контента, экономии бюджета при продвижении и развитии бизнеса — использование парсера законно.

Ограничения по парсингу

Общедоступной информацией для решения личных или коммерческих задач может пользоваться любой человек. Ограничения распространяются на парсинг популярного авторского контента. Его можно парсить, но использовать без разрешения владельца — нельзя.

Нельзя также использовать собранные данные для спам-рассылок, плагиата, DDOS-атаки, взлома сайтов и распространения личных данных пользователей.

Это недобросовестные действия, которые нарушают закон, правила работы в поисковых системах и соцсетях. За них грозят штрафы, санкции и блокировка.

Если хотите на своем сайте собирать персональные данные, предупредите посетителей об этом.

Преимущества и недостатки парсинга

Автоматический сбор информации имеет несколько преимуществ:

- Самостоятельная работа. Специалист ставит задачу, а парсер находит и сортирует данные по указанным параметрам при наличии стабильного доступа к Интернету. Время работы не ограничено. Программа может собирать сведения 24 часа в сутки без перерывов.

- Анализ и систематизация. Специалист указывает один или несколько параметров, по которым парсер сводит сведения. Количество настроек не ограничено. Готовый отчет содержит только необходимый контент без спама, ошибок или нерелевантной информации.

- Отсутствие ошибок. При использовании парсера человеческий фактор исключен. Программа не устает и не допускает ошибки по невнимательности.

- Удобный отчет. Парсер формирует сведения в удобной форме. Пользователь настраивает форму отчета сам.

- Распределение нагрузки. Парсер учитывает требования по частоте обращений к сайту и минимизирует риск взлома чужого сайта. Вас не обвинят в умышленной DDOS-атаке.

Единственный существенный недостаток парсинга — невозможность сбора данных с ресурсов с запретом на автоматический сбор сведений.

Владелец чужого сайта может запретить собирать данные по IP-адресам, включить настройки блокировки для поисковых ботов. Во всех остальных случаях парсинг — это быстрый и надежный способ сбора информации.

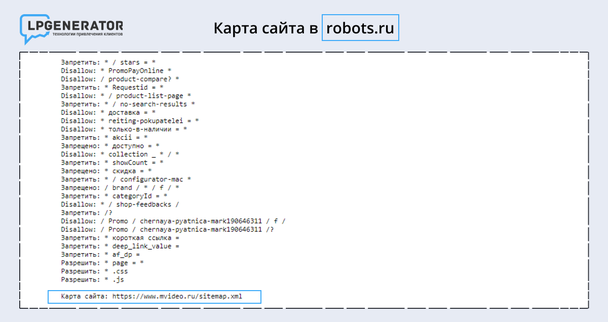

Если вы не хотите, чтобы конкуренты парсили ваш сайт, заблокируйте сторонние запросы через robots.txt или настройте капчу. Хотя эти способы не дают 100% защиты от парсинга конкурентов.

Обойти блокировку можно двумя способами:

- Настроить отображение бота по именем YandexBot, Googlebot и проверить отсутствие блокировки на эти имена в site.ru/robots.txt/IP.

- Включить VPN Капча для автоматического распознавания капчи.

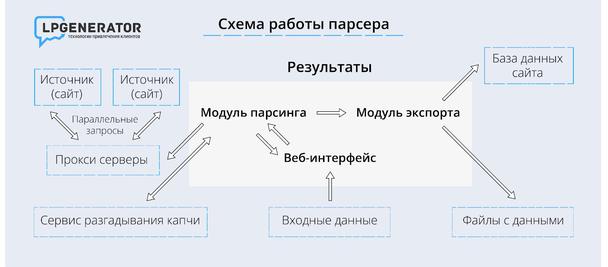

Как работает парсинг?

Принцип работы сервисов примерно одинаков:

Способы использования парсинга

Парсер используют в двух случаях:

Когда анализируют собственный сайт.

Когда изучают ресурсы конкурентных фирм, ищут тенденции и контент.

В чистом виде тот или иной способ используют редко. Для комплексной оценки ситуации специалисты совмещают оба метода.

Например, анализируя цены других компаний из отрасли, они учитывают диапазон цен заказчика. При наличии новинок они ищут аналогичные товары в собственной базе и сравнивают их между собой.

Как парсить цены?

Есть несколько сервисов, которые помогут решить корпоративные задачи:

- Screaming Frog SEO Spider.

- Mozenda.

- Automation Anywhere.

- Content Grabber.

- Netpeak Spider.

- FMiner и др.

Если ни одна из программ не решает поставленной задачи, вы можете написать парсер самостоятельно при помощь любого языка программирования: PHP, C++, Python.

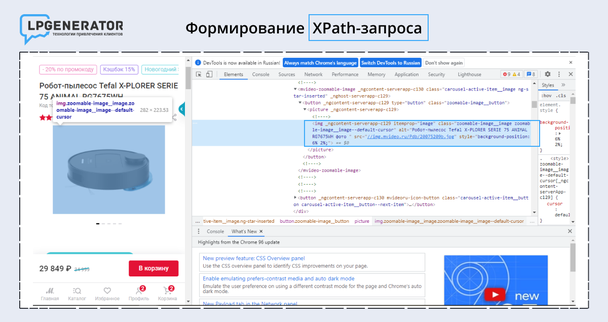

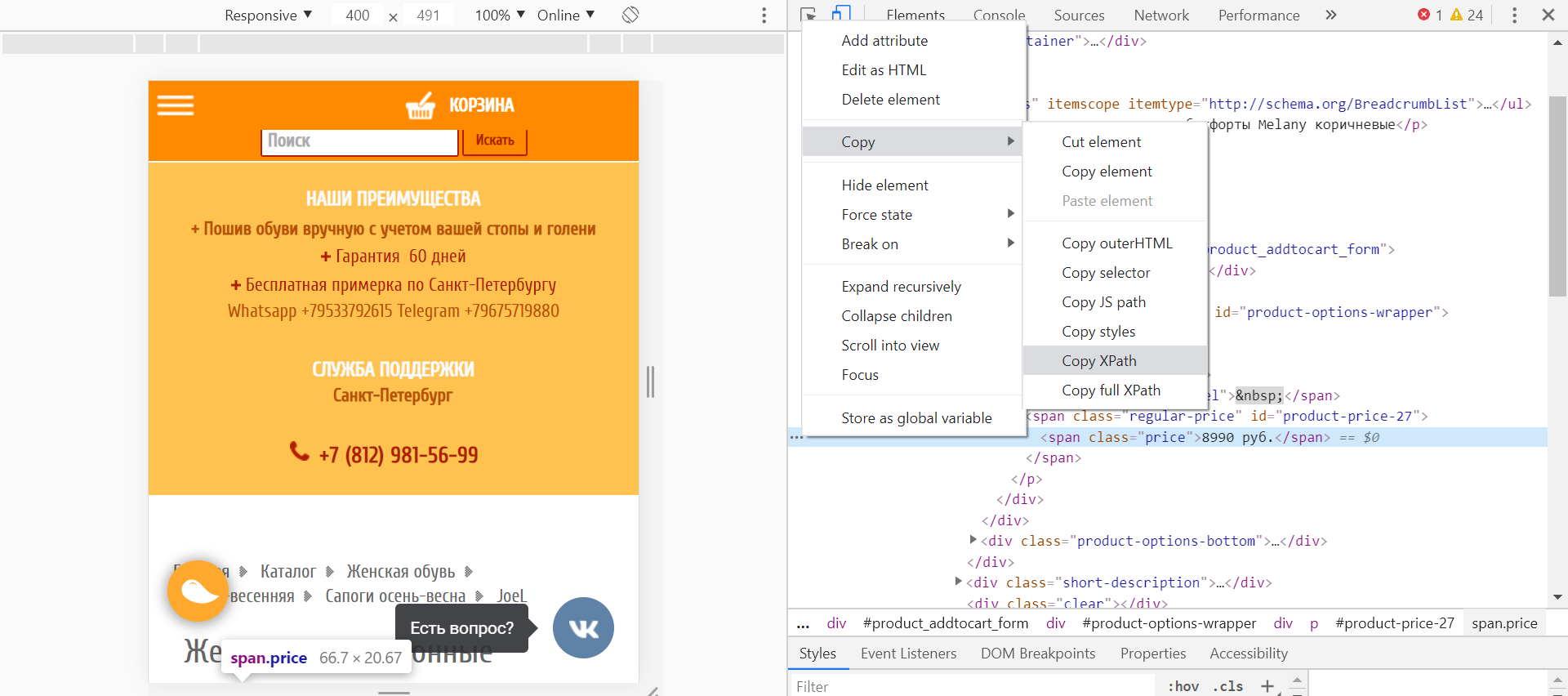

Если парсер нужен для одного параметра на странице, используйте XPath — язык, позволяющий парсить XML-документы. Разберем, как работает XPath на конкретном примере.

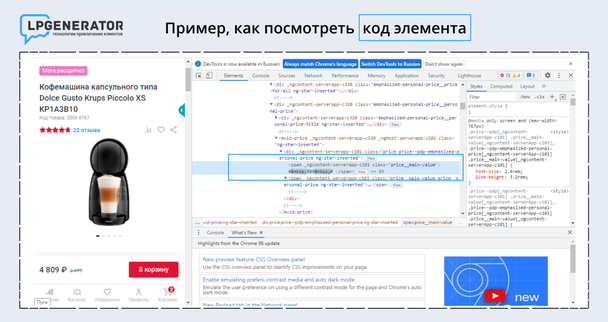

Шаг 1. Выбираем объект парсинга

Например, нужно собрать цены продуктов из каталога конкурента. Перейдите на нужную страницу, правой кнопкой нажмите на цифру с ценой и выберите «Посмотреть код элемента».

Теперь правой кнопкой мыши нажмите на → Copy → XPath. Вы скопировали строку из HTML-кода, где написана необходимая информация, и определили границы будущего парсинга.

Если на другой странице верстка будет другой, копирование XPath не поможет. Парсер не соберет нужную информацию. В таком случае используйте справочники по языку XPath. В них собраны участки кода xpath.

Когда кусочек кода выделен, выбирайте парсер, например Screaming Frog. Он бесплатно анализирует 500 страниц: проверяет пустые title, дубликаты, заголовки, незаполненные метатеги и битые ссылки. Для парсинга нужна платная версия.

Откройте программу и укажите параметры настройки:

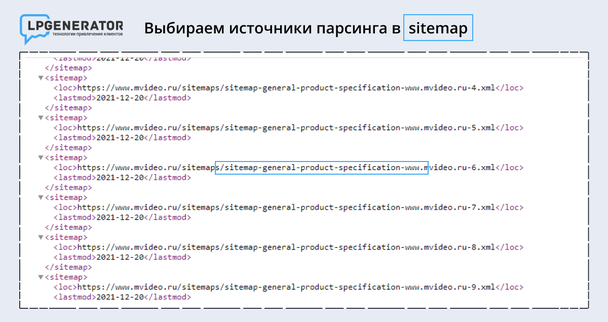

Шаг 2. Выбираем источники

Теперь выберите страницы, с которых нужно собирать данные. Если вставить ссылку на главную страницу сайта в Screaming Frog, в выборку попадут информационные страницы без цен. Для сокращения времени, необходимого на парсинг, выберите конкретный перечень страниц, по которым программа сделает выборку.

Перейдите в карту сайта — «адрес сайта/sitemap.xml» или в robots.txt — site.ru/robots.txt и выберите товарные карточки.

Если карты сайта нет, систематизировать данные не получится. Запускайте парсинг в стандартном режиме по всем страницам сайта. Программа соберет нужные сведения, но потратит больше времени.

Выбирайте страницы, касающиеся товаров, с надписью — Product.

Ссылочную массу выгружайте в раздел Mode → List → Upload → Download Sitemap. Введите гиперссылку с картой сайта, в которой сгруппированы товарные позиции и нажмите ОК. Парсер формирует выборку и выводит на экран.

Раздел Internal отражает данные по всем параметрам:

- код ответа;

- возможность индексации;

- title, description и т. д.

Для просмотра цен нажмите на стрелку в правом верхнем углу. В выпадающем меню выберите Custom → Filter → Extraction. Парсер покажет перечень страниц с товарами и цены на них. Для выгрузки данных нажмите Export.

Чтобы к списку добавить названия товаров, перейдите в Configuration → Custom → Extraction, вставьте дополнительный XPath-запрос, а затем повторно запустите парсер. Проверяйте, как пишется нужный элемент html-кода в справочнике или в sitemap.xml.

Парсить информацию таким образом можно почти с любого сайта, кроме защищенных ресурсов. Например, скопировать данные из Яндекс.Маркета не выйдет.

Как парсить фото и иллюстрации?

Крупные интернет-магазины размещают на сайте фото от поставщиков. Они универсальные и могут использоваться в любом каталоге.

Специалисты собирают в таблицы ссылки на картинки из разных карточек, чтобы позже выбрать нужный файл и загрузить на свой сайт.

Большинство систем для управления сайтов, например Bitrix или Shop-Script, разрешают прикреплять ссылки вместо загрузки фото. Через эти движки можно выгружать изображения прямо из CSV-файла.

Чтобы запустить парсинг картинок, выделите код и сформулируйте XPath-запрос:

1. Правой кнопкой мыши нажмите на фотографию и выберите «Посмотреть код объекта».

2. Найдите строку кода и выделите в элементе нужный тег.

Таким способом можно спарсить одну фотографию или весь каталог:

- Для добавления одного изображения скопируйте ссылку и вставьте ее в парсер Upload → Paste.

- Чтобы скопировать ссылки по всем фотографиям, опубликованным на ресурсе, выберите вкладку Mode → Spider, введите ссылку на сайте и запустите программу.

Конкретизировать страницы при сборе фотографий не надо. Парсер пропустит разделы, в которых нет иллюстраций.

Если собранные фотографии нужно идентифицировать по артикулу или названию, добавьте еще один XPath-запрос. Специалисты часто собирают связку: наименование товара под метатегом Н1, артикул, иллюстрация.

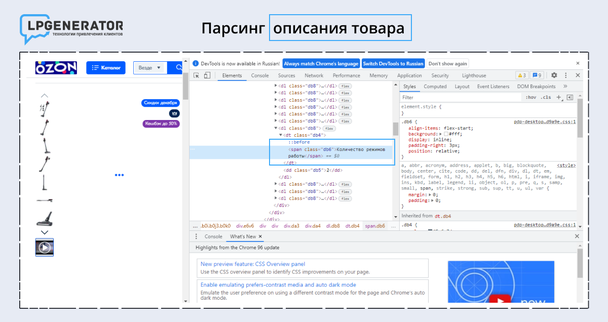

Как парсить описание товаров?

Перед покупкой покупатели читают информацию о продукте. Чем больше характеристик указывает продавец, тем выше шанс, что клиент оформит заказ.

Собирать данные вручную долго и сложно. Автоматизировать процесс и свести данные в Excel-таблицу также помогает парсер.

Последовательность действий та же:

- Нажмите правой кнопкой мыши на название характеристики, которую хотите выделить. Например, «количество режимов работы» у робота-пылесоса.

- Выберите «Посмотреть код объекта» и найдите строку с HTML-кодом.

В данном случае описание находится под тегом . Технические характеристики и описания к ним указаны внутри элемента .

Программа соберет все параметры, указанные под тегом . Например, в количестве режимов отразится характеристика «2».

Заключение

Парсинг — это удобный способ получения информации для развития бизнеса. Он автоматизирует и ускоряет сбор данных, снимает часть нагрузки со специалиста и минимизирует ошибки.

Источник: lpgenerator.ru

Что такое парсинг и как правильно парсить

Что такое парсинг данных должен знать каждый владелец сайта, планирующий серьёзно развиваться в бизнесе. Это явление настолько распространено, что рано или поздно с парсингом может столкнуться любой. Либо как заказчик данной операции, либо как лицо, владеющее объектом для сбора информации, то есть ресурсом в Интернете.

К парсингу в российской бизнес-среде часто наблюдается негативное отношение. По принципу: если это не незаконно, то уж точно аморально. На самом деле из его грамотного и тактичного использования каждая компания может извлечь немало преимуществ.

Оптимизируйте маркетинг и увеличивайте продажи вместе с Calltouch

Digital шагает семимильными шагами. Еще недавно компании и клиенты радовались первым сайтам, а сегодня загрузка страницы за 10 секунд вызывает дикое раздражение. Пройдите тест и узнайте, какие невероятные технологии уже стали реальностью, а какие пока остаются мечтой.

Что такое парсинг

Глагол “to parse” в дословном переводе не означает ничего плохого. Делать грамматический разбор или структурировать — действия полезные и нужные. На языке всех, кто работает с данными на сайтах это слово имеет свой оттенок. Парсить — собирать и систематизировать информацию, размещенную на определенных сайтах, с помощью специальных программ, автоматизирующих процесс.

Если вы когда-либо задавались вопросом, что такое парсер сайта, то вот он ответ. Это программные продукты, основной функцией которых является получение необходимых данных, соответствующих заданным параметрам.

Законно ли использовать парсинг

- взлом сайта (то есть получение данных личных кабинетов пользователей и т. п.);

- DDOS- атаки (если на сайт в результате парсинга данных ложится слишком высокая нагрузка);

- заимствование авторского контента (фотографии с копирайтами, уникальные тексты, подлинность которых заверена у нотариуса и т. п. лучше оставить на их законном месте).

Парсинг законен, если он касается сбора информации, находящейся в открытом доступе. То есть всего, что можно и так собрать вручную.

Парсеры просто позволяют ускорить процесс и избежать ошибок из-за человеческого фактора. Поэтому «незаконности» в процесс они не добавляют.

Другое дело, как владелец свежесобранной базы распорядится подобной информацией. Ответственность может наступить именно за последующие действия.

Маркетинг

Онлайн-марафон, который нельзя пропустить: 4 шага к интернет-маркетингу уровня PRO

Онлайн-марафон, который нельзя пропустить: 4 шага к интернет-маркетингу уровня PRO

Для чего нужен парсинг

Что такое парсить сайт разобрались. Переходим к тому, зачем же это может понадобиться. Здесь открывается широкий простор для действий.

Основная проблема современного Интернета — избыток информации, которую человек не в состоянии систематизировать вручную.

| Для чего нужен парсинг | Польза |

| Анализа ценовой политики | Чтобы понять среднюю стоимость тех или иных товаров на рынке, удобно использовать данные по конкурентам. Однако если это сотни и тысячи позиций, собрать их вручную оперативно невозможно. |

| Отслеживания изменений | Парсинг можно осуществлять на регулярной основе, например, каждую неделю, выявляя на что повысились цены в среднем по рынку и какие новинки появились у конкурентов. |

| Наведения порядка на своём сайте | Да, так тоже можно. И даже нужно, если в интернет-магазине несколько тысяч товаров. Найти несуществующие страницы, дубли, неполное описание, отсутствие определенных характеристик или несоответствие данных по складским остаткам тому, что отображается на сайте. С парсером быстрее. |

| Наполнения карточек товаров в интернет-магазине | Если сайт новый, счёт обычно идёт даже не на сотни. Вручную на это уйдёт непозволительно количество времени. Часто используют парсинг с иностранных сайтов, переводят полученные тексты автоматизированным методом, после чего получают практически готовые описания. Иногда то же проделывают с русскоязычными сайтами, а полученные тексты изменяют с помощью синонимайзера, но за это можно получить санкции от поисковых систем. |

| Получения баз потенциальных клиентов | Существует парсинг, связанный с составлением, например, списка лиц, принимающих решения, в той или иной отрасли и городе. Для этого может применяться личный кабинет на сайтах поиска работы с доступом к актуальным и архивным резюме. Этичность дальнейшего использования подобной базы каждая компания определяет самостоятельно. |

Сквозная аналитика — это тоже своеобразный парсинг, только рекламы и продаж. Система интегрируется с площадками и CRM, а потом автоматически соединяет данные о бюджетах, кликах, сделках и подсчитывает окупаемость каждой кампании. Используйте ее, чтобы не потеряться в большом количестве информации и видеть в отчетах то, что вам действительно нужно. Отчеты Calltouch легко кастомизировать под себя и задачи команды маркетологов.

Сквозная аналитика Calltouch

- Анализируйте воронку продаж от показов до денег в кассе

- Автоматический сбор данных, удобные отчеты и бесплатные интеграции

Достоинства парсинга

Они многочисленны. По сравнению с человеком парсеры могут:

- собирать данные быстрее и в любом режиме, хоть круглосуточно;

- следовать всем заданным параметрам, даже очень тонким;

- избегать ошибок от невнимательности или усталости;

- выполнять регулярную проверку по заданному интервалу (каждую неделю и т. п.);

- представить собранные данные в любом необходимом формате без лишних усилий;

- равномерно распределять нагрузку на сайт, где проходит парсинг (обычно одна страница за 1-2 секунды), чтобы не создавать эффект DDOS- атаки.

Ограничения при парсинге

Есть несколько вариантов ограничений, которые могут затруднить работу парсера:

- По user-agent. Это запрос, в котором программа сообщает сайту о себе. Парсеры банят многие веб-ресурсы. Однако в настройках данные можно изменить на YandexBot или Googlebot и отсылать правильные запросы.

- По robots.txt, в котором прописан запрет для индексации поисковыми роботами Яндекса или Google (ими мы представились сайту выше) определенных страниц. Необходимо задать в настройках программы игнорирование robots.txt.

- По IP- адресу, если с него в течение долгого времени поступают на сайт однотипные запросы. Решение — использовать VPN.

- По капче. Если действия похожи на автоматические, выводится капча. Научить парсеры распознавать конкретные виды достаточно сложно и дорогостояще.

Бесплатно Электронная книга

23 действующих способа сделать свой маркетинг круче, быстрее, эффективнее, чем сейчас

Какую информацию можно парсить

Спарсить можно всё, что есть на сайте в открытом доступе. Чаще всего требуются:

- наименования и категории товаров;

- основные характеристики;

- цена;

- информация об акциях и новинках;

- тексты описания товаров для их последующего переделывания «под себя» и т. п.

Изображения с сайтов технически спарсить тоже можно, но, как уже упоминалось выше, если они защищены авторским правом, лучше не нужно. Нельзя собирать с чужих сайтов личные данные их пользователей, которые те вводили в личных кабинетах.

Парсинг часто используется в индустрии e-commerce. Оценить влияние парсинга и его результатов можно в сквозной аналитике для интернет-магазинов. Вам доступны отчеты по любым временным срезам, метрикам и товарам. С помощью этих данных вы узнаете, из каких источников вы получаете добавления в корзины и продажи, и сможете оптимизировать рекламу с опорой на эти данные.

Аналитика для интернет-магазина

- Отслеживайте корзины, звонки, заявки и продажи с них с привязкой к источнику

- Постройте воронку продаж и оптимизируйте маркетинг

Алгоритм работы парсинга

Принцип действия программы зависит от целей. Но схематично он выглядит так:

- Парсер ищет на указанных сайтах или по всему Интернету данные, соответствующие параметрам.

- Информация собирается и производится первоначальная систематизация (её глубина также определяется при настройке);

- Из данных формируется отчёт в формате, соответствующем требуемым критериям. Большинство современных парсеров мультиформатны и могут успешно работать хоть с PDF, хоть с архивами RAR, хоть с TXT.

Способы применения

Основных способов применения парсинга существует два:

- анализировать свой сайт, внося в него необходимые улучшения;

- анализировать сайты конкурентов, заимствуя оттуда основные тенденции и конкретные характеристики товаров.

Обычно оба варианта работают в тесной связке друг с другом. Например, анализ ценовых позиций у конкурентов отталкивается от имеющегося диапазона на собственном сайте, а обнаруженные новинки сопоставляются с собственной товарной базой и т. п.

Предложения от наших партнеров

Online CRM для автосервиса

До 3-х месяцев CRM-системы для автосервисов

Бесплатная часовая сессия с ведущим маркетологом

Хостинг-провайдер и аккредитованный регистратор доменных имён

Скидка до 80% на пакет услуг «Быстрый старт» для создания сайта

Технический аудит вашего сайта за 50 рублей

Агенство по разработке сайтов

Бесплатная помощь в формировании концепции вашего сайта

Сервис мониторинга и оптимизации интернет-рекламы

Три дня бесплатного пользования сервисом

Как парсить данные

Для парсинга данных можно выбрать один из двух форматов:

- воспользоваться специальными программами, которых на рынке существует немало;

- написать их самостоятельно. Для этого может применяться практически любой язык программирования, например, PHP , C++, P ython/

Если требуется не вся информация по странице, а только что-то определенное (наименования товаров, характеристики, цена), используется XPath.

XPath – это язык, на котором формируются запросы к XML- документам и их отдельным элементам.

С помощью его команд необходимо определить границы будущего парсинга, то есть задать как парсить данные с сайта — полностью или выборочно.

Чтобы определить XPath конкретного элемента необходимо:

- Перейти на страницу любого товара на анализируемом сайте.

- Выделить цену и щелкнуть по выделению правой кнопкой мыши.

- В открывшемся окне выбрать пункт «Посмотреть код».

- После появления с правой стороны экрана кода, нажать на три точки с левой стороны от выделенной строки.

- В меню выбрать пункт “Copy”, затем “Copy XPath”.

Пример определения XPath элемента на сайте интернет-магазина обуви Holtz

Как спарсить цену

Задаваясь вопросом «Парсинг товаров — что это?», многие подразумевают именно возможность провести ценовую разведку на сайтах конкурентов. Цены парсят чаще всего и действовать необходимо следующим образом. Скопированный в примере выше код ввести в программу-парсер, которая подтянет остальные данные на сайте, соответствующие ему.

Чтобы парсер не ходил по всем страницам и не пытался найти цены в статьях блога, лучше задать диапазон страниц. Для этого необходимо открыть карту XML (добавить “ /sitemap.xml ” в адресную строку сайта после названия). Здесь можно найти отсылки к разделам с ценами — обычно это товары ( products) и категории (categories ), хотя называться они могут и по-другому.

Маркетинг

Чем занимается таргетолог

Источник: www.calltouch.ru

8 инструментов для парсинга сайтов

Расширения для браузеров, облачные сервисы и библиотеки.

Google выдает пользователю релевантные ссылки благодаря мониторингу сети и парсингу сайтов. Программы парсинга используют не только для поиска близких к запросу ссылок, но и для сбора данных.

Рассказываем, как просканировать интернет и какое ПО вам понадобится.

Как устроен парсинг сайтов

Это автоматический сбор и систематизация информации с помощью ПО. Парсеры применяют, работая с большими объемами информации, которые сложно отсортировать вручную.

Парсингом сайтов часто занимаются роботы поисковиков. Инструмент также используют для анализа ценовой политики на сайтах-конкурентах и наполнения своих онлайн-ресурсов. Например, парсят сайты спортивной аналитики, чтобы обновлять информацию о ходе матчей, или мониторят комментарии в социальных сетях. Кроме того, платформы, которые отслеживают информацию о компаниях, применяют парсеры, чтобы автоматически добавлять новые сведения из госреестров.

Возможен и самопарсинг — поиск багов на своем сайте (продублированных или несуществующих страниц, а также неполных описаний продуктов).

Как противодействуют парсингу

Парсить и потом использовать можно только те данные, которые не защищены авторским правом или содержатся в открытых источниках. Иногда владельцы сайтов устанавливают защиту — за большую нагрузку на серверы нужно платить, а слишком интенсивный парсинг может вызвать DoS-атаку.

Способы защиты:

#1. Временная задержка между запросами (ограничивает доступ к информации для программы-парсера).

#2. Защита от роботов (установка капчи, подтверждение регистрации).

#3. Ограничения прав доступа.

#4. Блокировка IP-адресов.

#5. Honeypot — ссылки на пустые файлы или эмуляторы сервера, которые используют для обнаружения взломщиков или парсеров.

Как обойти защиту

Основная проблема парсера в том, что сайт видит признаки нетипичного поведения и блокирует доступ. Пользователи не открывают тысячи страниц за минуты. Поэтому задача парсера — выдать себя за обычного пользователя. Один из этапов — применение эмуляторов пользовательских инструментов. Они отправляют серверу HTTP-запросы с заголовком User Agent, то есть таким же, как у обычного пользователя.

Другой способ защиты — встроенный фрагмент JavaScript. Запуск фрагмента с браузера произойдет успешно, но при парсинге код HTML-страницы будет нечитаемым. Платформа node.js, которая позволяет запускать JS вне браузера, решает проблему.

Еще один вариант — использовать «безголовый» браузер. Это программа, которая копирует функции обычного браузера, но не имеет графического интерфейса. Она использует программное управление и может работать в фоновом режиме.

При большом количестве запросов с одного IP-адреса сайт может потребовать верификацию с помощью капчи. Некоторые из них можно расшифровать оптическим распознаванием символов, но лучше менять IP. Для этого используют прокси-серверы, которые запрашивают информацию с разных адресов.

XPath — язык запросов для доступа к частям документа XML, который используют для поиска элементов с определенным атрибутом. C его помощью реализуют навигацию в DOM (Document Object Model) — программном интерфейсе, который содержит информацию о структуре сайта, HTML и XML-документах.

Программы для парсинга

Расширения для браузера

Веб-приложения используют для простых задач. Такие расширения есть в каждом браузере. Они удобны для анализа маленького объема данных (до нескольких страниц).

Этот инструмент используют для извлечения данных из таблиц или информации со страницы в форматах XLS, CSV и TSV. Платный доступ добавляет новые функции. Например, API и анонимные IP.

Стоимость: бесплатно при просмотре до 500 страниц.

курсы по теме:

Расширение предназначено для импорта данных с сайтов. Есть возможность кликнуть на элемент страницы и выбрать все элементы такого типа на сайте.

В Scraper.AI доступна функция регулярного мониторинга изменений на веб-странице. Собранная информация экспортируется в форматы JSON, CSV и XLSX.

Стоимость: бесплатно первые 3 месяца, пакеты — от $49 до $249 в месяц.

Облачные сервисы

По сравнению с расширениями, у этих программ больше функций. Работа проходит в «облаке» через веб-интерфейс или API, а на компьютере сохраняются только результаты.

Этот сервис применяют для парсинга сайтов с высокой степенью защиты. Его использование требует навыков программирования.

Программа самостоятельно повторяет неуспешные запросы и обрабатывает капчу. А также приложение может визуализировать элементы, которые требуют рендеринга Javascript. Scraper API работает с Python, Ruby и PHP.

Стоимость: 1 тыс. бесплатных запросов API, пакеты от $29 до $249 в месяц.

Он использует ML-алгоритмы и computer vision при парсинге, а также работает с API и может автоматически определить тип URL-адресов. Diffbot регулярно парсит сеть и сохраняет результаты. Компания строит самый большой граф знаний — она соединяет факты о созданных продуктах, новостных событиях, результатах отчетов. Узнать больше о Diffbot можно здесь.

Стоимость: бесплатно первые 14 дней, пакеты Start и Plus — $299 и $899 в месяц.

Десктопные программы

Большинство десктоп-парсеров работают с Windows, но на macOS их можно запустить с виртуальных машин. Есть и кроссплатформенные решения.

Десктопные парсеры могут быть эффективнее облачных. Минус в том, что они используют операционную мощность компьютера.

Программа позволяет интегрировать и визуализировать собранные данные с помощью BI-системы Tableau. Поддерживает графический интерфейс обработки данных point-and-click. У ParseHub есть функция запланированного сбора датасета в установленный интервал времени. Сервис работает с Windows, Mac и Linux. Доступен в облачной и десктопной версии.

Стоимость: бесплатно при обработке до 200 страниц, пакеты Standard и Professional — $149 и $499 в месяц.

Библиотеки для создания собственного парсера

Библиотека на Java, которую используют для парсинга и автоматизации запросов в формате JSON. Это формат обмена данных в веб-приложениях, например, для отправки информации с сервера клиенту и отображения на сайте. Jaunt работает как браузер без графического интерфейса, что ускоряет его. В Jaunt обрабатывают выборочные HTTP-запросы и ответы, а еще есть доступ в DOM.

Стоимость: бесплатно

Библиотека для Python с открытым кодом. Фреймворк используют для парсинга. Особенность Scrapy — обработка запросов в асинхронном порядке: можно задавать команду, не дожидаясь завершения предыдущей. Также следующие запросы будут выполняться, даже если в обработке одного из них возникла ошибка.

В библиотеке можно установить паузу между запросами, а также регулировать число запросов с одного IP или домена.

Стоимость: бесплатно

Тоже библиотека на языке Python, но более простая. Обычно фреймворк используют для данных из HTML- и XML-документов. Чтобы открывать ссылки и сохранять собранные результаты, к Beautiful Soup необходимо подключить дополнительные библиотеки.

Стоимость: бесплатно

Источник: robotdreams.cc

Что такое парсинг и как он работает

Практически в каждой отрасли, будь то программирование, написание статьи или математические расчёты, есть свой определённый, общепринятый шаблон, по которому идёт проверка и сравнение данных. Если мы говорим о работе со строковыми данными – таким инструментом является парсинг. Подробнее что это такое и как работает, мы сейчас расскажем.

Что такое парсинг простыми словами

Чтобы было понятнее, объясним понятие парсинг простыми словами, приведя пример. Итак, из анонса мы уже выяснили, что парсинг – это процесс сопоставления и проверки строковых данных с определённым шаблоном, или правилами.

Например: наверное многие знают азбуку Морзе, и даже у некоторых был этот легендарный аппарат, с помощью которого передавались сообщения в зашифрованном коде, представленном в виде точки «.» и тире «-». Чтобы расшифровать послание: «самые перспективные стартапы 2019 года» к примеру, или целый текст, нужно было сверить поданные знаки с алфавитом, где каждая комбинация этих двух атрибутов имела свою букву.

Принцип работы парсинга точно такой же. Есть конкретный шаблон сообщения, который написан на каком-либо языке. В соответствии с ним сравнивается строка или конкретный символ. Применение парсинга не ограничивается программированием. В аналитике или любой другой области, где можно работать с данными в строковом формате, он так же активно применяется.

Парсинг аудитории: что это

Парсинг аудитории — это сбор различных данный о пользователях соц. сетей по определённой системе, так сказать, алгоритму. Парсеры, то есть специальные программы или же сами специалисты, которые имеют некоторое отношение к таргетологам помогают оперативно найти, а затем выгрузить собранную информацию в соответствующий рекламный кабинет.

Допустим, подписчиков каких-либо сообществ чаще всего парсят по следующим параметрам: администраторы, модераторы или редакторы сообществ (групп), пользователей, которые активно, то есть ежедневно или даже по нескольку раз на дню, посещают группу, ставят лайки и оставляют комментарии под постами, подписчики групп с аналогичной тематикой и т.п. Такой метод позволяет эффективно запарсить «нужную» аудиторию пользователей, которым может быть интересно ваше предложение о снижении стоимости услуг на SEO-продвижение с большей вероятностью, чем если показывать рекламу «всем подряд». Если говорить о, так называемой, «жёсткой» настройке, когда база подбирается по очень чётким критериям, где важно всё для мелочей: как статус стоит у человека на личной страничке в соц. сети или его семейное положение, так же жанр музыки, который он слушает. Таким образом сокращается не только бюджет рекламной кампании, но и повышается вероятность превращения пользователей из «холодных» клиентов в «горячих».

Парсинг товаров: что это такое

Парсинг товаров – это система в виде программы или алгоритма, на основании которой собираются нужная информация о продукции уже из заранее подготовленного списка магазинов в интернете — заказчиков.  Как правило, парсинг товаров их используют при заполнении интернет-магазина информации и детальном анализе ценовой политики конкурентов. Если не применять такую систему как парсинг для поискового продвижения сайтов в Яндексе, придётся самостоятельно посещать каждый из огромного списка предложенный поисковиком сайтов в Интернете. Затем, вручную собирать информацию с этих ресурсов, систематизировать и с помощью тщательной сортировки, находить необходимые. Благо, всем этим занимается парсер. Если Вы-владелец крупного интернет-магазинов, для Ваших работников это будет ничем другим, как спасением от рутиной и муторной работы, а если брать в расчёт более мощные и профессиональные инструменты, то парсинг будет не только быстрым, но и более качественным.

Как правило, парсинг товаров их используют при заполнении интернет-магазина информации и детальном анализе ценовой политики конкурентов. Если не применять такую систему как парсинг для поискового продвижения сайтов в Яндексе, придётся самостоятельно посещать каждый из огромного списка предложенный поисковиком сайтов в Интернете. Затем, вручную собирать информацию с этих ресурсов, систематизировать и с помощью тщательной сортировки, находить необходимые. Благо, всем этим занимается парсер. Если Вы-владелец крупного интернет-магазинов, для Ваших работников это будет ничем другим, как спасением от рутиной и муторной работы, а если брать в расчёт более мощные и профессиональные инструменты, то парсинг будет не только быстрым, но и более качественным.  С помощью программ-парсеров можно одновременно обрабатывать большие объёмы данных товаров, что является одним из основных преимуществ, благодаря которому можно закрыть глаза на все недостатки. Алгоритм работы парсера товаров очень прост, что даёт возможность в его использовании специалисту любого уровня знаний, это:

С помощью программ-парсеров можно одновременно обрабатывать большие объёмы данных товаров, что является одним из основных преимуществ, благодаря которому можно закрыть глаза на все недостатки. Алгоритм работы парсера товаров очень прост, что даёт возможность в его использовании специалисту любого уровня знаний, это:

- Загрузка каталога товаров, которым необходимо добавить описание и фотографию;

- Автоматический Поиск по составленному списку;

- И, наконец, выгрузка данных о товарах на сайт заказчика.

Что такое парсинг в ВКонтакте

Итак, что нужно знать о парсинге в социальных сетях, а именно в ВКонтакте. Один из ключевых моментов такого вида парсинга, а именно то, что должен знать каждый директолог, это то, что в соц.сети открыт API, и у SMM-специалистов и таргетологов увеличивается спектр возможностей для разработки приложений и различных сервисов деятельности во ВКонтакте.

Парсинг во ВК — это инструменты ретаргетинга для парсинга ВКонтакте является одной из самых полезных привилегий. Эти сервисы тщательно, зачастую, в автономном режиме после настройки собирают списки аудитории. Эту базу пользователей, как правило, позже загружают в рекламный кабинет социальной сети и настраивают рекламу.

Если уж мы заговорили о парсинге в социальных сетях, будет полезным упомнять и парсинг в Инстаграм, а именно что это и для чего он нужен.

Программы-парсеры для Instagram так же занимаются сборкой подписчиков или аудитории аккаунта, то есть тех пользователей, которым интересна та или иная страница, и они выражают это в регулярных и много численных лайках или комментариях. Ни для кого не секрет, что такой бизнес-инструмент как чат-бот это делает не хуже самого парсера.

Практика показывает, что порой ошибочно предполгают, что если для Instagram есть специально разработанные парсеры, то от их работы мало что зависит и можно настраивать рекламу на базу аудитории, взятую из ВКонтакте.

Это глубокое заблуждение и вот почему: в Instagram базы подходят лишь для, так называемого, «серого» продвижения, в структуру которого входит масслукинг и массфоловинг. Такая база пользователей используется, чаще всего, в качестве исполнения каких-либо необходимых действий, например лайков, репостов, просмотров сторис.

Таким образом, программа-парсер – очень полезный и важный сервис для именно для запуска рекламных компаний. Парсер можно разработать самостоятельно или заказать на бирже фриланса, оплатив заказ через электронные кошельки, что позволит не только сэкономить, но и ускорить процесс оплаты.

Как правило, парсер заказывают те владельцы сайтов, которым для настройки рекламы нужны конкретные условия для поиска и чтения баз данных и пользователей. Так же есть специальные порталы, где уже загружены готовые программы на платной основе.

Источник: pro-promotion.ru