Чтобы поддерживать информацию на своем ресурсе в актуальном состоянии, наполнять каталог товарами и структурировать контент, необходимо тратить кучу времени и сил. Но есть утилиты, которые позволяют заметно сократить затраты и автоматизировать все процедуры, связанные с поиском материалов и экспортом их в нужном формате. Эта процедура называется парсингом.

Давайте разберемся, что такое парсер и как он работает.

Что такое парсинг?

Начнем с определения. Парсинг – это метод индексирования информации с последующей конвертацией ее в иной формат или даже иной тип данных.

Парсинг позволяет взять файл в одном формате и преобразовать его данные в более удобоваримую форму, которую можно использовать в своих целях. К примеру, у вас может оказаться под рукой HTML-файл. С помощью парсинга информацию в нем можно трансформировать в «голый» текст и сделать понятной для человека. Или конвертировать в JSON и сделать понятной для приложения или скрипта.

№191 — Что такое ПАРСИНГ и как ЗАРАБОТАТЬ на парсинге сайтов? Делимся нашим опытом парсинга…

Но в нашем случае парсингу подойдет более узкое и точное определение. Назовем этот процесс методом обработки данных на веб-страницах. Он подразумевает анализ текста, вычленение оттуда необходимых материалов и их преобразование в подходящий вид (тот, что можно использовать в соответствии с поставленными целями). Благодаря парсингу можно находить на страницах небольшие клочки полезной информации и в автоматическом режиме их оттуда извлекать, чтобы потом переиспользовать.

Ну а что такое парсер? Из названия понятно, что речь идет об инструменте, выполняющем парсинг. Кажется, этого определения достаточно.

Комьюнити теперь в Телеграм

Подпишитесь и будьте в курсе последних IT-новостей

Какие задачи помогает решить парсер?

При желании парсер можно сподобить к поиску и извлечению любой информации с сайта, но есть ряд направлений, в которых такого рода инструменты используются чаще всего:

- Мониторинг цен. Например, для отслеживания изменения стоимости товаров у магазинов-конкурентов. Можно парсить цену, чтобы скорректировать ее на своем ресурсе или предложить клиентам скидку. Также парсер цен используется для актуализации стоимости товаров в соответствии с данными на сайтах поставщиков.

- Поиск товарных позиций. Полезная опция на тот случай, если сайт поставщика не дает возможности быстро и автоматически перенести базу данных с товарами. Можно самостоятельно «запарсить» информацию по нужным критериям и перенести ее на свой сайт. Не придется копировать данные о каждой товарной единице вручную.

- Извлечение метаданных. Специалисты по SEO-продвижению используют парсеры, чтобы скопировать у конкурентов содержимое тегов title, description и т.п. Парсинг ключевых слов – один из наиболее распространенных методов аудита чужого сайта. Он помогает быстро внести нужные изменения в SEO для ускоренного и максимально эффективного продвижения ресурса.

- Аудит ссылок. Парсеры иногда задействуют для поиска проблем на странице. Вебмастера настраивают их под поиск конкретных ошибок и запускают, чтобы в автоматическом режиме выявить все нерабочие страницы и ссылки.

Серый парсинг

Такой метод сбора информации не всегда допустим. Нет, «черных» и полностью запрещенных техник не существует, но для некоторых целей использование парсеров считается нечестным и неэтичным. Это касается копирования целых страниц и даже сайтов (когда вы парсите данные конкурентов и извлекаете сразу всю информацию с ресурса), а также агрессивного сбора контактов с площадок для размещения отзывов и картографических сервисов.

Про Парсинг. Что значит «Парсить»? Как работает Парсер?

Но дело не в парсинге как таковом, а в том, как вебмастера распоряжаются добытым контентом. Если вы буквально «украдете» чужой сайт и автоматически сделаете его копию, то у хозяев оригинального ресурса могут возникнуть вопросы, ведь авторское право никто не отменял. За это можно понести реальное наказание.

Добытые с помощью парсинга номера и адреса используют для спам-рассылок и звонков, что попадает под закон о персональных данных.

Где найти парсер?

Добыть утилиту для поиска и преобразования информации с сайтов можно четырьмя путями.

- Использование сил своей команды разработчиков. Когда в штате есть программисты, способные создать парсер, адаптированный под задачи компании, то искать другие варианты не стоит. Этот будет оптимальным вариантом.

- Нанять команду разработчиков со стороны, чтобы те создали утилиту по вашим требованиям. В таком случае уйдет много ресурсов на создание ТЗ и оплату работы.

- Установить готовое приложение-парсер на компьютер. Да, оно тоже будет стоить денег, но зато им можно воспользоваться сразу. А настройки параметров в таких программах позволяют точно настроить схему парсинга.

- Воспользоваться веб-сервисом или браузерным плагином с аналогичной функциональностью. Встречаются бесплатные версии.

При отсутствии разработчиков в штате я бы советовал именно десктопную программу. Это идеальный баланс между эффективностью и затратами. Но если задачи стоят не слишком сложные, то может хватить и облачного сервиса.

Плюсы парсинга

У автоматического сбора информации куча преимуществ (по сравнению с ручным методом):

- Программа работает самостоятельно. Не приходится тратить время на поиск и сортировку данных. К тому же собирает она информацию куда быстрее человека. Да еще и делает это 24 на 7, если понадобится.

- Парсеру можно «скормить» столько параметров, сколько потребуется, и идеально отстроить его для поиска только необходимого контента. Без мусора, ошибок и нерелеватной информации с неподходящих страниц.

- В отличие от человека, парсер не будет допускать глупых ошибок по невнимательности. И не устанет.

- Утилита для парсинга может подавать найденные данные в удобном формате по запросу пользователя.

- Парсеры умеют грамотно распределять нагрузку на сайт. Это значит, что он случайно не «уронит» чужой ресурс, а вас не обвинят в незаконной DDoS-атаке.

Так что нет никакого смысла «парсить» руками, когда можно доверить эту операцию подходящему ПО.

Минусы парсинга

Главный недостаток парсеров заключается в том, что ими не всегда удается воспользоваться. В частности, когда владельцы чужих сайтов запрещают автоматический сбор информации со страниц. Есть сразу несколько методов блокировки доступа со стороны парсеров: и по IP-адресам, и с помощью настроек для поисковых ботов. Все они достаточно эффективно защищают от парсинга.

В минусы метода можно отнести и то, что конкуренты тоже могут использовать его. Чтобы защитить сайт от парсинга, придется прибегнуть к одной из техник:

- либо заблокировать запросы со стороны, указав соотвествующие параметры в robots.txt;

- либо настроить капчу – обучить парсер разгадыванию картинок слишком затратно, никто не будет этим заниматься.

Но все методы защиты легко обходятся, поэтому, скорее всего, придется с этим явлением мириться.

Алгоритм работы парсера

Парсер работает следующим образом: он анализирует страницу на наличие контента, соответствующего заранее заданным параметрам, а потом извлекает его, превратив в систематизированные данные.

Процесс работы с утилитой для поиска и извлечения найденной информации выглядит так:

- Сначала пользователь указывает вводные данные для парсинга на сайте.

- Затем указывает список страниц или ресурсов, на которых нужно осуществить поиск.

- После этого программа в автоматическом режиме проводит глубокий анализ найденного контента и систематизирует его.

- В итоге пользователь получает отчет в заранее выбранном формате.

Естественно, процедура парсинга через специализированное ПО описана лишь в общих чертах. Для каждой утилиты она будет выглядеть по-разному. Также на процесс работы с парсером влияют цели, преследуемые пользователем.

Как пользоваться парсером?

На начальных этапах парсинг пригодится для анализа конкурентов и подбора информации, необходимой для собственного проекта. В дальнейшей перспективе парсеры используются для актуализации материалов и аудита страниц.

При работе с парсером весь процесс строится вокруг вводимых параметров для поиска и извлечения контента. В зависимости от того, с какой целью планируется парсинг, будут возникать тонкости в определении вводных. Придется подгонять настройки поиска под конкретную задачу.

Иногда я буду упоминать названия облачных или десктопных парсеров, но использовать именно их необязательно. Краткие инструкции в этом параграфе подойдут практически под любой программный парсер.

Парсинг интернет-магазина

Это наиболее частый сценарий использования утилит для автоматического сбора данных. В этом направлении обычно решаются сразу две задачи:

- актуализация информации о цене той или иной товарной единицы,

- парсинг каталога товаров с сайтов поставщиков или конкурентов.

В первом случае стоит воспользоваться утилитой Marketparser. Указать в ней код продукта и позволить самой собрать необходимую информацию с предложенных сайтов. Большая часть процесса будет протекать на автомате без вмешательства пользователя. Чтобы увеличить эффективность анализа информации, лучше сократить область поиска цен только страницами товаров (можно сузить поиск до определенной группы товаров).

Во втором случае нужно разыскать код товара и указать его в программе-парсере. Упростить задачу помогают специальные приложения. Например, Catalogloader – парсер, специально созданный для автоматического сбора данных о товарах в интернет-магазинах.

Парсинг других частей сайта

Принцип поиска других данных практически не отличается от парсинга цен или адресов. Для начала нужно открыть утилиту для сбора информации, ввести туда код нужных элементов и запустить парсинг.

Разница заключается в первичной настройке. При вводе параметров для поиска надо указать программе, что рендеринг осуществляется с использованием JavaScript. Это необходимо, к примеру, для анализа статей или комментариев, которые появляются на экране только при прокрутке страницы. Парсер попытается сымитировать эту деятельность при включении настройки.

Также парсинг используют для сбора данных о структуре сайта. Благодаря элементам breadcrumbs, можно выяснить, как устроены ресурсы конкурентов. Это помогает новичкам при организации информации на собственном проекте.

Обзор лучших парсеров

Далее рассмотрим наиболее популярные и востребованные приложения для сканирования сайтов и извлечения из них необходимых данных.

В виде облачных сервисов

Под облачными парсерами подразумеваются веб-сайты и приложения, в которых пользователь вводит инструкции для поиска определенной информации. Оттуда эти инструкции попадают на сервер к компаниям, предлагающим услуги парсинга. Затем на том же ресурсе отображается найденная информация.

Преимущество этого облака заключается в отсутствии необходимости устанавливать дополнительное программное обеспечение на компьютер. А еще у них зачастую есть API, позволяющее настроить поведение парсера под свои нужды. Но настроек все равно заметно меньше, чем при работе с полноценным приложением-парсером для ПК.

Наиболее популярные облачные парсеры

- Import.io – востребованный набор инструментов для поиска информации на ресурсах. Позволяет парсить неограниченное количество страниц, поддерживает все популярные форматы вывода данных и автоматически создает удобную структуру для восприятия добытой информации.

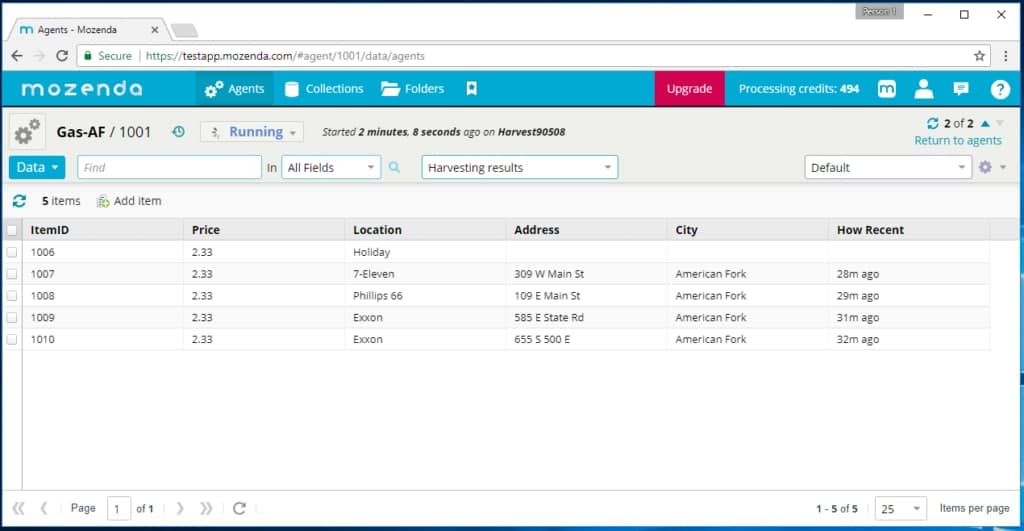

- Mozenda – сайт для сбора информации с сайтов, которому доверяют крупные компании в духе Tesla. Собирает любые типы данных и конвертирует в необходимый формат (будь то JSON или XML). Первые 30 дней можно пользоваться бесплатно.

- Octoparse – парсер, главным преимуществом которого считается простота. Чтобы его освоить, не придется изучать программирование и хоть какое-то время тратить на работу с кодом. Можно получить необходимую информацию в пару кликов.

- ParseHub – один из немногих полностью бесплатных и довольно продвинутых парсеров.

Похожих сервисов в сети много. Причем как платных, так и бесплатных. Но вышеперечисленные используются чаще остальных.

В виде компьютерных приложений

Есть и десктопные версии. Большая их часть работает только на Windows. То есть для запуска на macOS или Linux придется воспользоваться средствами виртуализации. Либо загрузить виртуальную машину с Windows (актуально в случае с операционной системой Apple), либо установить утилиту в духе Wine (актуально в случае с любым дистрибутивом Linux). Правда, из-за этого для сбора данных потребуется более мощный компьютер.

Наиболее популярные десктопные парсеры

- ParserOK – приложение, сфокусированное на различных типах парсинга данных. Есть настройки для сбора данных о стоимости товаров, настройки для автоматической компиляции каталогов с товарами, номеров, адресов электронной почты и т.п.

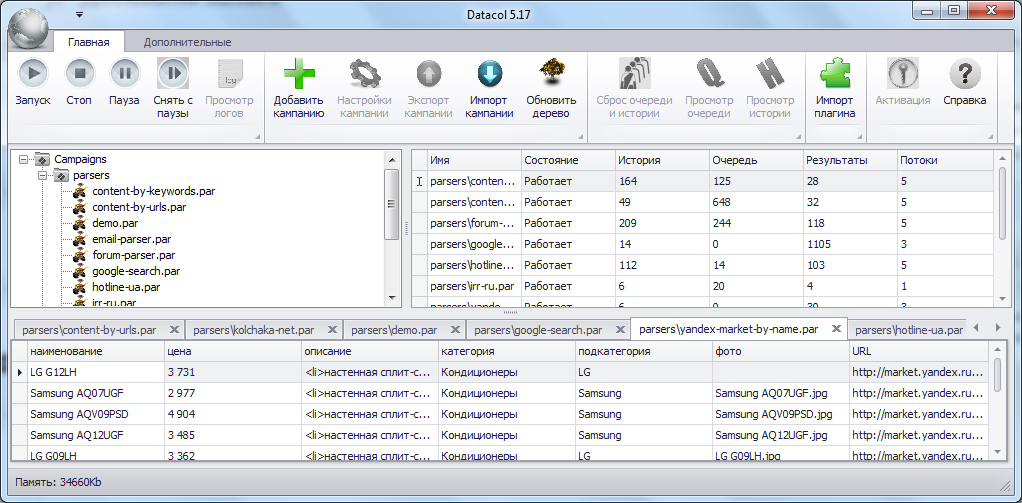

- Datacol – универсальный парсер, который, по словам разработчиков, может заменить решения конкурентов в 99% случаев. А еще он прост в освоении.

- Screaming Frog – мощный инструмент для SEO-cпециалистов, позволяющий собрать кучу полезных данных и провести аудит ресурса (найти сломанные ссылки, структуру данных и т.п.). Можно анализировать до 500 ссылок бесплатно.

- Netspeak Spider – еще один популярный продукт, осуществляющий автоматический парсинг сайтов и помогающий проводить SEO-аудит.

Это наиболее востребованные утилиты для парсинга. У каждого из них есть демо-версия для проверки возможностей до приобретения. Бесплатные решения заметно хуже по качеству и часто уступают даже облачным сервисам.

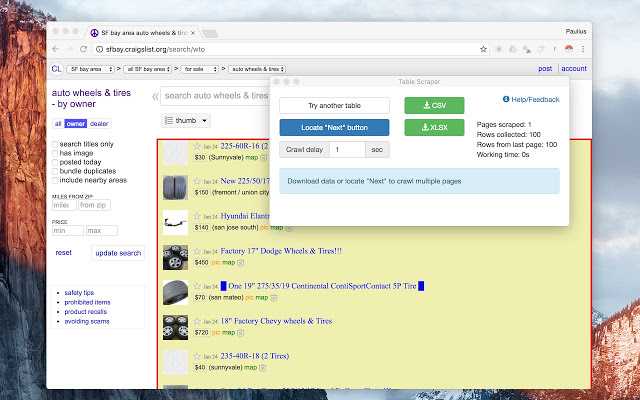

В виде браузерных расширений

Это самый удобный вариант, но при этом наименее функциональный. Расширения хороши тем, что позволяют начать парсинг прямо из браузера, находясь на странице, откуда надо вытащить данные. Не приходится вводить часть параметров вручную.

Но дополнения к браузерам не имеют таких возможностей, как десктопные приложения. Ввиду отсутствия тех же ресурсов, что могут использовать программы для ПК, расширения не могут собирать такие огромные объемы данных.

Но для быстрого анализа данных и экспорта небольшого количества информации в XML такие дополнения подойдут.

Наиболее популярные расширения-парсеры

- Parsers – плагин для извлечения HTML-данных с веб-страниц и импорта их в формат XML или JSON. Расширение запускается на одной странице, автоматически разыскивает похожие страницы и собирает с них аналогичные данные.

- Scraper – собирает информацию в автоматическом режиме, но ограничивает количество собираемых данных.

- Data Scraper – дополнение, в автоматическом режиме собирающее данные со страницы и экспортирующее их в Excel-таблицу. До 500 веб-страниц можно отсканировать бесплатно. За большее количество придется ежемесячно платить.

- kimono – расширение, превращающее любую страницу в структурированное API для извлечения необходимых данных.

Вместо заключения

На этом и закончим статью про парсинг и способы его реализации. Этого должно быть достаточно, чтобы начать работу с парсерами и собрать информацию, необходимую для развития вашего проекта.

Источник: timeweb.com

Парсинг — что это такое простыми словами. Как работает парсинг и парсеры, и какие типы парсеров бывают (подробный обзор +видео)

Парсинг – что это такое простыми словами? Если коротко, то это сбор информации по разным критериям из интернета, в автоматическом режиме. В процессе работы парсера сравнивается заданный образец и найденная информация, которая в дальнейшем будет структурирована.

В качестве примера можно привести англо-русский словарь. У нас есть исходное слово «parsing». Мы открываем словарь, находим его. И в качестве результата получаем перевод слова «разбор» или «анализ». Ну, а теперь давайте разберем эту тему поподробнее

- Парсинг: что это такое простыми словами

- Что такое парсер и как он работает

- Какие функции выполняют парсеры? Что с их помощью можно парсить?

- Пример парсера для Инстаграм

- Еще пару парсеров для примера

- Заключение

Парсинг: что это такое простыми словами

Парсинг — это процесс автоматического сбора информации по заданным нами критериям. Для лучшего понимания давайте разберем пример:

Пример того, что такое парсинг:

Представьте, что у нас есть интернет-магазин поставщика, который позволяет работать по схеме дропшиппинга и мы хотим скопировать информацию о товарах из этого магазина, а потом разместить ее на нашем сайте/интернет магазине (под информацией я подразумеваю: название товара, ссылку на товар, цену товара, изображение товара). Как мы можем собрать эту информацию?

Первый вариант сбора — делать все вручную:

То есть, мы вручную проходим по всем страницам сайта с которого хотим собрать информацию и вручную копируем всю эту информацию в таблицу для дальнейшего размещения на нашем сайте. Думаю понятно, что этот способ сбора информации может быть удобен, когда нужно собрать 10-50 товаров. Ну, а что делать, когда информацию нужно собрать о 500-1000 товаров? В этом случае лучше подойдет второй вариант.

Второй вариант — спарсить всю информацию разом:

Мы используем специальную программу или сервис (о них я буду говорить ниже) и в автоматическом режиме скачиваем всю информацию в готовую Excel таблицу. Такой способ подразумевает огромную экономию времени и позволяет не заниматься рутинной работой.

Причем, сбор информации из интернет-магазина я взял лишь для примера. С помощью парсеров можно собирать любую информацию к которой у нас есть доступ.

Грубо говоря парсинг позволяет автоматизировать сбор любой информации по заданным нами критериям. Думаю понятно, что использовать ручной способ сбора информации малоэффективно (особенно в наше время, когда информации слишком много).

Для наглядности хочу сразу показать главные преимущества парсинга:

- Преимущество №1 — Скорость.

За одну единицу времени автомат может выдавать в разы больше деталей или в нашем случае информации, чем, если бы мы с лупой в руках отыскивали ее на страницах сайта. Поэтому компьютерные технологии в обработке информации превосходят ручной сбор данных.

- Преимущество №2 — Структура или «скелет» будущего отчета.

Мы собираем лишь те данные, которые заинтересованы получить. Это может быть что угодно. Например, цифры (цена, количество), картинки, текстовое описание, электронные адреса, ФИО, никнеймы, ссылки и прочее. Нам нужно только заранее обдумать, какую информацию мы хотим получить.

- Преимущество №3 — Подходящий вид отчета.

Мы получаем итоговый файл с массивом данных в требуемом формате (XLSX, CSV, XML, JSON) и можем даже сразу использовать его, вставив в нужное место на своем сайте.

Если говорить о наличие минусов, то это, разумеется, отсутствие у полученных данных уникальности. Прежде всего, это относится к контенту, мы ведь собираем все из открытых источников и парсер не уникализирует собранную информацию.

Думаю, что с понятием парсинга мы разобрались, теперь давайте разберемся со специальными программами и сервисами для парсинга.

Что такое парсер и как он работает

Парсер – это некое программное обеспечение или алгоритм с определенной последовательностью действий, цель работы которого получить заданную информацию.

Сбор информации происходит в 3 этапа:

- Сканирование

- Выделение заданных параметров

- Составление отчета

Чаще всего парсер — это платная или бесплатная программа или сервис, созданный под ваши требования или выбранный вами для определенных целей. Подобных программ и сервисов очень много. Чаще всего языком написания является Python или PHP.

Но также есть и отдельные программы, которые позволяют писать парсеры. Например я пользуюсь программой ZennoPoster и пишу парсеры в ней — она позволяет собирать парсер как конструктор, но работать он будет по тому же принципу, что и платные/бесплатные сервисы парсинга.

Для примера можете посмотреть это видео в котором я показываю, как я создавал парсер для сбора информации с сервиса spravker.ru.

Чтобы было понятнее, давайте разберем каких типов и видов бывают парсеры:

- По способу доступа к вэб-ресурсу. Парсер может устанавливаться на компьютер или не устанавливаться (облачное решение);

- По используемой технологии. Программы, написанные на одном из языков программирования или это расширения для браузера, формулы в Google таблицах или надстройки в Excel;

- По назначению. Проверка оптимизации собственного ресурса, анализ данных пользователей и сообществ в социальных сетях, мониторинг конкурентов, сбор данных в определенной рыночной нише, анализ цен и товаров, необходимых для заполнения каталога интернет-магазина;

Не следует забывать о том, что парсинг имеет определенные минусы. Недостатком использования считаются технические сложности, которые парсер может создать. Так, подключения к сайту создают нагрузку на сервер. Каждое подключение программы фиксируется. Если подключаться часто, то сайт может вас заблокировать по IP (но это легко можно обойти с помощью прокси).

Какие функции выполняют парсеры? Что с их помощью можно парсить?

Для того чтобы понять, для чего нужен парсинг, что это такое простыми словами, давайте рассмотрим области применения. Для сбора какой непосредственно информации нужно писать или покупать специальную программу?

Итак, я выделил следующие задачи для парсера (на самом деле их куда больше):

- Парсер для нахождения описаний товаров и цен.

В первую очередь, речь идет об интернет-магазинах, которые при помощи специальных программ собирают, например, описания и характеристики товаров. Затем это сразу же устанавливают на свой сайт. В данном случае это возможность быстро заполнить карточки товаров исходными данными (техническими характеристиками, описанием, ценами). Учитывая, что количество товаров может исчисляться сотнями и тысячами позиций, другого, более быстрого способа, пока нет. Нужно сразу понимать, что такие описания будут, не уникальными.

- Парсер и публикатор для автозаполнения сайтов.

Специально созданные парсеры с определенной частотой «проходят» по вэб-ресурсам из заданного списка. Если на них появились новые статьи, то они сразу перекопируются на свой ресурс.

- Для получения личных данных.

Собирают личные данные, например, участников каких-то социальных групп на определенных ресурсах, посетителей сайтов, интернет-магазинов. Это имена, фамилии, электронные адреса, телефоны, возраст, пол. Словом, все то, что можно использовать, для определения целевой аудитории – разных групп людей, объединенных по какому-то одному или нескольким признакам.

В основном подобные парсеры используют для двух целей:

1. Корректно настроить таргетированную рекламу в соцсетях;

2. Собрать личные данные (почты, номера телефонов) для рассылки спама (я кстати тоже в свое время этим грешил. Я уже писал о таком способе привлечения клиентов в этой статье).

- Парсеры для обновления ленты новостей.

Новостные интернет-ресурсы содержат много динамической информации, которая меняется очень быстро. Автоматическое отслеживание погоды, ситуации на дорогах, курса валют поручают парсеру.

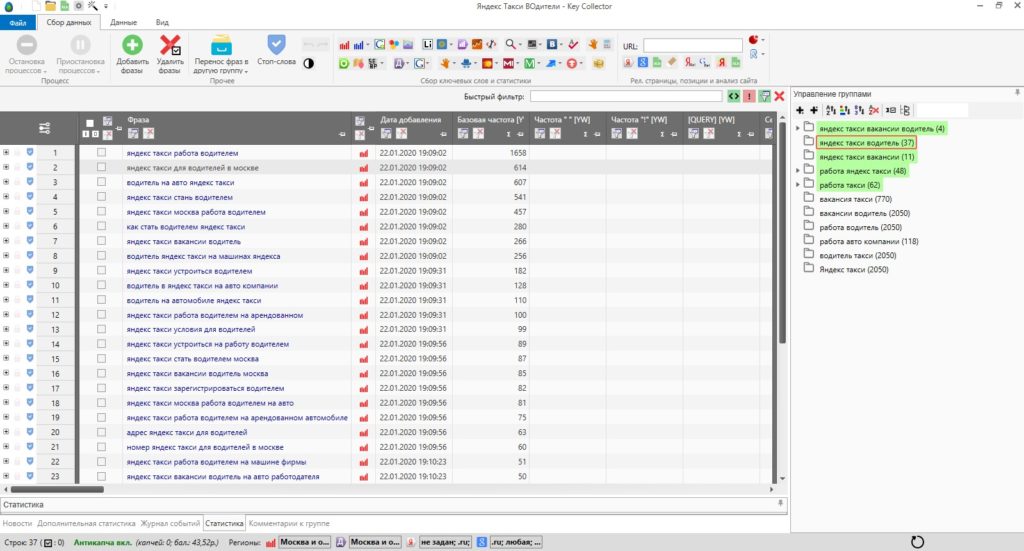

- Для составления семантического ядра.

В этом случае программа ищет ключевые слова (запросы), относящиеся к заданной теме, определяет их частотность. Затем собранные ключевые слова объединяют в классы (кластеризация запросов). В дальнейшем на основе семантического ядра (СЯ) пишутся статьи, способствующие продвижению вашего ресурса в поисковой выдачи

Я очень часто использую такой парсер, называется он Key Collector. Если кому интересно, сбор ключевых слов для продвижения сайта выглядит так:

- Парсер для аудита сайта

Программа-парсер находит заголовки и подзаголовки страниц, вплоть до 5-6 уровня, описания, изображения с их свойствами и другие данные, которые «возвращает» в виде необходимой таблицы. Такой анализ помогает проверить сайт на соответствие требованиям поисковых систем (такая проверка напрямую связана с продвижением ресурса в интернете, ведь чем лучше настроен сайт, тем больше у него шансов занять верхние строчки в поисковой выдаче)

Пример парсера для Инстаграм

Очень часто вижу запросы «пример парсера для инстаграм» или «пример парсера для социальных сетей», поэтому давайте разберемся что значит парсер для социальных сетей, групп и аккаунтов?

Если проще, то парсер для соц сетей — это помощник, который способствует продвижению товаров и услуг. То есть, такой парсер позволяет собрать данные пользователей, которые они указывают в своих аккаунтах или группах/пабликах (ну и прочую инфу) и в дальнейшем выборочно показывать им рекламу.

У Instagram как раз есть есть своя молодая, активная и платежеспособная аудитория, на которую хотят повлиять рекламодатели, поэтому давайте чуть подробнее остановимся на этой соц сети.

Чтобы было проще, давайте разберем от чего зависит успешное продвижения продукта в Инстаграм:

- Правильного подбора целевой аудитории (цель найти тех, кого можно заинтересовать нашим товаром);

- Ранжирования (сортировка) публикаций в ленте пользователей (с тем, чтобы владелец аккаунта увидел наше предложение или рекламу)

- Возможности нахождения записи в поиске (пользователь попадает на наше предложение при собственном поиске, используя определенные слова, словосочетания, называемые хэштегами)

Для того, чтобы успешно продвинуть продукт используется парсер, который поможет собрать информацию о пользователях Instagram. Нам понадобиться собрать следующую информацию:

- Личные данные (в данном случае это абсолютно легально, так как пользователи сами указывают, например, свои телефоны в профиле);

- Населенный пункт, в котором они проживают;

- Хэштеги, которыми они отмечают собственные записи;

- Аккаунты, на которые они подписаны;

- Публикации на которые пользователи ставят лайки.

- И подобное…

На основании этих данных вы можете провести определенную работу с пользователями, которая будет способствовать повышению ваших продаж. Вы пользователям «даете» нужные товары, которые они возможно искали, и получаете свой доход.

Целевую аудиторию для продвижения собственного товара собирают по 3 направлениям:

- По конкурентам. Скорее всего, подписчики вашего прямого конкурента, кроме ботов, фейковых и коммерческих аккаунтов, также заинтересованы и в вашем товаре.

- По хэштегам. Вам нужны публикации, отмеченные большим количеством лайков и комментариев и при этом помеченные одним или несколькими тематическими словами или сочетаниями (хэштегами), относящимися к вашему товарному предложению. Собрав в один список пользователей, поставивших этим публикациям лайки или оставивших комментарии, вы получите еще одну целевую аудиторию.

- По населенному пункту. Такой парсинг заинтересует прежде тех, кто продвигает товар в конкретных городах/населенных пунктах. В этом случае парсер соберет пользователей, которые размещали публикации с геометками.

Для парсинга в Инстаграме используют самописные и специальные программы, а также онлайн-сервисы. Причем некоторые из них не только собирают информацию, но еще и совершают определенные действия – ставят лайки, массово подписываются на странички пользователей и др.

Среди парсеров для Instagram популярностью пользуются:

- Zengram

- Tooligram

- Instaplus.pro

- InstaParser

- Instaturbo

Еще пару парсеров для примера

Как я уже говорил — парсеров огромное количество и они созданы под разные сайты и задачи. Для примера разберем еще парочку парсеров, чтобы у вас сложилось полное понимание этой сферы.

К примеру есть парсер turboparser.ru — он считается одним из самых удобных парсеров, помогающих организаторам совместных покупок.