Парсинг сайтов: что это и как работает + 9 способов применения

Парсинг данных – современный способ автоматизации сбора и обработки информации из интернета. Для этого используются специальные программы – парсеры сайтов. Они собирают неструктурированную информацию, преобразуют ее и выдают в удобном виде.

Для чего нужен парсинг?

Не все понимают, что такое парсинг и для чего он необходим. Удобнее рассмотреть этот вопрос на примере. Если взять интернет-магазин в виде сайта или группы в соцсетях, то его неотъемлемой частью будут карточки товаров. Как их наполнить? Наиболее очевидный ответ – вручную, но это долго и нерационально.

С программой для парсинга Q-Parser все можно сделать в пару кликов. Это удобно и в том случае, когда в интернет-магазине продаются товары какого-нибудь бренда с официальным сайтом, на котором тысячи наименований.

Как перенести информацию на свой ресурс, если нет доступа к базе и ассортимент не может быть передан в электронном виде? Вручную здесь опять же уйдет много времени, что просто нерентабельно. Куда проще использовать программу парсера сайтов, которая позволит быстро получить базу и занести ее в свой каталог. Причем парсить можно все, что угодно, даже изображения.

Парсер: что это такое и зачем он нужен | SEMANTICA

В общем случае, парсинг необходим:

- Для сбора и быстрого копирования информации с других сайтов.

- Для обновления данных и поддержания их актуальности.

- Для сбора, обработки и последующего размещения информации на своем ресурсе.

Как работает парсинг? Алгоритм работы парсера

Если рассматривать парсинг сайта на примере Q-Parser, то здесь целью является импорт данных о товарах:

- в собственные интернет-магазины;

- на сайты совместных покупок (СП);

- в группы в социальных сетях.

Таким образом, Q-Parser своей основной задачей ставит наполнение перечисленных ресурсов. С помощью парсера сайта можно выгрузить всю необходимую информацию о товаре:

- название,

- описание,

- фотографии,

- характеристики,

- стоимость и пр.

Алгоритм работы парсера данных Q-Parser очень простой. В общем виде он включает 3 этапа:

- Поиск нужных сведений в исходном виде.

- Извлечение данных с отделением от программного кода.

- Формирование отчета согласно требованиям, которые были заданы.

Для начала работы не нужно скачивать программы или настраивать расширения. Необходимо только зарегистрироваться, после чего запустить парсинг сайта из каталога, пройдя все шаги, которые предложит система для настройки загрузки категорий товаров.

Все остальное парсер данных сделает сам – вы даже можете выключить компьютер. Как только все будет готово, на вашу почту придет соответствующее уведомление.

Чем парсинг круче работы человека

Парсинг сайта – это монотонная и трудоемкая работа, которую и берет на себя специальная программа. Здесь важно отметить, что работа с сайтом или группой не ограничивается разовым наполнением. Чтобы сделать ресурс успешным и популярным, а затем поддерживать его на таком уровне, необходимо:

Парсинг в Python за 10 минут!

- Регулярно пополнять сайт новой информацией, а в случае с интернет-магазином – новыми товарами, что вручную сделать очень трудно из-за больших объемов.

- Постоянно обновлять уже имеющиеся данные, в том числе характеристики товаров, чтобы они соответствовали действительности. Здесь опять же приходится работать с большим объемом информации.

Это лишь 2 самые очевидные проблемы при наполнении сайта товарами. Не стоит забывать о том, что при ручном импорте ввиду большого количества данных высок риск сделать ошибку. А это значит, клиент получит недостоверную информацию, что повлияет на репутацию ресурса. Здесь на помощь и приходит парсер, который автоматизирует рутинную работу.

Таким образом, парсинг сайта с помощью Q-Parser однозначно лучше работы человека, поскольку позволяет:

- В считанные секунды изучать сайт для парсинга, выбранный в каталоге.

- Задать настройки перед загрузкой, если такое предусмотрено.

- Аккуратно выделить среди программного кода нужную информацию.

- Без ошибок выбрать и добавить категории для загрузки.

- Эффективно сохранить конечный результат и выгрузить товары в любой поддерживаемый формат или в соцсети.

Если сайта нет в списке, можно просто подать заявку на его настройку, и уже через 1-3 рабочих дня вы сможете оценить удобство работы с Q-Parser.

9 способов применения парсера

Автоматизация процесса выгрузки товаров – не единственное, в чем помогает парсер. С помощью парсинга данных возможно многое: от красивого оформления каталога до анализа конкурентов.

Способ №1 – осуществить ценовую «разведку»

Для этого достаточно выгрузить каталог интернет-магазина конкурентов. В нем будут все характеристики товаров, на основании которых легко произвести анализ ассортимента и стоимости. Все это позволяет сделать простой парсинг цен конкурентной площадки. На основании анализа вы сможете определить, какую стоимость установить для того или иного товара.

Способ №2 – выполнить «самопарсинг»

Используя каталог выгруженных товаров, можно найти дублирование или отсутствие иллюстраций, а также сравнить остатки на сайте со складскими остатками. Все это поможет в оптимизации работы интернет-магазина. Структурирование данных своего сайта также необходимо для последующей выгрузки на Яндекс-Маркет (YML). Это гораздо проще, чем заниматься подобным вручную.

Способ №3 – сделать удобным каталог

С помощью парсинга данных можно настроить спарсенные товары в соответствии со своими представлениями и сделать каталог максимально информативным:

- убрать категории товаров, которые уже не продаются;

- добавить описание к каждой позиции;

- убрать или заменить часть текста в описании;

- изменить стоимость и характеристики;

- наложить текст на фото товаров.

Способ №4 – представить спарсенные товары в нужном формате

Q-Parser предоставляет возможность парсить сайт и выгружать товары в 20 форматах, основные из которых:

- CSV – текстовый формат для представления табличных данных, используемый в большинстве интернет-магазинов.

- YML – формат, позволяющий затем размещать информацию в базе данных Яндекс.Маркета.

- XML – один из самых простых текстовых документов в формате, который предназначен для хранения данных.

- XLS/s – формат табличных файлов Excel, очень удобный для осуществления анализа данных.

Способ №5 – спарсить иностранный сайт

Q-Parser имеет функцию автоматического перевода всех наименований и описаний товаров. Если включить ее перед тем как спарсить сайт, то в итоге можно получить уже готовые карточки товаров с переводом, которые сразу можно выгружать в соцсети или интернет-магазин.

Способ №6 – спарсить новинки

В некоторых интернет-магазинах в отдельную категорию выделяют товары-новинки. Как правило, к ним наблюдается наиболее высокий интерес со стороны как постоянных, так и новых клиентов. Если такой раздел есть на сайте, то с помощью Q-Parser можно выполнить парсинг информации со страниц и понять, какие товары сейчас активно продаются у конкурентов.

Способ №7 – наполнить интернет-магазин новинками и увеличить продажи

Здесь опять же в помощь приходит возможность с помощью Q-Parser произвести парсинг страниц самых популярных интернет-магазинов, в частности, категории недавно появившихся новинок. Наполнив свой каталог самыми востребованными товарами, можно повысить интерес клиентов, количество покупок и, соответственно, прибыль.

Остается только определить наиболее выгодные цены товара. Для этого нужно провести анализ стоимости новинок у конкурентов, после чего скорректировать ее в своем каталоге. В Q-Parser есть удобная функция изменения цен у товаров, которая позволяет на определенный процент или число уменьшить/увеличить стоимость сразу у всех позиций, округлить сумму и даже сконвертировать валюту.

Способ №8 – скрытно парсить сайты

При необходимости сайт для парсинга может быть настроен без добавления в общий каталог. Здесь действуют те же гарантии и условия настройки, а работа парсера ничем не отличается от принципов для сайтов из каталога.

Обратите внимание, что Q-Parser никому не передает информацию о вас и о том, что вы парсите. Это является важным условием политики сервиса относительно передачи персональных данных. Распространением контактов занимаются только бесплатные парсеры, сотрудничество с которыми часто приводит к неприятным последствиям. С Q-Parser можно не переживать об этом и парсить любые нужные сайты.

Способ №9 – настроить автоматическую выгрузку по расписанию

С функцией автоматической выгрузки по расписанию вам не нужно думать, когда и как парсить сайт. Достаточно будет один раз настроить частоту запуска Q-Parser. Причем, если на сайте поставщика ничего не изменится, можно сделать так, чтобы выгрузка не запускалась. Настроить подобную функцию легко для любого парсинга, просто зайдя на страницу его результатов.

Источник: q-parser.ru

Что такое парсер и нюансы его использования

Каждый опытный пользователь Интернета и тем более владелец сайта просто обязан знать, что такое парсер. Этот инструмент помогает поддерживать в должном виде информацию на своем ресурсе и обрабатывать данные на сторонних веб-страницах.

Без использования подобной утилиты процессы поиска, структурирования и экспорта данных в необходимом формате отнимают значительное количество времени и сил. А это, учитывая современный темп жизни, является непозволительной роскошью.

Понятие парсинга данных

Парсинг представляет собой способ индексирования информации с ее дальнейшим преобразованием в другой формат, а в некоторых случаях даже другую разновидность данных.

Для примера возьмем HTML-файл. Парсинг позволит вам преобразовать информацию из этого файла в сплошной текст, тем самым сделав его читабельным. Другой вариант – трансформировать HTML в JSON для последующей работы в приложении или скрипте.

Однако в данной статье будет рассмотрена более узкая сфера применения парсинга – обработка данных на веб-страницах. Иными словами, парсинг предполагает сбор и систематизацию данных, которые находятся на сайте.

Теперь о том, что такое парсер сайта. Это специальная программа, осуществляющая сбор нужной информации по заранее установленным критериям.

При этом парсинг является легальным видом деятельности. Законодательством установлен запрет на следующие сходные манипуляции:

- взлом веб-сайта – несанкционированное получение информации из аккаунтов пользователей и др.;

- DDOS-атаки – когда парсинг перегружает сайт;

- плагиат – незаконное использование фотографий с копирайтом, оформленных у нотариуса оригинальных текстов и т.п.

Парсинг является правомерным в том случае, если он осуществляет сбор данных из открытых источников. Такую информацию можно набрать и собственноручно, поэтому парсеры лишь упрощают эти многочисленные действия и повышают скорость их выполнения. Кроме того, сводятся к минимуму оплошности, присущие работе человека. Таким образом, в чистом парсинге нет никаких противозаконных деяний.

Основные цели использования парсера

Какие задачи способен решить парсинг? Переизбыток информации, свойственный современному Интернету, настолько огромен, что человек уже не способен собственноручно обрабатывать ее. Существуют парсеры номеров, парсеры товаров и множество других вариантов, каждый из которых служит для определенных целей. Итак, парсинг предназначен для решения следующих основных задач:

- Анализ ценовой политики. Для определения средних значений стоимости какого-то товара нужно основываться на соответствующих показателях конкурентов. Но в некоторых случаях информации может быть слишком много для быстрого собственноручного сбора.

- Наблюдение за переменами. Парсинг позволяет непрестанно отслеживать (мониторить) изменение цен и появление новых товаров у конкурентов.

- Оптимизация сайта. Речь идет о нахождении несуществующих страниц, дублей, недостаточно полных описаний, выявлении отсутствия некоторых характеристик и многих других процессах, которые проще всего осуществлять с использованием парсинга. Особенно это актуально, если интернет-магазин включает в себя тысячи позиций.

- Наполнения карточек товаров. Наиболее показательным примером является новый сайт, на формирование информбазы которого может уйти крайне много времени. Зачастую применяют парсинг с заграничных сайтов, а собранные тексты автоматически переводятся на русский язык. В результате пользователь приобретает полноценные описания. В некоторых случаях под обработку попадают и русскоязычные веб-ресурсы, которые затем редактируются при помощи синонимайзеров. Однако это чревато негативными последствиями, исходящими от поисковых систем.

- Создание баз возможных клиентов. Например, парсинг может помочь в составлении списка людей, принимающих решения в определенной отрасли или месте. С этой целью могут использоваться личные кабинеты на платформах по поиску работы с доступом к актуальным и архивным резюме. Насколько это приемлемо с точки зрения нравственности – каждая фирма определяет для себя сама.

- Поиск технических ошибок. Благодаря парсерам можно осуществлять сбор данных о наличии страниц с ошибкой 404, редиректах, нерабочих и так называемых битых ссылках, и др.

- Сквозная аналитика. Парсинг рекламы и продаж. В этом случае система соединяется с площадками и CRM, а затем в автоматическом режиме объединяет информацию о бюджетах, кликах, сделках и осуществляет расчет окупаемости каждой фирмы.

Источник: gb.ru

Парсер что это простым языком, для чего нужен и как его сделать

Приветствую Вас на страницах блога: My-busines.ru. Сегодня мы рассмотрим популярный термин — один из способов автоматизации при работе с вебсайтами.

Парсеры — специализированные программы, способные исследовать контент в автоматическом режиме и обнаруживать необходимые фрагменты.

Под парсингом подразумевается действие, в ходе которого конкретный документ анализируется с точки зрения синтаксиса и лексики. Он преобразовывается; если в нем выявлены искомые сведения, они выбираются для последующего применения.

Для скорой обработки информации применяется парсинг. Так называют поочередную синтаксическую оценку данных, размещенных на интернет-страничках. Данный способ применяется для своевременного обрабатывания и копирования большого количества информации, если ручной труд требует много времени.

Для чего нужен

С целью создания веб-сайта и его эффективного продвижения необходимо огромное количество контента, который нужно длительно формировать в ручном порядке.

Парсеры имеют последующие возможности:

- Обновление данных для поддержки актуальности. Прослеживать перемены курса валют либо прогноза погоды в ручном порядке невозможно, по этой причине прибегают к парсингу;

- Сбор и мгновенное дублирование информации с иных веб-сайтов для размещения на своем ресурсе. Сведения, приобретенные с помощью парсинга, подвергают рерайтингу. Подобное решение применяется для наполнения киносайтов, новостных проектов, ресурсов с кулинарными рецептами и других площадок;

- Соединение потоков данных. Ведется получение значительного количества сведений с некоторых источников, обрабатывание и распределение. Это комфортно для наполнения новостных площадок;

- Парсинг значительно ускоряет ход работы с ключевыми словами. Настроив работу, допустимо немедленно выбрать требуемые для продвижения запросы. После кластеризации по страничкам подготавливается SEO-контент, в котором будет предусмотрено наибольшее количество ключей.

Какие бывают виды

Приобретение сведений в интернете – сложная, обыденная, забирающая большое количество времени деятельность. Парсеры могут в сутки рассортировать значительную долю веб-ресурсов в поисках необходимых сведений, автоматизируют её.

Более стремительно «парсят» всеобщую сеть роботы поисковых концепций. Однако, сведения накапливаются парсерами и в индивидуальных интересах. На её базе, н-р, возможно писать диссертацию. Парсинг применяют программы автоматичного контроля уникальности текстовый данных, стремительно сопоставляя содержимое сотен веб-страничек с предоставленным текстом.

Без схем парсинга обладателям интернет-магазинов, которым необходимы сотни монотипных изображений продуктов, технических данных и иного контента, было бы сложно ручным способом забивать характеристики продуктов.

Выделяют 2 более распространенных разновидности парсинга в интернете:

- парсинг контента;

- парсинг итого в экстрадации поисковых концепций.

Некоторые программы объединяют данные функции, плюс затягивают добавочные функции и полномочия.

Как сделать парсер

- Легче всего выполнить парсинг при помощи PHP функции file_get_contents(). Она дает возможность приобрести содержимое файла в варианте текстовой строчки . Функция применяет метод «memory mapping», что делает лучше её продуктивность.

- К примеру, чтобы составить script, который парсит сведения с веб-сайта ЦБ РФ, следует приобрести при помощи надлежащей функции содержимое XML-странички, заранее установив дату в соответствующем для веб-сайта формате, после чего при помощи регулярных формулировок разделить её.

- Если необходимо парсить конкретно сам файл XML, то для этого имеются еще надлежащие функции. Для основы парсера следует его инициализировать при помощи xml_parser_create:$parser = xml_parser_create();

- Потому оказывается реестр функций, которые будут редактировать надлежащие теги и текстовые данные. Формируются соответственные обработчики основы и окончания компонента XML:xml_set_element_handler($parser, “startElement”, “endElement”);

- Считывать сведения возможно при помощи стандартной функции fopen() и fgets() в рамках подходящего цикла. Содержимое файлов отдается построчно в xml_parse().

- Для снятия занимаемых концепцией ресурсов применяется функция xml_parser_free(). Эти функции считаются наиболее эффективными при обрабатывании XML файлов.

Какие программы использовать

Рассмотрим некоторые наилучшие легкодоступные программы парсинга:

- Import.io — предлагает разработчику свободно создавать личные пакеты данных: необходимо лишь импортировать данные с конкретной интернет-странички и экспортировать её в CSV. Возможно получать тысячи веб-страничек за считанные минутки, не прописав ни строчки кода, формировать тысячи API в соответствии с вашими условиями.

- Webhose.io -веб-приложение для браузера, применяющее свою технологию парсинга сведений, дающее возможность обрабатывать очень много информации из многих источников с одним API. Webhose предоставляет безвозмездный тарифный план за обрабатывание 1000 запросов в месяц.

- Scrapinghub — преобразовывает интернет-странички в подготовленный контент. Коллектив экспертов гарантирует персональный доступ к клиентам, гарантирует создать определение для каждого оригинального эпизода. Базовая безвозмездная программа предоставляет допуск к 1 поисковому роботу, бонусный пакет приносит 4 одинаковых поисковых ботов.

- ParseHub — существует обособленно от веб-приложения в виде проекта для рабочего стола. Проект предоставляет безвозмездно 5 проверочных поисковых программ.

- Spinn3r — дает возможность парсить сведения из блогов, соцсетей… Spinn3r содержит «обновляемый» API, совершающий 95 % функций по индексированию. Настоящая программка подразумевает улучшенную защиту от “мусора”, усиленная степень защищенности сведений. Механизм регулярно сканирует сеть, отыскивает обновления необходимых сведений из большого количества источников, юзер постоянно имеет обновляемые сведения. Панель администрирования дает возможность распоряжаться ходом обследования.

Что такое парсер сайтов

Эта концепция функционирует по установленной программе, сравнивает конкретную комбинацию слов, с тем, что обнаружилось в интернете. Как действовать с приобретенными сведениями, прописано в командной строчке, именуемой «регулярное выражение». Она складывается из знаков, организовывает принцип поиска.

Парсер сайтов осуществляет службу в ряд этапов:

- Поиск необходимых данных в исходном варианте: приобретение допуска к коду интернет-ресурса, загрузка, скачивание.

- Получение функций из кода интернет-странички, выделяя при этом необходимый материал от программного шифра странички.

- Формирование отчета в соответствии с условиями, которые были установлены (запись данных непосредственно в базы данных, текстовые файлы).

Источник: my-busines.ru

Что такое парсер (parsing)и как пользоваться?

Парсер (parsing) это программа или скрипт, которое собирает данные с сайтов в нужном формате. Парсеры не запрещены законом. Ими пользуются маркетологи и таргетологи, чтобы сократить расходы на рекламу создавая целевую аудиторию.

С помощью парсеров можно решить много задач в автоматическом режиме.

- Цены. Актуальная задача для интернет-магазинов. Например, с помощью парсинга вы можете регулярно отслеживать цены конкурентов по тем товарам, которые продаются у вас. Или актуализировать цены на своем сайте в соответствии с ценами поставщика (если у него есть свой сайт).

- Товарные позиции: названия, артикулы, описания, характеристики и фото. Например, если у вашего поставщика есть сайт с каталогом, но нет выгрузки для вашего магазина, вы можете спарсить все нужные позиции, а не добавлять их вручную. Это экономит время и нервы

- Метаданные: SEO-специалисты могут парсить содержимое тегов title, description и другие метаданные.

- Анализ сайта. Так можно быстро находить страницы с ошибкой 404, редиректы, неработающие ссылки и т. д.

Если в компании есть программист, а лучше два они вполне могут сделать парсер для цели компании и получать неограниченные данные с сайтов. Отслеживать конкурентов, парсить ключевики и контент сайтов и конечно данные клиентов.

Если вы занимаетесь бизнесом, то наверняка вам поступали предложения по поводу рекламы вашего сайта/товара/услуги (и внимание!) по базе 2-3мил., человек. Это 100% напарсено и смысла давать по такой базе рекламу нет. Потеря денег. Такие базы называют серыми. Туда попадают аккаунты ботов, детей, фиктивные и устаревшие e-mail и телефоны, то есть 99,9% абсолютно не нужной информации, которая скорее вредит, а не помогает.

Это похоже, как если бы вы стояли на улице и затаскивали к себе всех, кто проходит и стоит рядом. Считая машины, животных и деревья. Много пользы от такой базы?

И вот тут встает вопрос: чем нам может помочь parsing? А вот чем: просто нужно уметь им пользоваться.

Как пользоваться парсером?

Давайте рассмотрим конкретный пример на одной из функций парсера Pepper.Ninja

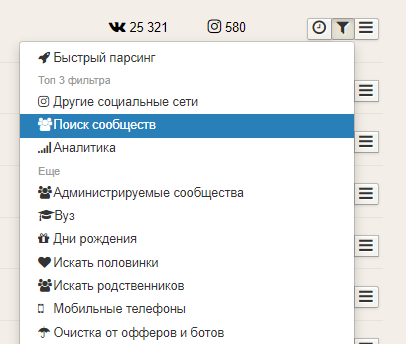

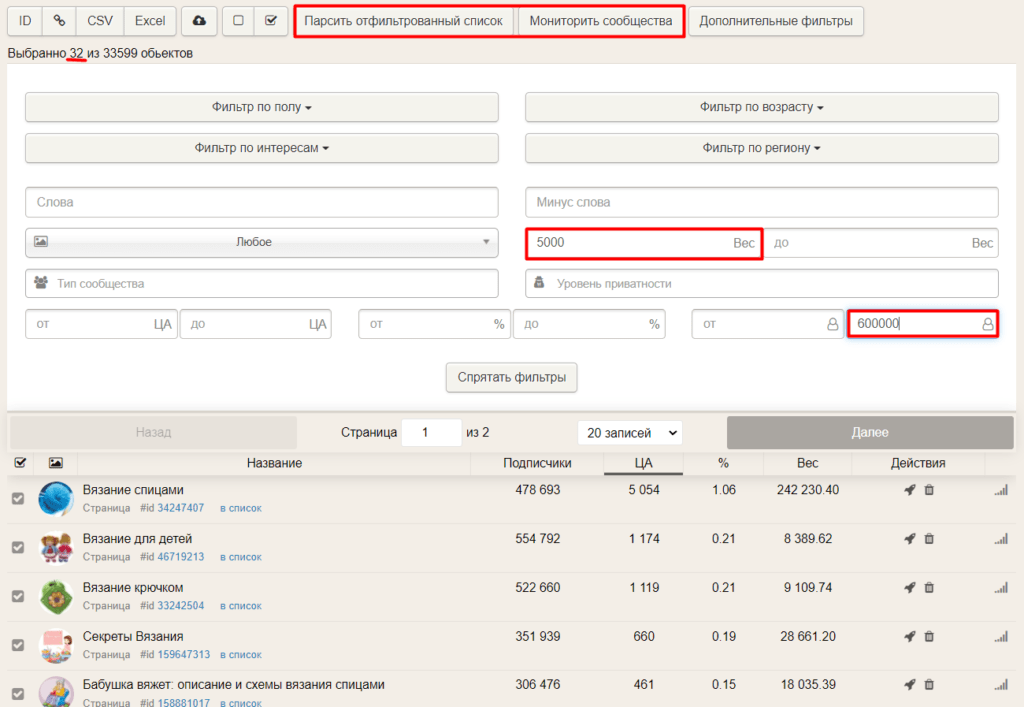

В Pepper.Ninja (парсер которым я пользуюсь для рекламы) есть несколько инструментов для масштабирования. Один из них – поиск сообществ аудитории. Как это работает? Например, собрали аудиторию, заинтересованную в различных видах рукоделия, и она показала хорошие результаты. Для ее расширения надо зайти в раздел «Задания» и нажать на воронку напротив задачи.

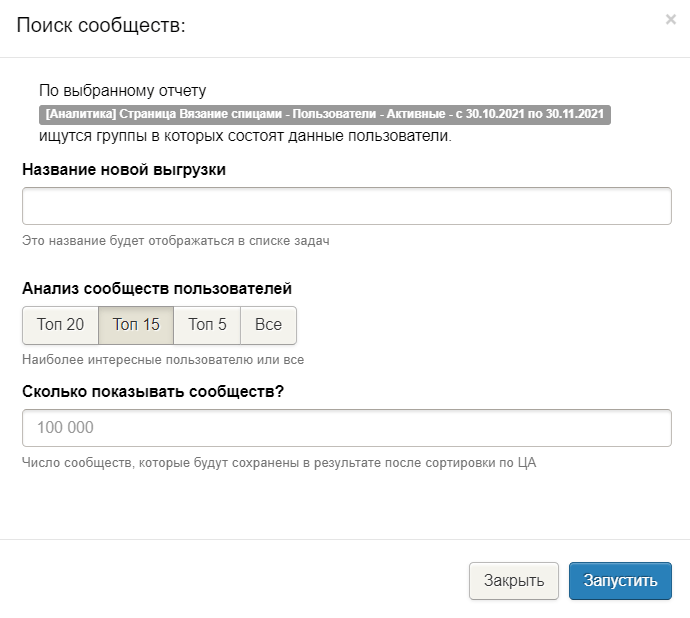

Здесь надо выбрать раздел «Поиск сообществ». С его помощью можно найти сообщества, находящиеся в топе подписок у найденной аудитории. Например, можно выбрать топ-15 сообществ у каждого человека.

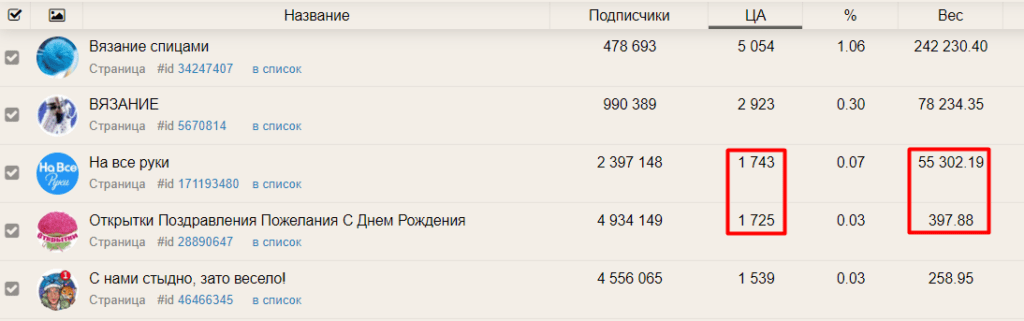

В результате найдутся все группы, которые встречаются у выбранной аудитории в топ-15. Теперь надо найти сообщества, в которых состоит много людей из базы, к которой применяем фильтрацию. Также важно оставить группы по схожей тематике. Так можно будет подобрать сообщества, в которых будет состоять аудитория, похожая на ранее собранную. Вы сможете собрать ее и настроить рекламу на этих пользователей.

Теперь откроем фильтры и оставим группы с большим Весом, например, от 5000. Также можно добавить фильтр по числу подписчиков (в сообществах с миллионами подписчиков может быть много нецелевой аудитории). В результате справа будет указано число групп, подходящих под заданные фильтры.

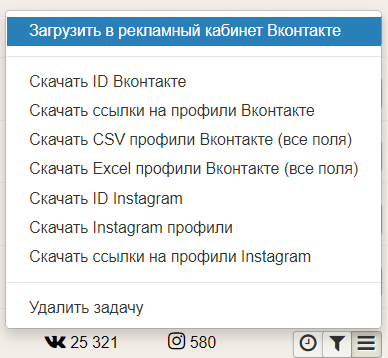

Из этих сообществ можно спарсить аудиторию или поставить группы на мониторинг, чтобы собирать новых подписчиков и автоматизировать их отправку в рекламный кабинет.

В результате используя фильтр «Вес», вы увеличите объем заинтересованной аудитории для рекламы и сможете загрузить её в рекламный кабинет из раздела «Задания».

И все! Это один из примеров. Функций у парсера много, каждая под ваши цели и задачи. Кстати, если у вас VPN и вы пользуетесь инстаграм вы, можете через Pepper.Ninja найти свою аудиторию.

Как продвигать инстаграм без таргета

Продвижение в Инстаграме невозможно? А что если есть способ привлекать аудиторию без таргета.

Настроить таргетированную рекламу в Инстаграм невозможно, но бизнес продолжает использовать эту соц. сеть для продвижения, а пользователи продолжают заходить и потреблять контент. Из платных методов продвижения в Инстаграме сейчас можно использовать только рекламные посевы, но это не все!

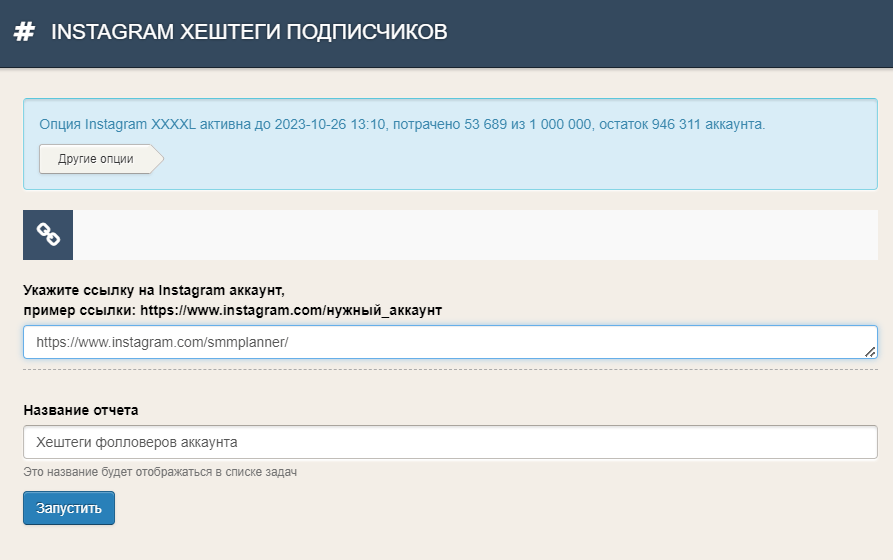

Инструмент, помогающий в продвижении в Инстаграме: сбор хештегов подписчиков. Для продвижения по хештегам надо знать, на какие хештеги подписана ваша аудитория и грамотно использовать их в своих постах.

В Pepper.Ninja вы сможете посмотреть, на какие хештеги подписаны подписчики любого открытого аккаунта – вашего или конкурентов. В первом случае это поможет для анализа своих подписчиков, во втором, находить тематические хештеги и использовать их для продвижения.

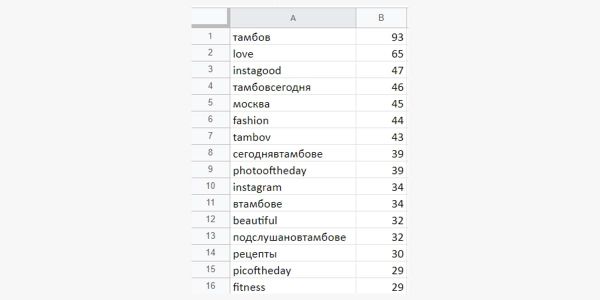

Для запуска задачи нужны специальные Инстаграм-опции. По завершению сбора вы сможете скачать таблицу, в которой хештеги отсортированы по популярности.

Зная на какие хештеги подписана ваша ЦА, вы сможете использовать их в своих постах для привлечения новой аудитории, даже когда таргетированная реклама недоступна.

Как подключить парсер?

Это очень просто ниже переходи по кнопке. Сервис отличается от других удобным интерфейсом, подробные уроки для начинающих, поддержка от сервиса работает прекрасно.

Кому интересна и актуальна данная информация:

Хочу сделать вам подарок введите промокод: “pars” Дает месяц в подарок, при покупке от 1 мес.

Предупреждаю! Количество использования промокода ограниченно. Так что успей первым.

Есть бесплатный тариф на месяц, правда с ограничениями. Используйте это время, что бы изучить весь функционал! Но и платные очень демократичные (недорого) Тарифы можно купить на 1 месяц, 3 месяца, полгода и на год. Посмотрите и изучите, вещь не заменимая.

Дополнительно

- Составление УТП на основе ЦА (пошаговый план).

- Система продаж с внедрением СРМ

- Что такое воронка продаж простыми словами.

- Аналитика для бизнеса гугл, яндекс или сквозная?

- За что платят SMM специалистам.

Источник: aruna.website