Есть ли программа, с помощью которой можно выкачать сайт по FTP и обновлять файлы?

То есть, функционал FileZilla плюс эта программа должна мониторить файлы на сервере и закачивать на мой жесткий диск ТОЛЬКО измененные и новые.

комментировать

в избранное бонус

Medve doc [5.5K]

8 лет назад

Универсальных программ не бывает. Можете попробовать Total Commander. Но я обычно использую связку FileZilla и Notepad++.

Notepad++ позволяет редактировать код исправляемыз страниц сайта вне зависимости от кода их написания.

FileZilla обеспечивает обмен файлами между компьютером и сервером (то бишь хостом).

Но если вы планируете выкачать сайт, то нужно забирать и базу данных сайта. Обычно для этого с хостинга подключаются через phpmyadmin и делают дамп базы данных. Иначе без нее копия сайта работать не будет.

Можно просто скачать сайт, но при этом он сохранит неполнофункциональную копию сайта. Для этого существует такая программа Teleport.

Источник: www.bolshoyvopros.ru

🔥 Как скачать видео с GetCourse или любого сайта на компьютер?✅

Wget как скачать сайт

Очень часто возникает необходимость в копировании стороннего сайта. В то время, как копирование с помощью встроенной функции браузера «сохранить как», не работает должным образом, можно воспользоваться программой wget.

В этой статье будут рассмотрены основные команды wget, на примере будет показано, как скачать страницу с помощью wget для локального просмотра, а так же, как скачать https сайт.

- Скачивание страниц по списку из файла

- Как задать папку для скачивания

- Рекурсивное скачивание подкаталогов

- Выкачивание всего сайта

- Скачивание страницы с локальным сохранением клиентских файлов

- Скачивание http-страниц

- Резюме

В этой статье я не буду рассматривать установку wget на компьютер. Я воспользуюсь сборкой Open Server, в которой эта программа уже включена. Open Server — это сборка локального веб-сервера. Потому, если вы не программируете на php, то смысла устанавливать Open Server не много. Для вас лучший вариант — это отдельная установка wget.

Скачивание всех страниц по списку из файла

wget -i YOURFILE , где YOURFILE — путь к файлу, с URL-адресами

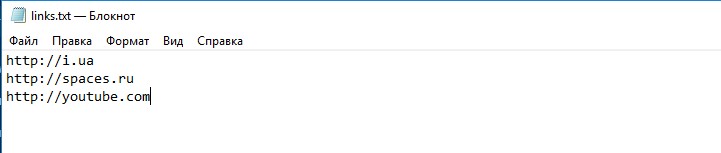

Например, у меня есть файл links.txt :

Теперь, запустив команду wget -i links.txt (у меня links.txt находится в той папке, относительно которой запущена консоль)

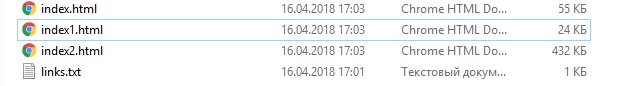

И в результате получим 3 файла, как и было в списке:

Скачивание в указанную папку

Для того, чтобы скачать в нужную нам папку, нужно выполнить:

Как полностью скачать сайт с CSS, JavaScript и картинками

wget -P /path http://example.com , где /path — папка для сохранения, http://example.com — url-сайта, который нужно скачать

-P — путь сохранения (указывается -P /path )

Например, скачаем содержимое главной страницы http://badcode.ru в папку files

Выполним:

wget -P files http://badcode.ru

И wget создаст папку с названием files , и куда сохранит содержимое нашего сайта

Рекурсивное скачивание каталога и вложенных подкаталогов

wget -r —no-parent http://example.com/catalog

Проверим это на примере скачивания всех статей одного из тегов: http://badcode.ru/tag/parsery/

Выполнив:

wget -r —no-parent http://badcode.ru/tag/parsery/

Скачивание всего сайта

wget -r -l 5 -k -p http://example.com

Каждая из опций значит:

-r — рекурсивно открывает новые найденные страницы

-l — глубина рекурсии -l 5 , что значит, что максимально рекурсивно будет открыто 5 ссылок

-k — конвертирование ссылок на локальные, загружая файлы (css, js, картинки) к себе в папку

-p — скачать в папку все нужные файлы для отображения страницы без интернета

Выполнив:

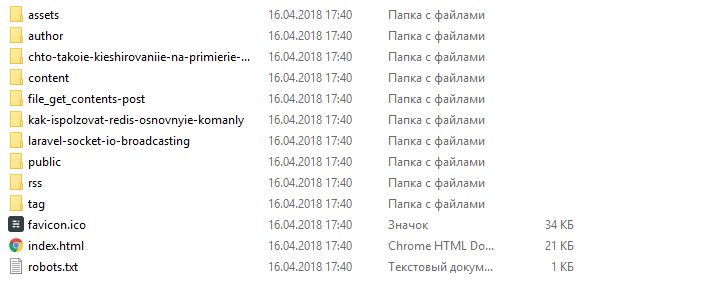

wget -r -l 5 -k -p http://badcode.ru

Получим результат в виде всех скачанных статей, которые без проблем можно читать без интернета:

Скачивание одной страницы со всеми файлами

Эта команда будет симбиозом того, что мы уже рассмотрели.

wget -k -p http://example.com

А ключи -k и -p нам уже известны: это значит, что мы говорим wget скачать все файлы, и проставить пути так, чтобы можно было открыть эти страницы локально, без интернета.

Скачивание https-страницы

Для того, чтобы скачать https-страницы, просто нужно добавить опцию —no-check-certificate

На прошлом примере, что будет иметь вид:

wget -k -p https://example.com —no-check-certificate

Резюме

Цель этой статьи — показать, с какой простотой и удобством можно пользоваться Wget. Я постарался ответить на то, как сохранять страницы, или даже целые сайты к себе локально, и просматривать их без интернета. В этой статье были описаны основные команды Wget, если вы хотите более продвинутого пользования этим инструментом, то этой информации будет недостаточно.

Ранее, для того, чтобы скопировать какую-то страницу, я прибегал к использованию сторонних сервисов, которые, зачастую, являются обёрткой над Wget. Потому, изучив основные команды Wget, необходимость в других сервисах отпадает сама собой.

К слову, моя «история фриланса», как раз и началась, с того, что я копировал лендинги, и тут мне очень помогали знания, связанные с Wget.

В серці. Назавжди.

Вчора у мене помер однокласник. А сьогодні бабуся. І хто б міг уявити, що цей рік принесе війну, смерть товариша, та смерть члена сім’ї? Це боляче. Проте це добре нагадування про те, як швидко тече час. І як його ціна збільшується кожної марно витраченої секунди. І я не скажу щось

20 мая 2022 г. 1 min read

Ось такий він, руський мир

«Руський мир» — звучить дуже сильно та виправдовуюче. Гарна обгортка виправдання слабкості, аморальності та нікчемності своїх дійсних намірів. Руський мир, який дуже солодко звучить для всіх, хто хоче закрити очі на факт повномасштабної війни. Дуже добре виправдання вбивства для купки звірів. Втім, це ж росія, в якій все виглядає логічно

16 апр. 2022 г. 3 min read

Перехват запросов и ответов JavaScript Fetch API

Перехватчики — это блоки кода, которые вы можете использовать для предварительной или последующей обработки HTTP-вызовов, помогая в обработке глобальных ошибок, аутентификации, логирования, изменения тела запроса и многом другом. В этой статье вы узнаете, как перехватывать вызовы JavaScript Fetch API. Есть два типа событий, для которых вы можете захотеть перехватить HTTP-вызовы:

Источник: badtry.net

Website Downloader Online — Tool Download HTML CSS Javascript Of A Website currently online

It allows you to download a World Wide Web site from the Internet to a local directory, building recursively all directories, getting HTML, images, and other files from the server to your computer.

Download all the source code and assets of any website online as a zip file. Download beautiful websites templates like a Pro with the best website copier online. Paste the link to start!

How to use the Website Downloader Online tool?

Step 1: copy the website url you want to download

Step 2: paste the url Bfotool

Step 3: Click on Start Processing

Step 4: Wait for Bfotool to process download html, css, js

Step 5: Download the zip file containing the source of the website

Download all the source code and assets of any website

Note the download time depends on the size of the website you want to download

This is an free online tool to download all html, css, javascript files of a website quickly and accurately

It allows you to download a World Wide Web site from the Internet to a local directory, building recursively all directories, getting HTML, images, and other files from the server to your computer. Bfotool arranges the original site’s relative link-structure.

Источник: bfotool.com