Что такое парсинг и как правильно парсить

Современный маркетинг – это работа с огромными массивами данных. Нужно анализировать работу сайта, конкурентов, свою аудиторию и еще массу всего. Но откуда брать эти данные? Можно собрать что-то вручную, пойти в метрику, wordstat или дугой аналитический сервис и что-то увидеть. Однако часто ручного сбора информации недостаточно, тогда на помощь приходят парсеры.

Что такое парсинг

Простыми словами парсинг – это автоматический сбор данных по конкретным параметрам или под какие-то задачи. Соответственно, парсеры – специальные сервисы для автоматического сбора данных. Собирать информацию можно практически из любых источников. Там где вы можете вычленить данные вручную, там можно использовать и парсинг, главное подобрать правильный инструмент для этого.

В этой статье мы разберем парсеры, которые позволяют собирать данные, полезные для развития сайта.

Законно ли использовать парсинг

Применение парсинга в целом не запрещено законом. В конституции РФ закреплено право свободно искать, получать и распространять информацию любым законным способом. Таким образом, если информация не защищена авторским правом, находится в свободном доступе для каждого человека и нет никаких других запретов с точки зрения закона, значит, ее можно копировать и распространять, а способ копирования и распространения большого значения не имеет.

Комплексные инструменты OSINT. Сбор информации в сети

Однако, помните о том, что есть некоторые виды информации, которые защищены законом. Пример таких данных – персональные данные пользователей. Эта информация защищена Законом «О персональных данных» и с их парсингом нужно сохранять некоторую осторожность. Если собираете личные данные, уведомляйте пользователя об этом:

Таким образом, парсинг разрешен, но не путайте его с другими понятиями:

- взломом сайта: получением данных из личных кабинетов пользователей

- DDOS-атакой: когда сайт перестает работать вследствие слишком частых запросов к серверу

- заимствованием авторского контента: забрали картинку с копирайтом или уникальный текст и разместили у себя

Такие действия – недобросовестная конкуренция, они запрещены и за них можно получить наказание: санкции со стороны закона, поисковиков, от социальных сетей и так далее.

Парсинг – это законно, если вы собираете информацию находящуюся в открытом доступе и это не вредит другим лицам

Алгоритм работы парсера

Парсер – это робот. Он воспринимает информацию на сайте не так как мы. Ему не интересны визуальные эффекты, он видит только код и текстовое содержимое страницы. Программа находит информацию по заданным параметрам, сравнивает ее, анализирует и сохраняет в нужном вам формате.

В качестве объекта парсинга может выступать практически все что угодно: обычный сайт, интернет-магазин, социальная сеть, какой-то каталог.

Парсинг в Python за 10 минут!

Для чего нужен парсинг

Объемы данных в интернете настолько большие, что обработать их вручную бывает просто невозможно. Представьте сайт с каталогом товаров на 3000 позиций. Как анализировать такой массив данных вручную? Никак. Какую-то часть информации, скажем, процентов 15-20 удастся держать под контролем вручную, но остальная доля будет оставаться без внимания.

Парсинг данных позволяет контролировать всё.

Вот некоторые способы использования парсеров на благо своего сайта:

- Для наведения порядка на сайте. Снова к тому же примеру: на сайте несколько тысяч товаров. Как вы будете поддерживать актуальность цен? А как следить за наличием товара? А каким образом проверите есть ли такой товар в каталоге, если забыли, размещалась группа товаров или нет? С помощью парсера можно собрать все страницы и в одной таблице увидеть все позиции с адресами и описанием

- Анализ цен и подстройка под рынок. Чтобы собрать цены вручную, нужно: открыть страницу → найти товар → найти цену на странице. В парсере нужно нажать три кнопки и заполнить пару полей и вы увидите полный список товаров конкурента с ценами

- Наполнение карточек товаров. Снова тот же каталог на несколько тысяч позиций. Как писать для каждого товара описания? Вручную, это объем работ на десятки, если не на сотни часов. А ведь можно пойти более простым путем. Спарсить данные, например, с англоязычного сайта, перевести автоматическим способом и у вас есть список из нескольких сотен готовых текстов, требующих минимальных доработок

- Парсинг используют при SEO-оптимизации: для аналитики своего сайта(позволяет в одном документе посмотреть мета-теги, урлы и другие данные) и при аналитике конкурентов

Это всего четыреи метода парсинга, которые относятся только к сайту, но даже они способны сэкономить десятки и сотни часов вашего времени.

Достоинства парсинга

- Быстрый сбор информации. Человек, работающий с данными устает, устает, ошибается, путается в информации. Робот – нет, он всегда работает в одном режиме. Парсер может работать круглосуточно

- Точное следование любым настройкам. Программа не будет отклоняться от заданных параметров сбора информации. Если данные невозможно собрать, выведется ошибка, но точность данных никогда не пострадает

- Формирование массивов данных в любой удобный формат

- Регулярно проверять сайт. Парсинг может быть систематическим с постоянным контролем качества материалов. Программу можно настроить так, чтобы она отправляла уведомления при обнаружении проблем

Ограничения при парсинге

Парсинг может быть ограничен внутренними ресурсами на сайте:

- user-agent. Перед посещением сайта бот сообщает ему о себе. Парсер может быть заблокирован при входе на сайт. Чтобы избежать этого, можно задать настройки, чтобы бот представлялся как YandexBot или Googlebot, ограничение будет снято

- robots.txt. Если ваш бот представился роботом гугла или яндекса, проверьте, нет ли ограничений для поисковиков в файле robots.txt. Найти файл можно на любом сайте по адресу site.ru/robots.txt

- IP-адрес. Если с одного и того же IP поступает много запросов за короткий промежуток времени IP может быть заблокирован. Если это случилось, используйте VPN

- Капча. Действия могут быть ограничены, если они повторяют или похожи друг на друга. Выводится капча. Можно научить парсер обходит капчу, но это трудно и дорого, альтернатива – использовать сервисы антикапчи

Парсеры сайтов по способу доступа к интерфейсу

Облачные парсеры

Преимущество таких программ – не требуют установки на компьютер. Их можно использовать онлайн и вся собираемая информация хранится на серверах разработчика. Работают через веб-интерфейсы или по API. Пара примеров облачных сервисов с русскоязычным интерфейсом:

- Церебро Таргет – для парсинга аудитории по интересам из VK

- Диггернаут – парсинг сайтов конкурентов

- Catalogloader – многофункциональный парсер для наполнения, отслеживания цен, мониторинга акций и т.д.

Программы-парсеры

Это приложения для установки на компьютер. Как правило, хорошо совместимы с Windows, на линуксе и MacOS возникают проблемы, запускаются через виртуальные машины.

- Постраничный SEO-парсинг для выявления ошибок на страницах, качества заполнения мета данных и так далее – Screaming Frog, Netpeak Spider

- Key Collector – специальное приложение для парсинга ключевых слов из различных источников

Парсеры сайтов в зависимости от используемой технологии

Парсеры на основе Python и PHP

Python – самый популярный язык для создания парсеров. По функциональности такие приложения превосходят все аналоги. Однако, если у вас нет навыков программирования, создать такой парсер не получится. Парсер на Python или PHP можно написать абсолютно под любые задачи. Но прежде, чем идти со своим заказом к разработчику, поищите готовое решение.

Скорее всего оно уже есть, нужно просто подобрать. За разработкой актуально обращаться только для решения узких специфических задач.

Парсеры-расширения для браузеров

Парсеры в виде расширений – очень удобные решения с той точки зрения, что не нужны никакие дополнительные приложения, кроме постоянно используемого браузера. По функциональности это чаще всего простые приложения, способные вытащить со страницы или сайта простые данные: цены, новости, товары, отзывы. Они делают выгрузку данных и компанют их в удобный для восприятия вид, обычно в Excel или Google Таблицы.

Вот пара полезных расширений в Chrome для владельцев интернет-магазинов: Scraper, Parsers.

Парсеры сайтов на основе Excel

Excel – настолько многофункциональное приложение, что на его основе разрабатывается масса надстроек, упрощающих жизнь вебмастеров и владельцев бизнеса в интернете. Парсинг в таком случае реализуется через макросы: специальные команды для Excel. Пример такой надстройки – ParserOK.

Парсинг при помощи Google Таблиц

В Google Таблицах есть встроенный функционал для автоматического сбора информации. Это две функции:

- IMPORTXML – импортирует информацию из разных источников: XML, CSV, RSS, HTML через запросы Xpath

- IMPORTHTML – у этой функции возможности уже. Она предназначена для импорта данных из списков и таблиц, размещенных на конкретной странице

Чтобы использовать эти функции не обязательно знать язык запросов Xpath.

Парсеры сайтов в зависимости от решаемых задач

Спектр задач, которые решаются с помощью парсера – основной параметр выбора. Вот основные разновидности парсеров по сферам применения:

Парсеры для организаторов совместных покупок (СП)

Предназначены для сбора данных о магазинах в социальных сетях, продающих свои товары мелким оптом по сниженной цене. Это парсеры с узким функционалом:

- сбор товаров из интернет-магазинов и социальных сетей

- выгрузка товаров из альбомов и каталогов соцсетей

- сохранение информации в форматы XLS и CSV

- автообновление блоков информации, например, цен

Отличаются понятным интерфейсом, могут быть реализованы разными способами: браузерная версия, приложение на компьютер и смартфон. Настройки простые: какие страницы парсить, расписание проверок, группы для выгрузки.

Примеры приложений такого типа:

Сервисы мониторинга конкурентов

Полезные сервисы для аналитики предложений ваших конкурентов. Они помогают поддерживать ваши предложения в соответствии с рынком. Например, если конкурент повысит или понизит цену, вы узнаете об этом первым и скорректируете свое поведение в соотвествии с рынком. Пример приложения для этих целей – Marketparser.

Сбор данных и автонаполнение контентом

Когда на сайте тысячи страниц, наполнение и обновление контента превращается в непосильную задачу. Чтобы не мониторить сайты конкурентов и поставщиков в ручную и не собирать с них информацию, можно использовать специальные сервисы. Парсер соберет информацию, выгрузит в таблицу или сразу на ваш сайт. В настройках таких приложений можно указать размер наценки, собирать данные сразу с нескольких сайтов и задать систематические проверки и анализ сайтов с автообновлением контента. Сервис для автонаполнения сайта – Диггернаут.

Многофункциональные парсеры

Это сервисы с широким функционалом, способны собирать данные для наполнения сайта, проверять разные SEO-параметры, мониторить цены конкурентов.

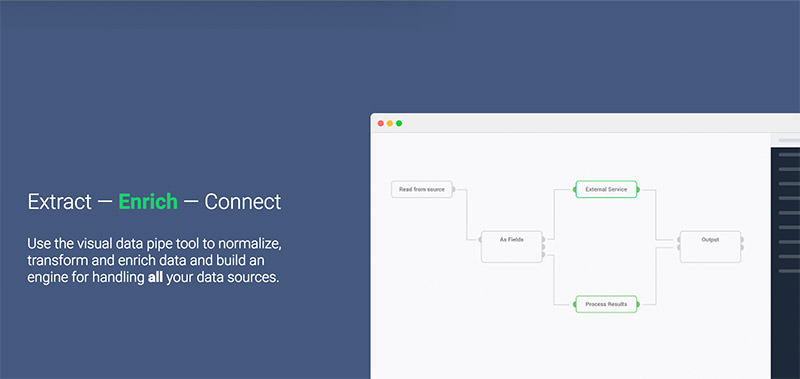

- ParseHub – мощный облачный парсер с широким функционалом. Может собирать цены, контакты, маркетинговую информацию, SEO-параметры

- Datacol – его особенность в работе с широким перечнем источников. Способен доставать данные из соцсетей, с сайтов-конкурентов, из Яндекс Карт

SEO-парсеры

Эти сервисы нужны, чтобы проверить техническое состояние сайта и качество оптимизации. Вот основные задачи, которые решаются с их помощью:

- сбор всех страниц сайта с основными параметрами качества

- проверка качества оптимизации изображений

- поиск битых ссылок и других проблем

- проверка качества внутренней перелинковки: какая страница, куда ссылается

- сбор сведений о технической оптимизации

Выводы

Парсеры – сервисы, которые экономят ваше время и отдают максимально точную информацию за считанные минуты. Чтобы получать нужные данные, важно подобрать правильный парсер. Вот вопросы, на которые нужно ответить:

- Зачем? Какие данные нужно извлечь и что нужно сделать: изучить конкурентов, наполнить сайт, проверить SEO-параметры или решить сразу несколько задач

- В каком виде нужны данные? Формат и объем данных – важный параметр, некоторые сервисы выгружают в небольшую таблицу, другие способны сразу загрузить информацию на сайт

- Когда и как часто делать выгрузки? Одни сервисы работают только при ручном запуске, другие самостоятельно обновляют данные и уведомляют об изменениях

После ответов на эти вопросы возьмите несколько подходящих приложений и изучите отзывы. Опыт прошлого использования подскажет, какой парсер ваш.

Источник: okocrm.com

10 инструментов, позволяющих парсить информацию с веб-сайтов, включая цены конкурентов + правовая оценка для России

Инструменты web scraping (парсинг) разработаны для извлечения, сбора любой открытой информации с веб-сайтов. Эти ресурсы нужны тогда, когда необходимо быстро получить и сохранить в структурированном виде любые данные из интернета. Парсинг сайтов – это новый метод ввода данных, который не требует повторного ввода или копипастинга.

Такого рода программное обеспечение ищет информацию под контролем пользователя или автоматически, выбирая новые или обновленные данные и сохраняя их в таком виде, чтобы у пользователя был к ним быстрый доступ. Например, используя парсинг можно собрать информацию о продуктах и их стоимости на сайте Amazon. Ниже рассмотрим варианты использования веб-инструментов извлечения данных и десятку лучших сервисов, которые помогут собрать информацию, без необходимости написания специальных программных кодов. Инструменты парсинга могут применяться с разными целями и в различных сценариях, рассмотрим наиболее распространенные случаи использования, которые могут вам пригодиться. И дадим правовую оценку парсинга в России.

1. Сбор данных для исследования рынка

Веб-сервисы извлечения данных помогут следить за ситуацией в том направлении, куда будет стремиться компания или отрасль в следующие шесть месяцев, обеспечивая мощный фундамент для исследования рынка. Программное обеспечение парсинга способно получать данные от множества провайдеров, специализирующихся на аналитике данных и у фирм по исследованию рынка, и затем сводить эту информацию в одно место для референции и анализа.

2. Извлечение контактной информации

Инструменты парсинга можно использовать, чтобы собирать и систематизировать такие данные, как почтовые адреса, контактную информацию с различных сайтов и социальных сетей. Это позволяет составлять удобные списки контактов и всей сопутствующей информации для бизнеса – данные о клиентах, поставщиках или производителях.

3. Решения по загрузке с StackOverflow

С инструментами парсинга сайтов можно создавать решения для оффлайнового использования и хранения, собрав данные с большого количества веб-ресурсов (включая StackOverflow). Таким образом можно избежать зависимости от активных интернет соединений, так как данные будут доступны независимо от того, есть ли возможность подключиться к интернету.

4. Поиск работы или сотрудников

Для работодателя, который активно ищет кандидатов для работы в своей компании, или для соискателя, который ищет определенную должность, инструменты парсинга тоже станут незаменимы: с их помощью можно настроить выборку данных на основе различных прилагаемых фильтров и эффективно получать информацию, без рутинного ручного поиска.

5. Отслеживание цен в разных магазинах

Такие сервисы будут полезны и для тех, кто активно пользуется услугами онлайн-шоппинга, отслеживает цены на продукты, ищет вещи в нескольких магазинах сразу.

В обзор ниже не попал Российский сервис парсинга сайтов и последующего мониторинга цен XMLDATAFEED (xmldatafeed.com), который разработан в Санкт-Петербурге и в основном ориентирован на сбор цен с последующим анализом. Основная задача — создать систему поддержки принятия решений по управлению ценообразованием на основе открытых данных конкурентов. Из любопытного стоит выделить публикация данные по парсингу в реальном времени 🙂

10 лучших веб-инструментов для сбора данных:

Попробуем рассмотреть 10 лучших доступных инструментов парсинга. Некоторые из них бесплатные, некоторые дают возможность бесплатного ознакомления в течение ограниченного времени, некоторые предлагают разные тарифные планы.

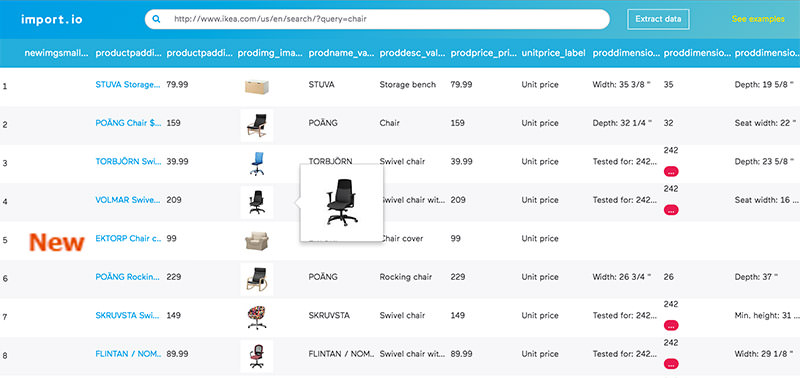

Import.io предлагает разработчику легко формировать собственные пакеты данных: нужно только импортировать информацию с определенной веб-страницы и экспортировать ее в CSV. Можно извлекать тысячи веб-страниц за считанные минуты, не написав ни строчки кода, и создавать тысячи API согласно вашим требованиям.

Для сбора огромных количеств нужной пользователю информации, сервис использует самые новые технологии, причем по низкой цене. Вместе с веб-инструментом доступны бесплатные приложения для Windows, Mac OS X и Linux для создания экстракторов данных и поисковых роботов, которые будут обеспечивать загрузку данных и синхронизацию с онлайновой учетной записью.

2. Webhose.io

Webhose.io обеспечивает прямой доступ в реальном времени к структурированным данным, полученным в результате парсинга тысяч онлайн источников. Этот парсер способен собирать веб-данные на более чем 240 языках и сохранять результаты в различных форматах, включая XML, JSON и RSS.

Webhose.io – это веб-приложение для браузера, использующее собственную технологию парсинга данных, которая позволяет обрабатывать огромные объемы информации из многочисленных источников с единственным API. Webhose предлагает бесплатный тарифный план за обработку 1000 запросов в месяц и 50 долларов за премиальный план, покрывающий 5000 запросов в месяц.

3. Dexi.io (ранее CloudScrape)

CloudScrape способен парсить информацию с любого веб-сайта и не требует загрузки дополнительных приложений, как и Webhose. Редактор самостоятельно устанавливает своих поисковых роботов и извлекает данные в режиме реального времени. Пользователь может сохранить собранные данные в облаке, например, Google Drive и Box.net, или экспортировать данные в форматах CSV или JSON.

CloudScrape также обеспечивает анонимный доступ к данным, предлагая ряд прокси-серверов, которые помогают скрыть идентификационные данные пользователя. CloudScrape хранит данные на своих серверах в течение 2 недель, затем их архивирует. Сервис предлагает 20 часов работы бесплатно, после чего он будет стоить 29 долларов в месяц.

4. Scrapinghub

Scrapinghub – это облачный инструмент парсинга данных, который помогает выбирать и собирать необходимые данные для любых целей. Scrapinghub использует Crawlera, умный прокси-ротатор, оснащенный механизмами, способными обходить защиты от ботов. Сервис способен справляться с огромными по объему информации и защищенными от роботов сайтами.

Scrapinghub преобразовывает веб-страницы в организованный контент. Команда специалистов обеспечивает индивидуальный подход к клиентам и обещает разработать решение для любого уникального случая. Базовый бесплатный пакет дает доступ к одному поисковому роботу (обработка до 1 Гб данных, далее — 9$ в месяц), премиальный пакет дает четырех параллельных поисковых ботов.

ParseHub может парсить один или много сайтов с поддержкой JavaScript, AJAX, сеансов, cookie и редиректов. Приложение использует технологию самообучения и способно распознать самые сложные документы в сети, затем генерирует выходной файл в том формате, который нужен пользователю.

ParseHub существует отдельно от веб-приложения в качестве программы рабочего стола для Windows, Mac OS X и Linux. Программа дает бесплатно пять пробных поисковых проектов. Тарифный план Премиум за 89 долларов предполагает 20 проектов и обработку 10 тысяч веб-страниц за проект.

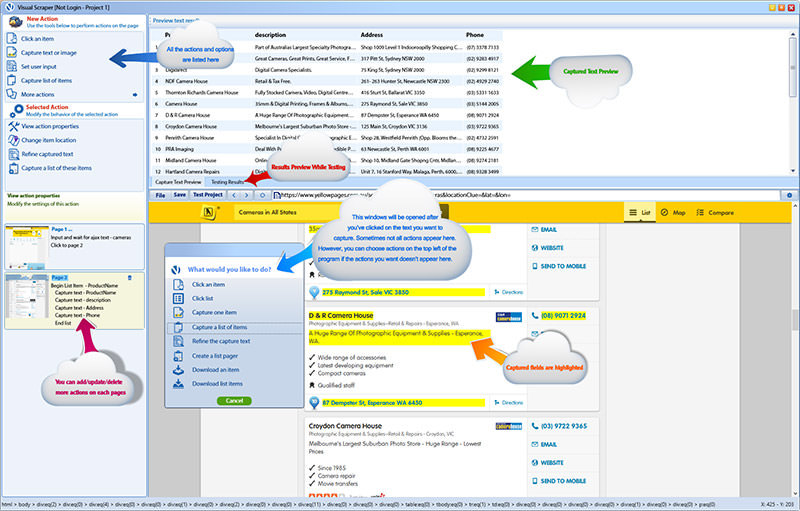

6. VisualScraper

VisualScraper – это еще одно ПО для парсинга больших объемов информации из сети. VisualScraper извлекает данные с нескольких веб-страниц и синтезирует результаты в режиме реального времени. Кроме того, данные можно экспортировать в форматы CSV, XML, JSON и SQL.

Пользоваться и управлять веб-данными помогает простой интерфейс типа point and click. VisualScraper предлагает пакет с обработкой более 100 тысяч страниц с минимальной стоимостью 49 долларов в месяц. Есть бесплатное приложение, похожее на Parsehub, доступное для Windows с возможностью использования дополнительных платных функций.

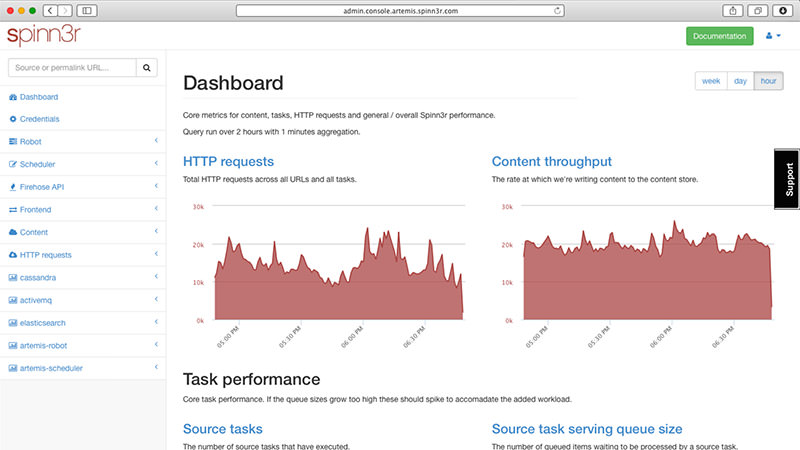

Spinn3r позволяет парсить данные из блогов, новостных лент, новостных каналов RSS и Atom, социальных сетей. Spinn3r имеет «обновляемый» API, который делает 95 процентов работы по индексации. Это предполагает усовершенствованную защиту от спама и повышенный уровень безопасности данных.

Spinn3r индексирует контент, как Google, и сохраняет извлеченные данные в файлах формата JSON. Инструмент постоянно сканирует сеть и находит обновления нужной информации из множества источников, пользователь всегда имеет обновляемую в реальном времени информацию. Консоль администрирования позволяет управлять процессом исследования; имеется полнотекстовый поиск.

80legs – это мощный и гибкий веб-инструмент парсинга сайтов, который можно очень точно подстроить под потребности пользователя. Сервис справляется с поразительно огромными объемами данных и имеет функцию немедленного извлечения. Клиентами 80legs являются такие гиганты как MailChimp и PayPal.

Опция «Datafiniti» позволяет находить данные сверх-быстро. Благодаря ней, 80legs обеспечивает высокоэффективную поисковую сеть, которая выбирает необходимые данные за считанные секунды. Сервис предлагает бесплатный пакет – 10 тысяч ссылок за сессию, который можно обновить до пакета INTRO за 29 долларов в месяц – 100 тысяч URL за сессию.

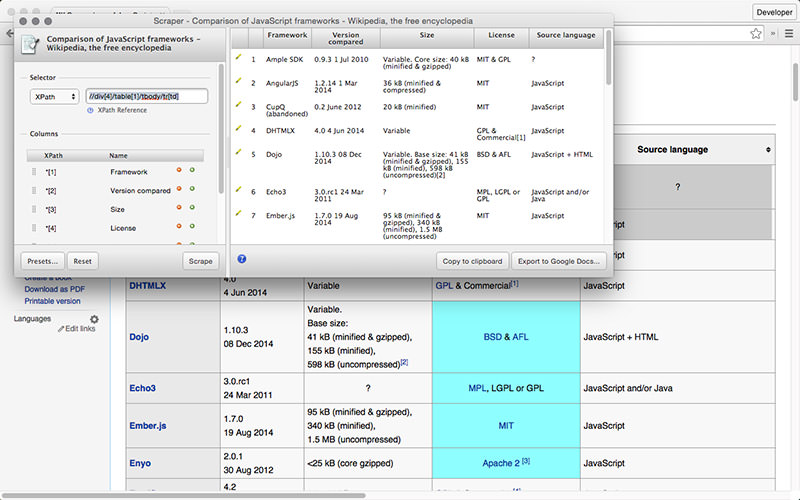

Scraper – это расширение для Chrome с ограниченными функциями парсинга данных, но оно полезно для онлайновых исследований и экспортирования данных в Google Spreadsheets. Этот инструмент предназначен и для новичков, и для экспертов, которые могут легко скопировать данные в буфер обмена или хранилище в виде электронных таблиц, используя OAuth.

Scraper – бесплатный инструмент, который работает прямо в браузере и автоматически генерирует XPaths для определения URL, которые нужно проверить. Сервис достаточно прост, в нем нет полной автоматизации или поисковых ботов, как у Import или Webhose, но это можно рассматривать как преимущество для новичков, поскольку его не придется долго настраивать, чтобы получить нужный результат.

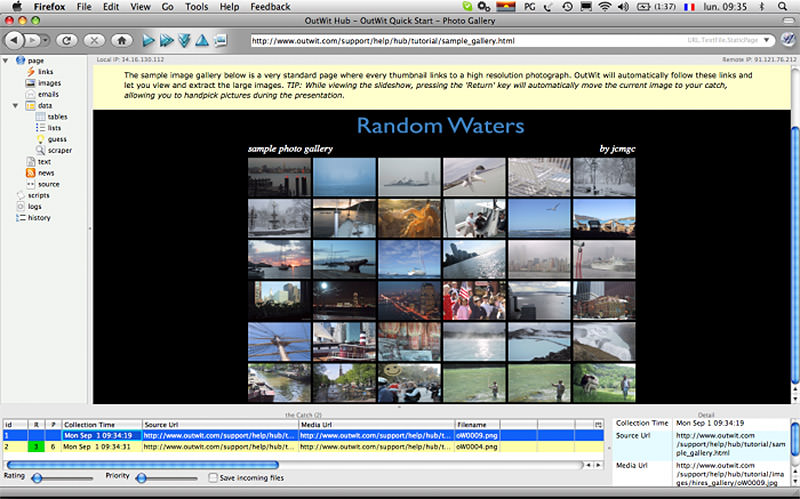

10. OutWit Hub

OutWit Hub – это дополнение Firefox с десятками функций извлечения данных. Этот инструмент может автоматически просматривать страницы и хранить извлеченную информацию в подходящем для пользователя формате. OutWit Hub предлагает простой интерфейс для извлечения малых или больших объемов данных по необходимости.

OutWit позволяет «вытягивать» любые веб-страницы прямо из браузера и даже создавать в панели настроек автоматические агенты для извлечения данных и сохранения их в нужном формате. Это один из самых простых бесплатных веб-инструментов по сбору данных, не требующих специальных знаний в написании кодов.

Самое главное — правомерность парсинга?!

Вправе ли организация осуществлять автоматизированный сбор информации, размещенной в открытом доступе на сайтах в сети интернете (парсинг)?

В соответствии с действующим в Российской Федерации законодательством разрешено всё, что не запрещено законодательством. Парсинг является законным, в том случае, если при его осуществлении не происходит нарушений установленных законодательством запретов. Таким образом, при автоматизированном сборе информации необходимо соблюдать действующее законодательство. Законодательством Российской Федерации установлены следующие ограничения, имеющие отношение к сети интернет:

1. Не допускается нарушение Авторских и смежных прав.

2. Не допускается неправомерный доступ к охраняемой законом компьютерной информации.

3. Не допускается сбор сведений, составляющих коммерческую тайну, незаконным способом.

4. Не допускается заведомо недобросовестное осуществление гражданских прав (злоупотребление правом).

5. Не допускается использование гражданских прав в целях ограничения конкуренции.

Из вышеуказанных запретов следует, что организация вправе осуществлять автоматизированный сбор информации, размещенной в открытом доступе на сайтах в сети интернет если соблюдаются следующие условия:

1. Информация находится в открытом доступе и не защищается законодательством об авторских и смежных правах.

2. Автоматизированный сбор осуществляется законными способами.

3. Автоматизированный сбор информации не приводит к нарушению в работе сайтов в сети интернет.

4. Автоматизированный сбор информации не приводит к ограничению конкуренции.

При соблюдении установленных ограничений Парсинг является законным.

p.s. по правовому вопросу мы подготовили отдельную статью, где рассматривается Российский и зарубежный опыт.

Какой инструмент для извлечения данных Вам нравится больше всего? Какого рода данные вы хотели бы собрать? Расскажите в комментариях о своем опыте парсинга и свое видение процесса…

- парсинг контента

- парсинг сайтов

- парсинг

- мониторинг цен

Источник: habr.com

10 лучших инструментов для сбора данных в Интернете

Просто люблю писать, переводить и давать людям возможность читать интересный контент. И пусть я не всегда идеальна — есть к чему стремиться.

Инструменты веб-скрейпинга специально разработаны для извлечения информации с веб-сайтов. Они также известны как веб-инструменты сбора извлечения данных. Эти инструменты полезны для тех, кто пытается собрать какую-либо форму данных из Интернета. Веб-скрейпинг — это новый метод записи данных, который не требует повторного набора текста или копирования.

Программное обеспечение для сбора данных ищет новые данные вручную или автоматически, извлекая новые или обновленные данные, а также сохраняя их для легкого доступа. Например, можно собирать информацию о продуктах и их ценах на Amazon с помощью инструмента для скрейпинга. В этом посте мы перечислим варианты использования инструментов и 10 лучших инструментов для сбора информации с нулевой необходимостью написания кода.

Почему инструменты веб-скрейпинга?

Инструменты веб-скрейпинга могут использоваться для неограниченных целей в различных сценариях, но мы расскажем об общих случаях использования, применимых к обычным пользователям.

1. Сбор данных для исследования рынка

Инструмент для сбора данных может помочь вам быть в курсе того, куда ваша компания или отрасль будет двигаться в ближайшие шесть месяцев, служа мощным инструментом для исследования рынка. Инструменты позволяют получать данные от нескольких поставщиков аналитической информации и фирм, занимающихся исследованием рынка, и объединять их в одном месте для удобства использования и анализа.

2. Извлечение контактной информации

Эти инструменты также могут использоваться для извлечения данных, таких как электронные адреса и номера телефонов с различных веб-сайтов, что позволяет получить список поставщиков, производителей и других лиц, представляющих интерес для вашего бизнеса или компании, наряду с их соответствующими контактными данными.

3. Загрузка решений из Stack Overflow

Используя инструмент веб-скрейпинга, можно также загружать решения для автономного чтения или хранения, собирая данные с нескольких сайтов (включая Stack Overflow и другие веб-сайты Qhttps://freelance.today/poleznoe/10-luchshih-instrumentov-dlya-sbora-dannyh-v-internete.html» target=»_blank»]freelance.today[/mask_link]

Что такое парсер простыми словами

Для наполнения интернет-магазина или торговой онлайн-площадки нужно анализировать тысячи страниц сайтов производителей. Делать это вручную очень затратно и долго, поэтому рекомендуется использовать специальные программы сбора и анализа данных — парсеры. Такие же утилиты подходят для сбора и систематизации информации с веб-страниц конкурентов — для изучения контента и многих других задач.

Что такое парсинг и парсер сайтов

Парсингом называется процесс и способ индексирования цифровой информации и дальнейшей конвертации в другой формат. Парсер — это специальная программа, онлайн-сервис или скрипт, собирающие данные с нужных сайтов, аккаунтов социальных сетей и других интернет-площадок, а затем преобразующие их в нужный вид. Есть разные виды парсеров, конвертирующие информацию в простейший язык, необходимый для отображения или использования для различных целей.

Сбор открытых данных разрешен Конституцией. Но если собираются персональные данные пользователей, которые используются для таргетированной рекламы, спам-рассылок, то это уже считается незаконными действиями (нарушение закона о персональных данных).

Назначение парсеров сайтов

Какие данные можно собирать с помощью программ-парсеров («белый» парсинг»):

- Цена на товары или услуги конкурентов. Для коммерческих сайтов, интернет-магазинов, товарных электронных каталогов очень важно поддерживать рыночные цены, ориентируясь на ведущих конкурентов своей ниши. Для сбора нужной информации можно парсить данные сайтов конкурентов и корректировать ценовые предложения под рыночные.

- Товарные позиции или категории. Для того, чтобы скопировать данные о продукции (названия, описания свойств и характеристик, артикулы и фотографии карточек товаров) с сайтов поставщиков, можно применить парсинг данных и с помощью таких инструментов выгрузить необходимую информацию в свой онлайн-магазин.

- Мета-данные. Информация о title, description и других метаданных может требоваться SEO-специалистам для анализа интернет-продвижения.

- Технические ошибки. Парсеры позволяют собирать информацию о наличии страниц с ошибкой 404, редиректах, неработающих и «битых» ссылках и т. д.

Есть также «серый» парсинг, к которому относятся скачивание контента на конкурентных онлайн-ресурсах, сбор контактной информации с агрегаторов и бизнес-порталов, применяющийся для рассылок и обзвона «холодных» баз.

Виды парсеров веб-сайтов

Есть разные виды парсеров, которые подбираются в зависимости от поставленных целей и задач, вида контента, который нужно собирать, анализировать и конвертировать. Они приведены в Табл. 1.

Табл. 1. Типы парсеров и их особенности

| Параметр классификации | Тип парсера | Особенности и применение |

| Тип устройства | Облачный | Облачные сервисы работают с помощью скриптов и программ, которые не нужно скачивать на компьютер. Скачать нужно только полученные результаты. Такие инструменты рекомендованы тем, кто регулярно парсит данные, автоматизируя процессы. В сети можно найти англоязычные и русскоязычные программы для парсинга |

| Декстопный (на компьютере) | Парсеры для сбора информации о товарах и ценах, которые нужно скачать на компьютер либо запускать с флешки, внешнего накопителя. Такие сервисы разрабатываются под Windows — на macOS | |

| Технологии | Браузерные расширения | Браузерные расширения подходят для сбора небольшого количества информации и преобразуют ее в удобный формат (XML или XLSX). Есть различные парсеры для Google Chrome и других браузеров |

| Надстройки для Excel | Программные продукты, разработанные в виде надстроек для Microsoft Excel (такие, как ParserOK и пр.). В таких парсерах для сайтов используются простые макросы, которые дают возможность выгрузки результатов в файлы XLS или CSV | |

| Google Таблицы | Программный продукт поисковой системы Гугл, который предлагает применение простых формул IMPORTXML и IMPORTHTML для сбора данных с веб-ресурсов. Функция IMPORTXML работает с помощью языка запросов XPath, парсит данные XML-фидов, HTML-страниц и прочих источников для анализа заголовков, метаданных, ценовых показателей и пр. Функция IMPORTXML дает меньше возможностей — она позволяет собирать информацию с таблиц и списков на веб-страницах | |

| Сфера применения | Совместные покупки | Специальные программы-парсеры устанавливают на своих интернет-магазинах или торговых онлайн-платформах производители или сетевики, продающие тысячи разных товаров. Потенциальные покупатели, заходя на такой ресурс, могут выгрузить себе весь ассортимент с помощью парсера. Можно загрузить себе на устройство весь ассортимент, а также отдельные товарные группы или категории. Предлагаются также разные форматы выгрузки — стандартные XLSX, CSV, адаптированный прайс-лист для Tiu.ru, выгрузка продукции для Яндекс.Маркета и т. д. |

| Анализ ценовых предложений конкурентов | Есть специальные сервисы, которые позволяют парсить цены на товары конкурентов при указании нужных ссылок | |

| Наполнение товарных сайтов, интернет-магазинов | При наполнении онлайн-магазина товарами с сайтов производителей нужно копировать названия и характеристики продукции, цены и фото. Это можно сделать вручную (если таких позиций немного) или же воспользоваться парсером. Такой сервис дает возможность добавлять стандартную наценку на все собранные единицы продукции, а также настроить автоматическое обновление всех данных с определенной периодичностью |

Есть также парсеры для SEO-специалистов, применяемые для оптимизации сайтов, интернет-магазинов, порталов. Программы по сбору SEO-данных можно также использовать для анализа конкурентных веб-ресурсов.

Такие программы нужны для:

- анализа файлов robots.txt и sitemap.xml;

- проверки наличия мета-тегов, тегов, заголовков всех уровней;

- проверки кодов ответа веб-страниц;

- сбора и визуализации структуры онлайн-ресурса;

- анализа оптимизации ссылочной массы (внешних и внутренних ссылок);

- проверки наличия битых, неработающих ссылок и мн. др.

Как найти парсер под определенные задачи

Для сбора данных можно:

- Разработать программное обеспечение под потребности компании или определенного проекта. Программисты пишут ПО с учетом технического задания и создают инструмент, заточенный под конкретные задачи. При изменениях целей свою программу можно доработать и адаптировать под новые потребности.

- Использовать готовые десктопные парсеры. Они устанавливаются на компьютеры. Есть платные и бесплатные версии (платные инструменты имеют более широкий функционал, возможность гибких настроек).

- Применять веб-сервисы или браузерные плагины. Предлагаются платные и бесплатные варианты.

Плюсы и минусы парсинга

У применения сервисов для парсинга сайтов в коммерческих и других целях есть свои преимущества и недостатки (Табл. 2).

Табл.2. Плюсы и минусы применения парсеров

| Преимущества | Недостатки |

| Автоматизация сбора, анализа и другой обработки собранных данных. Сервис работает быстро, без перерывов и выходных, в рамках настроек под нужные задачи | Некоторые сайты, с которых требуется собирать информацию, могут быть защищены от копирования или обработки парсинговыми программами |

| Возможность собирать именно те данные, которые нужны для выполнения определенных задач. Можно отсечь нецелевые данные путем гибких настроек сервиса или инструмента | Конкуренты также могут парсить ваш сайт (если не защищать его с помощью капчи или настроек — блокирования популярных ключевых запросов и слов в файле robots.txt) |

| Распределение нагрузки на обрабатываемые веб-ресурсы. Равномерная нагрузка при сборе данных позволяет скрыть планомерный парсинг контента. Если нагрузки превышать, то сайт может «упасть» и вас могут обвинить в незаконной DDoS-атаке |

Как работает парсер

Программное обеспечение анализирует данные определенного веб-ресурса с учетом заданных настроек, извлекает контент, систематизирует и преображает тексты и другие элементы наполнения.

Упрощенный алгоритм работы с парсинговым сервисом, который может различаться в зависимости от разных типов утилиты:

- Выбор парсера.

- Настройка программы под определенные задачи.

- Указание веб-страницы или онлайн-ресурса, на котором нужно парсить информацию.

- Анализ полученных данных. Программа собирает контент, анализирует и систематизирует его в автоматическом режиме.

- Формирование отчета.

Как использовать парсер для различных целей

Применение программы для сбора данных осуществляется с учетом поставленных задач. От этого зависит подбор типа и перечня функций сервиса.

Парсинг интернет-магазина

Одним из самых частых применений парсинговых программ является сбор данных с онлайн-площадок или электронных каталогов для наполнения собственного интернет-магазина товарами, ценами и описаниями продукции.

Какие задачи можно решить, применяя автоматизированные сервисы для сбора, анализа и конвертации данных:

- Актуализация информации. При смене цен поставщика нужно пересчитывать свои ценовые предложения по всем категориям номенклатуры. Если в каталоге представлены тысячи позиций ассортимента, сделать это очень трудно и дорого. Поэтому здесь подходят специальные плагины, которые собирают данные и дают возможность обновить всю информацию.

- Анализ конкурентных онлайн-магазинов. Такая аналитика делается для поддержания цен на рыночном уровне.

Парсинг контента

Для поиска и анализа текстов и другого контента используется специальная утилита для парсинга. Настройка осуществляется с учетом поставленных задач — анализ опубликованных статей, описание характеристик или комментариев в каталоге продукции.

Как парсить сайт интернет-магазина

Для корректного сбора данных нужно грамотно настроить парсинговую программу или расширение. Настройка модуля позволяет обеспечить корректное распознавание разметки сайта — расположение и структуру категорий и подкатегорий, карточек товаров. После этого можно получить всю необходимую информацию с онлайн-ресурса.

Алгоритм действий при парсинге интернет-магазина:

- Добавление ссылки на веб-ресурс (на сайт или отдельные разделы).

- Указание мест (блоков), откуда необходимо взять нужные данные.

- Загрузка информации с онлайн-площадки.

- Сохранение полученных данных в файл Excel (XLSX). Или выгрузка информации о товарах на нужный сайт либо электронный каталог в интернете.

Теги, которые используются для парсинга онлайн-магазина

При разработке интернет-магазинов разного масштаба и структуры используется язык HTML, типовые элементы блоков. Поэтому стандартные парсерыданных используют типовые теги HTML, которые имеются на страницах интернет-магазинов:

- Тег div. Этот блочный элемент дает возможность выделить раздел, в котором есть визуальный контент

- Тег a. Отображение ссылок на продукцию выбранной товарной категории.

- Тег h1 и др. Отображает заголовки различных уровней. Заголовками могут быть названия товаров и другие блоки.

- Тег p. Служит для отображения текстового абзаца — описаний товаров и пр.

- Тег table. Отображает таблицы.

- Тег ul. Обозначает маркированный список (перечень продукции и т.п.).

- Тег img. Отображает фотографии, другие изображения.

Используя стандартизированные настройки, можно выбрать именно те блоки информации, которые нужны для анализа или других целей.

Применение парсинговых утилит позволяет быстро собирать и систематизировать большие массивы данных. Это нужно для анализа цен и товаров конкурентов, а также для обновления данных о товарах и услугах. Если вы работаете с десятком производителей, то вам удобно использовать парсинговые сервисы для обновления и актуализации информации с этими товарами. Не нужно вносить изменения вручную, намного быстрее и проще применять данную программу.

Источник: www.rush-analytics.ru