«Кто владеет информацией, тот владеет миром». Это выражение действительно отражает современные реалии, но есть одна сложность ― данных очень много и они требуют обработки. Из-за этой проблемы простой сбор данных уже неактуален. Мы расскажем, о современной работе с информацией ― парсинге. Расскажем, что такое парсинг и как парсинг может помочь владельцу сайта.

Что такое парсинг сайтов

Понятие парсинга широкое. Этот термин был заимствован из английского языка «to parse», что означает «считывать». Что такое парсинг простыми словами? Если дать общее определение, парсинг ― это процесс сбора интернет-данных и последующая их обработка и анализ. Парсерами называют программы, которые помогают собирать и систематизировать данные.

Информацию можно брать как со своего веб-ресурса, так и с других сайтов.

Информацию, которую собирает парсер можно собрать и вручную, но это долго. Программы автоматизируют сбор информации и помогают её интерпретировать. Можно представить, как человек открывает браузер, ходит по сайтам и копирует с них данные. Парсинг — то же самое, только ходит не человек, а робот.

Парсер: что это такое и зачем он нужен | SEMANTICA

Для парсинга можно использовать:

- специальные готовые программы. Их очень много. Функционал некоторых программ ограничен, и они могут решить только одну задачу. Есть многофункциональные, которые могут собирать разного рода информацию из разных источников;

- самостоятельно написанные программы. Парсер можно создать на практически любом языке программирования, например, PHP, C++ и Python.

Как работает парсер?

Парсинг ― это строгий алгоритм работы системы с контентом на сайте. Использовать его можно в разных целях, но суть алгоритма почти не меняется. Вот какие этапы выполняет программа.

- Парсер посещает указанные сайты в интернете, а именно изучает их исходный HTML-код, базы данных, XML-разметки.

- Затем программа избавляется от тегов и других технических символов и оставляет только текст контента.

- Теперь из полученного текста можно извлечь информацию. Система разбивает текст на лексемы и ищет среди них интересующие фрагменты. Например, маркетолог хочет узнать, как обстоят дела с ценой на определённый товар. Для этой задачи программа из всего текста на страницах выделит только название продукта и цену, которая ему соответствует.

- Пришло время систематизировать данные в понятную для человека форму. Парсер сохраняет всё, что он узнал, в виде таблиц.

- Теперь человек может посмотреть на данные в таблице и сделать выводы.

Технология парсинга особенно пригодилась в онлайн-маркетинге. В бизнесе в целом важно изучение аудитории, рынка и конкурентов. Но важным является то, что у интернет-бизнеса, в отличие от оффлайн-рынка, есть больше возможностей сбора информации о целевой аудитории и конкурентах. Тему парсинга лучше рассматривать на конкретных примерах. Этим и займёмся.

Парсинг: что это такое и зачем он нужен | SEMANTICA

Что же можно спарсить?

Ограничений у парсинга нет, так как вы можете самостоятельно написать программу под свои нужды. Однако и уже готовых программ немало. Перечислим основные возможности парсинга, которыми пользуются маркетологи.

Анализ цен на рынке

Чтобы понять, за сколько продавать свой товар или стоит ли пересмотреть цену существующего продукта, можно посмотреть на конкурентов и использовать эту информацию для принятия решения. Оценить ситуацию на рынке можно самостоятельно, но это долго и скучно. Парсинг-программы могут сделать это всё за вас. Маркетологу нужно будет только принять бизнес-решение.

Парсинг ассортимента

Не знаете, с чего начать продажи или в какую сторону расширять свой ассортимент? Посмотрите, что за последнее время размещали ваши конкуренты. Какие товары залетели, а какие остались непонятыми. Таким образом, вы не сделаете ошибок, которые сделали ваши конкуренты и сразу начнёте продавать популярный товар.

Парсинг контента

В статье Сервис для контент-маркетинга ― Google Trends. Обзор возможностей мы рассказывали о том, как найти популярную тему для вашего блога или сайта с помощью изучения пользовательских запросов. Однако к этому вопросу можно зайти с другой стороны. Посмотреть, о чём пишут ваши конкуренты и какие темы самые популярные.

Важно отметить, что вы ни в коем случае не должны воровать контент. Парсинг нужно использовать только для анализа тем. А саму информацию нужно готовить самостоятельно.

Проверка на наличие ссылок на ваш ресурс

Для продвижения сайтов используют размещение ссылок сайта на сторонние ресурсы. Во-первых, ссылки на ваш сайт на других ресурсах улучшают поисковые позиции сайта. Во-вторых, грамотные PR-статьи могут привлечь новую аудиторию. Но если ссылки заказываются в больших количествах, как отследить, правильно ли их указали и куда именно добавили? Это тоже может сделать парсер.

Он может найти все указывающие на вас ссылки, правильно ли они написаны (указан защищённый протокол и ведёт ли на правильную страницу). Для маркетолога, который постоянно работает с партнёрами, такая автоматизация процесса значительно ускорит процесс продвижения.

Поиск места обитания аудитории

Парсинг может помочь подробно изучить свою аудиторию. Например, некоторые программы способны изучать увлечения пользователей по их социальным сетям. Как это работает? Например, нас интересуют увлечения мужчин 30-40 лет в определённом городе. Парсер выбирает людей по этим критериям и проверяет сообщества, на которые они подписаны, какие посты пишут, что лайкают.

Основываясь на этих данных, можно нарисовать подробный портрет аудитории без применения технологий интервьюирования и фокус-групп. На основе этих портретов может продумываться система сбыта товара, рекламные кампании, упаковка и многие другие маркетинговые задачи. Также этим пользуются таргетологи для настройки рекламы в социальных сетях.

Сбор отзывов и комментариев

Парсинг не всегда направлен на изучение сторонних ресурсов. Часто нужно собрать информацию со своего сайта. В частности, робот может собрать отзывы ваших клиентов с сайта и классифицировать их. Так вы быстро можете понять, сколько у вас негативных, положительных и нейтральных комментариев.

Стоит сказать, что роботы плохо классифицируют такого рода информацию, так как каждый комментарий индивидуален. Однако система всё равно способна собрать все данные в одну таблицу. Это всё равно значительно облегчает исследование. Собирать комментарии вы можете и на страницах ваших конкурентов. Оттуда тоже можно вынести много полезного.

Оценка продаваемости товаров в интернет-магазине

Если у вас крупный интернет-магазин, делать аудит популярных и непопулярных товаров может быть затруднительно. Можно настроить парсер, чтобы раз в месяц он готовил для вас сводку топовых и провальных товаров.

Проверка своего сайта на неправильные ссылки и дубли страниц

На продвижение сайта влияют ссылки с 404 ошибкой и дубли страниц. Если таких ошибок много, поисковые системы считают такой ресурс недобросовестным и понижают его рейтинг. Для маленького сайта ручная проверка не так критична. Но для крупных интернет-магазинов, где контент постоянно обновляется и пополняется, это непосильная задача.

С помощью парсера можно настроить автоматический сбор подобных недочётов. Вам останется только исправлять ошибки.

Какие данные используют при парсинге? Законно ли это?

Когда мы рассказывали про данные, которые можно собирать, могло сложиться впечатление, что парсинг ― это хакерская программа, которая собирает конфиденциальные данные в обход законов. Это не так. Парсинг ― технология сама по себе законная. Официальные парсинг-программы собирают только общедоступные пользовательские данные, которыми можно пользоваться в своих целях.

При сборе информации нужно соблюдать несколько условий:

- исследуемая информация должна находиться в открытом доступе и не быть под защитой закона об авторских правах,

- сбор данных не должен приводить к сбоям в работе веб-ресурса, с которого берутся данные,

- сбор должен проводиться только законными способами (без взлома сайта).

Если все условия соблюдены, ничего незаконного вы не делаете. Однако бывают случаи, когда воруют личные данные пользователей (телефоны, паспортные данные). В этом случае парсинг становится незаконным действием. В общем, технология может стать незаконной только в человеческих руках. Сам инструмент ничего не нарушает.

Что может помешать парсинг-программам?

Есть несколько настроек ресурсов, которые могут помешать работе парсера:

- Настройки robots.txt. В этом файле владелец сайта может прописать запрет для индексации некоторых страниц поисковыми роботами. Так как парсинг-системы являются роботами, то и настройки robots.txt на них тоже влияют. Однако в некоторых парсерах есть настройки игнорирования robots.txt. Да и в целом в этом файле редко бывает что-то полезное для маркетолога.

- Однотипные запросы IP-адреса. В целях безопасности сайты могут блокировать однотипные запросы, которые поступают от одного IP-адреса. Следовательно, парсер может не получить нужной ему информации.

- Капча. Данные парсят роботы, и они не смогут пройти капчу. Если на сайте она есть, сбор данных может не получиться. В теории парсеры можно научить проходить капчу, но это дорого и сложно.

Программы для парсинга

Приведём несколько примеров программ для парсинга, которые подойдут для разных задач.

Screaming Frog SEO Spider. Сервис специализируется на работе с SEO-данными. Программа требует немного практики, но у неё большие возможности:

- ищет нерабочие ссылки,

- может просматривать robots.txt,

- обнаруживает дубликаты страниц,

- просматривает Sitemap.

Netpeak Spider. Тоже работает с SEO-показателями сайтов, а именно:

- сканирует слабые места в оптимизации сайта,

- помогает создавать карты сайта,

- готовит комплексный анализ структуры.

Xenu’s Link Sleuth. Программа предназначена только для парсинга битых ссылок. Так как программа выполняет одну задачу, интерфейс лёгкий и понятный.

Церебро Таргет. Делает парсинг данных аудитории в ВК. Можно узнать, в каких сообществах состоит ваша аудитория. Анализирует фотографии вашей аудитории. Рисует портрет комментаторов.

Если вы планируете использовать ВК как площадку для продвижения, определённо стоит воспользоваться этим парсером.

Segmento Target. Собрат Церебро Таргет, но он работает не только с ВК, но и с Instagram и Одноклассниками. Благодаря этому вы можете ещё подробнее изучить аудиторию и попробовать продвигаться на нескольких площадках.

Xmlatafeed. Узкоспециализированная программа. Позволяет постоянно мониторить ассортимент и цены на товары конкурентов. Все данные структурируются в таблицу со всеми ссылками на товары и датами обновлений страниц.

Компании стремятся автоматизировать все свои процессы. Это ускоряет работу и экономит деньги. Парсеры могут значительно сократить расходы на анализ рынка и увеличить продуктивность сайта. Если ни одна из готовых программ не подходит под ваш проект, вы всегда можете нанять программистов, которые создадут вам новую программу.

Источник: 2domains.ru

Парсинг: что это такое простыми словами

Сегодня парсинг настолько распространен, что о нем должен знать каждый вебмастер, а маркетолог и подавно. Когда-нибудь его надо включать в список обязательных инструментов, ведь при грамотном использовании можно извлечь немало пользы. Процесс этот отличается от взлома, а если следовать инструкциям (прописанным в robots.txt на сайтах), то и вполне законный.

Что такое парсинг и что значит парсить

Дословный перевод слова parsing — делать грамматический разбор или структурировать. В программировании/информатике, это автоматический сбор и систематизация необходимых сведений, размещенных на веб-ресурсах с помощью специальных программ.

Принцип работы парсинга основывается на сравнении готового общепринятого шаблона и найденной в сети информации. Например, вы создали интернет-магазин и хотите его продвигать. Вам нужно скопировать данные о товарах (цены, изображения, описания) у конкурентов, а потом разместить на своем сайте.

Делать это вручную — длительная и рутинная работа, особенно когда речь идет о 500-1000 товарах. Поэтому процесс автоматизируется, и сбор данных доверяется программе/сервису. Результатом станет колоссальная экономия времени.

Подробнее о преимуществах автоматического сбора данных:

- высокая скорость получения информации — очевидный факт, так как все компьютерные технологии в обработке данных превосходят ручной сбор;

- точное структурирование по определенному критерию — отчет можно получать в виде чистых цифр, адресов, описаний, картинок и т. д (смотря, как настроить);

- отсутствие ошибок — вычислительной машине не свойственно уставать и ошибаться из-за невнимательности;

- удобный формат получения информации — XLSX, CSV, XML, JSON и даже сразу выгрузка на сайт;

- равномерное распределение нагрузки на анализируемую страницу — таким образом, сводится на нет противозаконная атака DDOS.

Единственное, что не умеет делать парсер, это уникализировать информацию — контент просто собирается из открытых источников.

Программа парсер

В роли парсера может выступить программа, сервис или скрипт. Функция у них одна — собрать данные с указанных web-сайтов, анализировать и выдать в нужном формате. Обычно используют десктопные и облачные парсеры, основное преимущество которых в отсутствии необходимости скачивать программу и устанавливать на свой комп. Вся работа производится в облаке.

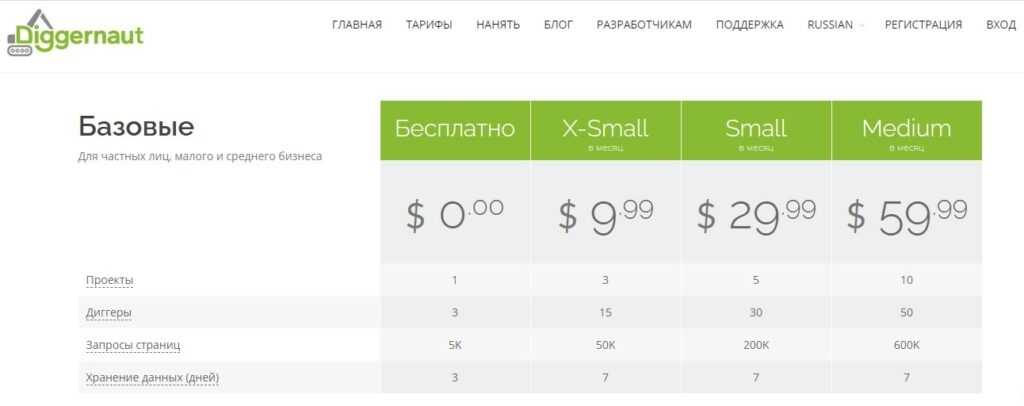

Вот, например, несколько облачных парсеров на русском языке.

- Диггернаут. Облачный сервис, робот которого умеет добывать открытую информацию — цены и отзывы о товарах, данные для статистического исследования, сводка из государственных/муниципальных источников и многое другое. На сайте действует бесплатный и платный тарифы.

- Xmldatafeed. Способен ежедневно парсить ведущие сайты Рунета, анализировать и мониторить цены конкурентов. Готовые каталоги можно скачивать бесплатно.

- Catalogloader. Аналогичный сервис, предлагающий эффективные решения для онлайн-бизнеса. Умеет обрабатывать прайсы поставщиков/интернет-магазинов и выгружать таблицы с ценами (все это бесплатно).

А это пара десктопных сервисов:

- ParserOK — можно скачать демо-версию и проверить, а затем купить лицензию на продукт с полным функционалом на 2 компьютера или больше;

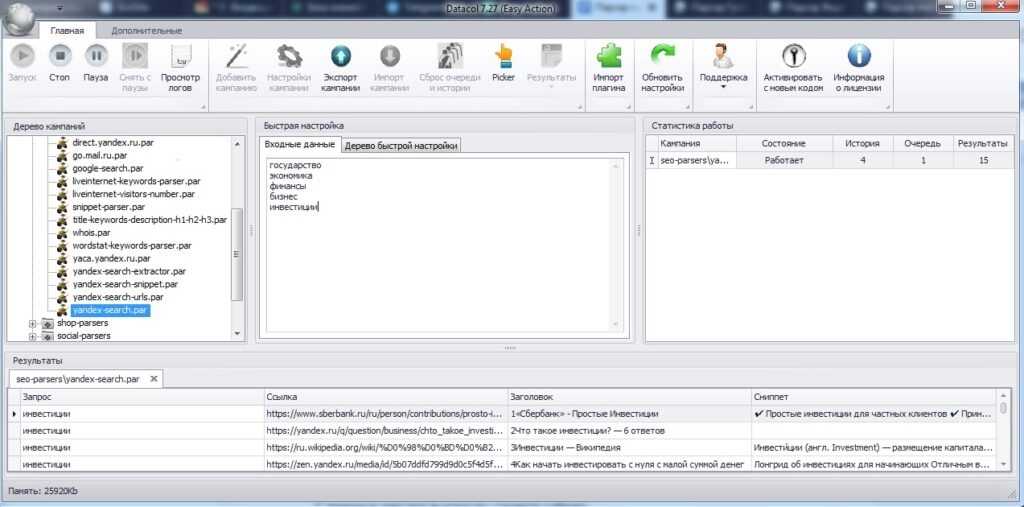

- Datacol — аналогичная программа, которую можно купить за 633 руб.

Что такое парсинг слов и зачем нужно

Парсинг также активно применяется вебмастерами и оптимизаторами для сбора семантического ядра с дальнейшей кластеризацией запросов. Таким образом, инструмент может решить вопросы с продвижением сайта и составлением рекламной кампании в Яндекс.Директе и Гугл Адс.

Среди популярных программ для парсинга в Seo:

- Key Collector;

- Словоеб;

- Rush Analytics;

- Магадан;

- Moab и другие.

В этапы работ над семантическим ядром сайта входит — определение поисковых фраз, анализ конкурентов, сбор данных со всех источников и т. д.

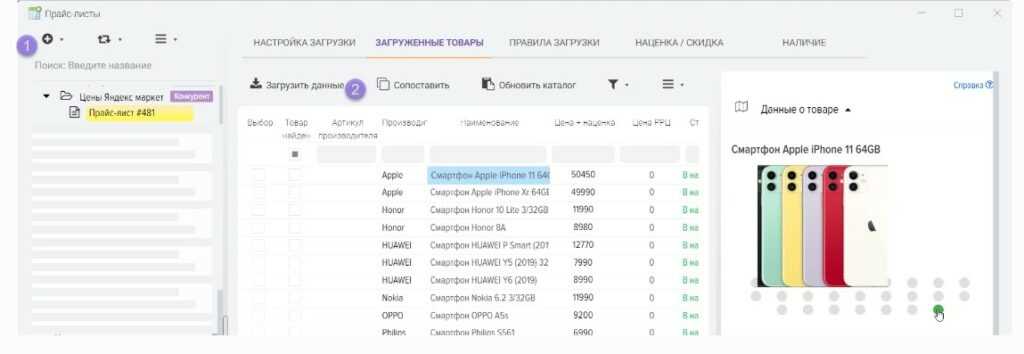

Что такое парсинг товаров и зачем нужно

Парсить товары, значит — собирать нужную информацию о продукции из готового каталога онлайн-магазинов. Обычно это делается в целях анализа ценовой политики конкурентов или для заполнения витрины своих сайтов. Ручной сбор такой информации и тщательная сортировка занимает много времени, поэтому автоматизация процесса напрашивается априори.

Например, парсинг товаров часто используется владельцами крупных интернет-магазинов. Это позволяет избавиться от рутинной работы, увеличить скорость сбора данных и сделать процесс более качественным.

Вот как работает парсинг:

- подготавливается список товаров;

- задается автоматический поиск по составленному каталогу;

- готовые данные (описание, иллюстрации) выгружаются на сайт заказчика.

Что такое парсинг сайтов и зачем нужно

Парсинг сайтов бывает двух типов:

- технический, чаще используемый сео-шниками — поиск битых ссылок, выявление дублей, анализ корректности роботс.тхт, проверка микроразметки и другие проверки проблем с сайтом;

- развитие бизнеса — поиск подборок товаров конкурентов, парсинг названий/прайса/описаний, анализ структуры чужих веб-ресурсов.

Алгоритм работы простой — машинальное извлечение открытых данных. Парсер переходит по ссылкам исследуемого сайта и собирает информацию по каждой странице. Сведения записываются в Excel или какой-нибудь другой файл.

Что такое парсинг аудитории и зачем нужно

Автоматический поиск и выгрузка данных о пользователях соцсетей по конкретному алгоритму называется парсингом аудитории. Данный процесс проводится на автомате (специальными программами) или вручную (таргетологи) — целью является выгрузка собранной информации в соответствующий рекламный кабинет.

Чаще всего аудиторию группы парсят по активным ее пользователям — админам, модераторам, редакторам или просто старожилам, регулярно публикующим контент. Такой метод позволяет быстро и точно подобрать ЦА под свою нишу. Это будут потенциальные покупатели, которых реально заинтересует товар или услуга. Таким образом, маркетолог сэкономит средства и время, а реклама не будет показываться всем подряд.

Парсинг по аудитории можно настроить еще точнее, используя различные критерии выбора — возраст, семейное положение, финансовый статус, хобби и интересы. В таком случае бюджет РК сократится еще больше, а вероятность покупок и целевых действий возрастет.

Что такое парсинг в программировании и зачем нужно

Принцип работы парсинга в программировании — сравнение строк или конкретных символов с готовым шаблоном, написанном на одном из языков. Другими словами, это процесс сопоставления и проверки стоковых данных, проводимый по определенным правилам. Цель — найти проблемы производительности, несоответствие кода требованиям и другие недостатки сайтов/ресурсов/приложений.

Обычно айтишники разрабатывают собственные парсеры на таких языках, как C++, Java Programing. Делается это из-за того что иногда требуемый синтаксический анализатор невозможно найти в свободном доступе.

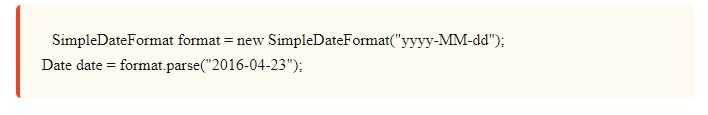

На самом деле, парсинг в программировании не является чем-то сверх сложным. Рассмотрим, как он работает на примере разбора даты из строки.

С первого взгляда это какой-то непонятный код, но если приглядеться, то можно разобрать узнаваемые части.

Примерно таким же способом осуществляется синтаксический анализ целого языка. Строки делятся на маленькие биты синтаксиса. Парсинг применяется не только в программировании, но также в аналитике и любой другой области, где можно работать с данными в стоковом формате.

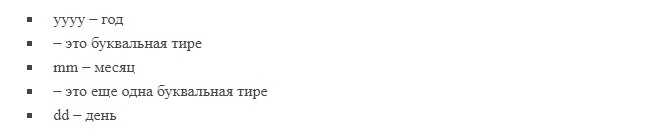

Что такое парсинг в Инстаграм и зачем нужно

Парсинг в Инсте используют как один из инструментов для работы с ЦА — чтобы отсортировать пользователей, заинтересованных в товаре. Благодаря этому снижается рутина и экономится время.

У парсинга в Instagram имеются широкие возможности анализа и мониторинга. Инструмент помогает собрать всю нужную информацию и наладить взаимодействие с пользователями. Вот что с его помощью получится сделать в Инстаграме:

- массфолловинг — подписки на акки пользователей;

- сбор аудитории по интересам и геолокации;

- масслайкинг — массовое проставление лайков на посты и комментарии;

- фильтрация базы по нескольким критериям — возраст, количество опубликованных постов, демография и т. д;

- рассылки — автоматическая отправка сообщений для обеспечения коммуникации с фолловерами;

- выгрузка базы в формате csv.

Все эти функции позволят точечно запустить рекламную кампанию, настроить таргет и оформить «вкусное» коммерческое предложение.

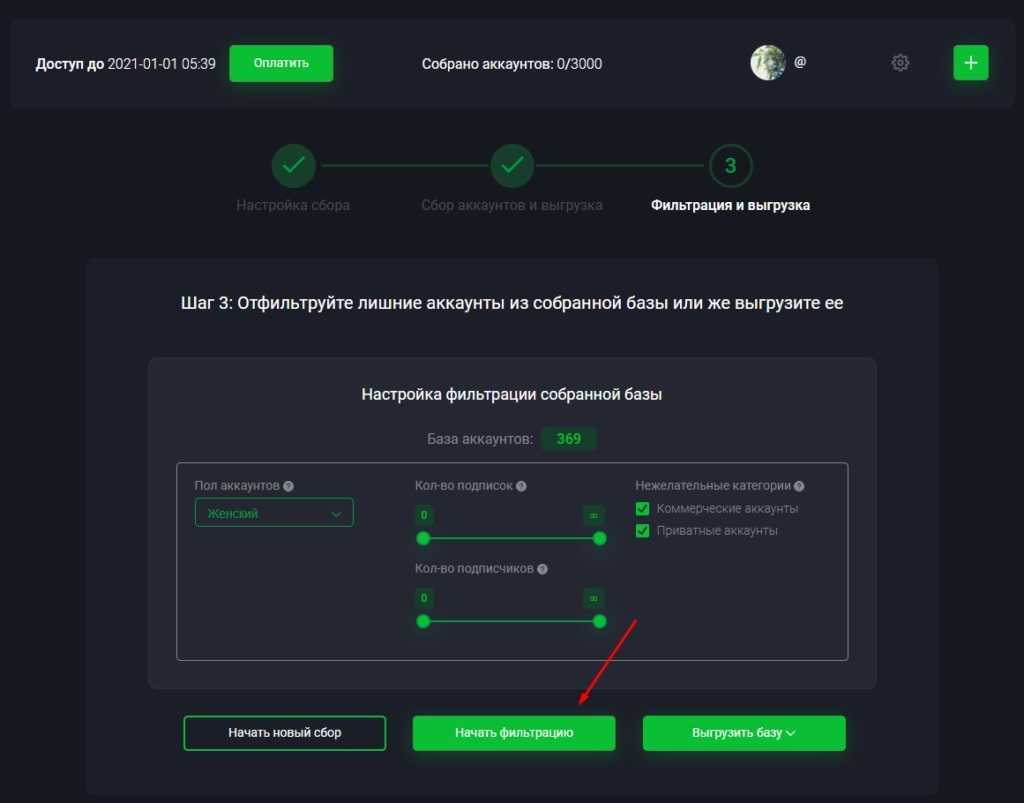

Что такое парсинг Авито и зачем нужно

Парсинг полезен также в Авито — самой популярной доски объявлений в Рунете. С его помощью можно получить информацию обо всех постах, размещенных в определенных категориях, включая номера телефонов и адреса.

Чтобы спарсить данные с Avito, достаточно сделать так:

- указать в поисковой строке Авито нужный запрос (например, телефоны), выставить фильтры (категория и параметры);

- обновить страницу — система автоматически покажет объявления по искомой тематике;

- скопировать ссылку и вставить в парсер;

- задать настройки по сбору данных — за какой период времени, по интересам и т. д.

Инструмент соберет всю требуемую информацию в течение дня (в зависимости от объема данных) и выгрузит в документ. Обычно арбитражникам и маркетологам бывают нужны имена/контакты людей, цены на товары и изображения.

Полученные сведения можно использовать для отправки уведомлений на email, Gold calling, заполнения собственных площадок, анализа конкурентов и много чего еще. Сейчас есть возможность применять несколько парсеров для Авито — AvitoMonsterParser, FastParserAvito, Avi2-parser и другие.

Что такое парсер выдачи и зачем нужно

Парсеры для мониторинга поисковой выдачи входят в обязательный джентльменский набор опытного вебмастера, оптимизатора и маркетолога. Инструмент в этом случае настроен на сбор информации с заданного источника (Гугл, Яндекс, соцсети, форумы).

В первую очередь такой сбор данных нужен для анализа сайтов конкурентов. Парсинг даст возможность определить лидеров топа, узнать их характеристики в разрезе Seo. Например, вот какие данные чужих ресурсов:

- количество индексируемых страниц в поисковиках по конкретной фразе;

- параметры ИКС, PR;

- число бэклинков — анкорные и безанкорные вариации;

- самые релевантные документы и многое другое.

Предоставленная информация поможет специалисту найти качественные сайты-доноры для размещения на них обратных ссылок, потенциальных клиентов/партнеров, а также площадки для рекламы.

Что такое парсинг цен и зачем нужно

Обычно ценовая «разведка», а в частности про оборот товара осложняется тем, что некоторые компании скрывают такую информацию. Напротив, такие гиганты, как Wildberries, Lamoda, Leroy Merlin ее открыто выставляют. На основе этих данных можно будет составить общее представление о продажах и сделать полезные выводы. К примеру, определить самые продаваемые позиции и сфокусироваться на них, а дешевые отсечь.

Цены можно парсить из разметки shema.org — это самый простой способ. Но если стоимость бывает зачеркнута или прайс с остатками товара загружается отдельными запросами к серверу, приходится использовать более функциональные программы. Сегодня есть такие проги, которые умеют раскрывать информацию методом эмулирования.

Кейсы по заработку на парсинге

Существует несколько способов заработка на парсинге. Но обычно заказчиков интересуют:

- полезные данные для исследования рынка в своей нише;

- получение контактов и их систематизация — ценная инфа для бизнеса, позволяющая найти потенциальных клиентов;

- поиск сотрудников — применимо к работодателям;

- отслеживание цен — даст возможность сделать свои товары конкурентоспособными.

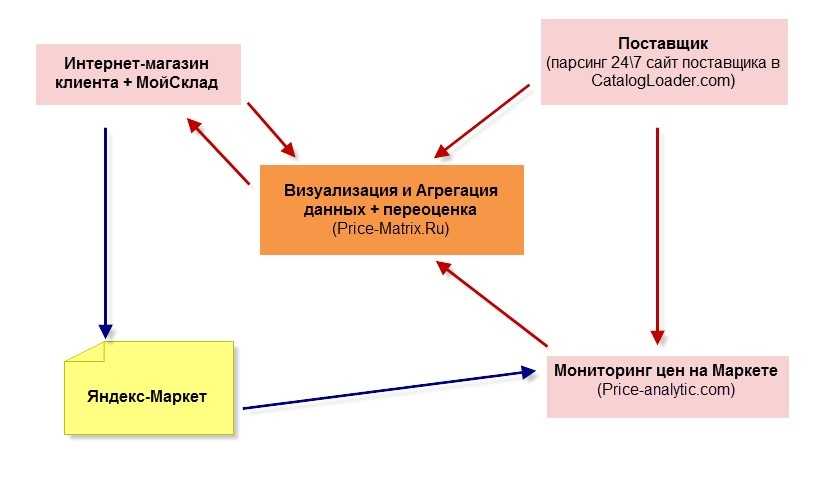

Ниже представлен интересный кейс от CatalogLoader, решивший задачи компании, закупающейся в буржунете и продающей на Яндекс.Маркете.

Что надо было сделать:

- информировать о товарах, которые выгодно продавать через Маркет в конкретных регионах РФ и СНГ;

- выставить такие цены, чтобы товары попали в топ-1 или топ-3 (ниже минимальных по рынку, но с учетом маржи).

Задача решилась эффективно, клиент получил все необходимые данные. Использовался парсер сервиса CatalogLoader.com, собравший всю актуальную информацию с зарубежного интернет-магазина по нужным категориям/брендам. Сведения выгрузили в Price-Matrix.ru, где можно их анализировать и делать переоценку.

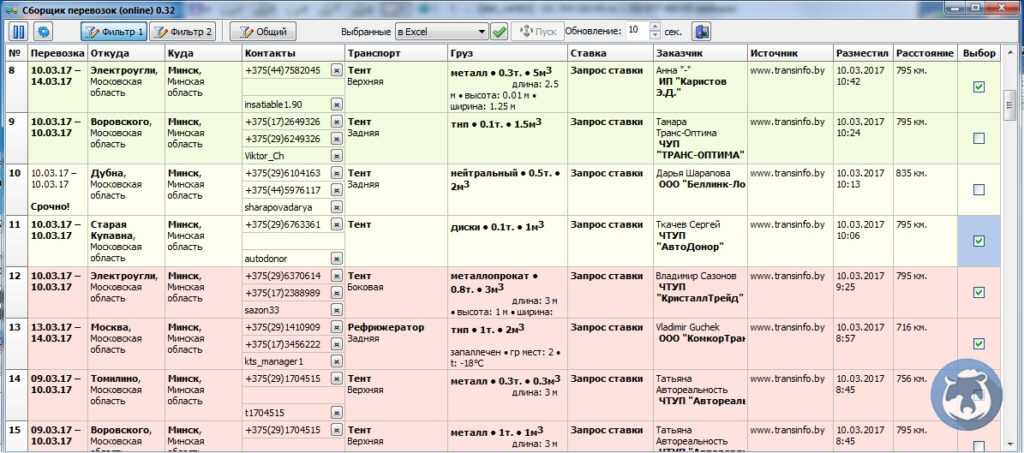

Еще один кейс, выложенный на сайте im-business. К ним обратился клиент, занимающийся грузоперевозками Россия-Беларусь. Ниша оказалась весьма конкурентной, поэтому человеку приходилось держать постоянный штат операторов и регулярно обновлять сайты с запросами на перевозку — чтобы не упустить заказы, иначе конкуренты не спят.

Задача для команды была следующая: спарсить информацию с 5 сайтов, которые постоянно мониторят заявки и отбирают их по определенным критериям. Сложность была в том, что все площадки разные — для некоторых требовалась регистрация. Пришлось в настройках прописать код для авторизации.

Дальше сделали так:

- заложили ссылку с конкретными параметрами, чтобы сбор проводился только по определенным маршрутам;

- выставили интервал сбора данных в каждые 4-30 секунд;

- настроили возможность использовать прокси.

Все полученные данные сохраняли в общей таблице, каждый параметр по своим ячейкам. Заказчику давалась возможность отфильтровывать грузы, отмечать взятые в работу, а обработанные заявки выгружать для логиста.

Результат — удалось сбросить значительную нагрузку с операторов фирмы, заявки стали обнаруживаться гораздо быстрее. Все это позволило опережать конкурентов и выходить в профит.

Заключение

Если у вас растущий бизнес или вы просто торгуете широко распространенными товарами, с парсингом вам придется столкнуться рано или поздно. Ничего противозаконного в нем нет, особенно при получении информации с интернет-магазинов. Здесь вы не нарушите закон о персональных данных или чьи-то авторские права

Источник: cpamonstro.com

Парсинг — что это такое и как пропарсить сайт

Про явление парсинга данных стоит знать всем, кто держит веб сайты или работает с ними. Парсинг (от английского to parse – структурировать, производить синтаксический анализ) — это сбор открытых нужных вам данных с определённого сайта с последующей их структуризацией. Сейчас в свободном доступе есть огромное количество решений, позволяющих проводить тончайшую настройку парсинга, начиная от формата собираемых документов, и заканчивая точкой мира, откуда парсер будет запрашивать эти самые данные.

Зачем нужен парсинг?

В основном парсинг используется для копирования деталей и наполнения сайта у конкурентов или наведения на собственном сайте порядка. Иногда парсинг используется для конкурентной разведки многими крупными компаниями (если рассматривать Россию, то компании МВидео, Ситилинк и Связной заявляли о конкурентном парсинге открыто, остальные компании не любят говорить об этом, но также занимаются этим делом).

Рассмотрим ситуацию. Вы – владелец крупного сайта продажи мебели, на котором ежедневно происходит не одна сотня покупок, а наполнение сайта идет бешеными темпами. Но со временем разбираться в структуре созданного вами сайта становится всё сложнее, а скорость его загрузки стремительно падает и оставляет желать лучшего. Тогда парсинг поможет вам выявить неиспользуемые файлы, более неактивные продажи, и дубликаты картинок или документов, мешающих вам и пользователям, заходящим на сайт.

Или давайте представим следующее. Вы только открыли сайт по продаже рыболовных снастей и вам надо заполнить больше тысячи карточек по продаже вашего товара, но время, которое на это может уйти слишком велико и вас не устраивает, но вы знаете другой сайт, продающий рыболовные снасти, который торгует точно такими же товарами, как и вы. Тогда вы парсите наполнение карточек товаров с сайта-конкурента, слегка меняя описание товаров, чтобы побыстрее продвинуть ваш магазин.

Следует отметить, что если вы во время парсинга найдете в открытом доступе личные данные владельца или пользователей сайта, следует их об этом сразу уведомить, иначе, если они узнают, что вы спарсили их данные без их ведома, вы можете попасть под статью уголовного кодекса Российской Федерации номер 273 – неправомерный доступ к компьютерной информации, и тогда вы надолго можете забыть о парсинге, как и свободном пользовании компьютера.

Как работает парсинг?

Немного окунемся в теорию. Программа-парсер отправляет с вашего ip-адреса очень много запросов на нужный вам сайт во все его директории. Это можно сравнить с ребенком, который бегает по подъезду и стучит во все двери. И как ребенка могут наругать, так и ваш ip-адрес могут забанить, т.е. заблокировать на спарсенном вами сайте.

Это значит, что без использования средств виртуализации сети или подсети, зайти на этот сайт вам уже не получится. Поэтому при парсинге мы советуем пользоваться вам как минимум VPN-соединением, если сайт не ваш. Функционал парсера предельно важен, хороший парсер должен иметь:

- Выбор типа файлов для парсинга

- Смену User-agent

- Meta robots

- Возможность построения древа сайта

- Отделение дублей контента

- Выбор прокси и ВПН

Выбор программы.

На данный момент в сети существует огромное множество парсеров. Одни из них распространяются бесплатно и имеют открытый исходный код, а значит их можно легко найти на сайте github.com, другие распространяются на платной основе и имеют закрытый исходный код, третьи вообще являются расширениями для браузеров. И даже если вас не устроит подобное разнообразие решений, вы всегда можете написать свое на популярных языках программирования, если вы их знаете. Вот несколько примеров.

Парсеры с открытым исходным кодом.

Сразу скажу, что для использования программ с открытым исходным кодом нужно обладать нужными знаниями, в том числе и знанием английского языка, зачастую процесс использования замороченный. Если вам надо спарсить данные с какого-то популярного ресурса, то на вышеупомянутом сайте гитхаб вы можете воспользоваться поиском, вбив в него “название сайта parser”. На каждый популярный сайт такая программа найдется. Если же вы хотите более универсальных решений, так как нужный вам сайт не популярен, то советую эти варианты:

- Drupal – отличный модуль для парсинга html-страниц (гитхаб код)

- Parsedown – PHP парсер (гитхаб код)

- Sitemap – парсер всех ссылок на сайте, используется для создания поиска на сайте (гитхаб код)

Парсеры с закрытым исходным кодом.

Такие парсеры в основном гораздо удобнее, так как направлены на простоту использования и принесения создателям прибыли, и, конечно, за них нужно платить.

- Screaming Frog SEO Spider – британская программа парсер, считается многими лучшей в своем роде. Обладает всем нужным парсеру функционалом и даже больше. Стоит эта программа 150 фунтов стерлингов в год (почти 16000 рублей). Также имеет пробную версию на парсинг 500 ссылок и рядом ограничений.

- NetpeakSpider – хорошая программа для парсинга, отличная альтернатива предыдущей программе, версия с большинством удобств стоит 15 долларов в месяц, хотя бесплатная версия также присутствует.

- Comparser – обычный парсер, однако в отличии от других имеет функцию проверки индексируемости сайта в поисковых системах.

- Goodparser.ru — парсер номеров телефонов и email адресов с досок объявлений и справочников

Парсеры, как расширения браузера.

Подобные парсеры обычно работают хуже, а функционал у них урезанный, но их преимущество в мобильности и простоте использования.

- Scraper – расширение для браузеров Google Chrome, обладающее урезанным функционалом.

- Outwithub – расширение для браузеров Mozilla Firefox, обладает обширным функционалом.

- 80legs – веб инструмент для работы с большими объемами данных. Зарекомендовал себя сотрудничеством с PayPal.

Собственный парсер.

Также можно создать свой парсер, но на это уйдет много времени, особенно, если вы не знаете ни одного современного языка программирования.

Если вы захотите написать свой парсер сайтов на python, то я советую вам воспользоваться модулем под названием BeautifulSoup, также нам понадобится вспомогательная библиотека Selenium, она нужна для перехода по сылкам и загрузки html версии сайта. Полная инструкция по созданию простейшего парсера на питоне есть здесь.

Парсинг контактных данных.

Зачастую применяется парсинг контактных данных с того или иного сайта, таких как электронная почта и номер мобильного телефона. Причины этого могут быть разные, например: оповещение посетителей своего сайта, рекламные рассылки или мошенничество. Последний вариант мы, конечно, рассматривать не будем.

Для парсинга адресов электронных почт и телефонов удобнее всего использовать программу под названием LetsExtractEmailStudio, она совмещает в себе огромный функционал и удобство использования именно для сбора контактных данных. Стоит эта программа 80 долларов, эта цена за так называемый полный комплект. Демоверсия также присутствует.

После того как мы скачали и запустили демоверсию, мы можем начать парсить данные с нашего сайта. Нажимаем кнопку “New Search” и выбираем в появившемся окне нужный сайт, в программе откроется браузер, который загрузит сайт, далее ищем нужную страницу сайта и нажимаем кнопку “Extract Members”, после этого вас могут попросить ввести данные аккаунта, потому что сейчас многие сайты, такие как фейсбук и вконтакте, ограничивают использование своих сервисов незарегистрированным пользователям. После введения данных вам перекинет на главынй экран приложения, где будут появляться электронные почты, и, возможно, прилагающиеся к ним другие контактные данные.

Если вы уже купили про версию, то вы также можете проверить электронную почту на валидность, то есть существует ли еще эта почта.

Кликаем на ту же кнопку “New Search”, выбираем пункт “Extract Email”, и выбираем файл с электронными почтами с вашего компьютера и нажимаем на пункт “Email Verify”, готово. Как видите, программа достаточно простая, но при этом функциональная.

Ограничения парсеров.

Однако какими бы парсеры не были мощными и функциональными, есть несколько методов противодействия им, которые могут использоваться владельцами сайтов.

- Разграничение прав доступа. Владелец сайта может закрыть доступ к материалам сайта для всех, кроме администраторов этого сайта.

- Закрытие сайта для роботов. Большинство сайтов по умолчанию мимикрируют под поисковых роботов компаний Google или Yandex, которые проходятся по всем сайтам, чтобы добавить их в свою поисковую выдачу, однако владелец сайта вправе решать, давать этим роботам доступ или нет, и может закрыть его.

- Блокировка по IP. Как мы уже писали выше, если парсить данные с сайтов в большом количестве, то ваш ip-адрес могут забанить, и вы уже не сможете зайти на сайт, если у человека, парсящего сайт, немного VPN, то его быстро заблокируют алгоритмы.

- Капча. Капча это набор проверок, чтобы отличить человека от алгоритма, и не дать алгоритму доступ к сайту. Вы могли видеть капчу на разных сайтах в виде выбора определенных картинок, связанных общей темой. Правильно настроенная капча может остановить любой парсер.

- Черные списки. В интернете лежит огромное количество баз данных ip-адресов, которыми пользуются парсеры, их можно внести в черный список, чтобы сайт не пропускал эти адреса.

- DDOS-специализированные программы. Данные программы, предназначенные для защиты сайта от перегруза посредством фильтрации роботов, могут в некоторых случаях отсеивать и парсеры.

Законность действа.

Законом Россиийской Федерации не запрещен сбор данных из открытых источников, однако запрещается:

- Выведение из строя сайта посредством парсинга данных, именуемое DDOS-атакой.

- Получение данных составляющих коммерческую или личную тайну.

- Публикация спарсенных данных, если они закреплены авторскими правами на уровне закона.

Парсинг, как заработок.

На разных фриланс площадках ежедневно появляется огромное количество объявлений, косвенно связанных с парсингом данных с сайтов. Это объявления о перепечатке карточек товаров со старой версии сайта на другом домене на новую, или копирование дизайна у сайта-конкурента. Если правильно расставить задачу, то нужная программа все сделает за вас, и вы легко сможете получить деньги за выполнение заказа.

Источник: wapico.ru