Кто и зачем хочет получить Nginx?

С тем, что происходит вокруг компании Nginx, IT-рынок уже определился, назвав происходящее попыткой рейдерского захвата. По мнению ряда экспертов, так называемые разработки open-source в принципе не должны быть объектом споров, так как распространяются бесплатно. А ключевой продукт Nginx — как раз из таких. Это самый популярный в мире веб-сервер, по сути, программа, благодаря которой мы можем пользоваться миллионами сайтов, в том числе Netflix и «ВКонтакте». Против основателей Nginx завели уголовное дело — в четверг у них дома прошли обыски.

Сначала некоторые СМИ сообщали, что инициатором иска мог быть Rambler, который утверждал, что бывшие сотрудники якобы разрабатывали свой софт, используя ресурсы компании. Посему и права на продукт должны принадлежать работодателю. Создатели же настаивали на том, что, придя в компанию в 2000 году, они уже имели проект на руках. По другой версии, интересантом мог быть Сбербанк, этим летом купивший 46,5% акций Rambler.

NGINX с нуля до профи. Nginx что это, как работает, как парсит конфиги?

Но все поменялось буквально за сутки. Первый глава совета директоров Rambler Сергей Васильев заявил, что Nginx никогда не упоминался в качестве актива Rambler, да и задач на разработку компания в принципе не давала. Кроме того, все права на предъявление исков IT-холдинг передал инвестиционной компании Lynwood, связанной со структурами совладельца Rambler Александра Мамута. Сбербанк в свою очередь поспешил дать понять, что не причастен ко всей этой истории и в целом ситуацией недоволен. Герман Греф выступил против уголовного расследования.

Но почему Rambler или Мамут вспомнили о компании и ее продукте лишь спустя 15 лет? Комментирует глава компании «Крибрум», бывший президент группы компаний Rambler Игорь Ашманов.

Игорь Ашманов экс-президент группы компаний Rambler «У меня есть ощущение, что люди реально не понимают, за что они схватились, и поэтому для них это был шок, когда поднялся такой хайп. Конкретно конечные следователи, они абсолютно не в теме. Они говорят, а что, у вас действительно не было никаких служебных заданий? Говорят, нет. А как же? Ну, мы сами придумывали, что сделать, как улучшить.

В каком смысле? Непонятно, и все. Мамут, возможно, это его юристы, чтобы выслужиться там. Моя гипотеза такая: при продаже Rambler « Сберу » — « Сберу » вешали лапшу, что Nginx принадлежит Rambler. И когда там стали разбираться, уже после продажи, то выяснилось, что это совершенно не так. И Мамуту сказали: ну, ты часть денег верни или ты там реши вопрос.

И он дал команду решать вопрос».

Как отмечают участники рынка, в нулевые интернет-холдинг часто приглашал в компанию «звезд» программирования и, понимая, что не может дать им высокую зарплату, позволял параллельно работать над сторонними проектами. Некоторые объясняют происходящее тем, что Nginx за 670 млн долларов продали американской компании F5 Networks. Один из выводов, который делает сам основатель стартапа Игорь Сысоев, таков: структуры, косвенно связанные с Nginx, осознали, что в истории замешаны большие деньги и их очень хочется получить. Продолжает генеральный директор группы компаний InfoWatch Наталья Касперская.

[NGINX] ЗА 3 МИНУТЫ // КОРОТКИЙ ЛИКБЕЗ

Наталья Касперская генеральный директор группы компаний InfoWatch «По нашему времени речь идет о том, чтобы старую какую-то историю, якобы с похищением авторских прав, вытащить в тот момент, когда компания продалась за большие деньги. По сути, речь идет о попытке как-то присосаться к этим деньгам. Кроме того, он же писал открытый код, он выложен, его можно посмотреть, разработчики его могут посмотреть, там везде стоит копирайт Сысоева, и подобного рода захват — это удар по отрасли в целом».

Эксперты говорят, что это уголовное дело — катастрофа для российского IT-рынка. Высокотехнологические компании сделают свои выводы и попробуют перевести свой бизнес в другие юрисдикции. Туда, где можно заниматься разработками, не отвлекаясь на суды.

Если же говорить о реакции отрасли, то айтишники Nginx поддержали. «Яндекс» и Mail.ru, пусть и не упоминая компанию напрямую, заявили, что любой софт с открытым кодом, а значит, доступный разработчикам по всему миру, необходимо поддерживать и защищать. Даже инженерная команда компании Okko, к слову, принадлежащей Rambler, выступила с поддержкой Сысоева и Коновалова. В Сети появился логотип ЯN, то есть ЯNginx.

Преследование основателей компании Nginx прокомментировал глава Mail.Ru Group Борис Добродеев. «Эта история опасна с точки зрения репутации нашего рынка», — сказал Добродеев в интервью РБК.

Действующий же владелец Nginx американская F5 Networks считает, что все претензии в адрес разработчиков бессмысленны. «Сразу после указанных событий мы приняли меры, чтобы обеспечить безопасность программного обеспечения всех продуктов Nginx. Все они хранятся на серверах за пределами России. Другие продукты в России не разрабатываются», — добавили в F5.

Источник: www.bfm.ru

Nginx что это за программа

МЕРОПРИЯТИЯ

Alfa Digital Open

13 декабря Онлайн Бесплатно

F*ckup Meetup 2022

14 декабря Онлайн Бесплатно

Комментарии

Популярные По порядку

Не удалось загрузить комментарии.

ВАКАНСИИ

Backend Node.js разработчик

Москва, от 180000 RUB

Android — разработчик

Кемерово, от 80000 RUB

QA Engineer

Москва, до 150000 RUB

ЛУЧШИЕ СТАТЬИ ПО ТЕМЕ

Подборка материалов по HTML и CSS

В этой подборке представлены актуальные книги и видеоматериалы по HTML, CSS и верстке в целом для начинающих и продвинутых веб-разработчиков.

15 прекрасных плагинов для Sublime Text

Встречайте список первой необходимости – 15 самых нужных плагинов для Sublime, которые сильно упростят жизнь разработчику.

Изучение JavaScript с нуля

Рассказ программиста о том, как добиться успехов в изучении JavaScript.

Источник: proglib.io

Что за Nginx, о котором сейчас все говорят

В сети набирает обороты скандал вокруг Rambler и Nginx.

Поисковый гигант пытается получить права на один из самых популярных веб-серверов в мире. Его создал бывший выходец из Рамблера 15 лет назад.

Рассказываем по порядку, что это за компания, и в чем суть «разборок».

Что такое Nginx

Nginx — третий по популярности веб-сервер в мире и один из самый успешных российских IT-стартапов. Им пользуется более 447 млн сайтов по всей планете (это почти 40% всех сайтов в мире), включая Яндекс, Facebook, Instagram, Google, Netflix, Adobe, Cloudflare, WordPress.com и многие другие.

Простыми словами: это программа для развертывания собственного веб-сервера. Может использоваться как независимый полноценный сервер, так и прокси с переадресацией веб-запросов на другие сервера.

Этот сервис использует открытый исходный код и доступен любому для редактирования и подстраивания под свои нужды.

В своём первоначальном виде ПО функционировало для веб-обслуживания HTTP, но сейчас оно также служит обратным прокси-сервером, балансировщиком нагрузки HTTP, а также почтовым прокси-сервером для IMAP, POP3 и SMTP .

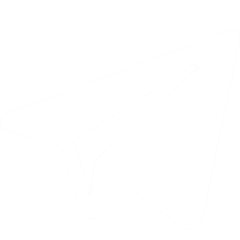

Примерная схема работы Nginx

Например, когда пользователь делает запрос на открытие страницы сайта, браузер связывается с сервером этой страницы. Затем сервер ищет файлы для страницы и отправляет их в браузер. Одно рабочее соединение может обрабатывать до 1024 запросов.

Nginx одновременно обрабатывает тысячи подобных запросов и распределяет нагрузку на загруженных сайтах, вроде облачных хранилищ, интернет-магазинов, поисковых систем и прочего. За счёт этого он и обрёл свою популярность.

В 2003 году Nginx стали использовать Звуки.ру, эстонский сайт знакомств Rate.ее и российский аналог Mamba. Год спустя на серверы компании перешёл сервис хранения фотографий от Рамблера.

Начал заниматься стартапом выходец из Rambler Group, программист Игорь Сысоев в 2002 году.

Кто такой Игорь Сысоев

Это непубличная личность, поэтому информации о нем не так много.

Игорь родился в 1970 году в Казахстане, провёл детство и школьные годы в Алма-Ате. После школы он отправился в Москву поступать в «Бауманку», но не сумел.

Вернувшись на родину, он устроился лаборантом в филиал Института повышения квалификации Министерства геологии СССР. Там на компьютерах «Искра-226» он учился программировать на Basic.

Позднее, в 1994 году, Сысоев всё-таки поступил в Университет им. Баумана и во время обучения написал небольшой антивирус AV. В 2000 году устроился на работу в Rambler.

Тогда мужчина администрировал различные сервисы Rambler и заметил, что сервер Apache нельзя отмасштабировать для большого числа посетителей сайта.

В 2002 году из технического интереса решил написать более произоводительный сервер и выкладывать результаты в открытый доступ.

Уже с 2011 года Nginx начала приносить прибыль и захватывать индустрию

В 2004 году появилась первая рабочая версия Nginx, а в 2011 Сысоев вместе с партнёром Максимом Коноваловым основал собственный стартап Nginx Inc.

Через два года фирма выпустила коммерческую версию Nginx Plus с дополнительными функциями. Тогда программисты и начали зарабатывать с больших корпораций. С момента основания компания привлекла $104 млн инвестиций .

В 2019 году разработчик облачных систем F5 Networks выкупил Nginx за $670 млн. Сысоев остался «у руля» и продолжил работать в офисе в Москве.

Что происходит прямо сейчас и какое отношение к этому имеет Rambler

4 декабря Rambler заявила о своих правах на Nginx и возбудила уголовное дело о нарушении авторских прав. А в офисах компании 12 декабря прошло несколько обысков.

Суть претензии в том, что Сысоев работал над сервисом, будучи сотрудником корпорации. При этом сам разработчик заявляет, что занимался веб-сервером в свободное от работы время.

Бывший исполнительный директор Rambler Group Игорь Ашманов подтвердил, что разработка ПО не входила в обязанности Сысоева, а у компании нет документов, которые могут подтвердить её позицию.

Rambler оценил ущерб в 51,4 млн рублей. Сейчас дело находится в полиции, решается вопрос о его рассмотрении в арбитражном суде. Пока Сысоеву и Коновалову не предъявили обвинений.

(26 голосов, общий рейтинг: 4.69 из 5)

Хочешь больше? Подпишись на наш Telegram.

Источник: www.iphones.ru

Nginx что это за программа

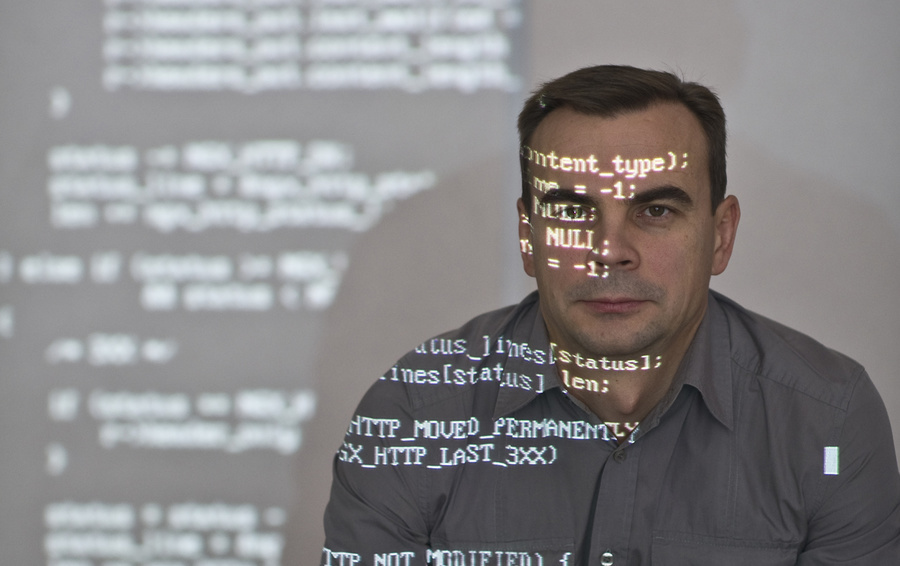

«исполнители» (workers) , а их количество ограничено. В рамках каждого «исполнителя» nginx может обрабатывать тысячи одновременных подключений и запросов в секунду.

Структура исходного кода

Исходный код «исполнителя» состоит из ядра и функциональных модулей. Ядро отвечает за поддержание работы цикла обработки событий и выполнение соответствующих модулей на каждом из этапов обработки запроса. Модули обеспечивают наибольшую функциональность на уровне представлений и уровне приложений. Модули считывают и записывают в сеть и на систему хранения, преобразуют данные, выполняют фильтрацию исходящего трафика, исполняют серверные операции и передают запросы вышестоящим серверам при включённом режиме проксирования.

Модульная архитектура nginx позволяет разработчикам расширять набор функций без изменения его ядра. Модули nginx подразделяются на несколько типов: модули ядра (core modules), обработчики событий (event modules), обработчики фазы (phase handlers), модули реализации протоколов (protocols), обработчики именованных переменных (variable), фильтры, модули перенаправления запросов на вышестоящие серверы (upstreams) и балансировщики нагрузки (load balancers).

В настоящее время nginx не поддерживает динамически загружаемые модули. То есть, модули компилируются вместе с ядром в один исполнимый файл на этапе сборки. Однако, поддержка загружаемых модулей и ABI запланирована на следующие major-релизы. Более подробную информацию о роли различных модулей можно найти в разделе 14.4.

При обработке операций, связанных с приёмом, обработкой и управлением сетевыми подключениями, извлечением данных, а также при дисковых операциях ввода/вывода, nginx для повышения производительности использует специфические механизмы уведомления о событиях, такие как kqueue , epoll и event ports , доступные в операционных системах Linux, Solaris и семействе BSD. Цель состоит в максимальном использовании возможностей операционной системы для обеспечения своевременной обратной связи, по своей природе асинхронной, при обработке входящего/исходящего трафика, дисковых операций, чтения или записи в сокеты, организации тайм-аутов и т.п. Используемые в nginx различные методы мультиплексирования и ускоренного ввода/вывода в значительной степени оптимизированы для каждой Unix-подобной операционной системы, на которой он запускается.

Обзорная схема архитектуры nginx представлена на рисунке 14.1

Рисунок 14.1: Схема архитектуры nginx

Модель исполнителя

Как уже упоминалось ранее, nginx не порождает новый процесс или поток для каждого соединения. Вместо этого исполнители принимают новые запросы из разделяемого прослушиваемого сокета и выполняют их в своих высокоэффективных циклах обработки, что позволяет обрабатывать тысячи соединений на каждого исполнителя . В nginx нет специализированных механизмов управления или перераспределения соединений между исполнителями, так как эта работа выполняется подсистемами ядра операционной системы. После запуска выполняется создание сокетов для приёма соединений. Затем исполнители непрерывно принимают, считывают и записывают в эти сокеты до тех пор пока выполняются обработка HTTP-запросов.

Непрерывный цикл обработки является самой сложной частью исходного кода исполнителя . Здесь широко используются внутренние вызовы и идея асинхронной обработки. Асинхронные операции реализованы с применением модульности, механизма сообщений о событиях, широкого использования функций обратного вызова (callback functions) и великолепно доработанных таймеров. В целом, во всём прослеживается принцип: все операции должны быть неблокирующими настолько, насколько это возможно. Единственная ситуация, когда nginx всё-таки применяет блокировку — это нехватка производительности дисковой подсистемы для исполнителя .

Так как nginx не порождает новый процесс или поток для каждого соединения, использование оперативной памяти очень экономичное и в подавляющем большинстве случаев крайне эффективное. nginx экономно использует ЦПУ в виду отсутствия постоянных созданий и удалений контекстов процесса или потока. Всё что делает nginx, это проверяет состояние сетевого подключения и дисковой подсистемы, инициирует создание новых соединений, переносит их обработку в цикл исполнителя и асинхронно обрабатывает их до завершения, после чего соединение освобождается и удаляется из цикла обработки исполнителя . Сочетание бережного использования вызовов syscall с аккуратной реализацией интерфейсов распределителей памяти pool и slab (pool and slab memory allocators) позволяет nginx достигать от умеренной до низкой загрузки ЦПУ даже при экстремальных нагрузках.

В связи с тем, что nginx использует несколько исполнителей для обработки соединений, он хорошо масштабируется на несколько ядер ЦПУ. В целом, распределение исполнителей по ядрам позволяет полностью использовать многоядерные архитектуры и предотвращает простой потоков и блокировки. В итоге, отсутствует нехватка ресурсов, а механизмы их контроля изолированы каждый в своём потоке исполнителя . Такая модель также позволяет достичь лучшей масштабируемости дисковой подситемы, способствует более эффективному её использованию и позволяет избежать блокировок при операциях ввода/вывода. В результате, ресурсы сервера используются более эффективно с распределением нагрузки между исполнителями .

Для достижения заданных паттернов использования дисковой подсистемы и ЦПУ число исполнителей может быть скорректировано. Для этого есть несколько основных правил, которые системные администраторы должны попробовать для своих рабочих нагрузок. Общие рекомендации могут быть следующими: если предполагается высокая нагрузка на ЦПУ (например, обработка большого количества TCP/IP запросов, обработка SSL или сжатие), то число исполнителей должно совпадать с количеством процессорных ядер; если предполагается высокая нагрузка на дисковую систему ввода/вывода (например, обслуживание запросов на выдачу данных или высоконагруженное проксирование), то число исполнителей должно быть в полтора-два раза больше, чем количество процессорных ядер. Некоторые инженеры выбирают количество исполнителей по количеству систем хранения или дисков, но эффективность такого подхода зависит от типа и конфигурации дисковой подсистемы.

Одной из основных проблем, которую разработчики nginx будут решать в ближайщих версиях, является существенное уменьшение количества блокировок при дисковых операциях ввода/вывода. На данный момент, если одному из исполнителей не хватает производительности дисковой подсистемы, то он может не снять блокировку на дисковый ввод/вывод пока не завершит свою операцию. Однако, существует целый ряд механизмов и директив конфигурационного файла для смягчения сценариев с блокировкой дискового ввода/вывода. В частности, комбинация опций sendfile и AIO обычно обеспечивает достаточный запас по производительности дисковой подсистемы. То есть, развёртывание nginx должно планироваться с учётом типа информации, к которой будет обеспечиваться web-доступ, объёма доступной оперативной памяти и архитектуры системы хранения данных.

Другая проблема в существующей модели исполнителя — это ограниченная поддержка встраиваемых скриптовых сценариев. В стандартной поставке nginx поддерживается встраивание скриптов только на языке Perl. Этому есть простое объяснение: встроенный скрипт может заблокировать выполнение любой операции или неожиданно завершиться. Любой из этих двух вариантов поведения может привести к зависанию исполнителя , что отразится на тысячах одновременных соединений, которые он обслуживал. Планируется проделать большую работу, чтобы сделать встраивание скриптовых языков более простым, надёжным и пригодным для широкого спектра применений.

Назначение процессов nginx

nginx запускает несколько процессов в оперативной памяти: один главный процесс и несколько процессов исполнителей . Также есть несколько специализированных процессов, в частности, загрузчик кеша и диспетчер кеша. В nginx версии 1.1 все процессы однопоточные. Все процессы для взаимодействия между собой используют механизмы разделяемой памяти (shared-memory machanisms). Управляющий процесс nginx (master process) запускается с привелегиями пользователя root . Загрузчик кеша, диспетчер кеша и исполнители запускаются от имени обычного непривелегированного пользователя.

- считывание и проверка на корректность файла настроек

- создание, подключение и удаление сокетов

- запуск, завершение и поддержание заданного количества исполнителей

- загрузка новых настроек без остановки работы

- управление бинарными обновлениями «на лету» (начиная от замены исполнимого файла и заканчивая откатом к предыдущему состоянию при необходимости)

- повторные открытия лог-файлов

- трансляция встроенных скриптов на языке Perl

Процессы исполнителей принимают, управляют и обрабатывают соединения от клиентов, обеспечивают обратное проксирование и фильтрацию, то есть, делают почти всё, на что спобен nginx. Что касается контроля за работой nginx, то системный администратор должен следить за состоянием процессов исполнителей , так как, фактически, именно они изо дня в день выполняют все операции web-сервера.

Процесс загрузчика кеша отвечает за контроль целостности кеша, хранящегося на диске, и заполнение базы данных с кешем мета-информации в памяти nginx. По сути, загрузчик кеша позволяет nginx работать с уже сохранёнными на жёсткий диск файлами, организованными в специальную структуру каталогов. При запуске он обходит все каталоги, проверяет целостность кеша мета-данных, обновляет соответствующие записи в разделяемой памяти и когда все устаревшие записи удалены, а остальные готовы к использованию, завершается.

Диспетчер кеша в основном отвечает за отслеживание истечения срока действия записей и маркирование их как недействительных. Он остаётся в оперативной памяти всё время работы nginx и в случае сбоя перезапускается вместе с главным процессом.

Краткий обзор кеширования в nginx

Кеширование в nginx реализовано в виде иерархически организованного хранилища в файловой системе. Ключи кеша настраиваемые, а информация, попадающая в кеш, может контролироваться с помощью различных специфичных для каждого типа запросов параметров.

Кеш ключей и кеш мета-данных хранятся в сегменте разделяемой памяти, к которой могут получить доступ диспетчер кеша и исполнители . В настоящее время кеширование в оперативную память отсутствует, кроме возможной оптимизации с помощью механизма виртуальной файловой ситемы средствами операционных систем. Кеш для каждого запроса располагается в отдельном файле в файловой системе. Иерархией кеша (уровни и способы именования) можно управлять с помощью директив конфигурационного файла nginx. При записи запроса в структуру каталогов кеша путь и имя файла вычисляются с помощью MD5-хеша проксируемого адреса URL.

Процесс размещения данных в кеше происходит следующим образом: при получении ответа от вышестоящего сервера nginx сохраняет его во временный файл вне структуры каталогов кеша. После завершения обработки запроса nginx переименовывает временный файл и перемещает его в каталог с кешем.

Если каталог для хранения временных файлов располагается в другой файловой системе, то он будет скопирован. Поэтому рекомендуется размещать каталог для временных файлов и кеш в одной файловой системе. Также вполне безопасно удалять файлы из каталога кеша в случае, когда явно видно, что они должны быть очищены. Также существуют сторонние расширения для nginx, которые позволяют дистанционно контролировать содержимое кеша, и в будущем этот функционал планируется интегрировать в основной дистрибутив.

Это произведение распространяется в соответствии с лицензией Creative Commons Attribution 3.0 Unported license . Для получения более детальной информации, пожалуйста, ознакомьтесь с полным описанием лицензии .

Источник: rus-linux.net

Настройка Nginx

Веб-сервер Nginx — это один из самых популярных веб-серверов с очень высокой производительностью и быстрой обработкой статических запросов от пользователей. При правильной настройке можно добиться очень высокой производительности от этого веб-сервера. Nginx очень быстро справляется со статическими файлами, будь то html страницы или другие виды ресурсов.

В одной из предыдущих статей мы уже рассматривали установку Nginx в Ubuntu и настройку его основных параметров, в этой же статье я хочу больше остановиться на производительности и подготовке веб-сервера к использованию в боевых условиях. Что касается дистрибутива Linux, то сегодня мы будем рассматривать CentOS, эта система часто используется на серверах и с настройкой Nginx тут могут возникнуть некоторые сложности. Дальше будет рассмотрена настройка Nginx CentOS, поговорим как включить полную поддержку http2, google pagespeed, и настроить основной конфигурационный файл.

1. Установка Nginx

В официальных репозиториях CentOS есть Nginx и он, скорее всего, уже установлен в вашей системе. Но мы хотим чтобы сайт работал по протоколу http2, который позволяет передавать все данные одним подключением, а это увеличивает производительность. Для работы по http2 вам понадобиться настроить SSL сертификат, но об этом уже написано в статье получение сертификата Lets Encrypt Nginx.

Но это еще не все. для переключения с обычного SSL на HTTP2.0 в большинстве браузеров сейчас используется протокол ALPN, а он поддерживается начиная с OpenSSL 1.02. В то время, как в репозиториях есть только OpenSSL 1.01. Поэтому нам нужно установить версию Nginx, собранную с OpenSSL 1.02. Для этого можно использовать Broken Repo:

sudo yum -y install yum-utils

# sudo yum-config-manager —add-repo https://brouken.com/brouken.repo

Если вы используете репозиторий EPEL, то нужно указать что не надо из него брать Nginx:

sudo yum-config-manager —save —setopt=epel.exclude=nginx*;

Теперь для установки правильной версии Nginx достаточно набрать:

sudo yum install nginx

Будет установлена самая последняя версия Nginx 1.13.2, с полной поддержкой ALPN. Дальше перейдем к настройке.

2. Настройка Nginx

Первым делом следует рассмотреть структуру конфигурационного файла. На первый взгляд, тут все может показаться очень запутанным, но там все достаточно логично:

глобальные опции

events <>

http server location<>

>

server <>

>

Сначала идут глобальные опции, которые задают основные параметры программы, например, от какого пользователя она будет запущена и количество процессов. Дальше есть секция events, в которой описано как Nginx будет реагировать на входящие подключения, затем идет секция http, которая объединяет все настройки касаемо работы протокола http. В ней находится секция server, каждая такая секция отвечает за отдельный домен, в секции server размещаются секции location, каждая из которых отвечает за определенный URL запроса, обратите внимание, что не файл на сервере, как в Apache, а именно URL запроса.

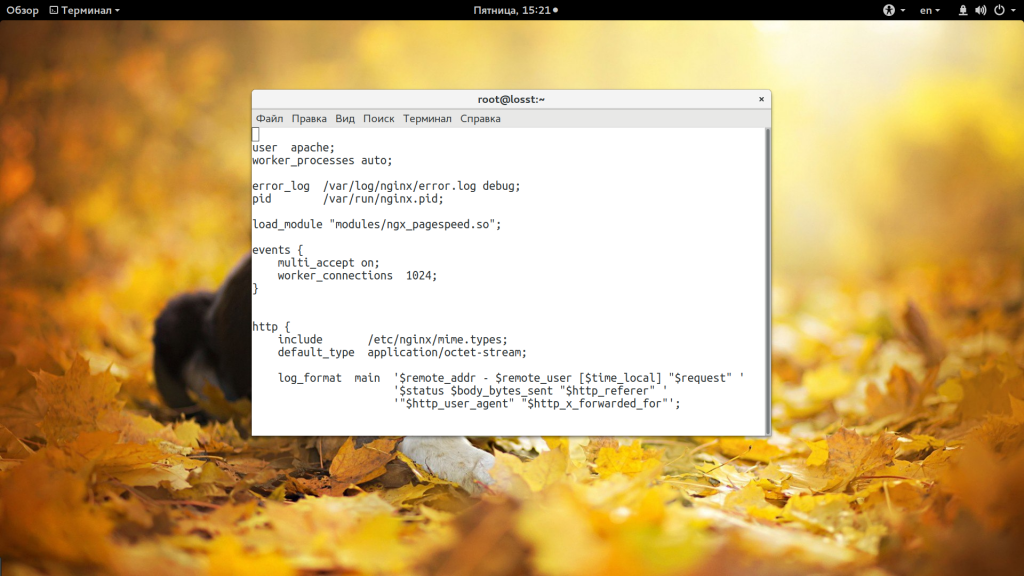

Основные глобальные настройки мы будем делать в файле /etc/nginx/nginx.conf. Дальше рассмотрим что именно будем менять и какие значения желательно установить. Начнем с глобальных опций:

- user — пользователь, от имени которого будет запущен сервер, должен быть владельцем каталога с файлами сайта, и от имени его же нужно запускать php-fpm;

- worker_processes — количество процессов Nginx, которые будут запущены, нужно установить ровно столько, сколько у вас есть ядер, например, у меня — 4;

- worker_cpu_affinity — этот параметр позволяет закрепить каждый процесс за отдельным ядром процессора, установите значение auto, чтобы программа сама выбрала что и к чему крепить;

- worker_rlimit_nofile — максимальное количество файлов, которые может открыть программа, на каждое соединение нужно как минимум два файла и каждый процесс будет иметь указанное вами количество соединений, поэтому формула такая: worker_processes * worker_connections* 2, параметр worker_connections разберем чуть ниже;

- pcre_jit — включите этот параметр для ускорения обработки регулярных выражений с помощью JIT компиляции;

В секции events стоит настроить два параметра:

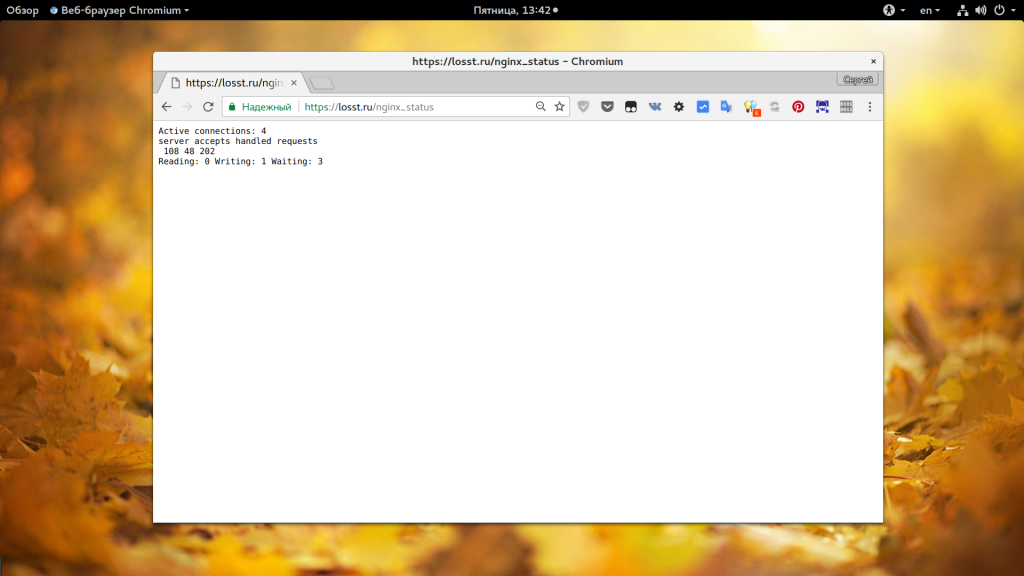

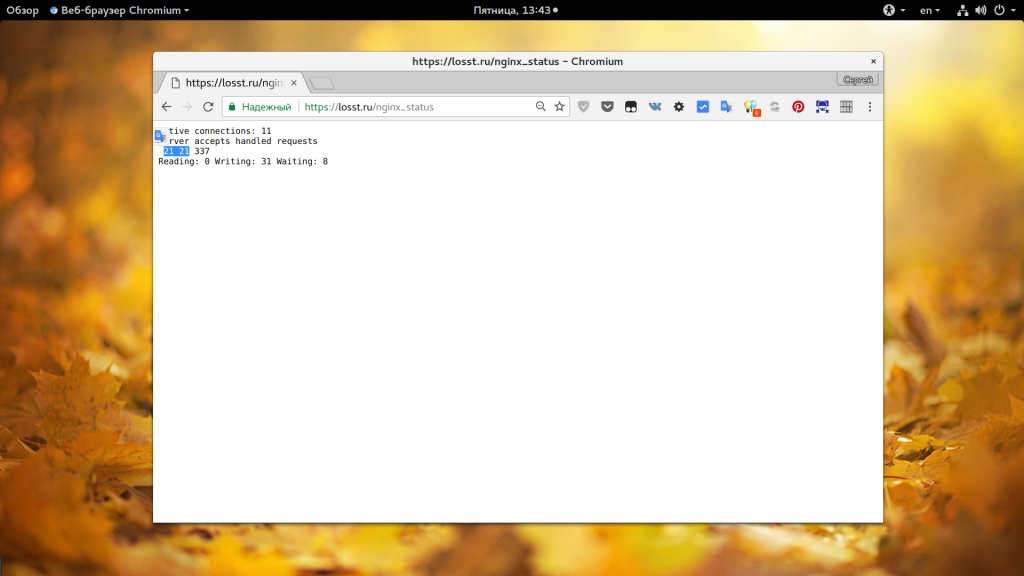

- worker_connections — количество соединений для одного процесса, должно быть достаточным для обработки входящих соединений. Сначала нам нужно знать сколько этих входящих соединений есть, для этого смотрим статистику по адресу ip_сервера/nginx_status. Как включить рассмотрим ниже. В строке Active Connections видим количество активных соединений с сервером, также нужно учесть что соединения с php-fpm тоже считаются. Дальше обратите внимание на поля accepted и handled, первое отображает обработанных подключений, второе — количество принятых. Из значения должны быть одинаковыми. Если отличаются значит соединений не хватает. Смотрите примеры, первый снимок проблема, второй — порядок. Для моей конфигурации оптимальной может быть цифра в 200 соединений (всего 800, учитывая 4 процесса):

- multi_accept — позволяет программе принимать несколько соединений одновременно, тоже ускоряет работу, при большом количестве соединений;

- accept_mutex — установите значение этого параметра в off, чтобы сразу все процессы получали уведомление про новые соединения;

Также в секции events рекомендуется использовать директиву use epoll, так как этот самый эффективный метод обработки входящих соединений для Linux, но этот метод применяется по умолчанию, поэтому не вижу смысла добавлять его вручную. Рассмотрим еще несколько параметров из секции http:

- sendfile — использовать метод отправки данных sendfile. Самый эффективный метод для Linux.

- tcp_nodelay, tcp_nopush — отправляет заголовки и тело запроса одним пакетом, работает немного быстрее;

- keepalive_timeout — таймаут поддержания соединения с клиентом, если у вас нет очень медленных скриптов, то будет достаточно будет 10 секунд, устанавливаем значение сколько нужно чтобы пользователь мог быть подключен к серверу;

- reset_timedout_connection — разрывать соединения после таймаута.

- open_file_cache — кэшировать информацию об открытых файлах. Например, open_file_cache max=200000 inactive=120s; max — максимальное количество файлов в кэше, время кэширования.

- open_file_cache_valid — когда нужно проверить актуальность файлов. Например: open_file_cache_valid 120s;

- open_file_cache_min_uses — кэшировать только файлы, которые были открыты указанное количество раз;

- open_file_cache_errors — запоминать ошибки открытия файлов.

- if_modified_since — устанавливает каким образом будут обрабатываться заголовки if-modified-since. С помощью этого заголовка браузер может получить ответ 304 если страница не изменилась с момента последнего просмотра. Возможны варианты — не отправлять — off, отправлять при точном совпадении времени — exact, отправлять если время совпадает точно или больше — before;

Вот как-то так будет выглядеть настройка nginx conf:

user nginx;

worker_processes 4;

worker_cpu_affinity auto;

worker_rlimit_nofile 10000;

pcre_jit on;

error_log /var/log/nginx/error.log warn;

load_module «modules/ngx_pagespeed.so»;

events multi_accept on;

accept_mutex off;

worker_connections 1024;

>

http sendfile on;

tcp_nopush on;

tcp_nodelay on;

open_file_cache max=200000 inactive=20s;

open_file_cache_valid 120s;

open_file_cache_errors on;

reset_timedout_connection on;

client_body_timeout 10;

keepalive_timeout 65;

include /etc/nginx/sites-enabled.*.conf

>

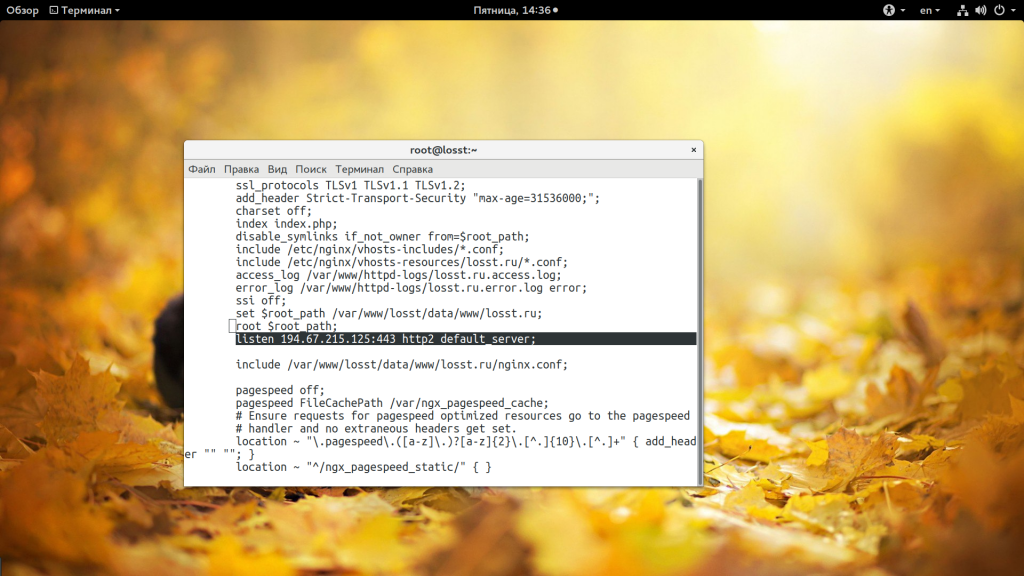

3. Настройка http2

Я не буду подробно описывать настройку секции server, потому что делал это уже в статье установка Nginx в Ubuntu и здесь мне нечего добавить, настройка SSL это достаточно обширная тема и тоже будет рассмотрена в отдельной статье. Но чтобы настроить http2 вам нужно иметь уже SSL. Далее, просто подправьте директиву listen в вашей секции server:

listen 194.67.215.125:443 default_server;

listen 194.67.215.125:443 http2 default_server;

Вот таким простым способом можно включить http2 если перед этим была установлена правильная версия Nginx.

4. Настройка PageSpeed

Google Pagespeed — это модуль Nginx, который выполняет различные оптимизации для того, чтобы страницы грузились быстрее, веб-сервер работал эффективнее, а пользователи не чувствовали дискомфорта. Сюда входит кэширование, оптимизация html кода, оптимизация картинок, объединение javascript и css кода и многое другое. Все это выполняется на уровне Nginx, поэтому эффективнее, чем если бы вы это делали в php. Но тут есть один недостаток, модуль удаляет заголовок Last Modified.

Дело в том, что PageSpeed устанавливает очень долгий строк кэширования для всех файлов, а в имя файла добавляет его хэш. Так скорость загрузки ресурсов выходит намного выше, поскольку браузер будет запрашивать файлы только с новым хэшем, а LastModified удаляется чтобы пользователи смогли увидеть изменения в случае если какой-либо файл будет изменен. А теперь рассмотрим как установить модуль. Нам придется собрать его из исходных кодов.

Сначала установите инструменты для сборки, очень важно, если не установите, потом получите ошибку и не будете знать что делать:

yum install wget gcc cmake unzip gcc-c++ pcre-devel zlib-devel

Скачайте и распакуйте исходники Nginx для вашей версии, например, 1.13.3:

wget -c https://nginx.org/download/nginx-1.13.3.tar.gz

# tar -xzvf nginx-1.13.3.tar.gz

Настройка сервера nginx не включает пере сборку и замену программы из репозитория, мы просто используем эти исходники для сборки модуля. Скачайте и распакуйте исходники PageSpeed:

wget -c https://github.com/pagespeed/ngx_pagespeed/archive/v1.12.34.2-stable.zip

# unzip v1.12.34.2-stable.zip

Скачайте и распакуйте библиотеку оптимизации PageSpeed в папку с исходниками модуля:

cd ngx_pagespeed-1.12.34.2-stable/

# wget -c https://dl.google.com/dl/page-speed/psol/1.12.34.2-x64.tar.gz

# tar -xvzf 1.12.34.2-x64.tar.gz

Скачайте и распакуйте исходники OpenSSL 1.02:

wget -c https://www.openssl.org/source/openssl-1.0.2k.tar.gz -O /opt/lib/$OPENSSL.tar.gz

# tar xvpzf openssl-1.0.2k.tar.gz

Теперь нам нужно собрать модуль. Сначала смотрим опции, с которыми собран текущий Nginx:

А теперь переходим в папку с Nginx, подставляем все полученные опции, опцию —add-dynamic-module для PageSpeed, OpenSSL и пробуем собрать:

cd nginx-1.13.3

# ./configure —prefix=/etc/nginx —sbin-path=/usr/sbin/nginx —modules-path=/usr/lib64/nginx/modules —conf-path=/etc/nginx/nginx.conf —error-log-path=/var/log/nginx/error.log —http-log-path=/var/log/nginx/access.log —pid-path=/var/run/nginx.pid —lock-path=/var/run/nginx.lock —http-client-body-temp-path=/var/cache/nginx/client_temp —http-proxy-temp-path=/var/cache/nginx/proxy_temp —http-fastcgi-temp-path=/var/cache/nginx/fastcgi_temp —http-uwsgi-temp-path=/var/cache/nginx/uwsgi_temp —http-scgi-temp-path=/var/cache/nginx/scgi_temp —user=nginx —group=nginx —with-compat —with-file-aio —with-threads —with-http_addition_module —with-http_auth_request_module —with-http_dav_module —with-http_flv_module —with-http_gunzip_module —with-http_gzip_static_module —with-http_mp4_module —with-http_random_index_module —with-http_realip_module —with-http_secure_link_module —with-http_slice_module —with-http_ssl_module —with-http_stub_status_module —with-http_sub_module —with-http_v2_module —with-mail —with-mail_ssl_module —with-stream —with-stream_realip_module —with-stream_ssl_module —with-stream_ssl_preread_module —with-cc-opt=’-O2 -g -pipe -Wall -Wp,-D_FORTIFY_SOURCE=2 -fexceptions -fstack-protector-strong —param=ssp-buffer-size=4 -grecord-gcc-switches -m64 -mtune=generic’ —with-ld-opt= —with-openssl=$HOME/openssl-1.0.2k —add-dynamic-module=$HOME/ngx_pagespeed-1.12.34.2-stable $

# make

Если все было сделано правильно, то на выходе вы получите модуль ngx_pagespeed.so в папке obj, его нужно скопировать в папку /etc/nginx/modules:

cp ngx_pagespeed.so /etc/nginx/modules/ngx_pagespeed.so

Создаем папку для кэша:

mkdir -p /var/ngx_pagespeed_cache

# chown -R nginx:nginx /var/ngx_pagespeed_cache

Теперь добавьте такую строчку для включения модуля в /etc/nginx/nginx.conf:

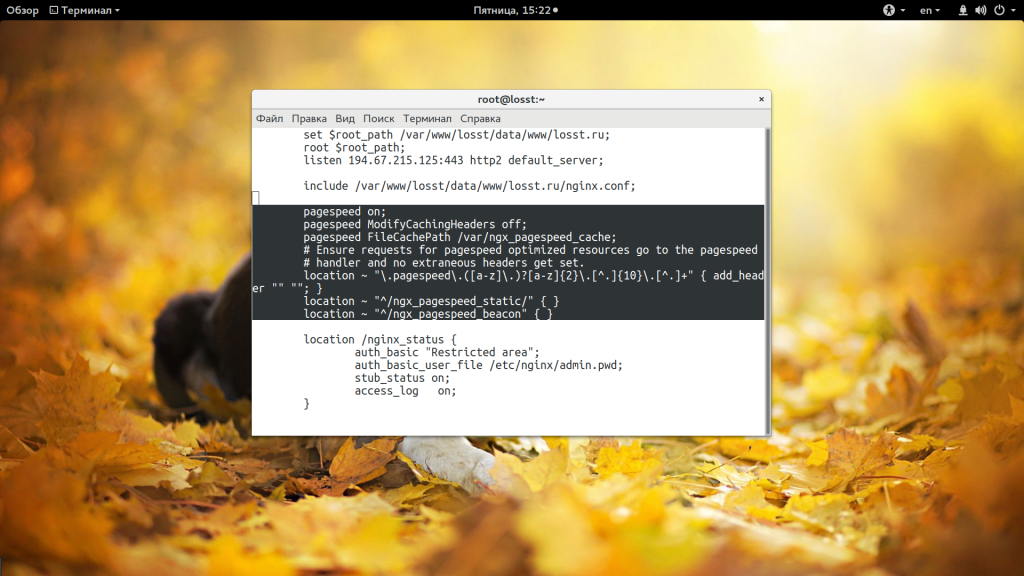

Затем, в секцию сервер достаточно добавить:

pagespeed on;

pagespeed FileCachePath /var/ngx_pagespeed_cache;

location ~ «.pagespeed.([a-z].)?[a-z].[^.].[^.]+» < add_header «» «»; >

location ~ «^/ngx_pagespeed_static/» < >

location ~ «^/ngx_pagespeed_beacon»

Теперь вам достаточно перезапустить nginx чтобы изменения вступили в силу:

nginx -t

# systemctl restart nginx

Выводы

Настройка Nginx завершена, возможно, остались еще и другие оптимизации, которые помогут ускорить Nginx, но они не войдут в эту статью. А какие оптимизации используете вы? Напишите обязательно в комментариях! Надеюсь, эта информация была полезной вам.

Источник: losst.pro