Apify SDK — это масштабируемая библиотека для сканирования и просмотра веб-страниц на Javascript. Позволяет обрабатывать данные и полностью автоматизировать работу по сбору данных. Есть несколько тарифных планов, в том числе и бесплатный со своими ограничениями.

Apify SDK может использоваться автономно в ваших проектах Node.js или запускаться как бессерверный микросервис в облаке Apify (собственный сервер Apify Cloud). При обходе сайтов используется анонимный прокси, динамический в том числе. Может быть создана кастомная разработка под вашу потребность по запросу.

- Автоматизирует любой веб-рабочий процесс

- Позволяет легко и быстро обходить сайты в Интернете, в том числе списком

- Работает локально и в облаке

- Работает на JavaScript

- Работает с прокси

Content Grabber

Обучение парсингу на Python, парсинг любых сайтов, в том числе SPA

http://www.contentgrabber.com/

Это мощное решение от компании Sequentum для сбора больших групп данных и главное надежного извлечения данных. Это позволит вам быстро и эффективно развернуть вашу компанию по сбору данных. Решение предлагает простые в использовании функции, такие как интуитивно понятный визуальный редактор.

- Извлекает данные быстрее чем другие похожие решения.

- Поможет вам в создании веб-приложения с помощью специального веб-API, который внедряется и позволяет выполнять сбор данных прямо с вашего сайта.

- Помогает вам переключаться между различными платформами (десктопная версия и серверная онлайн).

Data streamer

http://www.datastreamer.io

Data Stermer — инструмент помогает вам получать контент из всевозможных социальных сетей. Это позволяет извлекать метаданные с использованием обработки на естественном языке.

Простой в использовании API

Вы можете начать работу с Datastreamer менее чем за час. Если вы используете Java, вы сможете начать сбор данных за считанные минуты. Если вы используете другой язык, вам нужно анализировать только несколько файлов JSON каждые несколько секунд.

Построен на веб-стандартах

Создан с нуля, чтобы индексировать сырой HTML5. Сюда входят метаданные HTML, в том числе микроформаты и микроданные, — именно так Google и другие поисковые системы индексируют свой контент. Платформа также индексирует RSS и Atom (включая все 9 различных вариантов RSS). Обычные парсеры RSS хрупкие, но только не этот.

Надежная инфраструктура

Инфраструктура платформы является самой современной и предназначена для масштабирования. Все размещено на сверхбыстрых дисках SSD. Более 150 серверов в постоянной работе и компания хранит более 40 ТБ текстового контента. Каждый элемент инфраструктуры спроектирован с тройным резервированием и дополнительным оборудованием в режиме ожидания в случае сбоя. Data streamer контролируется 24/7 на предмет возможных ошибок в системе.

Секреты парсинга на Python | Как зарабатывать больше на фрилансе | Парсинг сайтов

- Интегрированный полнотекстовый поиск на базе Kibana и Elasticsearch.

- Интегрированное удаление шаблонов и контента на основе методов поиска информации.

- Построен на отказоустойчивой инфраструктуре и обеспечивает высокую доступность информации.

- Простая в использовании и всеобъемлющая консоль администратора.

Источник: parsing-cloud.ru

Парсинг сайтов конкурентов: 20 самых лучших сервисов

Привет. Меня зовут Лиза. Я изучаю различные решения по парсингу сайтов. За это время я смогла найти 20 наиболее полезных и удобных программ, которые показались мне самыми эффективными в работе с данными сайтов конкурентов.

Если вы далеки от сферы программирования и не имеете представления о том, что такое парсинг и почему его работа имеет такое большое значение в жизни любого бренда — приведу несколько причин.

Парсинг для цены.

Любой бренд, особенно начинающий, всегда старается сделать цену продукта более привлекательной. Парсер — лучший помощник в этом деле. Сервисы парсинга сайтов занимаются мониторингом цен на сайтах конкурентов. Они собирают информацию о скидках и акциях, и предоставляют вам готовый набор данных, на основе которых можно сформировать свою выгодную цену на товар.

Парсинг для наполнения сайта.

Благодаря парсеру вы сможете насыщать свой сайт новой информацией, добавлять блоки, которых у вас не было раньше, и заполнять карточки товаров более подробной информацией. Очень полезная штука, особенно, когда речь идет о новом сайте, который только начинает жить.

Парсер ловит нарушителей.

Сервисы парсинга довольно разнообразны и могут специализироваться на разных задачах. Как например, где-то функций по сбору цен может быть больше, где-то — меньше. Но в данном случае речь идет о программе по сбору данных о тех, чьи цены на товары нарушают РРЦ. Это полезная функция для брендов, которые производят свой продукт. Сервис обнаруживает нарушителей и рассылает им сообщения.

Довольно полезная и удобная функция.

Какие парсеры бывают?

- По назначению: мониторинг цен, сбор данных в определенной нише, парсинг данных для наполнения сайта.

- По способу доступа к интерфейсу: облачные программы и те, которые требуют установки на компьютер.

- По технологии: Серверы на основе языков программирования, расширения для браузеров, формулы в excel и Google таблицах.

Парсеры по назначению.

Сервисы мониторинга конкурентов.

Программы предназначены для мониторинга данных с сайтов по установленным требованиям. Такие сервисы, как правило, обладают широким спектром возможностей и умеют работать в режиме многозадачности.

Примеры сервисов для парсинга сайтов конкурентов:

Сайт с интуитивно понятным и очень удобным в использовании интерфейсом. Из полезных функций стоит выделить репрайсинг, с помощью которого пользователь может настроить сопоставление товаров таким образом, чтобы программа могла выводить рекомендованную цену на основе средней стоимости товара на рынке.

Также есть функции автосопоставления товаров и ручного контроля.

Программа предоставляет отчетность в любом формате и обеспечивает оперативную помощь в любых вопросах.

И еще, сервис предлагает бесплатный личный кабинет без регистрации.

Сервис парсинга сайтов практически с тем же функционалом. Парсер обеспечивает сбор данных с полным описанием товара и его стоимости и на выходе предоставляет данные в удобном и нужном вам формате.

Парсер мониторит сайты конкурнетов с учетом акций, скидок и любых новых обновлений или поступлений новых товаров. Парсер мониторит любые маркетплейсы (Яндекс.Маркет, e-katalog и другие прайс-агрегаторы.

Программа-специалист по сбору и обработки информации с любых сайтов, в том числе и маркетплейсов и других агрегаторов. Парсер регулярно мониторит сайты и предоставляет возможность добавлять или убирать товары в настройках, для этого следует обратиться к разработчику сервиса или ассистенту. Время для настройки инструмента — два дня.

Также разработчики обещают установить функцию автоматического обновления цен на вашем сайте.

Сервис гордится скоростью сбора и обработки данных по запросу клиента.

Парсеры по способу доступа к интерфейсу.

Облачные сервисы не требуют установку программы на ПК и сохраняют все данные в себе, вы скачиваете только полученные данные.

Доступ к программному обеспечению вы получаете через интерфейс или API.

Конечно, у программ есть бесплатная версия с ограниченным периодом использования, либо функционалом.

Программы-парсеры.

Программное обеспечение устанавливается на компьютер. Подобные парсеры подходят для OC Windows. Некоторые программы работают на съемных носителях.

Парсеры на основе Python и PHP.

Парсеры созданы программистами. Без навыков программирования создать такой парсер невозможно. Одним из самых популярных языков программ является — Python.

Примеры программ, которые будут полезны разработчикам:

- Beautiful Soup

- фреймворки с открытым исходным кодом Scrapy, Grab

Программы подходят для разработки парсера, настроенного для выполнения нестандартных задач.

Парсеры-расширения для браузеров.

Собирать данные сайтов можно благодаря бесплатным расширениям для браузера. Они извлекают данные из html-кода страницы с помощью языкового запроса Xpath и выгружают их в удобные для использования форматы: XLSX, CSV, XML, JSON, Google Таблицы и прочее.

Благодаря такому простому и бесплатному решению можно парсить данные с описанием товаров, цены и так далее.

Парсеры на основе excel.

Программа парсит данные и предоставляет их в формате XLS и CSV с помощью специальных автоматизированных функций в MS Excel.

Парсинг с помощью Google таблиц.

Парсить данные в гугл таблицах можно с помощью двух функций — importxml и importhtml.

- Функция IMPORTXML размещает данные формата XML, HTML, CSV, TSV, RSS, ATOM XML по ячейкам таблицы с помощью запросов Xpath

Как было сказано ранее, надежный сервис парсинга необходим каждому предпринимателю, стремящемуся увеличивать продажи и прибыль компании. Другой вопрос, насколько удобными или неудобными могут оказаться те или иные сервисы. Интернет-платформа полна сервисами мониторинга сайтов, каждый из которых обладает своими уникальными функциями, которые вашему бренду могут оказаться как нельзя кстати.

Источник: allrival.com

12 лучших сервисов для скрапинга данных

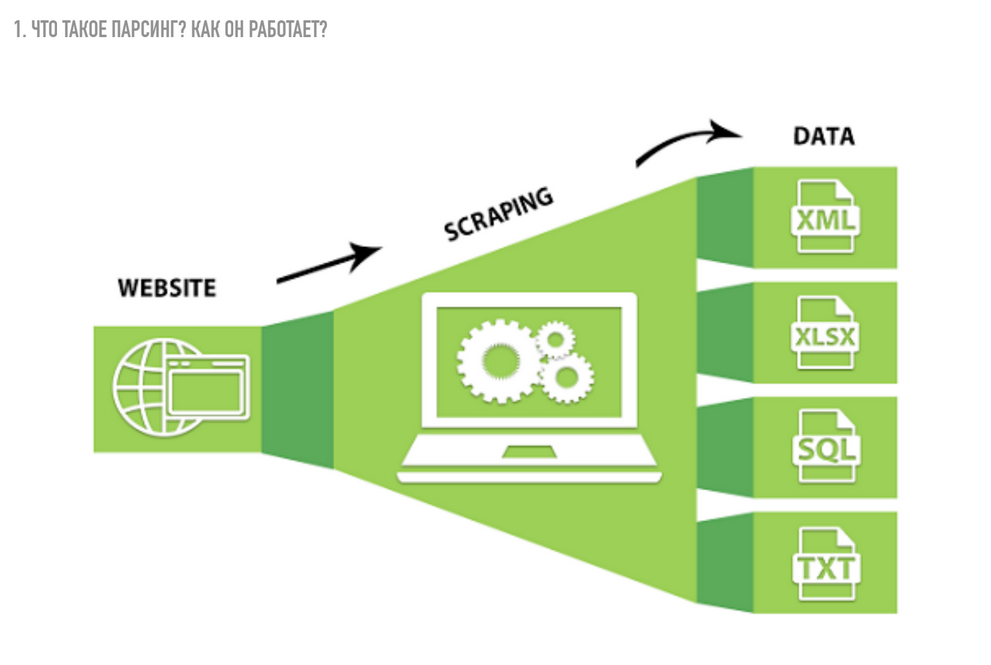

Существует ряд программных решений, которые позволяют извлекать, экспортировать и анализировать различные данные. Их основное направление – веб-скрапинг, а клиенты таких сервисов собирают данные с сайтов и конвертируют их в нужный формат.

Что такое веб-скрапинг, кому он нужен и какие сервисы для извлечения данных считаются лучшими – расскажу в сегодняшней статье.

Что такое скрапинг данных

Веб-скрапинг – это извлечение данных с сайта или приложения в понятном для обычного человека формате. Обычно эти данные сохраняются в таблицу или файл.

Такими данными могут быть:

- изображения;

- видеофайлы;

- каталог товаров;

- текстовый контент;

- контактные данные: адреса электронной почты, телефоны и так далее.

Все эти данные полезны для поиска потенциальных клиентов, сбора информации конкурирующих компаний, выявления тенденции развития рынка, маркетингового анализа и прочего.

Эта процедура сбора данных не запрещена, однако некоторые недобросовестные компании используют возможности скрапинга незаконно. Так, в октябре 2020 года Facebook подал в суд на две организации, которые распространяли вредоносное расширение для Chrome. Оно позволяло выполнять веб-скрапинг из социальных сетей без авторизации: в собранных данных содержался контент как публичного, так и непубличного характера. В последующем вся полученная информация продавалась маркетинговым компаниям, что является строгим нарушением закона.

Ну а для тех, кто собирается использовать веб-скрапинг для развития бизнеса, ниже я расскажу о лучших сервисах, которые предоставляют данную услугу.

Комьюнити теперь в Телеграм

Подпишитесь и будьте в курсе последних IT-новостей

Топ-12 сервисов для скрапинга данных

Большинство сервисов для скрапинга данных – это платное решение для сложных задач, но есть и условно-бесплатные, которые подойдут для простых проектов. В этом разделе мы рассмотрим и те, и другие варианты.

ScraperAPI

ScraperAPI позволяет получить HTML-содержимое с любой страницы через API. С его помощью можно работать с браузерами и прокси-серверами, обходя проверочный код CAPTCHA.

Его легко интегрировать – нужно только отправить GET-запрос к API с API-ключом и URL. Кроме того, ScraperAPI практически невозможно заблокировать, так как при каждом запросе он меняет IP-адреса, автоматически повторяет неудачные попытки и решает капчу.

Особенности:

- рендеринг JS;

- геотеги;

- пул мобильных прокси для скрапинга цен, результатов поиска, мониторинга соцсетей и прочего.

Стоимость: есть пробная версия, платные тарифы начинаются от $29 в месяц

Официальная страница: ScraperAPI

ScrapingBee

ScrapingBee использует API для скрапинга веб-страниц, который обрабатывает headless-браузеры и управляет прокси-серверами, обходя все типы блокировки. У сервиса также есть специальный API для парсинга поиска Google.

Особенности:

- рендеринг JS;

- ротация прокси;

- отлично взаимодействует с Google Sheets и Google Chrome.

Стоимость: от $49 в месяц

Официальная страница: ScrapingBee

ScrapingBot

ScrapingBot – это мощный API для извлечения HTML-содержимого. Компания предлагает API-интерфейсы для сбора данных в области розничной торговли и недвижимости, включая описание продукта, цену, валюту, отзывы, цену покупки или аренды, площадь, местоположение. Вполне доступные тарифные планы, JS-рендеринг, парсинг с веб-сайтов на Angular JS, Ajax, JS, React JS, а также возможность геотаргетинга делают этот продукт незаменимым помощником для сбора данных.

Особенности:

- рендеринг JS;

- качественный прокси;

- до 20 одновременных запросов;

- геотеги;

- есть расширение Prestashop, которое синхронизируется с сайтом для мониторинга цен конкурентов.

Стоимость: бесплатно или от €39 в месяц

Официальная страница: ScrapingBot

Scrapestack

Scrapestack – это REST API для скрапинга веб-сайтов в режиме реального времени. С его помощью можно молниеносно собирать данные с сайтов, используя миллионы прокси и обходя капчу.

Особенности:

- одновременные API запросы;

- рендеринг JS;

- шифрование HTTPS.

Стоимость: бесплатно или от $19.99 в месяц

Официальная страница: Scrapestack

ParseHub

ParseHub – это облачный онлайн-парсер, который является универсальным сборщиком любых данных и не требует специальных знаний. С помощью таких функций, как drag-and-drop, пользователи могут формировать элементы скрапинга. Это один из лучших инструментов для сбора данных, позволяющий загружать полученные данные в любом формате для последующего анализа.

Особенности:

- понятный для каждого пользователя графический интерфейс;

- экспорт данных в Excel, CSV, JSON или доступ через API;

- XPath, регулярные выражения, CSS-селекторы.

Стоимость: бесплатно или от $149 в месяц

Официальная страница: ParseHub

Datahut

Datahut – это возможность добыть данные любых крупномасштабных веб-сайтов с помощью облачной платформы для парсинга. Она позволяет пользователям получать и использовать структурированные данные в удобном им формате без использования серверов или дорогого программного обеспечения. Клиенты Datahut – это крупнейшие компании розничной торговли.

Особенности:

- есть мобильное приложение;

- облако, SaaS, удобный веб-интерфейс;

- отзывчивая техническая поддержка;

- эффективный, экономичный и простой в использовании сервис.

Стоимость: от $40 за один сайт

Официальная страница: Datahut

Octoparse

Octoparse представляет собой условно-бесплатное программное обеспечение для скрапинга веб-страниц, которое превращает неструктурированные данные в структурированный пак без необходимости кодирования.

Сбор данных осуществляется с любого динамического веб-сайта с наличием прокрутки, раскрывающихся списков, аутентификации при входе в систему и веб-страниц с поддержкой AJAX. Извлеченные данные можно экспортировать в базу данных в форматах API, HTML, CSV, TXT.

Благодаря автоматической ротации IP-адресов для предотвращения блокировки и возможности планирования последующего скрапинга этот парсер является одним из самых эффективных.

Особенности:

- работает с любым типом сайтов: с бесконечным скроллом, пагинацией, авторизацией, выпадающими меню и пр.;

- данные могут конвертироваться в Excel, CSV, JSON, API;

- данные хранятся в облаке;

- есть блокировка рекламы для ускорения загрузки и уменьшения количества HTTP-запросов;

- есть поддержка Windows и macOS.

Стоимость: бесплатно или от $75 в месяц

Официальная страница: Octoparse

Xtract.io

Xtract.io – комплексное решение для обнаружения, извлечения, управления и интеграции данных. Парсер предоставляет пользователям масштабируемую платформу для извлечения данных, которую можно настроить для сбора и структурирования данных с веб-страниц, социальных сетей, PDF-файлов, текстовых документов и электронных писем.

Особенности:

- парсинг каталогов, финансовых данных, данных об аренде, геолокационных данных, контактов, обзоров и рейтингов;

- настроенная система для автоматизации всего процесса извлечения данных;

- очистка и валидация данных по заданным параметрам;

- экспорт в JSON, текстовый документ, HTML, CSV, TSV;

- ротация прокси и прохождение капчи в режиме реального времени.

Стоимость: есть демоверсия, кастомные решения обсуждаются индивидуально

Официальная страница: Xtract.io

Datamam

Datamam – это сервис, предоставляющий услуги парсинга веб-страниц и обработки данных. Он основан на современных методах автоматического сбора данных с использованием специально разработанного программного обеспечения Python. Цель компании – предоставить пользователям сбор доступных данных и обеспечить преобразование необработанных данных в полезные аналитические сведения.

Особенности:

- мониторинг цен конкурентов и их маркетинговой активности;

- кастомизированные решения;

- быстрый и надежный парсинг, позволяющий автоматически извлекать данные с любого веб-сайта.

Стоимость: обсуждается индивидуально

Официальная страница: Datamam

Grepsr

Еще один сервис для веб-скрапинга под названием Grepsr. Он обеспечивает управляемый сбор данных и их извлечение через облачную платформу. Пользователи имеют возможность отмечать и извлекать данные с помощью автоматизированного процесса. Получение данных может быть запланированным, а загрузка данных осуществляться в различных форматах.

Особенности:

- удобная работа в облаке;

- отличная техническая поддержка;

- конвертация данных в XML, CSV, PDF, HTML;

- полностью оптимизированные процесс веб-скрапинга.

Стоимость: от $199

Официальная страница: Grepsr

Mozenda

Mozenda – это корпоративное программное обеспечение, разработанное для всех видов задач по извлечению данных. Сервису доверяют тысячи предприятий и более 30% компаний из списка Global Fortune 500. Он предлагает такие функции, как Job Sequencer and Request Blocking, которые необходимы для сбора веб-данных в реальном времени.

Программное обеспечение Mozenda работает на базе Windows, выполняя все процессы в облаке. Оно позволяет пользователям автоматизировать процесс сбора информации с веб-сайтов, просматривать, систематизировать и создавать отчеты по ней. Инструмент также может извлекать данные из различных типов и сложных структур страниц, списков и вложенных категорий. Функция захвата таблиц позволяет пользователям получать из таблиц большие объемы данных.

Особенности:

- совместимость с XPaths;

- предоставляет полный набор инструментов для парсинга и позволяет пользователям разбивать процесс на серию действий;

- работает крайне быстро и точно.

Стоимость: есть демоверсия, кастомные решения обсуждаются индивидуально

Официальная страница: Mozenda

Bright Data

Bright Data предлагает инструмент нового поколения, который позволяет получать автоматизированный и настраиваемый поток данных с помощью одной простой панели управления. Необходимо только отправить запрос, а всем остальным – IP-адресами, заголовками, файлами cookie, капчами – будет управлять система.

Особенности:

- круглосуточная техническая поддержка;

- данные можно собирать с любого крупномасштабного сайта;

- автоматически адаптируется к изменениям и блокировкам сайта;

- данные могут храниться в API, облачном хранилище Google и других сервисах.

Стоимость: от $350 в месяц за 100.000 страниц

Официальная страница: Bright Data

Заключение

Веб-скрапинг – это отличная возможность получить различные данные с сайтов конкурентов, которые в последующем помогут в разработке маркетингового плана, а также развитии бизнеса в целом. Сегодня мы рассмотрели лучшие сервисы, которые с этим справляются – в списке есть как платные, так и условно-бесплатные решения.

Если вам нужен анализ небольшого проекта, то из представленных сервисов вы сможете выбрать весьма экономичные варианты. В общем, выбор остается за вами!

Источник: timeweb.com