Чем парсинг полезен для бренда, который желает раскрутиться?

Парсер это инструмент для сбора и данных в интернете. Причем данные могут быть какими угодно.

Дело в том, что парсер способен отобрать именно ту аудиторию, для которой ваш товар или услуга будут наиболее актуальными.

Программа будет настроена таким образом, чтобы в результате ваш бренд смог получить только активных, “горячих” пользователей.

Иными словами, инструмент прокладывает путь от магазина к потенциальному клиенту, который на 100 процентов будет нуждаться в вашем продукте.

В чем преимущества парсера?

Очевидно, использование такого сервиса сэкономит ваше время, потраченное на поиск клиентов, и, конечно, сократит затраты на оплату дополнительного труда ваших сотрудников.

К тому же, потраченные деньги и часы не факт, что окупятся, поскольку объем работы довольно велик и среди казалось бы нужных клиентов могут оказаться те, кому это совершенно не интересно.

Бесплатный парсинг сайтов за 5 минут | allrival.com — сервис мониторинга цен конкурентов

Программа парсинга задаст правильное направление для рекламных рассылок и объявлений, гарантируя стопроцентное взаимодействие с пользователями.

Мы собрали для вас список из 10 лучших программ для сбора данных о пользователях в интернете.

Zengram

Считается одним из самых сильных сервисов парсинга данных пользователей.

Программа многофункциональная и умная. Может искать аккаунты по хештегам и ключевым словам, а еще собрать аудиторию подписчиков и подписок конкурентов в Instagram.

Помимо этого парсер может собрать данные с номерами телефонов, email и даже описание профиля и ссылки из био.

Данные можно расфасовать по категориям, полу, статусу и прочее. Зенграм способен отличить коммерческие аккаунты от личных.

Полный список данных можно получить в формате txt.

Дополнительная функция: инсташпион — занимается поиском пользователей, которые за последние 20 постов ставили лайки чаще всего.

Минимальная стоимость — 165 рублей

Есть пробный сбор за 1 рубль

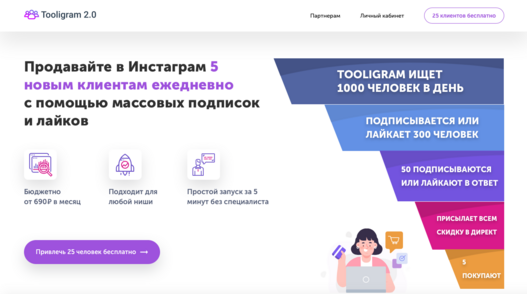

Tooligram

Сервис предоставляет доступ к различным алгоритмам поиска ЦА и множествам фильтров.

Программа может собирать логины аккаунтов подписчиков конкурентов по тегам, местоположениям, числу подписчиков, именам, даже рождения и прочее. Поскольку функций у программы очень много, разобраться в устройстве парсера дело непростое. Однако всегда можно обратиться за помощью к менеджерам сервиса.

Разработчики смогут настроить парсер так, как вам будет необходимо, и запустит его, предварительно согласовав все детали с вами.

Из минусов: некоторые пользователи жалуются на сбои в работе системы.

А еще, оплачивая разовый парсер, вы оформляете автоплатеж.

Вне зависимости от того, используете ли вы парсер или нет, деньги будут списываться автоматически.

Парсинг в Python за 10 минут!

Стоимость: 1 199 рублей в месяц

Pepper.Ninja

Преимущество парсера в том, что он может собирать данные с нескольких соцсетей одновременно. Программа сопоставляет данные из Инстаграма и ВКонтакте.

Какая информация берется: Возраст, пол, дата рождения, наличие или отсутствие детей, местоположение, музыкальные предпочтения, интересы и так далее.

Программа автоматически фильтрует “спящие” аккаунты, а также удаляет офферов и ботов.

Бывает что у клиентов нет времени парсить аудиторию, программа предоставляет уж готовую клиентскую базу по требуемым параметрам.

Основное внимание сервис концентрирует на парсинг аудитории ВКонтакте. За вступление в сообщество разработчики предлагают бесплатное использование аккаунта с небольшим ограничением по функционалу парсера.

Стоимость: 4900 рублей в месяц

Пробный период: 3 дня

Segmento Target

Программа с очень полезными функциями. Парсер способен собирать активных пользователей, которые ставят лайки и делятся публикациями, а также считывать оставленные комментарии и собирать контакты коммерческих аккаунтов.

Также парсер собирает контакты новых только что подписавшихся пользователей.

Разработчики позволяют клиентам самостоятельно собирать данные с помощью инструмента или поручать это специалистам сервиса.

За плечами компании большой опыт, поэтому за все время существования сервис успел подготовить большое количество кейсов по продвижению.

В случае вопросов по технической части, тех. поддержка сможет не только разъяснить вам все эти аспекты, но и предложить действенную стратегию поиска нужных пользователей

Стоимость: 200 рублей в месяц

Пробный период: 1 день

InstaParser

Программа собирает как логины пользователей Инстаграм, так и номера телефонов, что дает возможность осуществлять рекламные рассылки по Whatsapp, Viber или Telegram.

Единственное, вариантов поиска данных о пользователях довольно мало, программа парсит только на страницах конкурентов либо по конкретным тегам. Фильтрация сбора тоже не включена, однако, есть возможность исключить аккаунты без привязки пользовательского номера.

В остальном, парсер вполне подходит для базового сбора данных пользователей и отлично выполняет свои функции.

В результате вы получаете готовые данные в формате excel, со всеми номерами, логинами и информацией “о себе”.

Стоимость лицензии: 2 000 рублей за 1 месяц

Instaturbo

Программа дает возможность собрать до 60 000 пользователей за раз. Парсер осуществляет поиск данных по хештегам и конкурентам.

Программа фильтрует базу от ненужных коммерческих аккаунтов и ботов.

И здесь нам встречаются минусы в процессе работы. Система фильтрации слабая, поскольку программа пропускает множество бизнес-аккаунтов, также есть множество невыгодных пользователю ограничений в работе с программой, как например, обязательная привязка аккаунта к номеру, размещение не менее 10 фотографий и другие странные запросы.

Зато есть возможность раскручивать сразу несколько аккаунтов одновременно.

Сервис предлагает пользователю воспользоваться услугой “под ключ”, которая открывает ряд дополнительных возможностей и предоставляет личного менеджера, который сможет разработать для вас хорошую стратегию продвижения.

Стоимость: 890 рублей в месяц

Тестовый период: 3 дня

SMMflow

Программа собирает данные пользователей по хештегам, конкурентам и геолокации, при желании можно настроить парсер под конкретные категории.

Парсер может работать с нескольких аккаунтов одновременно, просто периодически переключаясь с одного на другой. Программу можно контролировать.

Есть возможность корректировать любые задачи в процессе выполнения. В случае появления новой информации или некорректного введения данных, фильтров и прочего, изменения можно будет внести в любое время.

Перед использованием сервис предлагает просмотреть видеоролик по использованию инструмента.

Чтобы не тратить время за настройками парсера на нужный лад, всегда можно купить пакет услуг и довести все процессы до автоматизма.

Минимальная стоимость: 299 рублей в месяц

Тестовый период: 3 дня

Instatools

Онлайн платформа, созданная для парсинга пользователей по геолокации, регионам, хештегам, ключевым словам и прочее.

Фильтрации, к сожалению, не предусмотрено. Однако парсер находится на стадии доработки.

Из плюсов: сервис предлагает удобную форму регистрации в один клик, после чего можно воспользоваться пробной версией, однако, в программе будет предоставлен ограниченный набор функций.

В качестве вишенки на торте предлагаю почтить про бесплатные онлайн-сервисы.

У них также есть интересные функции и, пожалуй, они заслуживают вашего внимания.

Минимальная стоимость: 1 300 рублей

Тестовый период: 5 дней

Findgram

Программа с несколькими режимами поиска: через конкурентов, геометки и хештеги.

Помимо этого программа дает возможность парсить активных пользователей, которые любят лайкать, делать репосты и оставлять комментарии.

Парсер может собрать целевую аудиторию во ВКонтакте, на что способен не каждый платный ресурс.

Доступ к сервису бесплатный, а вот функции поиска оплачиваются баллами.

Допустим, парсинг 1 000 аккаунтов обходится пользователю в 1 000 баллов. Программа предоставляет 20 000 бесплатных баллов для пользования другими функциями.

SmartChecker

Программа не предназначена для парсинга данных через поиск. Для сбора информации вам потребуется загрузить список ваших подписчиков в формате txt и загрузить его в программу.

Программа соберет всю информацию о пользователях (пол, возраст, геолокация) и подготовит для вас полный портрет вашей целевой аудитории. Быстрый и автоматизированный результат. Программа скачивается и устанавливается на компьютер. Для безопасности данных бесплатный софт поддерживает работу с прокси.

Заключение

Напоследок хочу дать вам несколько советов по выбору парсера.

- Не переплачивайте и не покупайте тариф за парсер с большим количеством функций, которыми вы не будете пользоваться.

- Тестируйте работу сервиса, перед тем, как принять решение о покупке.

- И не доверяйте отзывам, поскольку не все они бывают честными.

Выбрать программу среди такого количества парсеров — дело не из легких. Надеюсь, эта статья помогла вам разобраться в работе сервисов и выбрать для себя самый комфортный парсер.

Источник: allrival.com

Парсинг данных: лучшие сервисы для веб-скрапинга

Часто у вебмастера, маркетолога или SEO-специалиста возникает необходимость извлечь данные со страниц сайтов и отобразить их в удобном виде для дальнейшей обработки. В этой статье мы разберемся, что такое скрапинг данных, и расскажем про семь сервисов для веб-скрапинга, которые не требуют знания кода.

Что такое скрапинг данных?

Веб-скрапинг (Web Scraping) — это способ извлечения данных с сайта или приложения (в понятном человеку виде) и сохранение их в таблицу или файл.

К категории полезных данных могут относиться:

- каталог товаров;

- изображения;

- видео;

- текстовый контент;

- открытые контактные данные — адреса электронной почты, телефоны и другая информация.

Это легальная техника, но иногда способы использования этих данных могут быть незаконными. Например, в октябре 2020 года Facebook подал жалобу в федеральный суд США против двух компаний, обвиняемых в использовании двух вредоносных расширений для браузера Chrome. Эти расширения позволяют выполнять скрапинг данных без авторизации в Facebook, Instagram, Twitter, LinkedIn, YouTube и Amazon.

Оба расширения собирали публичные и непубличные данные пользователей. Компании же продавали эти данные, которые после использовались для маркетинговой разведки — это нелегально.

Как используют полученные данные

У веб-скрапинга/парсинга очень широкий спектр применений. Например:

1. Отслеживание цен

Собирая информацию о товарах и их ценах, например, на Amazon или других платформах, вы сможете корректировать цены, чтобы опередить конкурентов.

2. Рыночная и конкурентная разведка

Если вы хотите поработать на новом рынке, то сначала нужно оценить свои шансы, а принять взвешенное решение поможет как раз сбор и анализ данных.

3. Модернизация сайтов

Когда компании переносят устаревшие сайты на современные платформы, они используют скрапинг сайта для быстрой и легкой выгрузки данных.

4. Мониторинг новостей

Скрапинг новостных сайтов и блогов позволяет отслеживать интересующие темы и экономит ваше время.

5. Анализ эффективности контента

Блогеры и контентмейкеры используют скрапинг для извлечения статистики о своих постах, видео, твитах в таблицу. Например, в этом видео автор статьи получает данные из его профиля на сайте Medium, используя веб-скрапер:

Сервисы для веб-скрапинга

Скрапинг требует правильного парсинга исходного кода страницы, рендеринга JavaScript, преобразования данных в читаемый вид и, по необходимости, фильтрации… Звучит суперсложно, правда? Но не волнуйтесь — есть множество готовых решений и сервисов, которые упрощают процесс скрапинга.

Вот 7 лучших инструментов для парсинга сайтов, которые хорошо справляются с этой задачей.

1. Octoparse

Octoparse — это простой в использовании скрапер для программистов и не только.

Цена: бесплатен для простых проектов, но есть и платные тарифы: 75 $ в месяц — стандартный, 209 $ — профессиональный.

Особенности:

- Работает на всех сайтах: с бесконечным скроллом, пагинацией, авторизацией, выпадающими меню и так далее.

- Сохраняет данные в Excel, CSV, JSON, API.

- Данные хранятся в облаке.

- Скрапинг по расписанию или в реальном времени.

- Автоматическая смена IP для обхода блокировок.

- Блокировка рекламы для ускорения загрузки и уменьшения количества HTTP запросов.

- Можно использовать XPath и регулярные выражения.

- Поддержка Windows и macOS.

2. ScrapingBee

Сервис ScrapingBee Api использует «безлоговый браузер» и смену прокси. Также имеет API для скрапинга результатов поиска Google.

Безлоговый браузер (headless-браузер) — это инструмент разработчика, с помощью которого можно тестировать код, проверять качество и соответствие верстке.

Цена: бесплатен до 1 000 вызовов API, после чего нужно выбрать платный тариф от 29 $ в месяц.

Особенности:

- Рендеринг JS.

- Ротация прокси.

- Можно использовать с Google Sheets и браузером Chrome.

3. ScrapingBot

ScrapingBot предоставляет несколько API: API для сырого HTML, API для сайтов розничной торговли, API для скрапинга сайтов недвижимости.

Цена: бесплатный тариф на 100 кредитов и платные тарифы: 47 $ в месяц для фрилансеров, 120 $ в месяц для стартапов и 361 $ в месяц для бизнеса.

Особенности:

- Рендеринг JS (безголовый Chrome).

- Качественный прокси.

- До 20 одновременных запросов.

- Геотэги.

- Аддон Prestashop, интегрирующийся на ваш сайт для мониторинга цен конкурентов.

4. Scrapestack

Scrapestack — это REST API для скрапинга веб-сайтов в реальном времени. Он позволяет собирать данные с сайтов за миллисекунды, используя миллионы прокси и обходя капчу.

Цена: бесплатный тариф до 1 000 запросов и платные тарифы от 19,99 $ в месяц.

Особенности:

- Одновременные API запросы.

- Рендеринг JS.

- Шифрование HTTPS.

- Более 100 геолокаций.

5. Scraper API

Scraper API работает с прокси, браузерами и капчей. Его легко интегрировать — нужно только отправить GET запрос к API с вашим API ключом и URL.

Цена: 1000 вызовов API бесплатно, тариф для хобби — 29 $ в месяц, для стартапов — 99 $ в месяц.

Особенности:

- Рендеринг JS.

- Геотэги.

- Пул мобильных прокси для скрапинга цен, результатов поиска, мониторинга соцсетей и так далее.

6. ParseHub

ParseHub — ещё один сервис для веб-скрапинга, не требующий навыков программирования.

Цена: бесплатный тариф, стандартный тариф — 149 $ в месяц.

Особенности:

- Понятный графический интерфейс.

- Экспорт данных в Excel, CSV, JSON или доступ через API.

- XPath, регулярные выражения, CSS селекторы.

7. Xtract.io

Xtract.io — это гибкая платформа, использующая технологии AI, ML и NLP.

Её можно настроить для скрапинга и структурирования данных сайтов, постов в соцсетях, PDF-файлов, текстовых документов и электронной почты.

Цена: есть демо-версия

Особенности:

- Скрапинг данных из каталогов, финансовых данных, данных об аренде, геолокационных данных, данных о компаниях и контактных данных, обзоров и рейтингов.

- Преднастроенная система для автоматизации всего процесса извлечения данных.

- Очистка и валидация данных по заданным правилам.

- Экспорт в JSON, текст, HTML, CSV, TSV.

- Ротация прокси и прохождение капчи для скрапинга данных в реальном времени.

Независимо от того, чем вы занимаетесь, парсинг веб-страниц может помочь вашему бизнесу. Например, собирать информацию о своих клиентах, конкурентах и прорабатывать маркетинговую стратегию.

Источник: www.reg.ru

8 инструментов для парсинга сайтов

Расширения для браузеров, облачные сервисы и библиотеки.

Google выдает пользователю релевантные ссылки благодаря мониторингу сети и парсингу сайтов. Программы парсинга используют не только для поиска близких к запросу ссылок, но и для сбора данных.

Рассказываем, как просканировать интернет и какое ПО вам понадобится.

Как устроен парсинг сайтов

Это автоматический сбор и систематизация информации с помощью ПО. Парсеры применяют, работая с большими объемами информации, которые сложно отсортировать вручную.

Парсингом сайтов часто занимаются роботы поисковиков. Инструмент также используют для анализа ценовой политики на сайтах-конкурентах и наполнения своих онлайн-ресурсов. Например, парсят сайты спортивной аналитики, чтобы обновлять информацию о ходе матчей, или мониторят комментарии в социальных сетях. Кроме того, платформы, которые отслеживают информацию о компаниях, применяют парсеры, чтобы автоматически добавлять новые сведения из госреестров.

Возможен и самопарсинг — поиск багов на своем сайте (продублированных или несуществующих страниц, а также неполных описаний продуктов).

Как противодействуют парсингу

Парсить и потом использовать можно только те данные, которые не защищены авторским правом или содержатся в открытых источниках. Иногда владельцы сайтов устанавливают защиту — за большую нагрузку на серверы нужно платить, а слишком интенсивный парсинг может вызвать DoS-атаку.

Способы защиты:

#1. Временная задержка между запросами (ограничивает доступ к информации для программы-парсера).

#2. Защита от роботов (установка капчи, подтверждение регистрации).

#3. Ограничения прав доступа.

#4. Блокировка IP-адресов.

#5. Honeypot — ссылки на пустые файлы или эмуляторы сервера, которые используют для обнаружения взломщиков или парсеров.

Как обойти защиту

Основная проблема парсера в том, что сайт видит признаки нетипичного поведения и блокирует доступ. Пользователи не открывают тысячи страниц за минуты. Поэтому задача парсера — выдать себя за обычного пользователя. Один из этапов — применение эмуляторов пользовательских инструментов. Они отправляют серверу HTTP-запросы с заголовком User Agent, то есть таким же, как у обычного пользователя.

Другой способ защиты — встроенный фрагмент JavaScript. Запуск фрагмента с браузера произойдет успешно, но при парсинге код HTML-страницы будет нечитаемым. Платформа node.js, которая позволяет запускать JS вне браузера, решает проблему.

Еще один вариант — использовать «безголовый» браузер. Это программа, которая копирует функции обычного браузера, но не имеет графического интерфейса. Она использует программное управление и может работать в фоновом режиме.

При большом количестве запросов с одного IP-адреса сайт может потребовать верификацию с помощью капчи. Некоторые из них можно расшифровать оптическим распознаванием символов, но лучше менять IP. Для этого используют прокси-серверы, которые запрашивают информацию с разных адресов.

XPath — язык запросов для доступа к частям документа XML, который используют для поиска элементов с определенным атрибутом. C его помощью реализуют навигацию в DOM (Document Object Model) — программном интерфейсе, который содержит информацию о структуре сайта, HTML и XML-документах.

Программы для парсинга

Расширения для браузера

Веб-приложения используют для простых задач. Такие расширения есть в каждом браузере. Они удобны для анализа маленького объема данных (до нескольких страниц).

Этот инструмент используют для извлечения данных из таблиц или информации со страницы в форматах XLS, CSV и TSV. Платный доступ добавляет новые функции. Например, API и анонимные IP.

Стоимость: бесплатно при просмотре до 500 страниц.

курсы по теме:

Расширение предназначено для импорта данных с сайтов. Есть возможность кликнуть на элемент страницы и выбрать все элементы такого типа на сайте.

В Scraper.AI доступна функция регулярного мониторинга изменений на веб-странице. Собранная информация экспортируется в форматы JSON, CSV и XLSX.

Стоимость: бесплатно первые 3 месяца, пакеты — от $49 до $249 в месяц.

Облачные сервисы

По сравнению с расширениями, у этих программ больше функций. Работа проходит в «облаке» через веб-интерфейс или API, а на компьютере сохраняются только результаты.

Этот сервис применяют для парсинга сайтов с высокой степенью защиты. Его использование требует навыков программирования.

Программа самостоятельно повторяет неуспешные запросы и обрабатывает капчу. А также приложение может визуализировать элементы, которые требуют рендеринга Javascript. Scraper API работает с Python, Ruby и PHP.

Стоимость: 1 тыс. бесплатных запросов API, пакеты от $29 до $249 в месяц.

Он использует ML-алгоритмы и computer vision при парсинге, а также работает с API и может автоматически определить тип URL-адресов. Diffbot регулярно парсит сеть и сохраняет результаты. Компания строит самый большой граф знаний — она соединяет факты о созданных продуктах, новостных событиях, результатах отчетов. Узнать больше о Diffbot можно здесь.

Стоимость: бесплатно первые 14 дней, пакеты Start и Plus — $299 и $899 в месяц.

Десктопные программы

Большинство десктоп-парсеров работают с Windows, но на macOS их можно запустить с виртуальных машин. Есть и кроссплатформенные решения.

Десктопные парсеры могут быть эффективнее облачных. Минус в том, что они используют операционную мощность компьютера.

Программа позволяет интегрировать и визуализировать собранные данные с помощью BI-системы Tableau. Поддерживает графический интерфейс обработки данных point-and-click. У ParseHub есть функция запланированного сбора датасета в установленный интервал времени. Сервис работает с Windows, Mac и Linux. Доступен в облачной и десктопной версии.

Стоимость: бесплатно при обработке до 200 страниц, пакеты Standard и Professional — $149 и $499 в месяц.

Библиотеки для создания собственного парсера

Библиотека на Java, которую используют для парсинга и автоматизации запросов в формате JSON. Это формат обмена данных в веб-приложениях, например, для отправки информации с сервера клиенту и отображения на сайте. Jaunt работает как браузер без графического интерфейса, что ускоряет его. В Jaunt обрабатывают выборочные HTTP-запросы и ответы, а еще есть доступ в DOM.

Стоимость: бесплатно

Библиотека для Python с открытым кодом. Фреймворк используют для парсинга. Особенность Scrapy — обработка запросов в асинхронном порядке: можно задавать команду, не дожидаясь завершения предыдущей. Также следующие запросы будут выполняться, даже если в обработке одного из них возникла ошибка.

В библиотеке можно установить паузу между запросами, а также регулировать число запросов с одного IP или домена.

Стоимость: бесплатно

Тоже библиотека на языке Python, но более простая. Обычно фреймворк используют для данных из HTML- и XML-документов. Чтобы открывать ссылки и сохранять собранные результаты, к Beautiful Soup необходимо подключить дополнительные библиотеки.

Стоимость: бесплатно

Источник: robotdreams.cc