Информационные технологии все больше проникают во все сферы жизни общества. Уже давно привычны оплата услуг через Интернет, пересылка документов в электронном виде, а поиск информации стал обыденностью.

В настоящее время можно найти много сравнительных обзоров и материалов в области поисковых технологий, но, в силу огромной скорости развития данной отрасли, они мгновенно устаревают. Несмотря на обилие проработанных материалов, экспериментов, технологии поиска постоянно меняются. Особенно это касается Рунета.

Поисковые технологии в интернете уже давно стали состоявшимся полноценным рынком.

Для поисковых систем — это борьба за пользователей, другими словами, трафик и его монетизация, в том числе с использованием альтернативных средств рекламы (баннерная, контекстная и др.). Для владельцев сторонних компаний — дополнительная реклама и возможность привлечения дополнительных клиентов средствами поисковых систем.

При возникновении рынка и спроса на нем, сразу же реагирует и «предложение». По мере развития поисковых систем до уровня «спроса» и «актуальности» (понимания для чего и по каким ключевым запросам компании занимать «топовые» позиции) появились и специалисты, которые оказывают услуги по оптимизации сайта под «требования» и «желания» поисковых систем.

Штрих сканер, автоматизация небольшого магазина своими руками.

В настоящее время в мировой практике уже устоялась такая профессия, как СЕО-оптимизатор (от англ. SEO — Search Engines Optimization), копирайтеры начали осваивать дополнительные сферы работы — написание «сео-оптимизированных» текстов, которые «нравятся» не только посетителям сайта, но и поисковым роботам, которые тоже иногда заглядывают. Специалисты, работающие в сфере СЕО, все чаще находят спрос на свои услуги, воздействуя на поисковые системы определенным образом, «помогая» владельцам сторонних компаний занимать первые строчки в «топах» выдачи по тематическим запросам.

При этой кажущейся монополии на рынке поисковых систем, существует очень жесткая конкуренция, но от этого многообразие различных сервисов не уменьшается, как казалось бы, а наоборот, увеличивается, приводя с собой в жизнь различные инновационные подходы к поиску информации и поисковым технологиям в целом.

Более формальное определение выглядит следующим образом:

«Поисковые системы интернета (поисковые машины, поисковики) — это автоматизированные службы, со специальным программным обеспечением для глобального поиска, предоставляющие пользователю информацию по введенному запросу в виде слов или словосочетаний. Рассмотрим подробнее принцип действия поисковых систем интернета.

Каждая поисковая система интернета обладает роботом (также встречаются названия spider и crawler), который просматривает обнаруженные в Интернете страницы, проходит по их ссылкам и вносит информацию о содержании страниц в базу данных поисковой системы. Этот процесс называется индексацией сайта. Спустя некоторое время робот автоматически проводит переиндексацию, чтобы зафиксировать изменения в документах.

Полное руководство по Google Forms — универсальный инструмент для опросов и сбора данных онлайн!

Режим деятельности у поисковых систем интернета различается. К примеру, Alta Vista обновляет индекс значительно реже поисковой системы Google.

После введения запроса, по команде пользователя включается программа, называемая поисковым механизмом. Эта программа сравнивает введенные пользователем ключевые слова с содержимым индекса, для нахождения соответствующих документов. Алгоритм поиска у поисковых систем интернета также отличается. Не всегда то, что Вы видите на первой странице в одной поисковой системе, встретится вам в другой. К тому же робот не человек и естественно, не может прочитать ваши мысли. Поэтому часто, бывает не просто найти нужную вам информацию. »

Автоматизация продвижения в поисковых системах

На ранних стадиях эволюции поисковых системах учитывалось малое количество факторов, влияющих на ранжирование в выдаче результатов поиска, поэтому, зная базовые принципы работы поисковых систем, можно было достаточно легко манипулировать результатами.

При дальнейшей эволюции число таких факторов росло в геометрической прогрессии, постоянно увеличивался уровень конкуренции и, в некоторый момент времени, этап развития технологии продвижения сайтов вышел на новый виток — начало автоматизации процессов.

В самом начале были заложены основы лишь для основных процессов — закупка ссылок на появившихся «ссылочных биржах».

Первыми среди них были sape.ru . Далее появился аналогичный сервис по работе со «статейным продвижением» — miralinks.ru . Данный сервис ставил за основу размещение ссылок «навсегда» в статьях, которые создавались специальным образом.

Такие способы продвижения получили широкое распространение, и прекрасно работают по настоящее время. Получив широкое распространение, многие «оптимизаторы» начали использовать «черные» и «серые» методы оптимизации, которые работали на тот момент в поисковых системах (например во времена работы алгоритма поисковой системы Яндекс под названием «Магадан»). Это стало резко замусоривать поисковую выдачу «нужными», но не релевантными результатами, что приводило к ухудшению качества поиска.

В результате, поисковые системы были вынуждены усложнять свои алгоритмы. Количество учитываемых факторов возросли в сотни, и даже тысячи раз.

Снова возрос фактор «уровня подготовленности и профессионализма» специалистов.

2008-09 года дали новый виток в развитии автоматизации систем продвижения сайтов. Были введены блоговые биржи ( http://blogun.ru ), была создана первая система автоматического продвижения сайта «под ключ» — http://promopult.ru .

Этот сервис обозначил себя, как сервис автоматизации продвижения, начиная от составления «семантического ядра» (списка продвигаемых слов, составленный на основе «тематичности», «конкурентности» (частоты запросов в поисковых системах) и других факторов), анализа существующих страниц сайта на основе сравнения с «конкурентами по топу», автоматизированной закупкой ссылок и другими связанными техническими аспектами, а также выводом отчетов о занимаемых позициях.

Следом за вышеупомянутым сервисом появились еще два:

- http://webeffector.ru/ , позиционирующий себя тоже как сервис автоматического продвижения, только с некоторыми особенностями. Среди них можно выделить отдельно вынесенный модуль расчет бюджета, необходимого для продвижения сайта без необходимости сообщать адрес сайта или регистрироваться в системе и ручной, модерируемый признанными гуру среди СЕО-специалистов, список площадок с бирж ссылок и статей.

- http://www.rookee.ru/ молодой, но бурно развивающийся сервис. Позиционирует себя как «дополнительные руки», помощник сео-оптимизатору.

Каждый из этих сервисов активно обсуждается, решения вносятся в режиме очень быстрой обратной связи.

Классификация поисковых систем

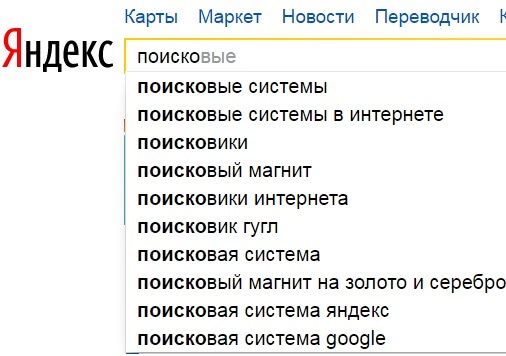

Практически все люди, использующие интернет в использовали «классические» поисковые системы. (например http://yandex.ru, http://google.com и другие)

В данной сфере очень популярными и «трастовыми» сообществами людей, обсуждающих все нововведения, веяния, «апдейты» (обновления в выдаче поисковых систем) и продолжают активно набирать новых пользователей множество форумов.

Среди них в качестве независимых можно выделить:

Cоздается множество систем анализа, систем предсказаний изменений (количественных и качественных). Например, http://tools.promosite.ru/ , http://analyzethis.ru/

В «классических» устоявшихся поисковых системах уже сформирован некоторый портрет основных посетителей, так, например, с поисковой системы http://mail.ru * большая доля трафика является «развлекательным» и в основном соответствует, либо молодежи, либо людям более старшей возрастной категории. Работники в сфере ИТ чаще в качестве поисковой системы пользуются результатами поиска от Google.

Несмотря на то, что рынок «разделен» между крупными гигантами в поисковой индустрии Рунета, некоторые компанию все равно выходят на рынок и находят свою аудиторию, хоть и меньшую.

Это прежде всего «специализированные поисковые системы» и «поисковики нового поколения».

Например, по данной ссылке http://inetgp.ru/internet-resursy/obzor-specializirovannyx-poiskovyx-sistem.html , проводится краткий обзор специализированных поисковых систем. Основные тенденции данного направления: выделить некоторую конкретную предметную область, например поиск по музыке.

«С появлением cистем пользовательского поиска от Google (Google Custom Search Engine) специализированные поисковые системы стали появляться как грибы после дождя.

В чем же их преимущества перед обычными поисковиками?

По сути оно только одно, но весьма весомое – если вы ищете информацию по какой-то узкой теме в специализированном поисковике, выдача, которую вы получите в результате вашего запроса, будет гораздо более чистой – вам не придется отсеивать десятки, а то и сотни ссылок рекламного характера и прочего мусора. Именно поэтому когда нужно найти что-то специфическое (например музыку, книги, информацию о товаре) я пользуюсь именно специализированными поисковыми системами.»

В блоге http://znayinternet.ru/poiskoviki-novogo-pokoleniya.html проводится обзор современных поисковых систем нового поколения.

Как правило, это системы объединяющие результаты поиска существующих поисковых систем , либо имеющие какую то «фишку», особенность. Например поисковая система http://Nigma.ru позиционирует себя как «интеллектуальную поисковую систему». В качестве предлагаемых ею «изюминок» своего поиска — возможность решать математические уравнения, технические задачи, составлять химические формулы и многое другое.

Несмотря на бурное развитие отрасли поисковых систем, саму информацию о качественных современных поисковых системах довольно непросто получить.

Последние события в поисковой области.

Не так давно в Рунете произошло несколько важных событий, посвященных, в том числе, СЕО.

Это, прежде всего, конференция РИФ+КИБ, которая прошла 23 апреля 2010 года, конференция eTarget 2010, Интернет Марафон, стартовавший в Иваново с интернет-фестиваля ClickFest 2010 в марте месяце.

На Кликфесте большинство поднимаемых проблем касались введения нового алгоритма ранжирования поисковой системой Яндекс — Снежинск, в основе которого лежит самообучающийся алгоритм MatrixNet; вопросы контекстной рекламы, которые были представлены компанией Begun; большой интерес посетителей вызвали доклады по развитию твиттера, вирусного маркетинга и построения нестандартных маркетинговых ходов в области поиска и рекламы в онлайн.

На конференции eTarget звучали более общие маркетинговые решения, тенденции и аналитика.

Наиболее интересными, с точки зрения изучения рынка СЕО услуг и тенденций развития поисковых систем, были доклады на конференции РИФ+КИБ.

В качестве примеров, хочу привести ссылку на статью «Яндекс: Некоторые аспекты поиска», построенную на основании выступления дружного коллектива во главе Александра Садовского, http://www.searchengines.ru/articles/008752.html

В данной статье четко сформулированы основные векторы развития поисковой системы Яндекс, некоторый отчет об уже сделанном и введенном и планируемых изменениях.

В данной статье-отчете http://2010.rif.ru/program/search/allowed/13/ с названием «Поиск: настоящее и перспективы» демонстрируются различные эксперименты выдачи поисковой системы Rambler.ru с представленной документированной презентацией http://2010.rif.ru/upload/8cb/23apr.rif2010—horujenko.ppt «Как пользователь воспринимает изменения, происходящие в поиске: в интерфейсах, качестве результатов поиска, рекламе, визуализации результатов поиска и т.п. Прогноз поведения пользователей и реальные факты. Всегда ли можно интерпретировать поведение пользователей. Когда необходима оценка экспертов. Краткосрочные и долгосрочные поведенческие метрики.»

Национальный поиск

В Рунете появился некий достаточно любопытный анонс, который на текущий момент не имеет материальной подоплеки — http://www.utro.ru/news/2010/03/26/883098.shtml — Планируется создание в России первого национального поисковика.

Достаточно примечательный факт, что основные игроки рынка поиска Рунета являются сторонними иностранными компаниями. Если «в случае» с Google это очевидный факт, то насчет Яндекса картина не такая однозначная.

http://ru.wikipedia.org/wiki/Yandex нам говорит, что «Я́ндекс — российская ИТ -компания»

С другой стороны, ранее имел резонанс некоторый факт, который остался тем не менее в истории Яндекса ( http://company.yandex.ru/about/interview/archive/2005/09-07_01.xml )

«100% собственности ООО «Яндекс» владеет кипрский офшор Yandex Technologies Ltd. В свою очередь 35,72% офшора принадлежит Ru-netHoldings, 10% – топ-менеджерам компании, остальная часть – частным инвесторам.»

Таким образом, у России на настоящий момент нет своего, «национального» поисковика.

Но все же, вопрос о создании своего национального поисковика поднимался уже не один раз. В том числе рассматривался вопрос покупки и «доработки» существующих крупных проектов (напр. Rambler или WebAlta).

Тенденции и варианты дальнейшего развития поисковых технологий

На мой взгляд, ближайшее время, революций в этой области не предвидится, но, тем не менее, некоторые изменения будут заметны.

В частности, набирает обороты «социальных поиск» — поиск в социальных медиа сетях. Пока что это исключительно медийный трафик, которым сложно управлять и монетизировать, но когда он сформируется, это будет неплохая подоплека.

Будет достаточно интересная борьба на рынке социальных сетей Рунета. С одной стороны это «Одноклассники», на которых «сидит» Москва (по статистике распределения аудитории), которые будут сдавать позиции из-за «излишней» монетизации проекта; «Вконтакте», который хочет сделать бесплатные сервисы, но первоначальная идея которого была взята с запада, и «Facebook», который неофициально объявлял (на уровне слухов, было объявлено официально, но я лично эту статью не видел и опираться на данные сведения, как на факт не буду) что 2 июня начинает активную фазу борьбы за долю на рынке России.

Также этому сопутствует развитие «Web 2.0 сферы» — это также блогинг и микроблогинг, чему способствует активное распространение «twitter».

Ну и еще не стоит забывать о том, что есть web 3.0, хоть и не имеющий четких формулировок, большого распространения, но в будущем еще сыграющего свою роль. Ярким примером таких сайтов среди западных ярких представителей можно назвать сайт http://last.fm/

Среди ярких представителей WEB 3.0 в Рунете, пожалуй, стоит отметить сайт http://imho.net/

Другими словами — это «рекомендательные» сервисы.

Выше был представлен общий обзор поисковых систем и систем автоматизации продвижения в них, с некоторым обзором форумов, блогов,некоторых других дополнительных материалов, а также, небольшое «резюме от автора», в виде моего личного мнения о перспективах развития рынка поисковых систем в интернете.

Интересные факты «внутренней жизни» поисковых систем описаны в статье http://www.searchengines.ru/articles/008545.html в русском переводе, с приведением документальных фактов:

«Патент Google:

Фильтрование результатов поиска с использованием аннотаций

Изобретатели: Patrick F. Riley, Ramanathan Guha

Принадлежит Google

US Patent 7,668,812

Утверждено 23 февраля 2010 года

Подано на рассмотрение 9 мая 2006 года

Аннотация:

Поисковая машина принимает запросы, включающие термины запросов и ярлыки, применимые к определенным документам. Фильтр домена создан так, что он фильтрует результаты поиска, оставляя определенные домены, которые определяются ярлыками, включенными в запрос. Фильтрованные результаты поиска обрабатываются таким образом, чтобы обеспечивать принадлежность определенных результатов поиска доменам, включенным в фильтр. Результаты обрабатываются дальше так, чтобы они включали ярлыки запросов с определенными результатами.»

Изучая поведение пользователей на странице выдаче, вполне естественно предположить, что сайты на 1 месте очень часто получают большую долю трафика по сравнению с сайтами, имеющими более худшие позиции.

Отсюда и расположение рекламных блоков с контекстной рекламой на страницах результатов выдаче (SERP).

Также на уровень CTR (отношению количества кликов на ссылку по отношению к количеству показов сайта на странице результатов поиска) влияют и другие факторы, например заголовок страницы, сниппет (краткое описание под заголовком ссылки).

Достаточно интересный обзор изменения распределения уровня CTR по тематикам и типам сайта после изменения дизайна страницы выдачи результатов поиска в поисковой системе Google написал Todd Heim ( http://www.searchenginejournal.com/why-google%E2%80%99s-redesign-could-be-good-news-for-social-marketers/20715/ )

В перспективе развития поиска, на мой взгляд, также возможна сегментация поиска. Развитие крупных систем, подобных Википедии, или небольшая модернизация Вики, и выделение ее в сферу информационного поиска, разделение новостного поиска, выделение коммерческого сегмента поиска через специализированные внешние сайты.

В данный момент аналогов таких систем, получивших огласку и какой-то общественный резонанс, мною найдено не было.

Источник: pugofka.com

Какие бывают поисковые системы и как они работают?

Интернет необходим многим пользователям для того, чтобы получать ответы на запросы (вопросы), которые они вводят.

Если бы не было поисковых систем, пользователям пришлось бы самостоятельно искать нужные сайты, запоминать их, записывать. Во многих случаях найти «вручную» что-то подходящее было бы весьма сложно, а часто и просто невозможно.

За нас всю эту рутинную работу по поиску, хранению и сортировке информации на сайтах делают поисковики.

Начнем с известных поисковиков Рунета.

Поисковые системы в Интернете на русском

1) Начнем с отечественной поисковой системы. Яндекс работает не только в России, но также работает в Белоруссии и Казахстане, в Украине, в Турции. Также есть Яндекс на английском языке.

p, blockquote 8,0,0,0,0 —>

2) Поисковик Google пришел к нам из Америки, имеет русскоязычную локализацию:

p, blockquote 10,0,0,0,0 —>

3)Отечественный поисковик Майл ру, который одновременно представляет социальную сеть ВКонтакте, Одноклассники, также Мой мир, известные Ответы Mail.ru и другие проекты.

p, blockquote 12,0,0,0,0 —>

4) Интеллектуальная поисковая система

Nigma (Нигма) http://www.nigma.ru/

С 19 сентября 2017 года «интеллектуалка» nigma не работает. Она перестала для её создателей представлять финансовый интерес, они переключились на другой поисковик под названием CocCoc.

5) Известная компания Ростелеком создала поисковую систему Спутник.

p, blockquote 17,0,0,0,0 —>

Есть поисковик Спутник, разработанный специально для детей, про который я писала ТУТ.

6) Рамблер был одним из первых отечественных поисковиков:

p, blockquote 20,0,0,0,0 —>

В мире есть другие известные поисковики:

- Bing,

- Yahoo!,

- DuckDuckGo,

- Baidu,

- Ecosia,

подробнее о них ЗДЕСЬ.

Попробуем разобраться, как же работает поисковая система, а именно, как происходит индексация сайтов, анализ результатов индексации и формирование поисковой выдачи. Принципы работы поисковых систем примерно одинаковые: поиск информации в Интернете, ее хранение и сортировка для выдачи в ответ на запросы пользователей. А вот алгоритмы, по которым работают поисковики, могут сильно отличаться. Эти алгоритмы держатся в тайне и запрещено ее разглашение.

Введя один и тот же запрос в поисковые строки разных поисковиков, можно получить разные ответы. Причина в том, что все поисковики используют собственные алгоритмы.

Цель поисковиков

В первую очередь нужно знать о том, что поисковики – это коммерческие организации. Их цель – получение прибыли. Прибыль можно получать с контекстной рекламы, других видов рекламы, с продвижения нужных сайтов на верхние строчки выдачи. В общем, способов много.

Прибыль поисковика зависит от того, какой размер аудитории у него, то есть, сколько человек пользуется данной поисковой системой. Чем больше аудитория, тем большему числу людей будет показываться реклама. Соответственно, стоить эта реклама будет больше. Увеличить аудиторию поисковики могут за счет собственной рекламы, а также привлекая пользователей за счет улучшения качества своих сервисов, алгоритма и удобства поиска.

Самое главное и сложное здесь – это разработка полноценного функционирующего алгоритма поиска, который бы предоставлял релевантные результаты на большинство пользовательских запросов.

Работа поисковика и действия вебмастеров

Каждый поисковик обладает своим собственным алгоритмом, который должен учитывать огромное количество разных факторов при анализе информации и составлении выдачи в ответ на запрос пользователя:

- возраст того или иного сайта,

- характеристики домена сайта,

- качество контента на сайте и его виды,

- особенности навигации и структуры сайта,

- юзабилити (удобство для пользователей),

- поведенческие факторы (поисковик может определить, нашел ли пользователь то, что он искал на сайте или пользователь вернулся снова в поисковик и там опять ищет ответ на тот же запрос)

- и т.д.

Все это нужно именно для того, чтобы выдача по запросу пользователя была максимально релевантной, удовлетворяющей запросы пользователя. При этом алгоритмы поисковиков постоянно меняются, дорабатываются. Как говорится, нет предела совершенству.

С другой стороны, вебмастера и оптимизаторы постоянно изобретают новые способы продвижения своих сайтов, которые далеко не всегда являются честными. Задача разработчиков алгоритма поисковых машин – вносить в него изменения, которые бы не позволяли «плохим» сайтам нечестных оптимизаторов оказываться в ТОПе.

Как работает поисковая система?

Теперь о том, как происходит непосредственная работа поисковой системы. Она состоит как минимум из трех этапов:

- сканирование,

- индексирование,

- ранжирование.

Число сайтов в интернете достигает просто астрономической величины. И каждый сайт – это информация, информационный контент, который создается для читателей (живых людей).

Сканирование

Это блуждание поисковика по Интернету для сбора новой информации, для анализа ссылок и поиска нового контента, который можно использовать для выдачи пользователю в ответ на его запросы. Для сканирования у поисковиков есть специальные роботы, которых называют поисковыми роботами или пауками.

Поисковые роботы – это программы, которые в автоматическом режиме посещают сайты и собирают с них информацию. Сканирование может быть первичным (робот заходит на новый сайт в первый раз). После первичного сбора информации с сайта и занесения его в базу данных поисковика, робот начинает с определенной регулярностью заходить на его страницы. Если произошли какие-то изменения (добавился новый контент, удалился старый), то все эти изменения будут поисковиком зафиксированы.

Главная задача поискового паука – найти новую информацию и отдать ее поисковику на следующий этап обработки, то есть, на индексирование.

Индексирование

Поисковик может искать информацию лишь среди тех сайтов, которые уже занесены в его базу данных (проиндексированы им). Если сканирование – это процесс поиска и сбора информации, которая имеется на том или ином сайте, то индексация – процесс занесения этой информации в базу данных поисковика. На этом этапе поисковик автоматически принимает решение, стоит ли заносить ту или иную информацию в свою базу данных и куда ее заносить, в какой раздел базы данных. Например, Google индексирует практически всю информацию, найденную его роботами в Интернете, а Яндекс более привередлив и индексирует далеко не все.

Для новых сайтов этап индексирования может быть долгим, поэтому посетителей из поисковых систем новые сайты могут ждать долго. А новая информация, которая появляется на старых, раскрученных сайтах, может индексироваться почти мгновенно и практически сразу попадать в «индекс», то есть, в базу данных поисковиков.

Ранжирование

Ранжирование — это выстраивание информации, которая была ранее проиндексирована и занесена в базу того или иного поисковика, по рангу, то есть, какую информацию поисковик будет показывать своим пользователям в первую очередь, а какую информацию помещать «рангом» ниже. Ранжирование можно отнести к этапу обслуживания поисковиком своего клиента – пользователя.

На серверах поисковой системы происходит обработка полученной информации и формирование выдачи по огромному спектру всевозможных запросов. Здесь уже вступают в работу алгоритмы поисковика. Все занесенные в базу сайты классифицируются по тематикам, тематики делятся на группы запросов. По каждой из групп запросов может составляться предварительная выдача, которая впоследствии будет корректироваться.

В каждой поисковой системе есть модераторы – люди, отвечающие за оценку сайтов и результаты выдачи по определенным группам запросов. Модераторы нужны для того, что контролировать работу поисковика, а также замещать алгоритм там, где он работает недостаточно хорошо (корректировать его работу). Модераторы могут вручную менять позиции тех или иных сайтов, если видят, что алгоритм поисковика в каких-то случаях сработал некорректно.

Голосование

Спасибо за Ваш голос!

Источник: www.inetgramotnost.ru

Поисковые системы

Поисковые системы – это полностью автоматизированные интерактивные службы поиска информации в Интернете по введенному пользователем текстовому запросу.

Создав и разместив в Интернете веб-сайт, разработчик регистрирует его адрес в поисковой системе, т.е. вносит URL стартовой странички в соответствующее поле на поисковом сервере. Вслед за этим специальная программа поисковой системы, называемая роботом, или спайдером, просматривает данный документ, проходит по всем обнаруженным на нем гиперссылкам и вносит информацию об обнаруженных страницах в базу данных поисковой системы, которая носит название индекса. Этот процесс носит называется индексацией веб-страниц. Как правило, индекс поискового сервера содержит только адреса веб-страниц и краткую аннотацию (70-150 символов), поясняющую их содержимое и почерпнутую из текста самих индексируемых документов. Спустя некоторое время робот автоматически проводит переиндексацию, в ходе которой удаляет из базы данных устаревшие и более недействительные ссылки.

Пользователь, обращаясь к поисковой машине, просто вводит в поле текстового запроса ключевые слова, характеризующие предмет его интересов. После того как он нажмет кнопку «искать», поисковый сервер передает управление другой программе, которая называется поисковым механизмом.

Эта программа сравнивает введенные ключевые слова с содержимым индекса, выявляя возможные соответствия. Например, получив запрос «идти», поисковый механизм может расширить диапазон поиска, включив в список ключевых слов глаголы «пойти», «шел», «шла», «пойдет» и т.д. Ссылки, в описании которых обнаруживаются подобные совпадения, автоматически включаются поисковым механизмом в файл отчета, предоставляемый пользователю в виде списка гиперссылок на найденные ресурсы с краткими текстовыми аннотациями для каждой из них. Степень соответствия обнаруженных таким образом ссылок исходному запросу называется релевантностью поиска.

Интерфейс большинства поисковых машин интуитивно понятен даже неподготовленному пользователю. Однако качество работы большинства поисковых систем все же не идеально, и релевантность предоставляемых ими отчетов зачастую оставляет желать лучшего. Поисковый механизм – не живой человек и какие бы совершенные эвристические методы анализа информации он не использовал, понимание многозначности некоторых слов и свойственное нам интуитивное восприятие разговорной речи ему, увы, недоступно. Поэтому в ответ на запрос «закон» вы можете получить и полный текст Гражданского кодекса РК, и формулировку закона всемирного тяготения, и русскую народную пословицу про закс и дышло.

Комментарий к тексту:

Индекс – база данных о проиндексированных роботом документах.

Поисковый робот – программа, которая просматривает веб-страницы и считывает их содержимое, следуя по ссылкам, найденным в документах.

Релевантность – степень соответствия обнаруженных ссылок исходному запросу пользователя.

Файл отчета – генерируемый роботом список гиперссылок на найденные ресурсы с краткими аннотациями.

Источник: studopedia.org