В начальный период развития Интернет, число его пользователей было невелико, а объем доступной информации относительно небольшим.

История развития поисковых систем

В начальный период развития Интернет, число его пользователей было невелико, а объем доступной информации относительно небольшим.

В большинстве случаев доступ к Интернет имели сотрудники различных университетов и лабораторий, а в целом Сеть использовалась в научных целях.

В это время задача поиска информации в сети Интернет была далеко не столько актуальной, как в настоящее время.

Одним из первых способов организации доступа к информационным ресурсам сети стало создание каталогов сайтов, в которых ссылки на ресурсы группировались согласно тематике.

Первым таким проектом стал сайт Yahoo, открывшийся в апреле 1994 года. После того, как число сайтов в каталоге Yahoo значительно увеличилось, была добавлена возможность поиска информации по каталогу. Это, конечно же, не было поисковой системой в полном смысле, так как область поиска была ограничена только ресурсами, присутствующими в каталоге, а не всеми ресурсами сети Интернет.

СЕКРЕТНАЯ СХЕМА ЗАРАБОТКА! ДАЖЕ САМЫЙ ТУПОЙ ЗАРАБОТАЕТ ПО ЭТОЙ СХЕМЕ

Каталоги ссылок широко использовались ранее, но практически утратили свою популярность в настоящее время.

Причина этого очень проста — даже современные каталоги, содержащие огромное количество ресурсов, представляют информацию лишь об очень малой части сети Интернет. Самый большой каталог сети DMOZ (или Open Directory Project) содержит информацию о 5 миллионах ресурсов, в то время как база поисковой системы Google состоит из более чем 8 миллиардов документов.

Первой полноценной поисковой системой стал проект WebCrawler появившийся в 1994 году.

В 1995 году появились поисковые системы Lycos и AltaVista. Последняя долгие годы была лидером в области поиска информации в Интернет.

В 1997 году Сергей Брин и Ларри Пейдж создали Google в рамках исследовательского проекта в Стэнфордском университете. В настоящий момент Google самая популярная поисковая система в мире.

23 сентября 1997 года была официально анонсирована поисковая система Yandex, самая популярная в русскоязычной части Интернет.

В настоящее время существует 3 основных международных поисковых системы — Google, Yahoo и MSN Search, имеющих собственные базы и алгоритмы поиска. Большинство остальных поисковых систем (коих можно насчитать очень много) использует в том или ином виде результаты 3 перечисленных. Например, поиск AOL (search.aol.com) и Mail.ru используют базу Google, а AltaVista, Lycos и AllTheWeb — базу Yahoo.

В России основной поисковой системой является Яндекс, за ним идут Rambler, Google.ru, Aport, Mail.ru и KM.ru.

Общие принципы работы поисковых систем

Поисковая система состоит из следующих основных компонентов:

Spider (паук) — браузероподобная программа, которая скачивает веб-страницы.

Crawler (краулер, «путешествующий» паук) — программа, которая автоматически проходит по всем ссылкам, найденным на странице.

Программа на Python для управления компьютером / Python + PyAutoGUI

Indexer (индексатор) — программа, которая анализирует веб-страницы, скаченные пауками.

Database (база данных) — хранилище скачанных и обработанных страниц.

Search engine results engine (система выдачи результатов) — извлекает результаты поиска из базы данных.

Web server (веб-сервер) — веб-сервер, который осуществляет взаимодействие между пользователем и остальными компонентами поисковой системы.

Детальная реализация поисковых механизмов может отличаться друг от друга (например, связка Spider+Crawler+Indexer может быть выполнена в виде единой программы, которая скачивает известные веб-страницы, анализирует их и ищет по ссылкам новые ресурсы), однако всем поисковым системам присущи описанные общие черты.

Spider. Паук — это программа, которая скачивает веб-страницы тем же способом, что и браузер пользователя. Отличие состоит в том, что браузер отображает информацию, содержащуюся на странице (текстовую, графическую и т.д.), паук же не имеет никаких визуальных компонент и работает напрямую с html-текстом страницы (вы можете сделать «просмотр html-кода» в вашем браузере, чтобы увидеть «сырой» html-текст).

Crawler. Выделяет все ссылки, присутствующие на странице. Его задача — определить, куда дальше должен идти паук, основываясь на ссылках или исходя из заранее заданного списка адресов. Краулер, следуя по найденным ссылкам, осуществляет поиск новых документов, еще неизвестных поисковой системе.

Indexer. Индексатор разбирает страницу на составные части и анализирует их. Выделяются и анализируются различные элементы страницы, такие как текст, заголовки, структурные и стилевые особенности, специальные служебные html-теги и т.д.

Database. База данных — это хранилище всех данных, которые поисковая система скачивает и анализирует. Иногда базу данных называют индексом поисковой системы.

Search Engine Results Engine. Система выдачи результатов занимается ранжированием страниц. Она решает, какие страницы удовлетворяют запросу пользователя, и в каком порядке они должны быть отсортированы. Это происходит согласно алгоритмам ранжирования поисковой системы. Эта информация является наиболее ценной и интересной для нас — именно с этим компонентом поисковой системы взаимодействует оптимизатор, пытаясь улучшить позиции сайта в выдаче, поэтому в дальнейшем мы подробно рассмотрим все факторы, влияющие на ранжирование результатов.

Web server. Как правило, на сервере присутствует html-страница с полем ввода, в котором пользователь может задать интересующий его поисковый термин. Веб-сервер также отвечает за выдачу результатов пользователю в виде html-страницы.

Все поисковые системы интернета в одном списке

Белорусские поисковые системы Tut.by Open.by Br.by (больше не работает) Zubr.com (больше не работает) All.by (больше не работает) Tit.by…

Чем отличается работа разных поисковых систем — Продолжение

История Яндекс — до Yandex поисковая система

Яндекс — поисковая система для русской морфологии Сегодня я хочу поговорить о компании Яндекс. Если проанализировать статистику посещаемости…

История компании Яндекс — дизайн Яndex история создания

Отцами-основателями Яndex (именно так, начиная с русской буквы, изначально писали название поисковика) считаются два человека: Аркадий Волож и…

Источник: knep.ru

Что такое поисковый робот? Функции поискового робота «Яндекса» и Google

Ежедневно в интернете появляется огромное количество новых материалов: создаются сайты, обновляются старые веб-страницы, загружаются фотографии и видеофайлы. Без невидимых поисковых роботов невозможно было бы найти во всемирной паутине ни один из этих документов. Альтернативы подобным роботизированным программам на данный момент времени не существует. Что такое поисковый робот, зачем он нужен и как функционируют?

Что такое поисковый робот

Поисковый робот сайтов (поисковых систем) – это автоматическая программа, которая способна посещать миллионы веб-страниц, быстро перемещаясь по интернету без вмешательства оператора. Боты постоянно сканируют пространство Всемирной паутины, находят новые интернет-страницы и регулярно посещают уже проиндексированные. Другие названия поисковых роботов: пауки, краулеры, боты.

Зачем нужны поисковые роботы

Основная функция, которую выполняют поисковые роботы, – индексация веб-страниц, а также текстов, изображений, аудио- и видеофайлов, находящихся на них. Боты проверяют ссылки, зеркала сайтов (копии) и обновления. Роботы также осуществляют контроль HTML-кода на предмет соотвествия нормам Всемирной организации, которая разрабатывает и внедряет технологические стандарты для Всемирной паутины.

Что такое индексация и зачем она нужна

Индексация – это, собственно, и есть процесс посещения определенной веб-страницы поисковыми роботами. Программа сканирует тексты, размещенные на сайте, изображения, видео, исходящие ссылки, после чего страница появляется в результатах поиска. В некоторых случаях сайт не может быть просканирован автоматически, тогда он может быть добавлен в поисковую систему вручную веб-мастером. Как правило, это происходит при отсутствии внешних ссылок на определенную (часто только недавно созданную) страницу.

Как работают поисковые роботы

Каждая поисковая система имеет собственного бота, при этом поисковый робот Google может значительно отличаться по механизму работы от аналогичной программы «Яндекса» или других систем.

В общих чертах принцип работы робота заключается в следующем: программа «приходит» на сайт по внешним ссылкам и, начиная с главной страницы, «читает» веб-ресурс (в том числе просматривая те служебные данные, которые не видит пользователь). Бот может как перемещаться между страницами одного сайта, так и переходить на другие.

Как программа выбирает, какой сайт индексировать? Чаще всего «путешествие» паука начинается с новостных сайтов или крупных ресурсов, каталогов и агрегаторов с большой ссылочной массой. Поисковый робот непрерывно сканирует страницы одну за другой, на скорость и последовательность индексации влияют следующие факторы:

- внутренние: перелиновка (внутренние ссылки между страницами одного и того же ресурса), размер сайта, правильность кода, удобство для пользователей и так далее;

- внешние: общий объем ссылочной массы, которая ведет на сайт.

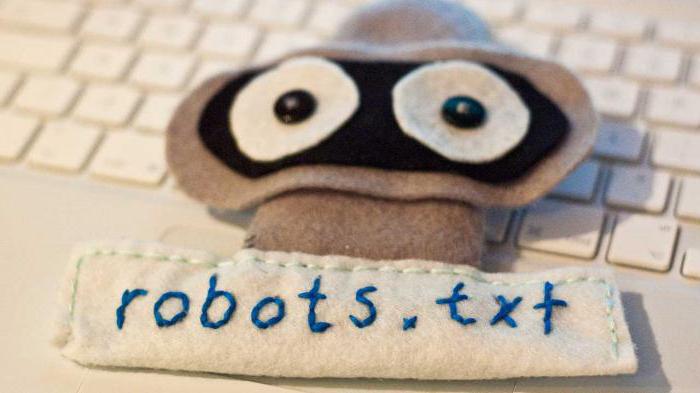

Первым делом поисковый робот ищет на любом сайте файл robots.txt. Дальнейшая индексация ресурса проводится, основываясь на информации, полученной именно от этого документа. Файл содержит точные инструкции для «пауков», что позволяет повысить шансы посещения страницы поисковыми роботами, а следовательно, и добиться скорейшего попадания сайта в выдачу «Яндекса» или Google.

Программы-аналоги поисковых роботов

Часто понятие «поисковый робот» путают с интеллектуальными, пользовательскими или автономными агентами, «муравьями» или «червями». Значительные отличия имееются только по сравнению с агентами, другие определения обозначают схожие виды роботов.

Так, агенты могут быть:

- интеллектуальными: программы, которые перемещаются от сайта к сайту, самостоятельно решая, как поступать дальше; они мало распространены в интернете;

- автономными: такие агенты помогают пользователю в выборе продукта, поиске или заполнении форм, это так называемые фильтры, которые мало относятся к сетевым программам.;

- пользовательскими: программы способствуют взаимодействию пользователя со Всемирной паутиной, это браузеры (например, Opera, IE, Google Chrome, Firefox), мессенджеры (Viber, Telegram) или почтовые программы (MS Outlook или Qualcomm).

«Муравьи» и «черви» больше схожи с поисковыми «пауками». Первые образуют между собой сеть и слаженно взаимодействуют подобно настоящей муравьиной колонии, «черви» же способны самовоспроизводиться, в остальном действуют так же, как и стандартный поисковый робот.

Разновидности поисковых роботов

Различают множество разновидностей поисковых роботов. В зависимости от назначения программы они бывают:

- «Зеркальными» — просматривают дубликаты сайтов.

- Мобильными – нацелены на мобильные версии интернет-страниц.

- Быстродействующими – фиксируют новую информацию оперативно, просматривая последние обновления.

- Ссылочными – индексируют ссылки, подсчитывают их количество.

- Индексаторами различных типов контента – отдельных программ для текста, аудио- и видеозаписей, изображений.

- «Шпионскими» — ищут страницы, которые еще не отображаются в поисковой системе.

- «Дятлами» — периодически посещают сайты, чтобы проверить их актуальность и работоспособность.

- Национальными – просматривают веб-ресурсы, расположенные на доменах одной страны (например, .ru, .kz или .ua).

- Глобальными – индексируют все национальные сайты.

Роботы основных поисковых систем

Существуют также отдельные роботы поисковых систем. В теории их функциональность может значительно различаться, но на практике программы практически идентичны. Основные отличия индексации интернет-страниц роботами двух основных поисковых систем состоят в следующем:

- Строгость проверки. Считается, что механизм поискового робота «Яндекса» несколько строже оценивает сайт на соответствие стандартам Всемирной паутины.

- Сохранение целостности сайта. Поисковый робот Google индексирует сайт целиком (в том числе медиаконтент), «Яндекс» же может просматривать страницы выборочно.

- Скорость проверки новых страниц. Google добавляет новый ресурс в поисковую выдачу в течение нескольких дней, в случае с «Яндексом» процесс может растянуться на две недели и более.

- Частота переиндексации. Поисковый робот «Яндекса» проверяет наличие обновлений пару раз в неделю, а Google – один раз в 14 дней.

Интернет, конечно же, не ограничивается двумя поисковыми системами. Другие поисковики имеют своих роботов, которые следуют собственным параметрам индексации. Кроме того, существует несколько «пауков», которые разработаны не крупными поисковыми ресурсами, а отдельными командами или веб-мастерами.

Распространенные заблуждения

Вопреки распространенному мнению, «пауки» не обрабатывают полученную информацию. Программа только сканирует и сохраняет веб-страницы, а дальнейшей обработкой занимаются совершенно другие роботы.

Также многие пользователи считают, что поисковые роботы оказывают негативное воздействие и «вредны» интернету. Действительно, отдельные версии «пауков» могут значительно перегружать сервера. Имеет место и человеческий фактор – веб-мастер, который создавал программу, может допускать ошибки в настройках робота. Все же большинство действующих программ хорошо спроектированы и профессионально управляются, а любые возникающие неполадки оперативно устраняются.

Как управлять индексацией

Поисковые роботы являются автоматическими программами, но процесс индексации может частично контролироваться веб-мастером. В этом значительно помогает внешняя и внутренняя оптимизация ресурса. Кроме того, можно вручную добавить новый сайт в поисковую систему: крупные ресурсы имеют специальные формы регистрации веб-страниц.

Источник: fb.ru

Поисковые роботы — что это и как они работают

Поисковые роботы – это компьютерные программы, которые автоматически обходят Интернет-ресурсы и индексируют их содержимое. Они используются для поиска информации, которую пользователи могут найти через поисковые системы, такие как Google, Bing, Yandex и другие. В этой статье мы рассмотрим, как работают поисковые роботы, их важность для SEO, а также некоторые техники, которые могут быть использованы для улучшения индексации сайтов.

Как работают поисковые роботы

- 1 Как работают поисковые роботы

- 2 Важность поисковых роботов для SEO

- 3 Техники для улучшения индексации сайтов

- 4 Вот список основных поисковых роботов Яндекс:

- 5 Выводы

- 6 Вместо заключения

Поисковые роботы начинают свою работу с поиска ссылок на другие страницы. Они ищут ссылки на новые страницы, а затем следуют по ним, чтобы проиндексировать новое содержимое. Когда поисковый робот находит страницу, он анализирует ее содержимое, включая текст, изображения, видео и другие элементы. Поисковые роботы используют алгоритмы, чтобы определить, какие страницы наиболее релевантны для конкретного поискового запроса.

После того, как поисковый робот проанализировал содержимое страницы, он добавляет ее в индекс поисковой системы. Индекс – это база данных, которая содержит информацию обо всех проиндексированных страницах. Когда пользователь вводит в строку поиска запрос, поисковая система использует свой индекс, чтобы найти страницы, которые наиболее соответствуют этому запросу.

Важность поисковых роботов для SEO

Поисковые роботы играют важную роль в SEO продвижении. Хорошо оптимизированные сайты имеют больше шансов быть проиндексированными поисковыми роботами и появляться на первых страницах результатов поиска. Некоторые из наиболее важных аспектов, которые поисковые роботы учитывают при индексации сайтов, включают в себя:

- Ключевые слова: поисковые роботы используют ключевые слова, чтобы определить, о чем идет речь на странице.

- Структура сайта: поисковые роботы учитывают структуру сайта, чтобы понять, какие страницы наиболее важны и как они связаны друг с другом.

- Качество контента: поисковые роботы анализируют качество контента на странице, чтобы определить, насколько полезной она может быть для пользователей.

Кроме качества контента, поисковые роботы также учитывают другие факторы ранжирования, которые могут повлиять на пользовательский опыт, такие как время загрузки страницы, удобство навигации и безопасность сайта.

Важно отметить, что поисковые роботы не только индексируют страницы, но также обновляют индекс, чтобы отразить в нем изменения на сайтах. Это означает, что владельцы сайтов могут использовать определенные техники, чтобы улучшить индексацию своих страниц и обновлять индекс с новым контентом.

Техники для улучшения индексации сайтов

Есть несколько техник, которые могут быть использованы для улучшения индексации сайтов поисковыми роботами. Одной из самых важных является оптимизация контента на страницах сайта. Для этого необходимо использовать ключевые слова в заголовках, описаниях и тексте, но не злоупотреблять ими, чтобы не получить штраф от поисковых систем за переспам (фильтр Баден-Баден).

Другая важная техника — это создание качественных и уникальных ссылок на ваш сайт. Поисковые роботы используют количество и качество ссылок на сайт, чтобы определить, насколько популярен и авторитетен сайт. Грамотно размещенные ссылки могут помочь улучшить позицию вашего сайта в результатах поиска.

Также важно убедиться, что ваш сайт имеет удобную структуру и навигацию. Это позволяет поисковым роботам легче просканировать ваш сайт и определить, какие страницы наиболее важны и релевантны для пользователей.

Вот список основных поисковых роботов Яндекс:

- YandexBot — главный робот Яндекса, который производит индексацию веб-страниц и сбор данных для поисковой выдачи.

- YandexImages — робот Яндекса, который индексирует изображения, находящиеся на веб-страницах.

- YandexVideo — робот Яндекса, который индексирует видео на веб-страницах.

- YandexMedia — робот Яндекса, который индексирует новостные материалы, статьи и другой контент, связанный с медиа.

- YandexMetrika — робот Яндекса, который собирает данные о посетителях сайтов и анализирует их поведение.

- YandexDirect — робот Яндекса, который обрабатывает рекламные запросы и показывает рекламу на страницах поисковой выдачи.

- YandexNews — робот Яндекса, который индексирует новостные материалы и показывает их в разделе новостей на главной странице Яндекса.

- YandexCatalog — робот Яндекса, который индексирует каталоги товаров и услуг, представленные на сайтах.

- YandexMarket — робот Яндекса, который индексирует интернет-магазины и предоставляет информацию о ценах на товары и услуги.

- YandexTranslate — робот Яндекса, который обрабатывает запросы на перевод текстов с одного языка на другой.

Выводы

Поисковые роботы играют важную роль в SEO оптимизации сайтов. Они помогают пользователям находить нужную информацию и помогают владельцам сайтов привлекать больше трафика и улучшать позиции в поисковых результатах. Следование лучшим практикам SEO и использование эффективных техник оптимизации контента и ссылок помогут улучшить индексацию вашего сайта поисковыми роботами и увеличить его видимость в поисковых результатах.

Вместо заключения

Хотите выйти в ТОП10 Яндекс и долго там оставаться? Продвигайте свои сайты и интернет-магазины исключительно белыми SEO методами! Не умеете? Могу научить! Тем, кто хочет разобраться во всех премудростях SEO, предлагаю посетить мои курсы по SEO обучению, которые я провожу индивидуально, в режиме онлайн по скайпу.

Источник: hozyindachi.ru