В рамках одного доменного имени очень может такое быть, что один и тот же контент доступен по разным адресам.

Вполне вероятно, что на разных страницах сайта опубликован очень похожий или же полностью дублированный контент. Это может быть одинаковые (или очень похожие) описания meta name=»description» content=»» , заголовки H1 , title страницы. Если после проверки на наличие дубликатов выяснилось, что они присутствуют в вашем приложении, то необходимо устранить ненужные дубли страниц.

Дубли — это страницы, которые или очень похожи или являются полной копией (дублем) основной (продвигаемой вами) страницы.

Причины появления дублей страниц на сайте

- Не указано главное зеркало сайта. Одна и та же страница доступна по разным URL (с www. и без | с http и с https).

- Версии страниц сайта для печати, не закрытые от индексации.

- Генерация страниц с одними и теми же атрибутами, расположенными в разном порядке. Например, /?id=1id=1 .

- Автоматическая генерация дубликатов движком приложения (CMS). Из-за ошибок в системе управления контентом (CMS), так же могут появляются дубли страниц.

- Ошибки веб-мастера при разработке (настройке) приложения.

- Дублирование страницы (статьи, товара. ) веб-мастером или контент-маркетологом.

- Изменение структуры сайта, после которого страницам присваиваются новые адреса, а старые не удаляются.

- На сайте используются «быстрые» мобильные версии страниц, с которых не выставлен Canonical на основные версии.

- Сознательное или несознательное размещение ссылок третьими лицами на ваши дубли с других ресурсов.

Виды дублей

Дубликаты различают на 3 вида:

Как найти дубликаты файлов (фото, видео, музыки) на компьютере.

- Полные — с полностью одинаковым контентом;

- Частичные — с частично повторяющимся контентом;

- Смысловые, когда несколько страниц несут один смысл, но разными словами.

Полные

Полные дубли ухудшают факторы всего сайта и осложняют его продвижение в ТОП, поэтому от них нужно избавиться сразу после обнаружения.

- Версия с/без www . Возникает, если пользователь не указал зеркало в панели Яндекса и Google.

- Различные варианты главной страницы:

- site.com

- site.com/default/index

- site.com/index

- site.com/index/

- site.com/index.html

- site.com/products/apple/

- site.com/products/category/apple/

- site.com/category/apple/

- site.com/products/apple/page.php?color=green

Избавиться от полных дубликатов можно, поставив редирект, убрав ошибку программно или закрыв документы от индексации.

Частичные

Частичные дубликаты не так страшны для на сайта, как полные. Однако, если их много — это ухудшает ранжирование веб-приложения. Кроме того, они могут мешать продвижению и по конкретным ключевым запросам. Разберем в каких случаях они возникают.

Характеристики в карточке товара

Нередко, переключаясь на вкладку в товарной карточке, например, на отзывы, можно увидеть, как это меняет URL-адрес. При этом большая часть контента страницы остаётся прежней, что создает дубль.

Пагинация

Если CMS неправильно настроена, переход на следующую страницу в категории меняет URL, но не изменяет Title и Description. В итоге получается несколько разных ссылок с одинаковыми мета-тегами:

- site.com/fruits/apple/

- site.com/fruits/apple/?page=2

Такие URL-адреса поисковики индексируют как отдельные страницы. Чтобы избежать дублирования, проверьте техническую реализацию вывода товаров и автогенерации.

Также на каждой странице пагинации необходимо указать каноническую страницу, которая будет считаться главной.

Подстановка контента

Часто для повышения видимости по запросам с указанием города в шапку сайта добавляют выбор региона. При нажатии которого на странице меняется номер телефона. Бывают случаи, когда в адрес добавляется аргумент, например city_by_default= . В результате, у каждой страницы появляется несколько одинаковых версий с разными ссылками. Не допускайте подобной генерации или используйте 301 редирект.

Версия для печати

Версии для печати полностью копируют контент и нужны для преобразования формата содержимого. Пример:

- site.com/fruits/apple

- site.com/fruits/apple/print – версия для печати

Поэтому необходимо закрывать их от индексации в robots.txt .

Смысловые

Смысловые дубли — контент страниц, написанный под запросы из одного кластера. Чтобы их обнаружить (смысловые дубли страниц), нужно воспользоваться результатом парсинга сайта, выполненного, например, программой Screaming Frog. Затем скопировать заголовки всех статей и добавить их в любой Hard-кластеризатор с порогом группировки 3,4. Если несколько статей попали в один кластер – оставьте наиболее качественную, а с остальных поставьте 301 редирект.

Чем опасны дубли страниц на сайте

Наличие дубликатов на сайте — один ключевых факторов внутренней оптимизации (или её отсутствия), который крайне негативно сказывается на позициях сайта в органической поисковой выдаче. Дубли служат причиной нескольких проблем, связанных с оптимизацией:

- Индексация сайта. При большом количестве дублей поисковые роботы в силу ограниченного краулингового бюджета могут не проиндексировать нужные страницы. Также есть риск того, что сайт будет пессимизирован, а его краулинговый бюджет — урезан.

- Проблемы с выдачей приоритетной страницы в органическом поиске. За счет дублей в поисковую выдачу может попасть не та страница, продвижение которой планировалось, а её копия. Есть и другой вариант: обе страницы будут конкурировать между собой, и ни одна не окажется в выдаче.

- «Распыление» ссылочного веса. Вес страницы сайта — это своеобразный рейтинг, выраженный в количестве и качестве ссылок на неё с других сайтов или других страниц внутри этого же сайта. При наличии дублей ссылочный вес может переходить не на единственную версию страницы, а делиться между ее дубликатами. Таким образом, все усилия по внешней оптимизации и линкбилдингу оказываются напрасными.

Инструменты для поиска

Как найти дублирующиеся страницы? Это можно сделать с помощью специальных программ и онлайн сервисов. Часть из них платные, другие – бесплатные, некоторые – условно-бесплатные (с пробной версией или ограниченным функционалом).

Яндекс Вебмастер

Чтобы посмотреть наличие дубликатов в панели Яндекса, необходимо зайти: Индексирование -> Страницы в поиске -> Исключённые.

Страницы исключаются из индекса по разным причинам, в том числе из-за повторяющегося контента (дублирования). Обычно конкретная причина прописана под ссылкой.

Google Search Console

Посмотреть наличие дублей страниц в панели Google Search Console можно так: Покрытие -> Исключено.

Netpeak Spider

Netpeak Spider – платная программа с 14-дневной пробной версией. Если провести поиск по заданному сайту, программа покажет все найденные ошибки и дубликаты.

Xenu

Xenu — бесплатная программа, в которой можно проанализировать даже не проиндексированный сайт. При сканировании программа найдет повторяющиеся заголовки и мета-описания.

Сайт Репорт

Сайт Репорт — это неплохой сервис, предоставляющий пользователю инструмент диагностики внутренних и внешних факторов с целью оптимизации сайта. Поиск дубликатов — это один из множества инструментов сервиса по оптимизации сайта или другого приложения. Сервис предоставляет бесплатный анализ до 25 страниц. Если у вас на сайте большее количество страниц, то (при необходимости) придётся немного потратиться. Но оно того стоит.

Screaming Frog Seo Spider

Screaming Frog Seo Spider является условно-бесплатной программой. До 500 ссылок можно проверить бесплатно, после чего понадобится платная версия. Наличие дублей программа определяет так же, как и Xenu, но быстрее и эффективнее.

Как начать пользоваться бесплатно:

- Скачать программу Screaming Frog Seo Spider и установить её на свой ПК. Скачать ключ-активатор для программы. Пароль к архиву: prowebmastering.ru

- Запустить keygen.exe , задать имя пользователя и ключ (ключ можно сгенерировать)

- В самой программе Screaming Frog Seo Spider выбрать вкладку «Licence» -> «Enter Licence»

- В появившемся окне указать то, что указали (или сгенерировали) при запуске keygen.exe , жмём «OK», перезапускаем программу.

Документация по работе с программой Screaming Frog Seo Spider здесь.

Поисковая выдача

Результаты поиска могут отразить не только нужный нам сайт, но и некое отношение поисковой системы к нему. Для поиска дублей в Google можно воспользоваться специальным запросом.

site:mysite.ru -site:mysite.ru/ — показывает страницы сайта mysite.ru, участвующие в поиске (основной индекс).

Как автоматически удалить дубликаты файлов по содержимому

Таким образом, можно определить малоинформативные страницы и частичные дубли, которые не участвуют в поиске и могут мешать страницам из основного индекса ранжироваться выше. При поиске обязательно кликните по ссылке «повторить поиск, включив упущенные результаты», если результатов было мало, чтобы видеть более объективную картину.

Варианты устранения дубликатов

При дублировании важно не только избавиться от копий, но и предотвратить появление новых.

Физическое удаление

Самым простым способом было бы удалить повторяющиеся страницы вручную. Однако перед удалением нужно учитывать несколько важных моментов:

- Источник возникновения. Зачастую физическое удаление не решает проблему, поэтому ищите причину

- Страницы можно удалять, только если вы уверены, что на них не ссылаются другие ресурсы

Настройка 301 редиректа

Если дублей не много или на них есть ссылки, настройте редирект на главную или продвигаемую страницу. Настройка осуществляется через редактирование файла .htaccess либо с помощью плагинов (в случае с готовыми CMS). Старый документ со временем выпадет из индекса, а весь ссылочный вес перейдет новой странице.

Создание канонической страницы

Указав каноническую страницу, вы показываете поисковым системам, какой документ считать основным. Этот способ используется для того, чтобы показать, какую страницу нужно индексировать при пагинации, сортировке, попадании в URL GET-параметров и UTM-меток. Для этого на всех дублях в теге прописывается следующая строчка со ссылкой на оригинальную страницу:

Например, на странице пагинации главной должна считаться только одна страница: первая или «Показать все». На остальных необходимо прописать атрибут rel=»canonical» , также можно использовать теги rel=prev/next :

// Для 1-ой страницы: // Для второй и последующей:

Запрет индексации в файле Robots.txt

Файл robots.txt — это своеобразная инструкция по индексации для поисковиков. Она подойдёт, чтобы запретить индексацию служебных страниц и дублей.

Для этого нужно воспользоваться директивой Disallow , которая запрещает поисковому роботу индексацию.

Disallow: /dir/ – директория dir запрещена для индексации Disallow: /dir – директория dir и все вложенные документы запрещены для индексации Disallow: *XXX – все страницы, в URL которых встречается набор символов XXX, запрещены для индексации.

Внимательно следите за тем какие директивы вы прописываете в robots.txt . При некорректном написании можно заблокировать не те разделы либо вовсе закрыть сайт от поисковых систем.

Запрет индексировать страницы действует для всех роботов. Но каждый из них реагирует на директиву Disallow по-разному: Яндекс со временем удалит из индекса запрещенные страницы, а Google может проигнорировать правило, если на данный документ ведут ссылки..

Вывод

Дублирующиеся H1 , title , description , а также некоторые части контента вроде отзывов и комментариев очень нежелательны и осложняют продвижение сайта. Поэтому обязательно проверяйте ресурс на дубликаты, как сгенерированные, так и смысловые и применяйте описанные в статье методы для их устранения.

Источник: prowebmastering.ru

Как найти дубли программ

Всем привет сегодня хочу рассказать как найти дубликаты файлов в Windows 10. Поиск дубликатов файлов, обычно хорошо проводить когда у вас на компьютере полная не неразбериха и начинает заканчиваться место, ну или просто решили прибраться у себя на жестком диске. В решении данной задачи нам поможет не безызвестная бесплатная программа ccleaner.

Поиск дублей файлов с помощью ccleaner

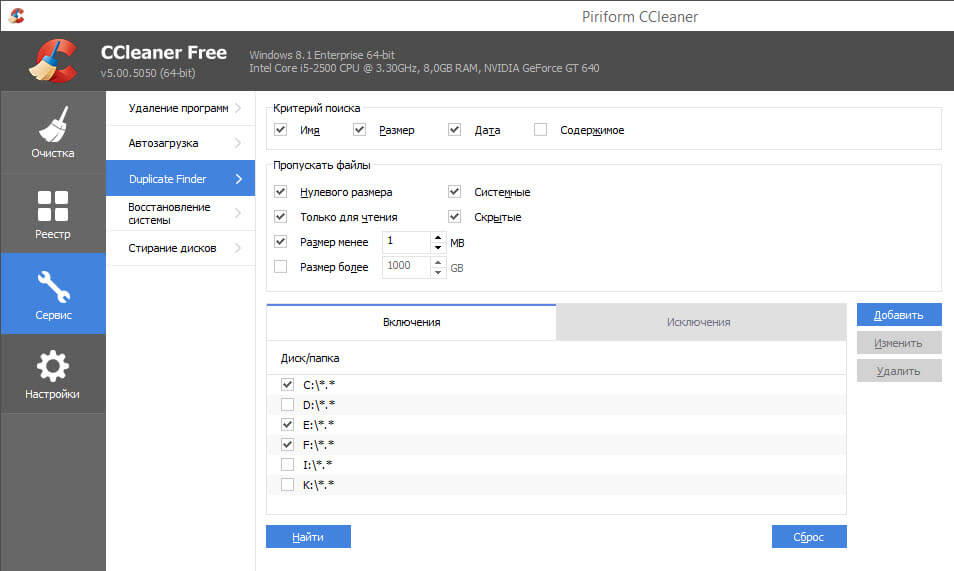

Недавно я рассказывал уже Как уничтожить данные с компьютера и там нам тоже помогла утилита ccleaner. Уверен,что далеко не все знают, что с помощью нее можно производить поиск дубликатов файлов на компьютере. Открываем ccleaner и переходим в пункт Сервис-Duplicate Finder.

поиск дубликатов файлов

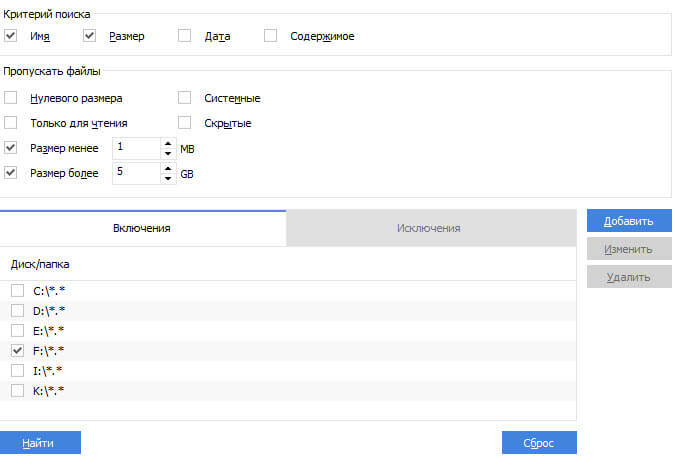

Теперь выберем размер файлов для поиска, локальный диск где будет искать ccleaner. Жмем Найти

Выбор параметров поиска

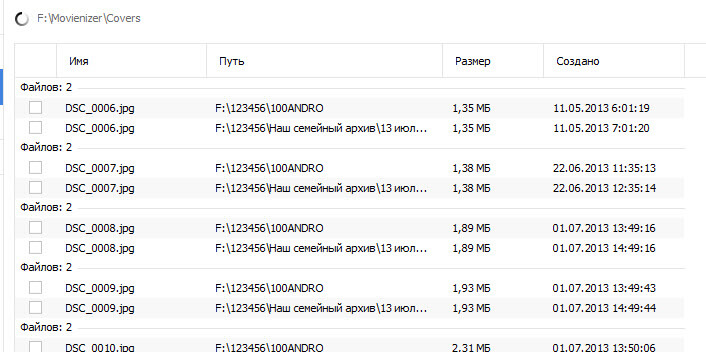

Если программа найдет файлы соответствующие нашим требованиям заданным ранее, то вы увидите нечто подобное, имя файла и где лежат дубликаты.

Как только утилита закончит сканирование вы увидите сообщение, что поиск файлов завершен.

Вообще ccleaner очень мощная утилита, с довольно большим функционалом, который с каждого релиза новой версии, только увеличивается, плюс большим преимуществом является,ч то она полностью бесплатная, у нее конечно есть платная версия, но она нацелена больше на корпоративный сегмент рынка, для больших компаний. Из выше сказанного можно сделать ввод,что данная утилита должна всегда присутствовать на вашем компьютере или ноутбуке и помогать вам в повседневной жизни. Конечно поиск дубликатов файлов делается и другими утилитами, но ни одна из них не сравнится по мощности с ccleaner.

PS был случай что у моего приятеля с помощью такого метода мы смогли разгрузить его HDD на 27 гигабайт, которые занимали дубликаты.

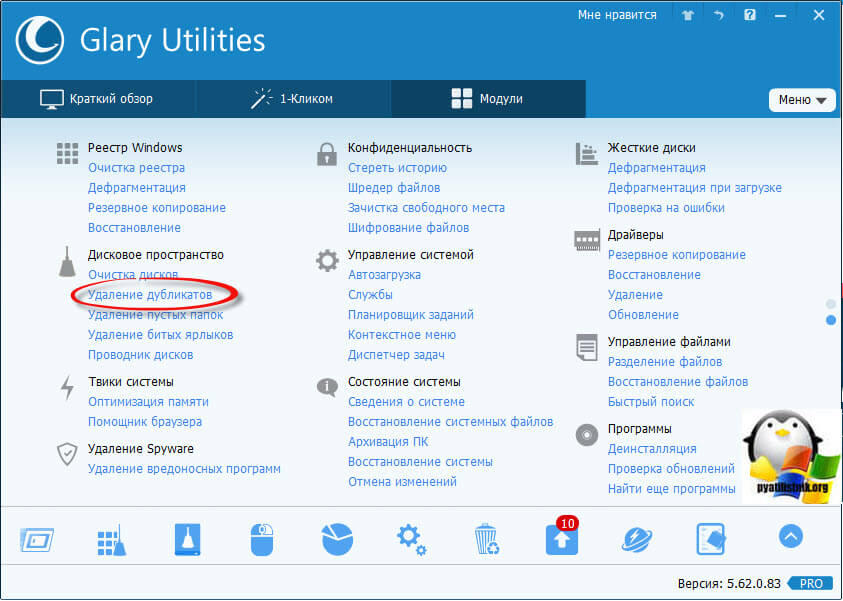

Поиск дублей файлов с помощью GlaryUtilities

Эту же задачу, легко и более профессионально решает, новая утилита появившаяся в моем инструментарии и называется она GlaryUtilities, у меня она пятой версии. GlaryUtilities платная, но ее функционал реально стоит своих денег. Запускаем ее. Выбираем Удаление дубликатов в области Дисковое пространство.

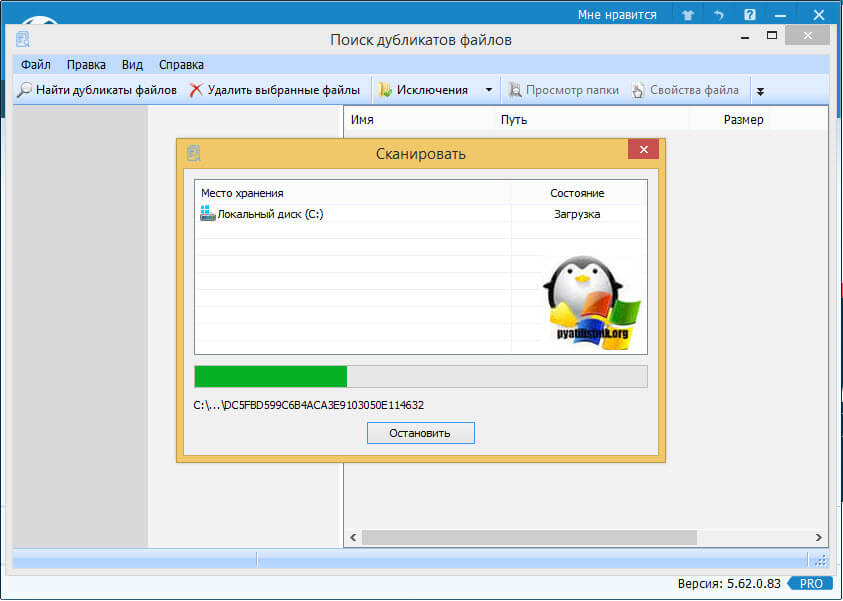

Если у вас больше локальных дисков, то укажите какие именно нужно будет сканировать данной утилитой.

Начинается поиск дублей файлов, у меня в компьютере стоит ssd диск, поэтому на все про все ушло две минуты, еще конечно от объема диска зависит и количества файлов на нем.

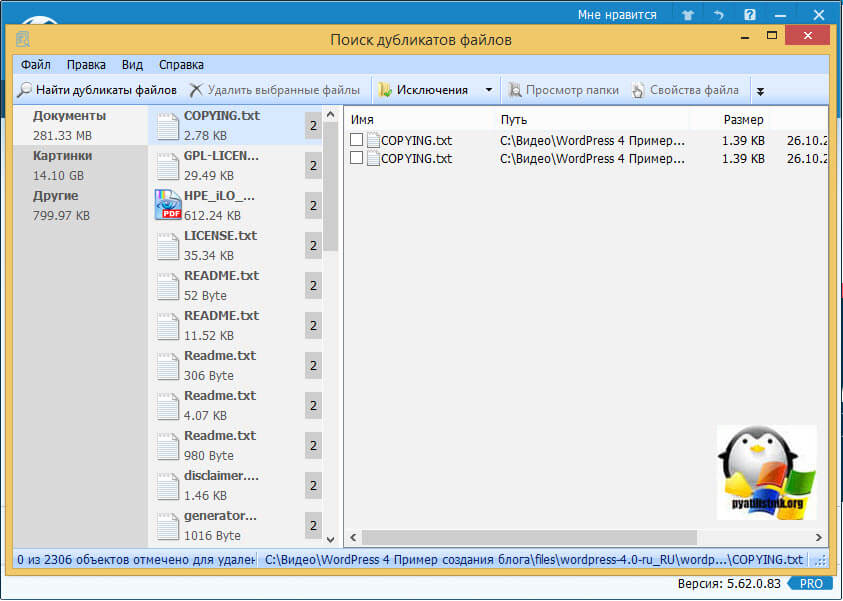

В итоге ф вижу результат, он разбит на категории:

- Документы > тут в основном текстовые файлы, но и тут я могу сэкономить 281 мегабайт

- Картинки > у меня это в основном фотографии, но даже тут я у себя смог найти 14 гб дублей.

- Другие > тут все остальное, это могут быть системные файлы

Как видите поиск дублей файлов не такая уж и сложная и долгая задача, больше времени вы потратите на сравнивание этих копий, но от этого уже никуда не деться.

Популярные Похожие записи:

Не работает 1С 7.7 в Windows Server 2019

Не работает 1С 7.7 в Windows Server 2019 Как вернуть средство просмотра фотографий Windows 11, за минуту

Как вернуть средство просмотра фотографий Windows 11, за минуту- Автозагрузка в windows server 2012-2016

Скрипт подсчета файлов и вывод процента по изменениям на определенную дату

Скрипт подсчета файлов и вывод процента по изменениям на определенную дату- Автоматическое удаления файлов в папке по заданным критериям

- Скачать утилиту extcv для Windows

Источник: pyatilistnik.org

Поиск и удаление дублей в 1С

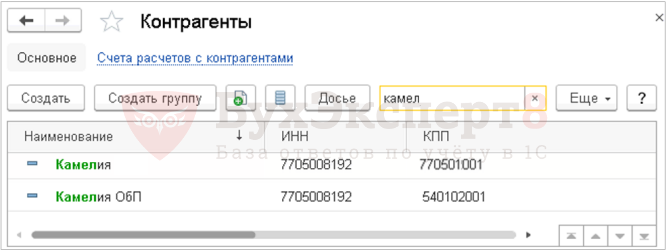

Как можно избавиться от дублей контрагентов в справочнике, если документы с дублями были созданы в закрытых периодах? Даже если вводятся данные нового контрагента в 2018 году, а контрагент с таким ИНН и КПП уже есть в программе, программа не предлагает никаких подсказок к действиям, с помощью которых можно исправить дубли. Что надо предпринимать в такой ситуации?

При вводе нового контрагента программа осуществляет проверку ИНН и КПП. Если в программе уже заведен контрагент с такими реквизитами — она об этом сообщает. PDF

Поиск производится только в том случае, если ИНН и КПП введены корректно.

Условия выполнения автоматической проверки

Проблем не должно быть, если:

- у вас типовая, не доработанная конфигурация;

- вы сразу при вводе нового контрагента заносите данные по ИНН и КПП в карточку контрагента;

- данные по ИНН и КПП введены правильно.

При вводе нового контрагента вам нужно сразу заполнить ИНН и КПП . Только тогда программа запускает поиск дублей специальной процедурой Поиск дублей . В противном случае поиск дублей не производится!

Скорее всего, вы не сразу заполняете информацию по ИНН и КПП . Или у вас доработанная конфигурация, и тогда уже требуется ее анализ программистом.

Сейчас вам нужно удалить все дубли из справочника Контрагенты . Сделать это можно специальной обработкой Поиск и удаление дублей .

- Самоучитель по 1С Бухгалтерии 8.3;

- Самоучитель по 1С ЗУП 8.3.

Поиск и удаление дублей

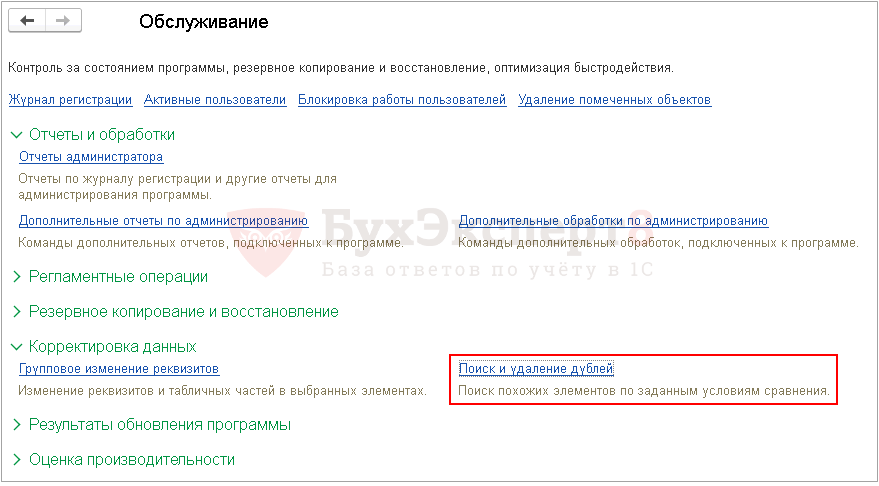

Открыть обработку Поиск и удаление дублей можно из раздела Администрирование – Настройки программы – Обслуживание – Корректировка данных – Поиск и удаление дублей .

- Главного меню – Все функции – Обработки — Поиск и удаление дублей . PDF

- Настроив Панель Навигации раздела Администрирования : настройка Панели Навигации («шестеренка» в правом верхнем углу) — выбор в доступных командах команды Поиск и удаление дублей . PDF

Работать с обработкой может пользователь с Полными правами. Обработка предназначена для поиcка и удаления дублей в справочниках и документах. Она позволяет найти ссылки на все продублированные элементы и производит их замену на выбранный «правильный» элемент.

Пошаговая инструкция поиска и удаления дублей

Перед удалением дублей обязательно сделайте копию базы данных — эта операция необратима! Если результат вас не устроит, вы всегда сможете восстановить данные.

Откройте обработку Поиск и удаление дублей : раздел Администрирование – Настройки программы – Обслуживание – Корректировка данных – Поиск и удаление дублей .

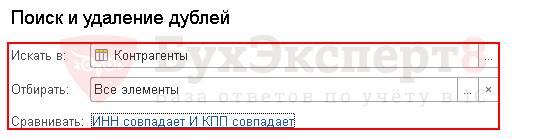

Шаг 1. Настройка шапки поиска дублей

Укажите в шапке поиска:

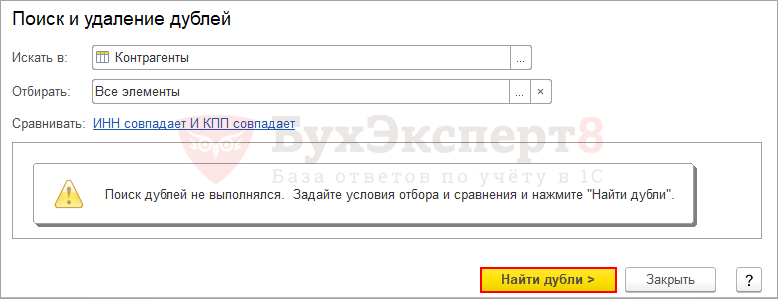

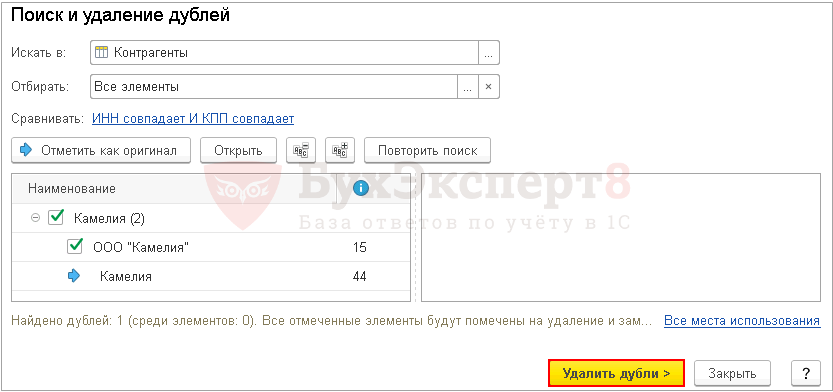

Шаг 2. Поиск дублей

Нажмите на кнопку Найти Дубли . Программа автоматически выполнит сравнение всех контрагентов в базе отберет с одинаковыми ИНН и КПП .

Шаг 3. Выбор оригинала

Если обнаружены дубли, то справа от контрагентов выводится информация, показывающая количество ссылок, имеющихся в базе по каждому контрагенту.

Элемент левой части с наибольшим количеством ссылок автоматически помечается как Оригинал («синяя» стрелка). Контрагент-дубль помечается флажком.

Можно изменить оригинал, встав курсором на ООО «Камелия» и нажав кнопку Отметить как оригинал . В этом случае при объединении дублей останутся ссылки только на ООО «Камелия».

Шаг 4. Объединение дублей

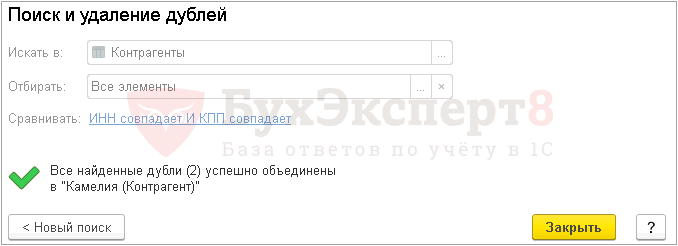

Удаление дублей происходит по кнопке Удалить дубли , при этом:

- дубли будут помечены на удаление;

- все вхождения дублей в документах заменяются на выбранный Оригинал .

Шаг 5. Удаление дублей

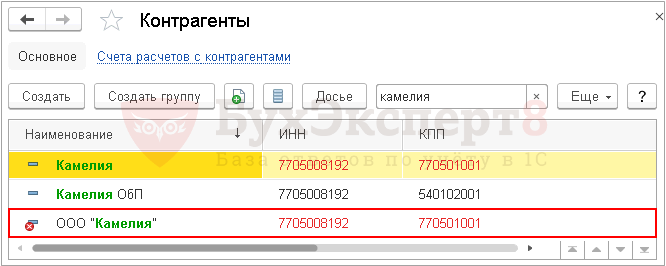

Обработка успешно объединила данные дубля в выбранный оригинал, но сам дубль не удален. Он остался помеченным на удаление в справочнике Контрагенты .

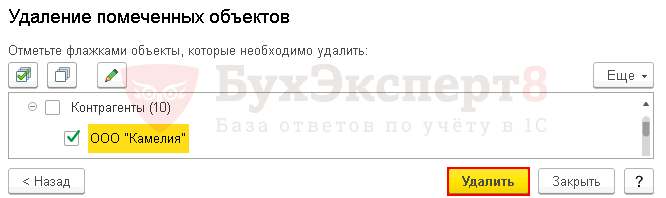

Окончательно удaлить контрагент-дубль можно обработкой Удаление помеченных объектов : раздел Операции – Сервис – Удаление помеченных объектов .

Обработка удалит ООО «Камелия» из справочника Контрагенты .

Подписывайтесь на наши YouTube и Telegram чтобы не пропустить

важные изменения 1С и законодательства

![]()

Помогла статья?

Получите еще секретный бонус и полный доступ к справочной системе БухЭксперт8 на 14 дней бесплатно

Похожие публикации

- Поиск и удаление дублей 1С 8.3При работе в программах 1С зачастую создаются дубли — одинаковые.

- Быстрый поиск и предварительный просмотр в отчетах.

- Поиск ссылок на объекты в 1С 8.3При работе с 1С бывает нужно найти список всех объектов.

- Поиск Функциональности в 1СВ форме Функциональность программы есть строка поиска. Что указывать в.

Оцените публикацию

(37 оценок, среднее: 4,76 из 5)

Публикацию можно обсудить в комментариях ниже.

Обратите внимание!

В комментариях наши эксперты не отвечают на вопросы по программам 1С и законодательству.

Задать вопрос нашим специалистам можно в Личном кабинете

Источник: buhexpert8.ru