В последнее время я все чаще задумываюсь, зачем нужны очень мощные видеокарты? Ведь большинство игр отлично работают на видеоадаптерах уровня GTX 660 Ti на высоких настройках в разрешении Full HD, то есть дают всё, что нужно для счастья геймера. А не переплачиваем ли мы систематически за мощные видеокарты, которые большую часть времени «простаивают» за показом интернета?

Вот свежий пример — NVIDIA GTX TITAN. Да, на сегодняшний день, это самая мощная однопроцессорная видеокарта. Но стоимость! За неё хотят 35 тысяч рублей и даже больше! Только подумайте: лет шесть-семь назад за такие деньги собирался компьютер, близкий к топовому, на котором работали все игры на максимальных настройках.

И, кстати, мало что изменилось: сегодня тоже можно за 35-40 тысяч рублей собрать хороший системный блок.

NVIDIA GTX TITAN

Зачастую разница между «железкой» из среднего ценового сегмента и из топового настолько мизерна, что её реально нужно выискивать. Особенно это касается процессоров. Если вы не монтируете видео и не занимаетесь тому подобными вещами, то вам придётся постараться, чтобы найти разницу в производительности между процессором за 5 и за 10 тысяч рублей.

ТЕБЕ НЕ НУЖНА ВИДЕОКАРТА !

Однако производители всячески провоцируют нас покупать железо ещё и ещё дороже, приводя, как правило, не очень убедительные для меня доводы. Зачем реально нужна видеокарта уровня NVIDIA GTX TITAN? Ну, кроме понтов, конечно.

Сейчас на меня многие набросятся и вспомнят про Crysis 3, который только что вышел, но уже «поставил на колени» даже мощные компьютеры. Но подумайте, вы действительно считаете, что стоит покупать такую дорогую видеокарту только для того, чтобы с комфортом пройти ОДНУ игру?

Покупать видеокарту «на вырост» — тоже глупое занятие. Долго играть на одной карте вам не позволят неписанные правила, которые установили производители операционных систем и игр. Через пару лет выйдет новая «крутая» версия DirectX, и вы все равно не сможете выкрутить на максимум какую-нибудь одну настройку в любимой игре. Вот тут и начнётся подзуживание в том самом месте.

Как так: я отвалил год-два назад столько денег за мощнейшую видеокарту, а тут на тебе — не активируется какая-то функция. И вы снова пойдёте за более современной видеокартой, даже если та, что установлена в вашу систему, будет показывать хорошую частоту кадров. Наверное, без ущерба остальному, такое возможно только в очень богатой стране.

Поэтому покупать «самый крутой топ» имеет смысл только в том случае, если для вас это совершенно безболезненная покупка и вы даже не заметите исчезновения тысячи долларов в кошельке. В противном случае, советую покупать «уверенные среднячки», которые и вытянут все, и продадутся впоследствии с минимальными потерями. Такая продуманность совершенно не понравится производителям железа, но зато очень понравится вашему кошельку.

Источник: www.ferra.ru

Всё о видеокартах за 11 минут

Как выбрать видеокарту

Дискретная видеокарта — необходимый компонент современного мощного настольного компьютера. Поэтому любой, кто хочет обновить или собрать компьютер, приходит к тому, что нужно выбирать видеокарту. Однако, по цене они сейчас намного превосходят остальные комплектующие. Мы расскажем, как выбрать оптимальную модель и не остаться с пустым кошельком.

Современная видеокарта вставляется в разъём PCI-E на материнской плате, а разъёмы самой видеокарты оказываются в задней части системного блока. В разъёмы видеокарты можно подключить монитор, телевизор, проектор, плату видеозахвата. Источник изображения: newegg.com

Выбор видеокарты по назначению

Первое, о чём стоит спросить себя при выборе видеокарты — способ её использования.

Если вы покупаете видеокарту для игр, она будет являтся самым дорогим и важным компонентом системного блока. Чем мощнее видеокарта, тем быстрее происходит обработка трёхмерной графики, вывод информации и лучше качество картинки на мониторе. Если видеокарта будет недостаточно мощной, вы разочаруетесь в своём компьютере. Игры будут работать медленно, а то и не запустятся совсем.

Картинка в современных компьютерных играх поражает вниманием к деталям. Порой становится сложно отличить, где скриншот, а где реальная фотография. Игра: Tom Clancy’s The Division. Источник изображения: vgtimes.ru

Впрочем, разные игры могут требовать разной мощности видеокарты. Двухмерные или старые игры могут запускаться и прекрасно работать на малопроизводительных видеокартах.

Инди-игры и ретро-игры могут быть настолько простыми с точки зрения графики, что им не требуется мощная видеокарта. Игра: Stardew Valley. Источник изображения: www.playground.ru

Для работы вам тоже может понадобится мощная видеокарта. Например, обработка и рендеринг видео, дизайнерские приложения, а также некоторые виды инженерных программ, таких как AutoCAD, могут работать с помощью видеокарты. Для таких задач существуют специальные профессиональные модели. У Nvidia профессиональные видеокарты представлены линейкой RTX A, у AMD — Radeon Pro.

Профессиональные видеокарты выделяются особым, строгим внешним видом. Видеокарта Radeon Pro W5500. Источник изображения: i2hard.ru

Nvidia против AMD

Исторически основными конкурентами являются видеокарты двух разработчиков: Nvidia и AMD.

Nvidia популярнее, но AMD не сильно отстает по используемым технологиям, а конкуренция только на пользу рынку. Источник изображения: mediasat.info

В видеокартах Nvidia используется технология трассировки лучей, по-английски Ray tracing. Суть её в том, что в играх лучи света работают как в реальном мире, благодаря чему улучшаются эффекты освещения, теней и отражений. Это делает трёхмерную графику более реалистичной.

Nvidia и AMD являются разработчиками видеокарт, они отвечают за устройство графического процессора и базовый дизайн видеокарты. Видеокарты, выпущенные Nvidia и AMD называются референсными и служат серийным рабочим образцом устройства.

Производители видеокарт

За массовый выпуск видеокарт отвечают различные компании, такие как ASUS, Gigabyte, Palit, Zotac и другие. Каждый из этих производителей не копирует референсный дизайн, а выпускает несколько собственных моделей, отличающихся компоновкой платы, системой охлаждения, частотами графического процессора и памяти.

Видеокарты разных производителей могут быть совершенно непохожими друг на друга, даже если они сделаны на основе одной модели графического процессора. Источник изображения: pics.computerbase.de

Графические процессоры видеокарт

Самая важная вещь, на которую нужно обращать внимание при выборе видеокарты — это модель графического процессора. Например, его название выглядит так: Nvidia GeForce RTX 2060 Ti. Именно он больше чем на 90 процентов определяет производительность.

У Nvidia в названии графического процессора первые две цифры означают поколение, или семейство, к которому он принадлежит, а две последующие — конкретный процессор в рамках одного поколения. Например, в названии RTX 3090 в начале 30 — это значит, что процессор поколения RTX 30XX, 90 — что это самая производительная модель. Приставка Ti обозначает модель выше классом. Например, RTX 3060 Ti быстрее, чем RTX 3060, но медленнее, чем RTX 3070. В старых видеокартах применялась другая классификация.

У AMD первая цифра обозначает поколение, оставшиеся три — модель. Применяется приставка XT, аналогичная по смыслу приставке Ti у Nvidia.

Выбрав модель графического процессора, мы можем выбирать модель видеокарты от конкретного производителя, которая подходит нам по цене, размерам, мощности и типу охлаждения.

Объём и тип памяти видеокарты

В дискретных видеокартах используется собственная память, которая называется видеопамятью. Её объем в настоящее время удобнее всего измерять в гигабайтах.

Она нужна для хранения текстур и прочих данных, которые видеокарта использует в данный момент времени.

Выбирая видеокарту, стоит смотреть на объём памяти как на вторичную характеристику. Гораздо важнее модель графического процессора.

Размеры видеокарт

Видеокарту можно назвать компьютером в компьютере, так как она имеет собственную память, собственный графический процессор и собственные контроллеры. Все эти компоненты помещаются на плате видеокарты, которая имеет определенные размеры. В зависимости от устройства системы охлаждения, видеокарта может занимать от одного до трёх слотов в корпусе системного блока. При выборе нужно учитывать физические размеры карты. Слишком большая видеокарта может просто не поместиться в ваш компьютер.

Длина видеокарты часто мешает поставить её в тот или иной корпус системного блока. Источник изображения: assets.rockpapershotgun.com

Охлаждение видеокарт

Графический процессор и память видеокарты выделяют достаточно много тепла, особенно при нагрузках. Чтобы рассеивать тепло, используется радиатор. Радиатор на мощных видеокартах включает тепловые трубки, которые улучшают теплоотвод. Для обдува радиатора используется один или несколько вентиляторов.

Система охлаждения видеокарты. Видна контактная площадка, тепловые трубки и радиатор. Источник изображения: techpowerup.com

Если вентиляторов нет, то охлаждение называют пассивным. Главный плюс такого решения — полное отсутствие шума. Пассивное охлаждение реализуемо только на видеокартах нижнего ценового сегмента.

Энергопотребление видеокарт

Выбирая видеокарту, не нужно забывать об источнике энергии для неё — блоке питания.

Минимальная рекомендованная мощность блока питания указывается на сайте производителя видеокарты и измеряется в ваттах.

Примеры видеокарт разных ценовых сегментов

Дешёвые видеокарты

Видеокарты нижнего ценового сегмента предназначены для простейших задач — таких, как просмотр видео или офисная работа. Игры с двухмерной графикой, браузерные, ретро-игры здесь могут работать. Но игры с навороченной графикой будут безбожно тормозить.

ASUS GeForce GT 730 2GB. Видеокарта имеет пассивное охлаждение. Источник изображения: ru.gecid.com

Начальные игровые видеокарты

Позволяют играть в современные трёхмерные игры, но на минимально-средних настройках качества графики и на разрешении FullHD 1920×1080. Многие популярные онлайн-игры вроде World of Tanks тоже пойдут на них без проблем.

Видеокарта Gigabyte Nvidia GeForce RTX 3050. Источник изображения: techspot.com

Средние игровые видеокарты

Тянут современные игры уже на настройках, близким к максимальным, но с уменьшением сглаживания, на умеренном разрешении. Мультиплеерные многопользовательские проекты, скорее всего, пойдут на максимальных настройках.

Видеокарта MSI Radeon RX 6600 XT. Источник изображения: techspot.com

Хорошие видеокарты

Эти видеокарты тянут максимально требовательные игры на высоких настройках графики, но не позволяют при этом использовать большие разрешения, например 4K 3840×2160.

Например, это Nvidia GeForce RTX 3080 или AMD Radeon RX 6800.

Видеокарта Sapphire Nitro+ Radeon RX 6750 XT. Источник изображения: techspot.com

Топовые видеокарты

На них можно позволить себе играть в высоком разрешении на максимальных настройках качества в любые игры. Как правило, стоимость таких видеокарт сильно завышена по сравнению с их производительностью.

Видеокарта ASUS Nvidia GeForce RTX 3090 Ti. Источник изображения: techspot.com

Немного теории: выбор видеокарты для игр и характеристики монитора

Как уже говорилось, чем мощнее видеокарта, тем больше графической информации она может обрабатывать за единицу времени. Для использования этой мощности есть три пути:

- Улучшение графических настроек. Это, к примеру, детализация моделей в игре, количество объектов, качество теней. Чем выше настройки детализации, тем более реалистичной становится графика, тем больше мелких нюансов появляется.

- Повышение разрешения. Разрешение — это количество точек, или пикселей, по горизонтали и вертикали, из которых состоит картинка. Чем выше разрешение, тем более гладкое изображение, тем меньше пиксельной «лесенки» на объектах и тем больший размер монитора может быть.

Таким образом, если мы купили монитор с высоким разрешением, например 4K, то видеокарта, в идеале, тоже должна быть более мощной, так как ей придется выводить всё то же самое, но на большее количество пикселей.

3. Увеличение частоты кадров. Частота кадров, или FPS — это, как можно понять из названия, то, сколько кадров в секунду отображается на экране. Чем выше частота кадров, тем более плавным выглядит любое движение.

У компьютерного монитора всегда есть определённая частота обновления. Стандартным минимумом является частота обновления 60 Гц, этого достаточно для большинства задач, но для гейминга выпускаются мониторы с большей частотой, например, 144 Гц и 240 Гц.

Например, если у вас монитор с частотой обновления 144 Гц и в игре близкое количество кадров в секунду, то движение будет выглядеть более плавным. Хотя для многих людей это незаметно.

Итак, если у вас монитор с повышенным разрешением и/или повышенной частотой обновления, то, чтобы раскрыть его возможности, нужна более мощная видеокарта.

Заключение

Дискретная видеокарта — сложное и дорогое устройство. Но не стоит думать, что её выбор и установка — дело избранных. В основном, всё зависит от того, какая на неё будет идти нагрузка.

При выборе нужно смотреть на следующие моменты:

- модель графического процессора;

- отзывы и надёжность производителя;

- возможность установить её в свой компьютер (размеры и требуемая мощность блока питания);

- во что планируется играть и в каком разрешении;

- будет ли видеокарта использоваться для рабочих приложений.

Если нужна видеокарт аза минимальную стоимость, которая позволяет поиграть в современные игры, то стоит просмотреться Nvidia RTX 3050, GTX 1660 и AMD Radeon RX 6500 XT.

В связи с дефицитом полупроводников разброс цен на видеокарты сейчас огромен. Поэтому при покупке нужно отслеживать выгодные предложения и покупать комплектующие по приемлемой цене.

Источник: www.fotosklad.ru

Нужна ли видеокарта для работы

Современные видеокарты — недешевые и сложные устройства, но пользователи старательно покупают самые дорогие из них, не задумываясь — а нужны ли они им?

erid: LjN8KXX2o

ООО «ИТ Медиа»

Когда нужна 3D-графика Для каких приложений полезно ускорение при помощи GPU Какие нетрадиционные применения GPU существуют

Когда нужна 3D-графика Исторический экскурс (см. врезку) показывает, что игровые приложения становятся фактически единственным применением трехмерных ускорителей. Но ведь существует и множество других предназначений для персонального компьютера, в которых работа ведется исключительно с 2D-объектами – начиная от офисных приложений и заканчивая программами для создания собственного видео.

Именно по этой причине авторы последних версий ОС Windows сделали столь явный акцент на многочисленные, но совершенно бесполезные красивости в интерфейсе пользователя (вспомним хотя бы Aero): имея в своем распоряжении мощнейший спецпроцессор, можно без проблем задействовать его ресурсы. Конечно, логичнее было бы предположить появление 3D-интерфейса, но, увы, он не прижился.

Хотя попытки создать его предпринимаются и по сей день, и пользовательские фан-группы есть, впрочем, их количеством можно пренебречь: основная масса предпочитает старый добрый двумерный подход. Это касается не только интерфейсов: системы обработки изображений (графические редакторы, растровые и векторные), системы проектирования, среды программирования, верстка, дизайн, работа со звуком – все направлено исключительно на двумерную среду.

И здесь помочь не могут даже самые навороченные и сложные видеоадаптеры: по сути, пользователь не заметит разницы между простейшим встроенным видео и четырехпроцессорным дискретным 3D-ускорителем. Та же история и с кодированием видео: в лучшем случае востребованным останется только интерфейс HDMI – но им уже оснащены даже материнские платы с интегрированным GPU.

Единственное исключение из правила – системы создания и моделирования трехмерных объектов. В таких графредакторах, безусловно, необходимы дискретные 3D-ускорители. А кроме них остаются только игры. Всем другим приложениям современная видеокарта практически не нужна.

Словом, если вы не фанат суперсовременных трехмерных игр и не работаете в системах такого же моделирования, то и видеокарта подойдет любая, в том числе встроенная. Но чтобы не быть голословным, я попробую рассмотреть ситуацию подробнее. Для каких приложений полезно ускорение при помощи GPU Прежде всего отметим некоторые, можно сказать, исключительные моменты.

Конечно, нельзя однозначно говорить, будто для таких случаев видеокарта очень полезна, но и упускать из виду возможность немного улучшить жизнь и ускорить выполнение определенных операций не стоит. Итак, прежде всего – графический редактор.

Широко распространенный Photoshop, как и прежде, опирается на производительность CPU и HDD, но в версии CS4 появилась поддержка OpenGL, что позволило немного разгрузить центральный процессор и увеличить скорость отрисовки изображения. Для доступа к графическому процессору Photoshop необходимо, чтобы видеоакселератор располагал данной технологией, а также имел достаточно оперативной памяти (от 128 Мбайт) и драйверы, предусматривающие наличие OpenGL 2.0 и Shader Model 3.0.

Проверить, как это работает на вашем компьютере, можно, проследовав по меню Edit – Preferences – Performance: если видеокарта поддерживается, опция будет доступна. Если же нет или вы только планируете приобрести видеокарту – лучше всего посетить сайт Adobe и просмотреть список совместимых устройств.

А заодно и прочитать приведенный там же FAQ: для некоторых видеокарт (причем недешевых) выложен список проблем совместимости. Тем не менее в перечне проверенных видеокарт встречаются варианты любого уровня, от встроенных Intel Graphics Media Accelerator HD до NVIDIA Quadro FX 3700, что позволяет увеличить производительность Photoshop CS4 решениями любой ценовой категории.

Таким образом можно получить сглаженное отображение при любом уровне масштабирования, а также анимированное масштабирование, анимированные переходы при масштабировании одним кликом, «толкание рукой» изображения, вид с высоты птичьего полета, поворот холста, гладкое отображение изображений с неквадратными пикселями, сетку для пикселей и предпросмотр кисти. Кроме того, соответствие цветов будет обрабатываться при помощи графического процессора и станут доступными различные функции для обработки 3D-изображений.

К сожалению, пользователям 64-разрядной Windows XP эти возможности не доступны из-за отсутствия драйверов, а пользователям Vista потребуется активировать ее самостоятельно (по умолчанию она отключена у данной ОС). Переложить часть нагрузки с CPU на видеопроцессор – заманчивая идея не только для графических редакторов.

Современные браузеры также вынуждены отображать большое количество информации, что отнимает много ресурсов системы. А потому в 9-й версии Internet Explorer заявлена поддержка технологий Direct2D и DirectWrite, соответственно, практически все операции по обработке графики и видео выполняются видеокартой.

Правда, воспользоваться этим смогут только владельцы ОС Windows Vista и 7. Ожидается, что в ближайшее время у остальных браузеров также появится аппаратное ускорение, хотя основное его применение – все те же игры и анимированные приложения. И наконец, аппаратная поддержка кодирования видео, предоставляемая некоторыми современными моделями видеокарт (H.264/AVC), тоже призвана ускорить операции по сжатию видео.

Но энтузиасты отмечают, что на практике ощутимой выгоды не наблюдается, если речь идет о создании собственных видеороликов. Если же перекодировать большое количество HD-медиаконтента для личных мобильных устройств, напротив, выигрыш присутствует, и немалый.

Так, благодаря технологии Intel Quick Sync Video и встроенному графическому ядру время «перегона» видео сокращается значительно: по некотором оценкам, скорость может возрастать в 17 раз. Следует упомянуть еще об одном важном моменте – это актуально для тех пользователей, кто хочет иметь в своем распоряжении ноутбук с мощной дискретной графикой, но не намерен терять в мобильности (то есть во времени автономной работы), – технологии nVidia Optimus.

Главное ее назначение – задействовать видеокарты в зависимости от используемого приложения. Другими словами, работаем с офисным пакетом – включается интегрированная графика, снижается энергопотребеление; запускаем игру или другое ресурсоемкое приложение – система автоматически активирует более мощную дискретную, растет производительность.

По примерным подсчетам благодаря такому подходу удается продлить время работы от батарей от 1,5 до 2,5 раза, но точнее сказать трудно: слишком причудливо система выбирает, когда и какую видеокарту использовать. Какие нетрадиционные применения GPU существуют Факт остается фактом: на борту современной видеокарты установлен очень мощный компьютер.

Самостоятельный, со своим ПО, процессорами, памятью, и прочими атрибутами. Что и послужило  предпосылкой к решению применить эту (кстати, весьма недорогую – если сравнивать с компьютерами) производительность для нетипичных задач. Так появилась на свет технология CUDA.

предпосылкой к решению применить эту (кстати, весьма недорогую – если сравнивать с компьютерами) производительность для нетипичных задач. Так появилась на свет технология CUDA.

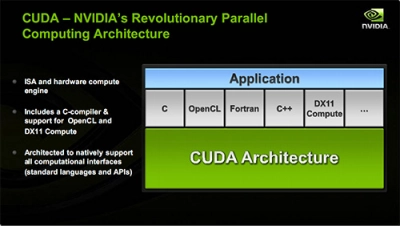

Идея, кстати, чрезвычайно интересная: аппаратная архитектура параллельных вычислений, для которой есть готовый набор средств разработки. Главное – среда программирования CUDA, предоставляющая набор абстракций, позволяющих выражать как параллелизм данных, так и параллелизм задач.

Программист сам выбирает средства разработки: доступны языки высокого уровня, такие как C, C++, Fortran или же API – OpenCL и DirectX-11 Compute. Первым языком, для которого nVidia обеспечила поддержку, стал C. Набор программных инструментов создания С для CUDA позволяет программировать GPU с помощью этого языка с минимальным набором ключевых слов и расширений.

В дальнейшем планируется обеспечить поддержку Fortran, OpenCL и других. Свое применение CUDA нашла исключительно в научной сфере, для сложных расчетов: наиболее яркими из них считают решение задачи умножения плотных матриц, расчет цены опционов по формуле Блэка – Шоулза, обработку изображений алгоритмами фильтрации, а также преобразования Фурье.

К примеру, некоторые источники приводят такие данные: «при нынешних объемах памяти на графическом процессоре можно умножать матрицы размером в миллионы элементов, и все данные будут размещены в видеоОЗУ. Реально достигнутая производительность при этом будет достаточно высока: на GPU AMD HD 2900 это 100 ГФлоп/c, на GPU nVidia GeForce 8800GTX – 125 ГФлоп/c». На бумаге все красиво, но вот в реальной жизни.

Попытка использовать такую технологию сразу же продемонстрировала ее слабые места. Прежде всего, переносимость – об этом речь вообще не идет, что резко ограничивает возможности распространения готового решения.

Закрытая архитектура также накладывает негативный отпечаток, но это все можно было бы списать на несовершенство и «юный возраст» технологии, если бы не другие моменты. Так, некоторые исследователи жалуются на отсутствие обработчика критических ошибок – при их возникновении компьютер просто зависает.

Есть трудности и с функционированием ОС в связке с драйвером: не получая от него отклика, операционная система попросту посылает команду сброса каждые 5–10 секунд, делая невозможной работу программы свыше указанного времени. Конечно, с проблемами пытаются бороться, но после прочтения очередного отзыва от экспериментаторов становится понятно, что сейчас это не более чем игрушка для энтузиастов, практическое применение которой будет найдено не скоро.

Если, разумеется, будет найдено вообще. Выводы Выводы напрашиваются сами собой: для большинства пользовательских приложений возможностей самой простой современной встроенной графики хватит с лихвой.

Просмотр видео, обработка и редактирование фотографий, оцифровка и монтаж видео, работа с мультимедиаконтентом, а также практически все без исключения современные приложения требуют для своей работы только 2D-ускорителя. Что бы ни рассказывали маркетологи, какими бы супертехнологиями ни оперировали – в большинстве случаев все это останется невостребованным в реальной жизни.

Исключения, как уже говорилось, делаются только для игр и редакторов трехмерной графики – именно для них нужны хорошие, качественные и недешевые ускорители. Что же касается игровых приложений, здесь варианты выбора упростились до минимума – достаточно прочесть рекомендации разработчика игры или приобрести самый дорогой адаптер (из доступных по бюджету).

Впрочем, если вы заядлый геймер, то и без подсказок знаете, что делать! Что представляет собой современная видеокарта? С этого вопроса придется начать, потому что многие пользователи совершенно не представляют истинного положения вещей и предполагают, будто это устройство для подключения монитора.

А ведь еще относительно недавно это было не одно, а несколько устройств, и предназначались они для разных задач. Итак, небольшой экскурс в историю. Давным-давно, когда компьютеры были восьмибитными, такого понятия, как «видеокарта» не существовало вовсе.

И тем не менее, многие из нас прекрасно помнят и «Денди», и SEGA, и ATARI, и ZX-SPECTRUM, имевших графику, в том числе игры, весьма приличного качества. Достигалось это специфической схемотехникой, уникальной для каждого случая, но в подробности вдаваться не стану, упомяну лишь, что схема, отвечающая за формирование видеосигнала, являлась неотъемлемой частью компьютера и была задействована в других узлах.

Например, тот же ZX-SPECTRUM при чтении файла с магнитофонной ленты создавал специфическое изображение на части экрана – бордюре. По сути, главная роль видеомодуля сводилась к преобразованию цифрового изображения в растровое, пригодное для отображения на дисплее или телевизоре, который пришел на смену печатающему устройству – АЦПУ.

Отдельным узлом видеоадаптер стал, пожалуй, только в IBM-совместимых ПК. Один из первых, CGA, позволял формировать растровое изображение (320×200 пикселей, 16 цветов; 640×200 пикселей, 2 цвета), не делая при этом никаких самостоятельных вычислений: подготовка и формирование картинки выполнялась только центральным процессором.

По этому же принципу изготовлялись и другие модели, благодаря чему выводимое изображение было исключительно двумерным. Ситуация кардинально изменилась только с изобретением 2D-акселлераторов и появлением у видеокарт собственного процессора (GPU) – он существенно разгрузил CPU и уменьшил количество данных, передаваемых между центральным процессором и видеомодулем.

Теперь такие операции, как построение линии по двум точкам, рисование геометрических фигур и примитивов, которые были занесены в GDI (графический интерфейс Windows), стали делом графического процессора. Ускорение достигалось еще и тем, что GPU был неизмеримо лучше приспособлен для подобных операций и выполнял их быстрее, чем CPU.

2D-акселератор взял на себя прорисовку отдельных элементов – например, рабочего столал, окон приложений, курсора и т. д.  Такая концепция дала мощный толчок к созданию не только графических интерфейсов, но и ряда программ для проектирования (CAD/CAM).

Такая концепция дала мощный толчок к созданию не только графических интерфейсов, но и ряда программ для проектирования (CAD/CAM).

Решение оказалось настолько удачным, что длительное время специалисты считали трехмерную графику совершенно бесперспективным направлением, а многие компании еще долго выпускали высокопроизводительные 2D-ускорители для профессиональных инженерных применений. Перелом наступил в середине 1990-х, с появлением 3D-акселераторов, ориентированных на ускорение вывода трехмерной графики. Точнее говоря, это произошло летом 1996 год, когда начался выпуск трехмерных игр (конкретно Quake), в которых был реализован полностью полигональный трехмерный мир – с его отрисовкой классические видеокарты уже не справлялись. Примечательно, что отдельные компании, сконцентрировавшие усилия на разработке видеокарт, проигнорировали данное направление, предпочитая совершенствовать двухмерные акселераторы: по их мнению, «игрушками» заниматься несолидно, а персональные компьютеры достойны гораздо лучшего применения, чем в качестве игровой приставки. Увы, история показала, что таким подходом они подписали себе смертный приговор – пользователи рассудили иначе и теперь уже пятое поколение графических карт представляет собой высокопроизводительные 3D-ускорители.

Опубликовано 24.08.2011

Показать комментарии (0)

Источник: www.it-world.ru