Чип PCI-E Switch, по оценкам, многие люди слышали об этом. Но считается, что большинство людей мало знают о его основных функциях. Коммутатор PCI-E Switch широко используется в традиционных системах хранения данных и в небольшом количестве серверных платформ марки / модели, поскольку он является наиболее производительным.

Как системный архитектор компании PMC-Sierra, которая имеет самые передовые в мире коммутаторы PCI-E, я хочу популяризировать базовые знания о коммутаторах PCI-E для всех. КВведениеКак все знают о PCI-E, на материнской плате есть слот PCI-E, а золотые пальцы внутри представляют собой связку сигнальных линий, которые напрямую подключены к контроллеру PCI-E внутри процессора.

Однако текущий процессор платформы Intel поддерживает максимум 40 каналов (Lane) на процессор. Вообще говоря, сетевые карты 10 Gigabit используют 8 каналов.

Высококачественным видеокартам требуется x16 каналов, потому что пропускная способность, необходимая для 3D-операций, огромна (автор: ПК Старая материнская плата оснащена видеокартой GTX980, которая может работать только в режиме x8, но производительность в 3D практически не изменилась, что доказывает, что x8 в принципе достаточно). Обычная карта памяти также использует x8, но внутренняя карта памяти SAS 12 Гбит / с (карта HBA, карта Raid) обычно перешла на x16.

ОБЪЯСНЯЕМ PCI Express 4.0

Однако для некоторых продуктов высокого класса, особенно для традиционных систем хранения, x40 каналов на процессор недостаточно. Особым требованием к традиционным системам хранения является то, что количество внутренних и внешних HBA-адаптеров относительно велико, поэтому количество каналов, предоставляемых ЦП, не может быть удовлетворено.

Кроме того, традиционные контроллеры хранилища должны выполнять различные обмены данными и синхронизацию, и обычно используется PCI-E, что увеличивает потребление количества каналов. Для обычных высокопроизводительных серверов они обычно имеют двухканальную и четырехканальную конфигурации, а каналы x80 предоставляются в двухканальном режиме.

Теоретически можно подключить 10 устройств x8 PCI-E и некоторые внутренние встроенные устройства PCI-E для управления. После того, как канал занят, можно легко подключить 8 устройств, что может покрыть практически все сценарии применения.

Тем не мение,В связи с постоянным повышением требований пользователей к интеграции, унификации, эффективности, пространству и энергопотреблению в последние годы появилось много модульных серверных платформ с высокой плотностью размещения или открытых блейд-серверов. У этого типа серверной платформы есть некоторые особые требования для PCI-E, такие как разделение и MR-IOV.Ниже автор подробно расскажет об этих знаниях. Косновные навыки1.FanoutFanout (расширение, расширение и рассредоточение) — основная функция коммутатора PCI-E. Другими словами, роль коммутатора PCI-E была разработана с самого начала стандартной системы PCI-E для работы с недостаточным количеством каналов.

Что такое PCIe? Все виды скоростного интерфейса подключения PCIe 1.0-6.0 (x1 x4 x8 x18 x32)

Стандарт предыдущего поколения до PCI-E был PCI-X. В то время не существовало концепции Switch. Fanout принял форму моста для формирования древовидной структуры, как показано в середине приведенного выше рисунка. ККонцепция коммутатора была введена в эпоху PCI-E.

Одно из самых существенных отличий от мостов состоит в том, что несколько ролей в одной и той же шине используют коммутатор вместо шины.Эпоха PCI-X действительно использует разделяемую шину для передачи данных, что означает арбитраж и низкую эффективность. Однако PCI-E сохраняет основные концепции системы PCI-X.

Например, слово «шина» и слово «мост» все еще используются, но эти два символа стали виртуальными символами. Коммутатор эквивалентен виртуальному мосту + виртуальная шина. Каждый виртуальный мост (VB) может подключать только одно конечное устройство (то есть конечное устройство / карту, конечную точку / EP) или каскадировать другой коммутатор и не может подключиться к шине. потому что физического автобуса нет. Эта форма разветвления должна соответствовать древовидной структуре, потому что древовидная структура является самой простой, в ней нет цикла и нет необходимости рассматривать сложную маршрутизацию. К2.PartitionФункция разделения эквивалентна Vlan в коммутаторе Ethernet и такая же, как зона в коммутаторе / расширителе SAS.

Как показано на рисунке выше, две или более машины могут быть подключены к одному коммутатору PCI-E, и коммутатор может быть разделен на разделы, а некоторые устройства EP могут быть назначены серверу. Таким образом можно достичь единого управления и гибкого распределения.

BIOS или ОС каждого сервера найдет только виртуальный мост, виртуальную шину и EP, назначенные ему, при перечислении шины PCI-E. Нет интерференции между несколькими разделами. КЕсли к одному коммутатору подключено несколько независимых серверов, возникнут проблемы, если они не разделены на разделы.

Поскольку две ОС будут перечислять роли в одной и той же куче шин PCI-E и назначать им адреса доступа, в это время возникнут конфликты. К3.NTBВ некоторых особых сценариях, таких как несколько контроллеров в традиционной системе хранения, между ними необходимо синхронизировать большое количество данных и управляющей информации, и предполагается использование канала PCI-E для прямой связи.

Проблема в том, что два сервера на картинке не могут связываться напрямую, потому что они должны находиться в двух разных разделах. Чтобы удовлетворить этот спрос, появилась технология NTB. Основным принципом является трансляция адресов, поскольку каждая из двух разных систем (термин System Image, SI) имеет свои собственные адресные пространства, которые перекрываются. Тогда покаОтображение адресов и трансляция соответствующих пакетов данных внутри коммутатора PCI-E позволяют осуществлять связь между двумя сторонами. Эта технология моста с трансляцией адресов называется None Transparent Bridge.

основные навыки1.Dynamic PartitionУпомянутая выше конфигурация разделов должна быть статической.Коммутатор PCI-E должен быть разделен на разделы до запуска BIOS, то есть до включения ЦП, и BMC можно использовать для настройки. После того, как раздел настроен, его нельзя изменить динамически во время работы системы.

Это означает, что если карта PCI-E назначена серверу A, ее нельзя динамически перераспределить на сервер B, не влияя на работу серверов A и B. Продукт Switchtec PCI-E Switch от PMC-Sierra поддерживает динамическое размещение. Я не могу раскрыть конкретные способы реализации. Однако для опытных разработчиков это не проблема.

Проблема в том, является ли внутренняя архитектура соответствующего чипа достаточно гибкой и настраиваемой. Это ключ к ограничению разработки расширенных функций. К2.FabricКак упоминалось выше, будь то системные стандарты PCI-X или PCI-E, поддерживаются только древовидные топологии.

Проблема с топологией дерева состоит в том, что путь слишком длинный, а диаметр всей сети слишком велик. Кроме того, невозможно обеспечить избыточность. При выходе из строя канала все ответвления, находящиеся за ним, становятся недоступными. Так,Поддержка Fabric стала очень сложной расширенной функцией.

Этот сценарий в настоящее время редко используется людьми.Для целых стоечных серверов, таких как Scorpio, они больше заинтересованы в этой функции.Однако текущая реализация этой технологии все еще находится в зачаточном состоянии и несовершенна, и стандарта не существует.

3.IOVМногие люди слышали о SR-IOV, но не знают конкретный портал. Что означает Root в однокорневой виртуализации ввода-вывода? А как насчет единственного корня? И Multi Root IOV, что это за хрень?

КSR-IOV относится к виртуализации карты PCI-E, вставленной в сервер, в несколько виртуальных карт, которые используются несколькими виртуальными машинами, работающими на этом сервере, и каждая виртуальная машина распознает карту PCI-E. Карта E, но виртуальная машина не знайте, что эта карта виртуальная.

Если он не виртуализирован на несколько карт, как несколько виртуальных машин могут совместно использовать это устройство? Ответ: устройство должно использоваться через службу, предоставляемую гипервизором. Гипервизор установит драйвер на виртуальную машину. Этот драйвер виртуализирует несуществующее устройство, например «Ethernet-карту марки XXX».

Этот драйвер будет фактически подключен к стеку протоколов ОС для приема пакетов данных, отправленных верхним уровнем. . Но после того, как драйвер получает пакет данных, поскольку на самом деле сетевая карта отсутствует, драйвер фактически отправляет пакет гипервизору, или некоторые реализации виртуальных машин используют виртуальную машину с привилегиями домена 0, которая отвечает за работу с реальным оборудованием, затем этот драйвер отправит данные на эту привилегированную виртуальную машину. Гостевая виртуальная машина и привилегированная виртуальная машина будут передавать данные посредством межпроцессного взаимодействия.

После того, как гипервизор или привилегированная виртуальная машина получит данные, он будет использовать настоящий драйвер, например » Intel xxx Ethernet card «для передачи данных. Отправьте на настоящую сетевую карту.

Такая пересылка выполняется медленно, потому что стоимость копирования в память относительно высока, и если требования к пропускной способности велики, этот метод не будет работать. Итак, SR-IOV вышел, чтобы решить эту проблему. SR-IOV необходимо виртуализировать несколько подустройств непосредственно в аппаратном обеспечении карты PCI-E. Как это сделать?

Прежде всего, карты PCI-E, поддерживающие SR-IOV, должны подать заявку на удвоенное адресное пространство из системы.Если вы хотите виртуализировать несколько устройств, вам необходимо объявить в несколько раз больше адресного пространства по сравнению с исходным в соответствии с Стандартный формат SR-IOV. Это адресное пространство будет получено, когда ядро или BIOS перечислит устройство PCI-E, и система запишет базовый адрес сегмента адресного пространства, применяемого для устройства, в регистр устройства.

Например, сетевая карта виртуализирует 8 виртуальных сетевых карт, а затем основной модуль управления PCI-E объявляет системе 8 устройств PCI-E. Затем гипервизор сопоставляет соответствующее устройство с соответствующей виртуальной машиной, и соответствующий драйвер хоста загружается в виртуальную машину.

Гипервизору также необходимо выполнять преобразование адресов или преобразование адресов с аппаратной поддержкой. Поскольку само устройство PCI-E поддерживает SR-IOV, коммутатор PCI-E может поддерживать его изначально без какой-либо дополнительной обработки. НоMR-IOV может поддерживаться только дополнительной обработкой на коммутаторе PCI-E.

Причина в том, что несколько независимых систем не взаимодействуют друг с другом. Если все они попытаются настроить шину PCI-E, они будут конфликтовать. Основные средства поддержки MR-IOV коммутатором PCI-E Switch достигаются путем добавления уровня управления отображением адресов. КПара платформ Dell PowerEdge FX2Применение переключателя PCI-EDell PowerEdge FX2 — это многоузловая серверная платформа высотой 2U, в которой используется корпус 2U, самый большой из которых может вместить: 2 серверных салазок 1U или 1 серверные салазки 1U + 2 салазки для хранения половинной ширины 1U или 1 серверные салазки половинной ширины 1U +3 салазки половинной ширины 1U или 4 серверных салазок 1U половинной ширины или 2 серверных салазок 1U половинной ширины + 2 салазки половинной ширины 1U или 3 серверных салазок 1U половинной ширины + 1 салазки половинной ширины 1U Или 8 Серверные салазки 1U шириной в четверть позволяют реализовать множество гибких комбинаций. Как показано ниже.

На задней панели корпуса имеется 8 слотов PCI-E.

Эти 8 слотов PCI-E можно гибко назначать различным комбинациям серверных салазок на передней панели корпуса. Это выигрывает от использования функций PCI-E Switch и Partition.Автор нарисовал принципиальную схему для введения внутреннего направляющего пути.

Как показано на рисунке ниже, порт, подключенный к слоту 1/2, и порт, подключенный к серверу Sled1, находятся в красной зоне, а слот 3/4 и серверный Sled2 — в желтой зоне. Слоты 5/6/7/8, салазки для хранения и сервер Seld3 находятся в синем разделе. Это означает, что сервер Sled3 распознает карту PCI-E (если есть) в слоте 5/6/7/8 и карту RAID на салазках хранения.

Веб-интерфейс конфигурации, подключенный к BMC, может глобально настраивать все салазки, включенные во всю платформу FX2, включая назначение соответствующих слотов PCI-E, то есть операцию основного раздела коммутатора PCI-E.

Благодаря гибкому использованию функции разделения коммутатора PCI-E, платформа Dell PowerEdge FX2 может реализовать гибкое распределение следующих восьми устройств PCI-E, чтобы лучше адаптироваться к все более гибким сценариям приложений и бизнес-требованиям.

Источник: russianblogs.com

PCIe для электронщиков: анатомия канала передачи

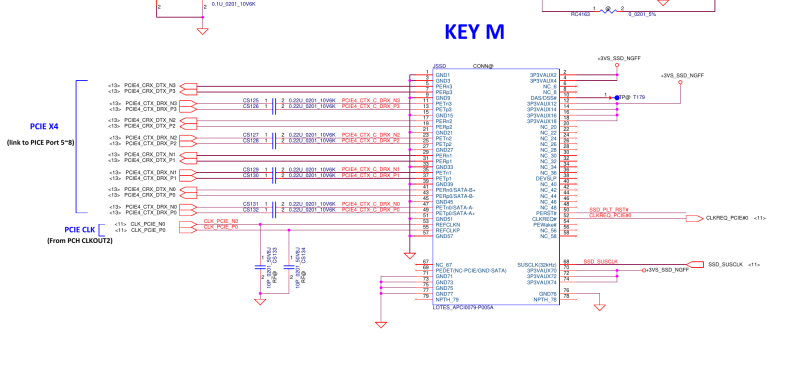

В предыдущий раз мы разбирали дифпары, их основы, правила разводки и известные допуски PCIe в этом отношении. Сегодня же мы поговорим о конкретных сигналах, на которых работает PCIe, а также узнаем, какие разъёмы применимы к этому интерфейсу.

Я делю разъёмы PCIe на две категории. Первые – это десктопные, которые обычно имеют ширину канала х1, х16 или х4 и встречаются на десктопных материнских платах. Вторая категория – это мобильные разъёмы, а именно mPCIe и M.2. Также существуют модели вроде ExpressCard, которые до сих пор встречаются в некоторых стареньких ноутбуках, но уже определённо утратили свою актуальность. Что касается мобильной сферы, то M.2 в отношении PCIe идёт значительно впереди – если интересно, у меня есть короткая серия статей, в которых я подробно разбираю данный стандарт.

В этих разъёмах большинство сигналов будут необязательными, а некоторые специфичными для самого разъёма, но в любом устройстве PCIe есть и необходимые. Естественно, первую группу таких необходимых сигналов представляют сами дифпары PCIe.

▍ PCIe – это просто изощрённый UART

В любом интерфейсе PCIe присутствует два вида дифпар – TX и RX. Для канала х1 у вас будет по одной дифпаре TX и RX, а каналу х16 их потребуется уже по 16. Как вы наверняка понимаете, RX на одном конце подключается к TX на другом и наоборот – всё как в UART, только более изощрённо. Конечно, если вы собираете расширитель PCIe или переходник между разъёмами, то такое перекрещивание делать не нужно.

Если же вы проектируете плату для одного из стандартов расширения с поддержкой PCIe, то обычно маркировка соответствует стороне хоста. Предположим, что вы добавляете микросхему Ethernet-контроллера PCIe на плату, которая устанавливается в десктопный разъём PCIe – подключите TX и RX платы к RX и TX вашей микросхемы Ethernet соответственно.

Перекрещивание TX и RX не сработает – проверено на собственном горьком опыте

Если есть отчётливый признак того, что это правило было нарушено, не беспокойтесь – просто проведите сравнение с имеющимся хостом или устройством и попробуйте определить, соответствует маркировка линий ожидаемой или же действительно была перевёрнута. Опять же, всё как в UART. Тем не менее на обоих линиях TX и RX также последовательно установлены конденсаторы связи по переменному току. Говоря конкретнее, в случае карт расширения PCIe, будь то M.2 или десктопные PCIe, по соглашению на плате устройства они размещаются на линиях TX (RX хоста), а на плате хоста – на стороне TX (RX устройства). Одно только это является приятным отличием от UART, когда речь идёт о проектировании и реверс-инжиниринге.

Третий вид дифпар, который присутствует всегда – это REFCLK – дифпара тактового генератора 100 МГц. Это быстрый генератор, и я не уверена, каково его полное назначение.

Тем не менее он, по-видимому, участвует в декодировании передаваемых по TX и RX данных, в частности, в восстановлении тактовой частоты – оставаясь жизненно важным, несмотря на значительно более низкую скорость в сравнении с гигабитной пропускной способностью дифпар RX и TX. В отличие от RX и TX, полярность REFCLK поменять местами на своё усмотрение не получится. С другой стороны, не возникнет особых проблем, если провести REFCLK через серию отверстий в случае, если вам потребуется этот сигнал перевернуть – его частота всего 100 МГц. Главное, не забывайте относиться к дифпарам с уважением, и всё будет в порядке.

REFCLK необходим, хотя теоретически есть случаи, в которых его можно опустить. Для этого потребуется, чтобы оба конца канала PCIe поддерживали его восстановление из данных, передаваемых через дифпары RX и TX, либо генерировали свой собственный сигнал REFCLK. Звучит реалистично, но лишённые REFCLK реализации PCIe в жизни встретить вряд ли удастся.

Даже SD-Express, новый стандарт, который переносит возможности PCIe на SD-карты для значительного повышения их скорости, не пошёл по этому пути. Единственная доступная для потребителей реализация без REFCLK – это SATA-Express, стандарт, который был замещён M.2 практически сразу после того, как материнские платы с портами SATA-Express попали на витрины магазинов. Так что на данный момент, если вы хотите, чтобы ваш канал PCIe работал, REFCLK вам определённо нужен.

Линия Connector представляет коннектор с поддержкой PCIe – если у вас есть такой в проекте

Скажу ещё немного про конденсаторы. Для работы канала они потребуются вам и на линиях TX, и на линиях RX. Ёмкость должна быть от 75 нФ до 265 нФ, в зависимости от поколения PCIe: в качестве хорошего универсального выбора подойдёт 200 нФ, а вот 100 нФ сгодится лишь в крайних случаях. Также рекомендую выбирать корпуса 0402 или 0201. На этом, собственно, всё.

REFCLK обычно не нуждается в конденсаторах, но они не повредят, и в определённых устройствах могут оказаться необходимы. Кроме того, здесь есть повод задуматься – известен как минимум один задокументированный случай дешёвых массово производимых SSD от Western Digital, в которых, по всей видимости, отсутствовали конденсаторы на стороне TX. Эти накопители не инициализировались кастомными платами хостов с PCIe до тех пор, пока на стороне материнской платы не добавляли дополнительные конденсаторы. Это определённо не относится к типичным решениям – просто особенность, которую один производитель имел наглость реализовать.

▍ Обязательные сигналы

Далее, есть ещё три однонаправленных управляющих сигнала – CLKREQ, PEWAKE и PERST. CLKREQ используется для экономии энергии – устройство обычно устанавливает его на низкий уровень для начала получения REFCLK и может отключать (устанавливая на высокий уровень), сигнализируя хосту, что можно перестать обеспечивать REFCLK с целью экономии энергии.

Сигнал CLKREQ является специфичным – он присутствует в мобильных устройствах, но не в десктопных, где изначально в гнёздах PCIe даже не имелось выделенного для него пина. В результате майнерские райзеры для видеокарт с кабелем USB3 не проводят CLKREQ – только PEWAKE и PERST. Если у вашего хоста вывод CLKREQ есть, а у устройства отсутствует, заземлите его. Если же, наоборот, в устройстве он есть, а на хосте нет, то просто проигнорируйте его. В противном случае соедините эти линии.

Схемы материнских плат для ноутбуков и настольных ПК представляют собой отличные справочники по схематике PCIe. Однако в некоторых случаях это может оказаться нарушением авторских прав, и я бы не советовала использовать их в таком качестве.

Что ж, если ищущих простых путей майнеров волнует передача сигналов PEWAKE и PERST, значит, эти сигналы важны, не так ли? Давайте разберёмся. PERST – это вывод сброса канала PCIe, и хост удерживает его на нижнем уровне, пока все тактовые генераторы (включая REFCLK) и шины питания стабильны, а также выполняются прочие требования, позволяющие хосту начать взаимодействие по PCIe. Помимо этого, он используется для управления режимом пониженного питания.

PEWAKE, как и CLKREQ, служит для управления питанием и, по-видимому, тоже необходим – при этом он контролируется на стороне устройства. Я затрудняюсь сказать, как можно опустить эти два сигнала, поэтому просто рекомендую оставлять их оба подключёнными, если только они не оказываются недоступны на одной из сторон.

Ещё в гнёздах настольных ПК также есть сигналы PRSNT – в зависимости от ширины канала вам нужно замкнуть PRSNT#1 с одним из сигналов PRSNT#2. Не то, чтобы это необходимо – PCIe и так вполне способен корректно обнаруживать ширину канала. Тем не менее десктопные материнские платы зачастую в этом нуждаются. Похоже, что эти сигналы используются для горячего подключения – такая возможность технически присуща PCIe и будет работать даже при использовании систем вроде Linux. Windows же может отказываться обрабатывать горячее подключение по PCIe без дополнительных плясок с бубном.

В гнёздах десктопных и мобильных устройств вроде mPCIe или M.2 присутствуют сигналы I2C. Однако к материнской плате они подключаются редко – если же такое происходит, то лишь по прихоти производителя или ради предоставления таких возможностей, как VPro. На серверных платах они подключены, что вызывает забавные явления, например, отказ серверных SAS-контроллеров работать на определённых десктопных платах, где I2C подключены к гнёздам десктопного размера.

Если вы монтируете гнездо PCIe на стороне хоста, то вам не обязательно подключать I2C. Если же вы устанавливаете устройство, то не ожидайте, что линии I2C обязательно будут в гнезде подключены. То же касается сигналов JTAG – они используются для отладки или в серверных средах, и лучше оставлять их неподключенными, если только вы не уверены, что по предполагаемому месту применения их реализация обеспечит определённые преимущества.

Мобильные устройства с PCIe обычно работают от 3,3 В, в то время как десктопные могут питаться от 3,3 В или 12 В, в зависимости от своей мощности. В результате если вы добавляете гнездо PCIe десктопного размера, и у вас под рукой нет 12 В, некоторые десктопные карты могут не работать. Предполагается, что гнёзда х1 обеспечивают меньшую мощность при 12 В, чем гнёзда большего размера, и производители десктопных материнских плат зачастую этим пользуются. Так что, если вы проектируете карту под х1, не ожидайте, что это гнездо обеспечит полноценные 75 Вт (66 Вт при 12 В). Плюс же здесь в том, что при разработке материнской платы с гнездом х1 вам не обязательно обеспечивать полноценные 75 Вт.

▍ Различия в ширине канала

На стороне хоста и на стороне устройства могут использоваться каналы разной ширины – х1, х2, х4 и х16, где число указывает количество задействованных дифпар. Ввиду технических особенностей функционирования каналов PCIe на нижнем уровне ширина должна быть кратна 2. Так что не ждите, что канал х3 будет полноценно работать, если вы как-то проведёте от хоста к устройству три линии – он понизится до х2. PCIe довольно гибок в отношении ширины канала – хост и устройство будут взаимодействовать на доступной обоим максимальной скорости.

К примеру, если на хосте используется канал х4, а на устройстве – х16, будет использована ширина х4 с четырьмя дифпарами – и не важно, что на другой стороне останется 12 неиспользуемых. Хотя здесь есть очень редкие исключения, а именно некоторые карты для серверов. Тем не менее даже в этом случае речь идёт о том, что «карта х8 не будет работать при подключении к х4», хотя канал х1 продолжит функционировать в качестве резервного варианта.

Это гнездо разработано с возможностью расширения, то есть от него можно ожидать поддержку бюджета питания для карт х16. Фото Hans Haase, CC BY SA 4.0

И это добавляет гибкости – если на одной из сторон нет достаточного числа линий для соответствия второй, всегда можно ожидать функционирование как минимум в режиме х1. К примеру, вы можете установить видеокарту х16 в десктопное гнездо х1, надрезав это гнездо и, возможно, замкнув контакты PRSNT. Только убедитесь, что ваша видеокарта не требует больше питания, чем может обеспечить гнездо х1, как вполне может оказаться, если вы подключаете дополнительную видеокарту в подрезанный слот х1 напрямую.

Что касается гнёзд и карт PCIe, то вы будете встречать физическую ширину каналов х1, х4 и х16. При этом гнёзда и карты х8 чаще используются в серверах. Существуют некоторые бюджетные видеокарты, которые по факту имеют ширину канала х8, но используют гнёзда х16. То же касается карт х2 – они устанавливаются в гнёзда х4. Очень редко можно встретить карты или гнёзда, физически имеющие ширину канала х2 или х8.

При реализации многолинейного канала необходимо убедиться в том, что вы подключаете линию 0 к линии 0, линию 1 к линии 1 и так далее. Несомненно, можно переиграть сочетание линий, если это поможет в проектировании схемы – скажем, в случае канала х4 можно подключить линию 0 к линии 3, 1 к 2 и так далее. Но тут уже неизвестно, насколько широко такое решение поддерживается – оно, скорее, опционально и где-то наверняка работать не будет.

▍ Будет работать по любому

Аналогично Ethernet, быстродействие PCIe с каждым поколением возрастало за счёт постепенного увеличения скорости передачи данных, улучшения кодирования и прочих доработок. Здесь та же история, что и с шириной каналов – существует прекрасная прямая и обратная совместимость. Устройство Gen1 будет работать в гнезде Gen5, а устройство Gen5 – в гнезде Gen1, опять же, на доступной обоим сторонам максимальной скорости. Естественно, канал может отклоняться от ожидаемых показателей – если вы подключите контроллер USB3 в гнездо PCIe х1 на старой материнской плате, пропускная способность порта USB3 упадёт (то же касается подключения видеокарт через канал х1). Однако это также говорит о том, что обычно вам не стоит беспокоиться о поколении PCIe, если только вас не интересует достижение конкретной скорости.

К счастью, если у вас есть более углублённые вопросы по теме PCIe, то в сети полно соответствующей информации, и можно без проблем найти спецификации даже для последнего поколения PCIe 5.0. Этот материал может оказаться сложнее в сравнении с текущей статьёй, но при погружении в тему он определённо поможет. В следующий раз мы дорисуем вашу ментальную карту стандарта PCIe, чтобы вы без проблем могли найти нужный подход при его реализации и расширении возможностей.

Источник: habr.com