Если интернет – огромная библиотека, в которой собраны книги со всего мира, а пользователь – читатель, который пришел за книгой, то поисковая система – библиотекарь, способный в кратчайшие сроки найти искомую книгу. Как поисковик быстро находит нужный сайт? С помощью индексации, которую совершают поисковые роботы.

Поисковый индекс

Когда пользователь вводит запрос в строке поиска, система формирует выдачу, которую она берет из собственной базы данных. Эта база данных находится на серверах поисковых систем и представляет собой хранилище информации о сайтах – поисковый индекс. В выдаче мы видим результаты в порядке убывания их значимости. Если сайт отсутствует в индексе поисковика, то он не показывается по поисковым запросам. Пользователи смогут найти страницу только тогда, когда ее проиндексирует робот.

Как рассчитать фонд оплаты труда?

Что такое индексация сайтов

Индексация сайта – это процесс сбора информации о сайте, ее последующей обработки и добавления в базу данных поисковых систем. Она может осуществляться двумя способами: 1) Ручной; Владелец ресурса добавляет адрес в базу с помощью специальной формы, которая есть в любом поисковике.

2) Автоматический Робот самостоятельно находит сайт и сканирует его в соответствии со своим алгоритмом работы. Индексация интернет-ресурсов начала производиться еще в 90-х годах прошлого столетия. Тогда основным признаком было текстовое наполнение – наличие ключевых слов. Сегодня же учитываются сотни характеристик, а сам принцип ранжирования сложен и основан на искусственном интеллекте.

Что такое поисковый робот

- основой (главный робот);

- индексатор картинок (специализируется на графических файлах);

- робот-зеркальщик (предназначен для работы с зеркалами);

- быстробот (обрабатывает сайты с часто меняющимся контентом).

Роботы создают базу данных, которая используется для формирования релевантной поисковой выдачи.

Как проверить индексацию

1. Поисковый оператор site;

В строке поиска вводим адрес сайта после конструкции «site:». Так мы узнаем приблизительное число проиндексированных страниц в соответствующей системе. Этот способ работает и в Яндексе, и в Google. Если результаты сильно отличаются, то это может говорить о наличии санкций в одном из поисковиков.

2. Панели вебмастера Яндекс и Гугл;

Яндекс.Вебмастер: Индексирование сайта – Страницы в поиске;

Google Search Console: Индекс Google – Статус индексирования.

3. Сервисы для проверки индексации.

Бесплатные сервисы: XSEO.in, SEOGadget.

У сайта RDS целая линейка сервисов, в том числе и плагин для браузера RDS Bar. Он предоставляет комплексную информацию, полезную для СЕО-продвижения сайта.

Семинар: оплата и расчёты

Как управлять индексацией

Робот воспринимает сайт не в том виде, в котором привык видеть веб-страницы рядовой пользователь. Программа анализирует все страницы ресурса, в том числе и созданные ошибочно или находящиеся в разработке.

Так как робот индексирует за раз ограниченное количество страниц, он может просканировать только «пустые» страницы, а полезные оставить на потом. Так уменьшается скорость индексации, а вместе с ней и позиция ресурса.

Чтобы этого не случилось, необходимо управлять индексацией. Рассмотрим несколько простых и эффективных инструментов:

1. Robots.txt;

Это текстовый файл, указаниям которого подчиняется робот. Инструкция для робота пишется при помощи директив:

- User-agent – указывает, для какого поисковика написаны правила (User-agent: Yandex). Если правила для всех систем, то используется *;

- Allow – разрешает индексирование отдельных объектов. Например, когда нужно закрыть от робота весь каталог за исключением нескольких файлов;

- Disallow – запрещает сканировать объекты. Это самая распространенная директива в Robots.txt. Она прячет от робота служебные файлы и страницы, дубли и другие объекты, не нуждающиеся в продвижении. О том, как вредит неправильная работа с дублями СЕО-продвижению мы уже рассказывали в нашем блоге;

- Host – указывает главное зеркало. Из страниц с идентичным контентом помечает ту, которую нужно индексировать;

- Sitemap – содержит адрес с картой сайта, если она есть;

- Clean-param – запрещает индексацию страниц с определенными параметрами;

- Crawl-delay – устанавливает временные ограничения на скачивание страниц для поискового робота.

2. Атрибут nofollow;

Закрывает от робота определенные ссылки на странице. Универсален для всех поисковиков.

3. Тег noindex;

Выделяет части текста, которые робот не будет сканировать. Это фирменный тег Яндекса, остальные системы его воспринимают только после небольшой работы с синтаксисом.

4. Атрибут rel=”canonical”;

Выделяет главную страницу, которая будет показываться в выдаче. Нужен для разделения основного зеркала от второстепенного.

5. Sitemap;

Карта сайта содержит перечень страниц и взаимосвязей между ними, а также данные для индексации сайта – приоритет сканирования и частоту обновления. Карту можно создать самостоятельно или с помощью сторонних сервисов, например, gensitemap.

Почему важна скорость индексации сайта

Поисковый робот сканирует сайты не регулярно, а через определенные промежутки времени. Их длительность напрямую зависит от частоты обновления контента. При этом он обрабатывает данные порционно, а не все сразу, чтобы не нагружать сервер. В среднем индексация в Яндексе занимает несколько недель, в Google – несколько дней.

Новостные ресурсы, где часто происходит добавление материала, посещаются роботом практически непрерывно. Поэтому свежие новости почти сразу появляются в поисковой выдаче.

Веб-страницы, которые обновляются редко, проверяются роботом один-два раза в неделю. Сайты, на которых новый контент не появляется, тоже посещаются роботом, но редко – пару раз в месяц.

Так как результаты поиска формируются из индекса поисковой системы, то чем раньше ресурс попадет в него – тем лучше. Чем больше скорость индексации сайта – тем выше его позиция в поисковой выдаче. Это один из подтвержденных факторов ранжирования.

Есть еще несколько причин для повышения скорости индексации:

- Содержимое сайта потеряет актуальность еще до того, как его увидят пользователи. Например, если опубликована срочная новость или условия акции, которая скоро закончится;

- Конкуренты скопируют и опубликуют контент раньше, если их сайт сканируется быстрее. Так они займут более высокие позиции;

- Пользователи не успеют увидеть важные изменения и уйдут к конкурентам. Например, расширился ассортимент, появились скидки, но посетитель не дождался, пока они окажутся в выдаче.

Как ускорить индексацию сайта

Вот небольшой чек-лист для быстрой индексации страниц сайта поисковыми роботами:

- Настроить файл robots.txt;

- Создать карту сайта;

- Использовать Яндекс.Вебмастер и Google Search Console;

- Сделать простую и удобную навигацию для посетителей;

- Публиковаться на более крупных ресурсах;

- Добавлять контент, если не регулярно, то хотя бы часто;

- Убрать из индексации дубли и ненужные страницы;

- Исправить технические ошибки;

- Использовать быстрый и надежный хостинг.

Индексация сайта – сложный процесс, непосредственно влияющий на позицию ресурса в выдаче. Управление индексаций является неотъемлемым элементом СЕО-продвижения.

Если Вам понравилась статья — ставим лайк и делимся ей в социальных сетях. Хотите получать больше полезных статей? Подпишитесь на рассылку. Раз в неделю пишем коротко про интернет-маркетинг.

Автор

Александр Хмелев

Источник: bvorona.su

Индексирование в поисковиках: что это такое и как работает

Сергей Ломакин Редакция «Текстерры»

Перед тем, как страница попадет в поисковую выдачу, она должна пройти долгий и увлекательный путь. Сперва ее обходят краулеры , которые есть у каждой поисковой системы. Затем, если контент достаточно качественный и представляет ценность, страница попадает в SERP . Вроде бы все просто, быстро и удобно, правда?

В тени остается сам процесс индексации, его алгоритмы и механизмы. Есть ли там что-то интересное и полезное для нас? Да, есть, и немало! Сегодня остановимся на процессе индексирования. Узнаем, что это такое, как происходит, а также поймем, можно ли повлиять на скорость добавления новых страниц в Google и «Яндекс».

В чем разница между индексированием и ранжированием

Начинающие вебмастера и оптимизаторы часто путают индексирование с ранжированием. Эти понятия взаимосвязаны, но обозначают разные явления и процессы.

Ранжирование – конечная сортировка сайтов, которые находятся в выдаче, и присвоение им определенных позиций или рангов. Конкретный ранг может быть дан определенной странице, когда она окажется в индексе, и только в тот момент, когда пользователь осуществит поиск по какой-то фразе. Такой порядок внедрен, чтобы обеспечить наличие максимально релевантных страниц в результатах поиска.

Индексирование – процесс добавления (обновления) данных о странице.

Как работает индексирование

Индексирование происходит благодаря краулеру: он обходит страницы всех сайтов в интернете и отправляет получаемую информацию в базу данных поисковой системы. Она и называется индексом. В дальнейшем собранные данные задействуются по-разному. Частично – для выстраивания ранжирования и формирования максимально релевантных поисковой фразе результатов поиска. Частично – для иных, например, служебных целей.

Поисковик может использовать данные только с тех страниц, которые уже были проиндексированы им. Пока первичная индексация не состоялась, его не будет существовать для Google. Зато после Google быстро найдет любую информацию в своих базах данных, и поиск по нескольким миллионам страниц займет считанные миллисекунды.

Стоит отметить, что, даже если краулер уже «обошел» страницу, это не гарантия того, что она мгновенно или вообще когда-либо попадет в поисковую выдачу. Да, краулер обходит абсолютно все страницы, но в SERP попадают только страницы с полезным и уникальным контентом.

Тяжело создавать контент, который удовлетворит не только запросы поисковиков, но и пользователей? Обращайтесь за помощью в «Текстерру».

Обмануть поисковую систему точно не удастся, а если и удастся, то ненадолго: для распознавания некачественного контента у Google есть собственные наработки, защищенные патентами.

Индекс E-A-T, рейтинг Page Quality и алгоритм BERT – все эти разработки позволяют точно определять полезность контента на странице и автоматически распознать его качество. В их основе лежит взаимодействие машинного обучения и других разработок Google, связанных с оценкой пользовательского опыта.

Что представляет из себя индекс Google

Как мы уже выяснили выше, индекс – это большая база данных, которая состоит из нескольких ключевых разделов. Углубляться в них не буду – это не так важно. Скажу лишь, что в этой базе данных имеются сведения о нескольких миллионах страниц. При сканировании краулеры «ощупывают» не только видимую посетителю текстовую информацию страницы, но и другие данные: атрибуты документа, информацию из тегов (alt, title, description), другие технические данные.

Как выглядит индекс Google

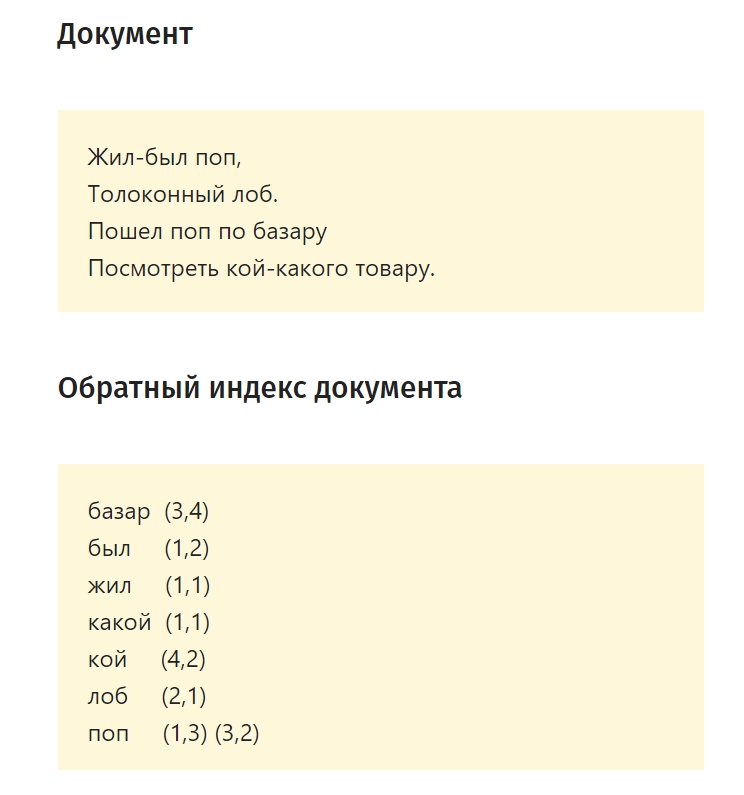

Google использует так называемый инвертированный (преобразованный в противоположную сторону) индекс. Условно, краулеры сперва проверяют код ответа сервера, затем – данные из хед и данные по индексации. Только после всех этих технических проверок следует проверка текста. Схематично инвертированный индекс выглядит следующим образом:

Как создается индекс Google: все этапы

Если представить формирование индекса поэтапно, он будет включать в себя четыре стадии.

- Первая – извлечение текста. На этой стадии происходит конвертирование страницы и «удаление» с нее всех вспомогательных элементов: текст отделяется от остальных составляющих, включая изображения, разметочные и структурные элементы.

- Вторая – формирование списка слов-лексем. Краулер формирует специальную выборочную совокупность. Делается это, чтобы в дальнейшем выделить так называемую лексему. Если вы имеете какое-то отношение к изучению русского языка, то знаете, что в лингвистике термин «лексема» передает некое слово или выражение, которые принято считать за одну единицу. Собственно, аналогичные лексемы выделяются и на втором этапе индексирования страницы. Лексемы собираются со всех текстов (точнее, выделяются со всех слов), которые есть на странице.

- Третья – упорядочивание и обработка. На этой стадии все сформированные лексемы выстраиваются в алфавитном порядке, нумеруются. Так каждая лексема получает собственный номер страницы (обозначает первоначальный источник происхождения лексемы) и номер вхождения.

- Четвертая – формирование индексной записи. Выглядит она следующим образом:

Краулеры могут сформировать и более сложную запись, но ее скелет все равно будет иметь в основе нарисованную выше схему.

Можно ли ускорить индексирование новых страниц

Можно, но не прямым образом. Если страница долго не появляется в результатах поиска, нужно убедиться, что она не закрыта для краулеров.

Для этого открываем системный файл robots.txt (он находится в корневой директории). Допустим, для сайта mirdostupa.ru файл robots.txt будет находиться по адресу mirdostupa.ru/robots.txt. Проверяем наличие запрещающего тега для интересующего URL. Выглядеть он может так:

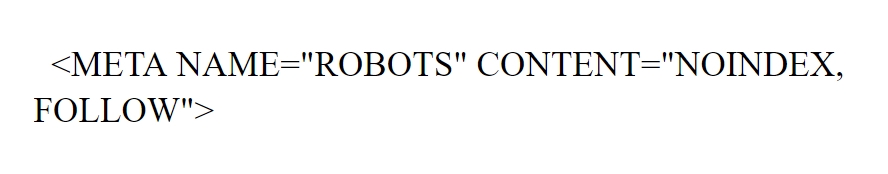

Чтобы проверить состояние страницы в Google, открываем инструменты вебмастера:

При необходимости здесь же запрашиваем повторное индексирование (если страница так и не попала в индекс).

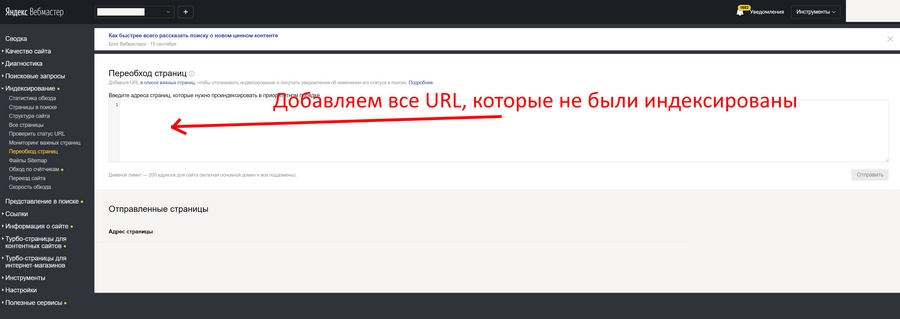

Чтобы добавить новую страницу в «Яндекс», можно воспользоваться служебным инструментом «Переобход страниц», который присутствует в «Яндекс.Вебмастере», но такое добавление не гарантирует попадание в индекс:

Чтобы новые страницы индексировались быстро и без проблем, необходимо следить за качеством контента. Естественно, в Google и «Яндекс» не будут попадать мусорные страницы, содержащие только поисковый спам и SEO-оптимизацию. Все элементы страницы должны находиться на своих местах, включая теги, картинки, названия и описания.

Как закрыть страницу сайта от индексации / удалить ее из Google

Хотите скрыть определенную страницу от краулеров (например, технические страницы или страницы с данными пользователей, включая конфиденциальную информацию)? Для этого есть три способа: использование тега robots, добавление запрещающей директивы в системный файл robots.txt, использование инструментов Google и «Яндекса». Рассмотрим все три способа подробнее.

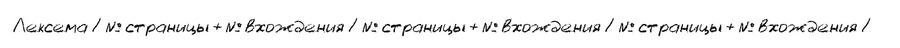

Чтобы закрыть страницу от индексации при помощи мета-тега Robots, достаточно добавить в заголовок страницы () следующий код:

Теперь о запрещающей директиве в robots.txt.

В этом файле прописываются наши «пожелания» для поисковых ботов, но исполнять их будут на свое усмотрение. Чтобы «попросить» краулера не обходить страницу, достаточно добавить в robots следующую запись:

- User-agent: * # вставить название поисковой системы

- Disallow: /catalog/ #вставить ссылку на страницу

Теперь об инструментах вебмастера. Открываем «Инструмент удаления URL», выбираем домен и пункт «Создать запрос». указываем ссылку и выбираем пункт «Удаление страниц». Далее следуем подсказкам инструмента, чтобы удалить URL из результатов поиска. После завершения отправки данных страницы будут удалены из индекса Google через некоторое время.

Как удалить страницу из результатов поиска «Яндекса»

Для удаления конкретной страницы из результатов поиска проще всего воспользоваться инструментом «Удалить URL». Запретить индексацию можно директивой Disallow, которую нужно добавить в уже знакомый нам системный файл robots.txt:

Disallow: /вставить_URL #

Как узнать, проиндексирована ли страница

Проверить состояние страницы в индексе поисковых систем можно несколькими способами. Самый простой заключается в ручном вводе URL страницы в строку поиска Google / «Яндекса». Если страница уже попала в индекс, она будет отображаться в результатах поиска. Если нет, совпадений, соответственно, не будет.

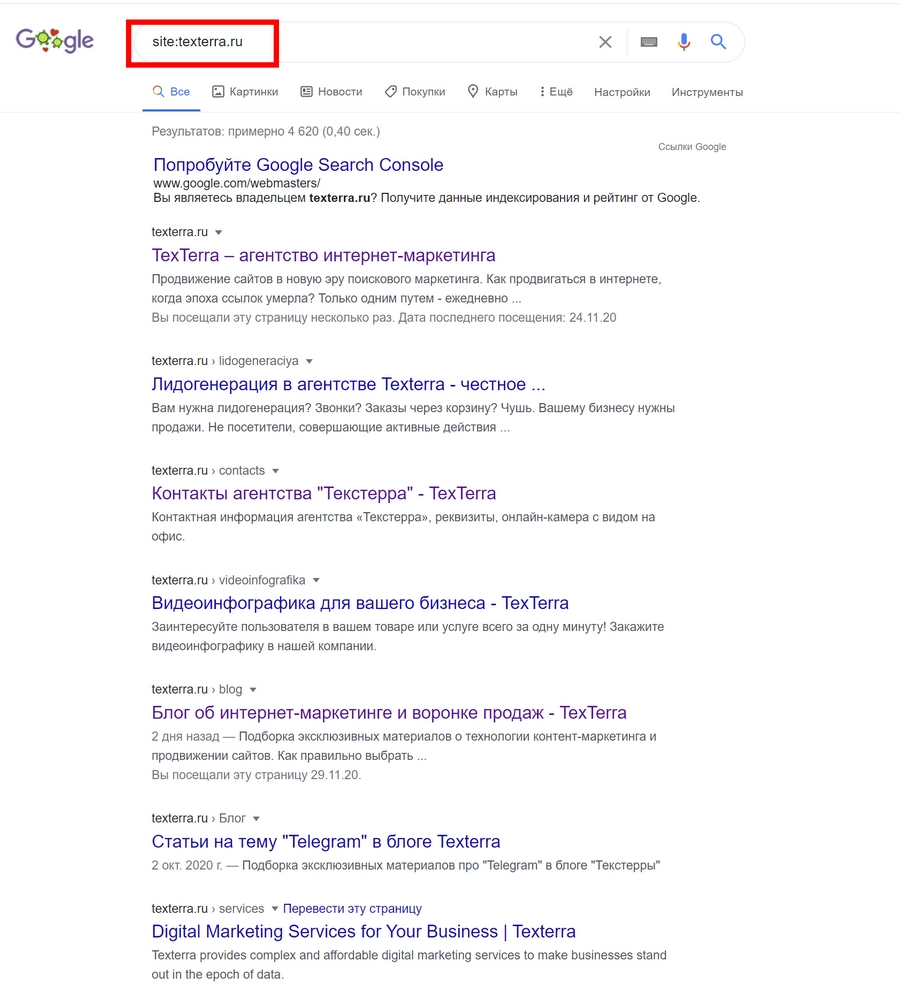

Как увидеть все страницы сайта, которые находятся в индексе

Для этого в поисковой строке вводим оператор вида site:вставитьвашсайт.ru, например: site:texterra.ru. В результатах поиска мы увидим все страницы, которые сейчас находятся в индексе Google:

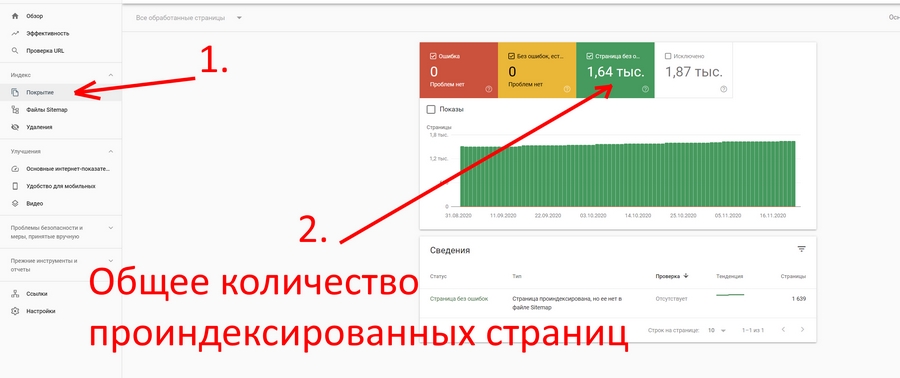

Увидеть количество проиндексированных страниц можно также в Google Search Console. Открываем раздел «Индекс» и выбираем пункт «Покрытие». Здесь отобразится общее количество проиндексированных страниц:

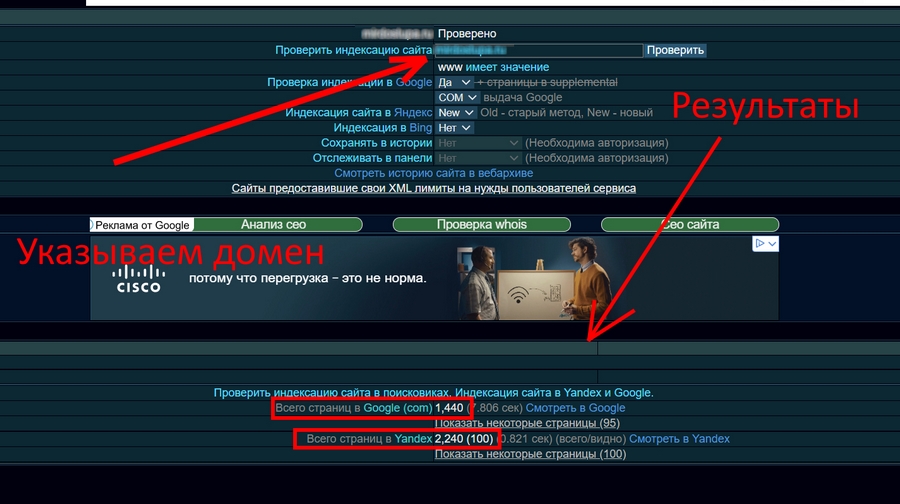

Кроме этого, узнать, сколько страниц находится в индексе «Яндекса» и Google, можно при помощи сервиса xseo. Пользоваться им просто: достаточно указать домен и выбрать пункт «Проверить»:

Почему проиндексированная страница может покинуть SERP

Причин выпадения из индекса довольно много. Я перечислю самые распространенные, с которыми сам регулярно сталкиваюсь:

- страница отдает 301-ый код – если настроено перенаправление, то в результатах поиска такая страница надолго не задержится;

- запрет индексирования настроен в системном файле robots.txt;

- дублирование контента;

- настроен каноникал-атрибут, который ведет на другую веб-страницу;

- на сайт были наложены меры пессимизации со стороны Google или «Яндекса»;

- страница отдает четырехсотые или пятисотые коды – краулер не будет учитывать такие веб-страницы вообще.

Послесловие

Индексирование – важнейший этап сбора данных о сайтах в интернете. Без индексации новые веб-страницы никогда бы не попали в поисковые системы. Повлиять на индексирование можно лишь непрямым образом: если мы указываем какие-либо команды в robots.txt, то мы даем краулерам лишь рекомендации.

Стоит отметить, что большие поисковые системы эти рекомендации соблюдают беспрекословно. Если ваши страницы преимущественно проиндексированы, но на поиске сайт почти невидим, значит, следует работать над качеством контента.

Проиндексируются все страницы, но бесполезный контент и поисковый спам никогда не будут ранжироваться наравне с качественными сайтами в результатах поиска.

Источник: texterra.ru

Быстрая индексация сайта — полезные программы

Быстрая индексация страниц сайта с помощью программ

Быстрая индексация сайта поисковыми системами Яндекс и Гугл является мечтой каждого блоггера. Для ускорения индексации новых страниц сайта или всего сайта помимо стандартных методов — создание карты сайта, добавление в адурилки ПС, публикация в соцзакладках, соцсетях, форумах, новостных порталах, блогах и тд, можно и нужно применять программы для ускорения индексации сайта. Программы позволяют быстро донести информацию о новостях вашего ресурса в различные сервисы и блоги в считанные минуты.

Программа Powerhouse SEO Link Building Tools

Программа предназначена для отправки ссылок в зарубежные сервисы и блоги с применением ключевых слов. Программа очень простая, добавляем адрес страницы — ключевое слово, пуск — программа начнет работать. После окончания работы проинформирует о результате. Применение программы не только ускоряет индексацию сайта, но и способствует получению обратных ссылок на ваш блог.

Скачать программу можно по ссылке внизу

Программа — Индексатор сайтов

Небольшого размера утилита sIndexer v1.2 предназначена для того, чтобы с ее помощью произошла быстрая индексация сайта или его новых страниц. Функциональность программы:

- Отправка ссылки в пинг сервисы

- Работа с картой сайта (парсинг и пинг)

- Отправка ссылки по базе Jenah (более 600 сайтов )

- Работа с прокси

Программа позволяет работать со своими списками для пинга, редактировать базу сайтов Jenah. Программа очень быстрая и не требует инсталляции на компьютер.

Скачать одним архивом обе программы

Такие полезные программы для ускорения индексации, как WebM_AddUrl , sIndexer v1.2 , Powerhouse SEO Link Building, не только экономят время для работы с сайтом, но и способствуют быстрой индексации вашего сайта. Для успешной работы этих программ требуется .NET Framework 4.

Советую почитать:

- Полезные cервисы в интернете

- Быстрая индексация ссылок

- Полезные программы для копирайтера

- Полезные программы для блоггера

- Полезные утилиты для сайта

Источник: www.websteel.ru