Открытие BIG файлов

У вас есть проблема с открытием .BIG-файлов? Мы собираем информацию о файловых форматах и можем рассказать для чего нужны файлы BIG. Дополнительно мы рекомендуем программы, которые больше всего подходят для открытия или конвертирования таких файлов.

Для чего нужен файловый формат .BIG?

Расширение .big повсеместно используется для обозначения больших сжатых и/или зашифрованных двоичных файлов-контейнеров (.big). Единого формата, который применялся бы к файлам .big, не существует, поскольку такие файлы используются многими независимыми друг от друга играми и приложениями.

Распространенный случай использования типа файлов .big имеет отношение к играм Electronic Arts (EA). Каждая игра EA, задействующая файлы .big для хранения своих ресурсов, использует слегка видоизмененный вариант общего формата EA BIG.

Кроме того, файлы-контейнеры .big встречаются во многих других играх, где они также служат для хранения графики, музыки и звуковых эффектов с применением целого ряда различных файловых форматов. Подобные файлы .big постоянно служат мишенью для «моддинга», и, как правило, для каждой использующей файлы .big игры существуют неофициальные утилиты по извлечению данных из BIG-контейнеров.

Что такое Big Data за 6 минут

Помимо игр, тип файлов .big также находит свое применение и в рамках некоторых приложений, хранящих большие объемы проприетарных данных. К примеру, известный мощный музыкальный редактор-студия Sibelius использует файлы .big для хранения коллекций высококачественных инструментальных сэмплов, которые можно использовать в рамках программы, но нельзя легко извлечь из архива.

Источник: www.filetypeadvisor.com

Big что это за программа

Курсы криптовалют онлайн

Bitcoin (BTC)

Ethereum (ETH)

Dogecoin (DOGE)

Cardano (ADA)

Polygon (MATIC)

Polkadot (DOT)

Shiba Inu (SHIB)

Litecoin (LTC)

Solana (SOL)

Chainlink (LINK)

Monero (XMR)

Cosmos Hub (ATOM)

Ethereum Classic (ETC)

Stellar (XLM)

Bitcoin Cash (BCH)

Algorand (ALGO)

VeChain (VET)

Theta Network (THETA)

Decentraland (MANA)

IOTA (MIOTA)

Enjin Coin (ENJ)

Compound (COMP)

Waves (WAVES)

OMG Network (OMG)

Komodo (KMD)

Наши контакты: [email protected]

Информационный портал «Майнинг Криптовалюты».

Источник: mining-cryptocurrency.ru

Big Data от А до Я. Часть 1: Принципы работы с большими данными, парадигма MapReduce

Что такое BI, чем можно анализировать Big Data и за что выбирают Tableau

Привет, Хабр! Этой статьёй я открываю цикл материалов, посвящённых работе с большими данными. Зачем? Хочется сохранить накопленный опыт, свой и команды, так скажем, в энциклопедическом формате – наверняка кому-то он будет полезен.

Проблематику больших данных постараемся описывать с разных сторон: основные принципы работы с данными, инструменты, примеры решения практических задач. Отдельное внимание окажем теме машинного обучения.

Начинать надо от простого к сложному, поэтому первая статья – о принципах работы с большими данными и парадигме MapReduce.

История вопроса и определение термина

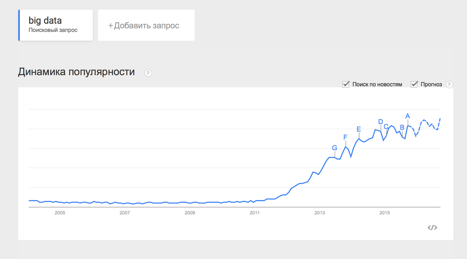

Термин Big Data появился сравнительно недавно. Google Trends показывает начало активного роста употребления словосочетания начиная с 2011 года (ссылка):

При этом уже сейчас термин не использует только ленивый. Особенно часто не по делу термин используют маркетологи. Так что же такое Big Data на самом деле? Раз уж я решил системно изложить и осветить вопрос – необходимо определиться с понятием.

В своей практике я встречался с разными определениями:

· Big Data – это когда данных больше, чем 100Гб (500Гб, 1ТБ, кому что нравится)

· Big Data – это такие данные, которые невозможно обрабатывать в Excel

· Big Data – это такие данные, которые невозможно обработать на одном компьютере

· Вig Data – это вообще любые данные.

· Big Data не существует, ее придумали маркетологи.

В этом цикле статей я буду придерживаться определения с wikipedia:

Большие данные (англ. big data) — серия подходов, инструментов и методов обработки структурированных и неструктурированных данных огромных объёмов и значительного многообразия для получения воспринимаемых человеком результатов, эффективных в условиях непрерывного прироста, распределения по многочисленным узлам вычислительной сети, сформировавшихся в конце 2000-х годов, альтернативных традиционным системам управления базами данных и решениям класса Business Intelligence.

Приведу несколько примеров того, что может быть источником данных, для которых необходимы методы работы с большими данными:

· Логи поведения пользователей в интернете

· GPS-сигналы от автомобилей для транспортной компании

· Данные, снимаемые с датчиков в большом адронном коллайдере

· Оцифрованные книги в Российской Государственной Библиотеке

· Информация о транзакциях всех клиентов банка

· Информация о всех покупках в крупной ритейл сети и т.д.

Количество источников данных стремительно растёт, а значит технологии их обработки становятся всё более востребованными.

Принципы работы с большими данными

Исходя из определения Big Data, можно сформулировать основные принципы работы с такими данными:

1. Горизонтальная масштабируемость. Поскольку данных может быть сколь угодно много – любая система, которая подразумевает обработку больших данных, должна быть расширяемой. В 2 раза вырос объём данных – в 2 раза увеличили количество железа в кластере и всё продолжило работать.

2. Отказоустойчивость. Принцип горизонтальной масштабируемости подразумевает, что машин в кластере может быть много. Например, Hadoop-кластер Yahoo имеет более 42000 машин (по этой ссылке можно посмотреть размеры кластера в разных организациях). Это означает, что часть этих машин будет гарантированно выходить из строя. Методы работы с большими данными должны учитывать возможность таких сбоев и переживать их без каких-либо значимых последствий.

3. Локальность данных. В больших распределённых системах данные распределены по большому количеству машин. Если данные физически находятся на одном сервере, а обрабатываются на другом – расходы на передачу данных могут превысить расходы на саму обработку. Поэтому одним из важнейших принципов проектирования BigData-решений является принцип локальности данных – по возможности обрабатываем данные на той же машине, на которой их храним.

Все современные средства работы с большими данными так или иначе следуют этим трём принципам. Для того, чтобы им следовать – необходимо придумывать какие-то методы, способы и парадигмы разработки средств разработки данных. Один из самых классических методов я разберу в сегодняшней статье.

MapReduce

Про MapReduce на хабре уже писали (раз, два, три), но раз уж цикл статей претендует на системное изложение вопросов Big Data – без MapReduce в первой статье не обойтись J

MapReduce – это модель распределенной обработки данных, предложенная компанией Google для обработки больших объёмов данных на компьютерных кластерах. MapReduce неплохо иллюстрируется следующей картинкой (взято по ссылке):

MapReduce предполагает, что данные организованы в виде некоторых записей. Обработка данных происходит в 3 стадии:

1. Стадия Map. На этой стадии данные предобрабатываются при помощи функции map(), которую определяет пользователь. Работа этой стадии заключается в предобработке и фильтрации данных. Работа очень похожа на операцию map в функциональных языках программирования – пользовательская функция применяется к каждой входной записи.

Функция map() примененная к одной входной записи и выдаёт множество пар ключ-значение. Множество – т.е. может выдать только одну запись, может не выдать ничего, а может выдать несколько пар ключ-значение. Что будет находится в ключе и в значении – решать пользователю, но ключ – очень важная вещь, так как данные с одним ключом в будущем попадут в один экземпляр функции reduce.

2. Стадия Shuffle. Проходит незаметно для пользователя. В этой стадии вывод функции map «разбирается по корзинам» – каждая корзина соответствует одному ключу вывода стадии map. В дальнейшем эти корзины послужат входом для reduce.

3. Стадия Reduce. Каждая «корзина» со значениями, сформированная на стадии shuffle, попадает на вход функции reduce().

Функция reduce задаётся пользователем и вычисляет финальный результат для отдельной «корзины». Множество всех значений, возвращённых функцией reduce(), является финальным результатом MapReduce-задачи.

Несколько дополнительных фактов про MapReduce:

1) Все запуски функции map работают независимо и могут работать параллельно, в том числе на разных машинах кластера.

2) Все запуски функции reduce работают независимо и могут работать параллельно, в том числе на разных машинах кластера.

3) Shuffle внутри себя представляет параллельную сортировку, поэтому также может работать на разных машинах кластера. Пункты 1-3 позволяют выполнить принцип горизонтальной масштабируемости.

4) Функция map, как правило, применяется на той же машине, на которой хранятся данные – это позволяет снизить передачу данных по сети (принцип локальности данных).

5) MapReduce – это всегда полное сканирование данных, никаких индексов нет. Это означает, что MapReduce плохо применим, когда ответ требуется очень быстро.

Примеры задач, эффективно решаемых при помощи MapReduce

Word Count

Начнём с классической задачи – Word Count. Задача формулируется следующим образом: имеется большой корпус документов. Задача – для каждого слова, хотя бы один раз встречающегося в корпусе, посчитать суммарное количество раз, которое оно встретилось в корпусе.

Раз имеем большой корпус документов – пусть один документ будет одной входной записью для MapRreduce–задачи. В MapReduce мы можем только задавать пользовательские функции, что мы и сделаем (будем использовать python-like псевдокод):

def map(doc): for word in doc: yield word, 1

def reduce(word, values): yield word, sum(values)

Функция map превращает входной документ в набор пар (слово, 1), shuffle прозрачно для нас превращает это в пары (слово, [1,1,1,1,1,1]), reduce суммирует эти единички, возвращая финальный ответ для слова.

Обработка логов рекламной системы

Второй пример взят из реальной практики Data-Centric Alliance.

Задача: имеется csv-лог рекламной системы вида:

,,,,, 11111,RU,Moscow,2,4,0.3 22222,RU,Voronezh,2,3,0.2 13413,UA,Kiev,4,11,0.7 …

Необходимо рассчитать среднюю стоимость показа рекламы по городам России.

def map(record): user_id, country, city, campaign_id, creative_id, payment = record.split(«,») payment=float(payment) if country == «RU»: yield city, payment

def reduce(city, payments): yield city, sum(payments)/len(payments)

Функция map проверяет, нужна ли нам данная запись – и если нужна, оставляет только нужную информацию (город и размер платежа). Функция reduce вычисляет финальный ответ по городу, имея список всех платежей в этом городе.

Резюме

В статье мы рассмотрели несколько вводных моментов про большие данные:

· Что такое Big Data и откуда берётся;

· Каким основным принципам следуют все средства и парадигмы работы с большими данными;

· Рассмотрели парадигму MapReduce и разобрали несколько задач, в которой она может быть применена.

Первая статья была больше теоретической, во второй статье мы перейдем к практике, рассмотрим Hadoop – одну из самых известных технологий для работы с большими данными и покажем, как запускать MapReduce-задачи на Hadoop.

В последующих статьях цикла мы рассмотрим более сложные задачи, решаемые при помощи MapReduce, расскажем об ограничениях MapReduce и о том, какими инструментами и техниками можно обходить эти ограничения.

Спасибо за внимание, готовы ответить на ваши вопросы.

Источник: habr.com

Формат файла BIG — описание, как открыть?

Файл формата BIG открывается специальными программами. Чтобы открыть данный формат, скачайте одну из предложенных программ.

Чем открыть файл в формате BIG

Тип файла: Electronic Arts Game Data File Разработчик: Electronic Arts Категория: Файлы игр

Формат данных игры, используемый видео-играми Electronic Arts (EA). Содержит персональные средства, используемые игрой и запакованные для того, чтобы сохранить пространство. Близок к файлу расширения .ELF, но изменяется и хранится в собственном формате EA. Может импортироваться в виде файла MOD в определенные игры для изменения процесса игры.

Чем открыть файл в формате BIG (Electronic Arts Game Data File)

| AssetCacheBuilder (assetcachebuilder.exe) | FinalBIG | Used by PlayStation hardware |

Источник: www.azfiles.ru

Тип файла BIG

Файлы BIG связаны с три типом (-ами) файлов, и их можно просматривать с помощью Dragon UnPACKer, разработанного Open Source. В целом, этот формат связан с пять существующим (-и) прикладным (-и) программным (-и) средством (-ами). Обычно они имеют формат Electronic Arts Game Data File. Большинство файлов BIG относятся к Game Files, однако они также могут относится к Raster Image Files.

Файлы с расширением BIG были идентифицированы на настольных компьютерах (и некоторых мобильных устройствах). Они полностью или частично поддерживаются Windows, Android и Playstation 3 System Software. Рейтинг популярности данных файлов составляет «Низкий», что означает, что они не очень распространены.

Для получения дополнительной информации о файлах BIG и связанных с ними прикладных программных средствах, см. информацию ниже. Кроме того, далее также представлено основное руководство по устранению неполадок, которое позволит вам решить проблемы, возникающие во время открытия файлов BIG.

Источник: www.solvusoft.com